Dallo studio allo streaming: L'influenza dell'IA nel plasmare la musica e il suo impatto sul mercato

La prima esibizione dal vivo documentata che unisce l'IA generativa e un musicista ha avuto luogo nel novembre 2022, quando il pianista David Dolan (Guildhall School of Music and Drama) ha improvvisato in dialogo con un sistema di IA semi-autonomo progettato dal compositore Oded Ben-Tal (Kingston University). Questo concerto innovativo ha dimostrato le possibilità creative dell'IA come partner collaborativo nella musica. Da allora, musicisti e anche non musicisti hanno abbracciato l'IA generativa, producendo composizioni complete con voci, strumenti e persino suoni di strumenti inesistenti. Questo segna l'inizio di una nuova era in cui l'intelligenza artificiale sta ridisegnando la creazione e la produzione musicale. Mentre l'intelligenza artificiale continua a rimodellare le industrie, il mondo della musica sta vivendo la propria rivoluzione. Dagli hobbisti alle grandi case discografiche, gli operatori del settore sono alle prese con le implicazioni di questa tecnologia.

L'industria musicale, storicamente plasmata dai progressi tecnologici, sta entrando in una nuova fase di trasformazione. Con l'ampio impatto dell'industria musicale attraverso l'intrattenimento, i media e le piattaforme di streaming che ospitano milioni di brani, l'integrazione dell'IA promette di ridefinire il modo in cui la musica viene creata, prodotta e consumata.

L'intelligenza artificiale generativa, la tecnologia alla base di questo cambiamento epocale, si è rapidamente evoluta dalla ricerca accademica alle applicazioni pratiche. Modelli come Music Transformer e MusicLM stanno superando i limiti del possibile, traducendo concetti astratti in composizioni armoniche. Questi sistemi di intelligenza artificiale, addestrati su vaste serie di dati di brani musicali, sono ora in grado di generare melodie originali, armonie e persino intere canzoni con una competenza sorprendente.

Tuttavia, come ogni rivoluzione tecnologica, l'ascesa dell'intelligenza artificiale nella musica suscita eccitazione e ansia. Artisti e professionisti del settore sono divisi sul suo potenziale impatto. Alcuni la vedono come un potente strumento di creatività e democratizzazione, mentre altri si preoccupano delle implicazioni per l'arte umana e la sicurezza del lavoro.

Il panorama dell'industria musicale sta già cambiando. Le piattaforme di streaming stanno sfruttando l'intelligenza artificiale per creare playlist personalizzate, mentre i software di produzione incorporano strumenti di mixaggio e masterizzazione assistiti dall'intelligenza artificiale. Anche le principali etichette discografiche stanno esplorando il potenziale dell'IA per il talent scouting e la previsione delle tendenze.

Mentre ci addentriamo in questa nuova era, le domande abbondano. Come l'IA rimodellerà i ruoli di artisti, produttori e ingegneri? Quali considerazioni legali ed etiche dobbiamo affrontare? E, cosa forse più importante, in che modo questa tecnologia influenzerà il legame emotivo tra i musicisti e il loro pubblico?

In questo articolo esploreremo lo stato attuale dell'IA generativa nella musica, le sue applicazioni in diversi settori dell'industria e il potenziale futuro che preannuncia. Dalla tecnologia che sta alla base di questi modelli di IA alle sfide pratiche per portarli sul mercato, esamineremo come questa innovazione sia pronta a trasformare una delle industrie creative più amate e influenti del mondo.

Mentre l'industria musicale entra in questa era guidata dall'intelligenza artificiale, è evidente che i futuri compositori potrebbero non essere esclusivamente umani, segnando un cambiamento significativo nella navigazione del settore verso questa nuova frontiera.

1. La tecnologia alla base dell'intelligenza artificiale generativa per la musica

Dalla composizione al codice: Le scoperte dell'intelligenza artificiale generativa nella musica

Il viaggio dalla composizione tradizionale alla musica generata dall'intelligenza artificiale è stato a dir poco rivoluzionario. Conosciamo bene la generazione di testi con chatGPT e la generazione di immagini con Stable diffusion e MidJourney. I maggiori progressi nella generazione di musica risiedono nell'adattamento di questi potenti modelli alle specificità dei dati musicali.

I. GPT per la musica (generazione discreta)

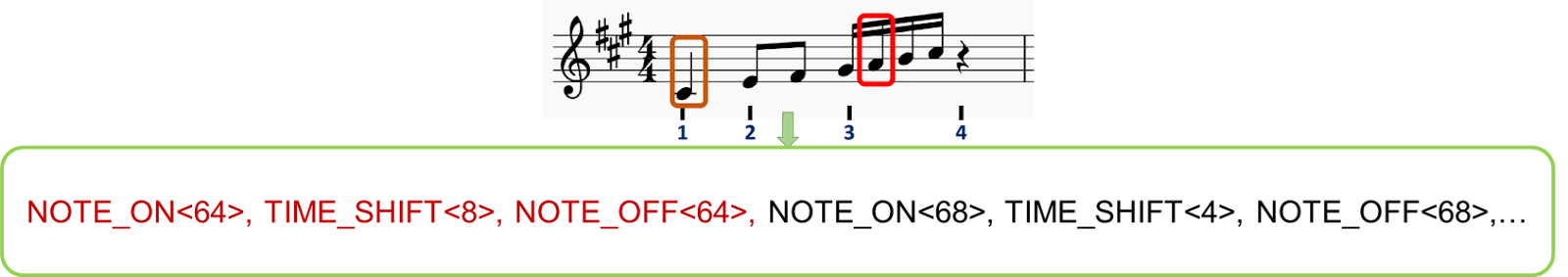

Così come i modelli GPT elaborano il linguaggio, principi simili possono essere applicati agli elementi musicali. La chiave sta nella tokenizzazione, ovvero nella scomposizione della musica in unità discrete e gestibili. Il processo di applicazione dei modelli GPT alla musica attraverso la tokenizzazione è un passo fondamentale per consentire all'intelligenza artificiale di comprendere e generare musica. Ecco una spiegazione più dettagliata:

1. Scomposizione in token della musica: Proprio come i modelli GPT suddividono il testo in token (parole o sottoparole), la musica deve essere suddivisa in unità discrete che l'intelligenza artificiale possa elaborare. Di seguito analizziamo due metodi di tokenizzazione:

i. Le note possono essere viste come elementi discreti contenenti più informazioni:

a) Il tono: La nota specifica che viene suonata (ad esempio, do, re, mi, ecc.).

b) Durata: La durata della nota (ad esempio, un quarto di nota, una mezza nota).

c) Velocità: Quanto forte o quanto dolcemente viene suonata la nota

d) Strumento: Quale strumento sta suonando la nota

ii. Esempio: una nota C4 suonata per un quarto di battuta potrebbe essere rappresentata con i token : ; ; , mentre una nota G3 suonata per un mezzo battito potrebbe essere tokenizzata in ; ;

(possiamo aggiungere tokens per velocità, strutture di battuta, strumenti, generi, ...)

iii. Creazione di sequenze numeriche:

Queste serie di note-token vengono poi concatenate e disposte in sequenze, analogamente a come le parole formano le frasi nei modelli linguistici. A ogni token viene assegnato un ID numerico univoco, consentendo al modello GPT di ricevere un input simile a quello della generazione del testo.

iv. Esempio: una frase musicale si presenta come: [123; 8; 456; 118; 12; 451;...] dove ogni numero rappresenta un evento musicale specifico.

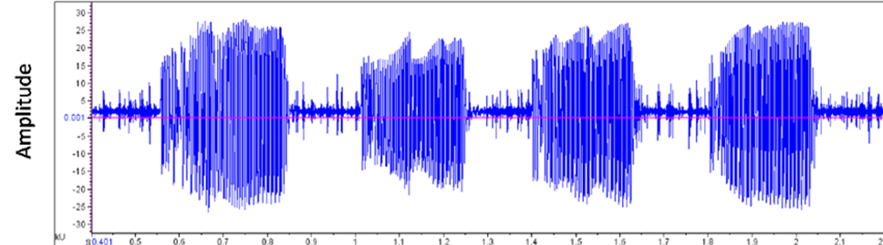

i. I file audio vengono memorizzati nei computer in un formato d'onda, che rappresenta l'ampiezza del segnale nel tempo. Ciò fornisce una rappresentazione più ricca rispetto ai semplici spartiti musicali.

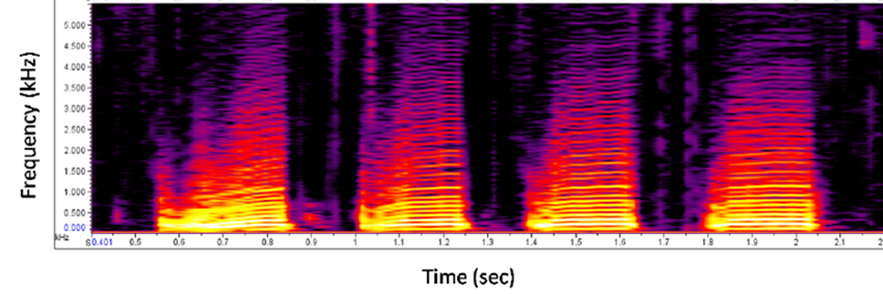

ii. Quest'onda può essere suddivisa in segmenti che rappresentano il "significato della musica" utilizzando un modello addestrato (simile a BERT per i vettori di parole) che crea una versione tokenizzata dell'input audio.

iii. I vettori risultanti possono essere condizionati da un incorporamento congiunto di audio e testo, creando token che rappresentano sia le caratteristiche audio che la descrizione testuale, consentendo all'utente di utilizzare un prompt testuale come input durante l'inferenza.

2. Formazione AI:

3. Generazione:

Music Transformer, sviluppato dal progetto Magenta di Google, ha segnato una tappa significativa in questo campo. Essendo tra i primi ad applicare il meccanismo di attenzione del Transformer, pietra miliare dei modelli linguistici, alle sequenze musicali, ha raggiunto una notevole coerenza nelle composizioni di lunga durata. Altri modelli hanno seguito l'esempio, ognuno dei quali ha spinto i confini di ciò che l'intelligenza artificiale poteva realizzare nella creazione di musica.

II. Modelli di diffusione per la musica (generazione continua)

I modelli di diffusione, come MidJourney o Stable Diffusion, sono stati ampiamente adottati e utilizzati per la generazione di immagini. Le immagini generate stanno diventando sempre più dettagliate e personalizzabili, mostrando una grande coerenza nell'aggiunta di dettagli di stile o di risoluzione in un prompt. Questa personalizzazione è una caratteristica interessante anche per la generazione di musica. Come possiamo trasformare la musica in un'immagine?

La musica come immagine:

Considerando gli spettrogrammi come immagini e allineandoli con una descrizione testuale, è possibile avere un potente controllo sulla generazione, consentendo agli utenti di richiedere la musica desiderata come farebbero per le immagini con MidJourney.

Colmare il divario tra innovazione e industria: Sfide nella generazione di musica con l'intelligenza artificiale:

Abbiamo esplorato due modi diversi per generare musica utilizzando l'IA. Tutte queste tecnologie hanno portato a dimostrazioni impressionanti e divertenti. Tuttavia, il percorso che porta dagli esperimenti di laboratorio ai prodotti pronti per il mercato è irto di sfide. Gli ostacoli tecnici abbondano, dalla garanzia di una qualità coerente tra i vari stili musicali alla gestione delle richieste computazionali della generazione in tempo reale. Le sfide del mercato sono altrettanto scoraggianti, poiché gli sviluppatori devono trovare il pubblico e i casi d'uso giusti per i loro compositori AI.

Le considerazioni di carattere gestionale e legale aggiungono ulteriore complessità. Costruire e guidare team all'intersezione tra musica e IA richiede una miscela unica di competenze. Nel frattempo, il panorama etico e legale rimane in gran parte inesplorato, sollevando questioni relative al copyright, alla paternità e alla natura stessa della creatività nell'era dell'IA.

Approfondendo le applicazioni attuali e i prodotti che stanno emergendo da questa rivoluzione tecnologica, diventa chiaro che l'impatto dell'IA sull'industria musicale sarà di vasta portata, toccando tutti i soggetti interessati, dagli ascoltatori alle grandi case discografiche.

2. Applicazioni e prodotti attuali

Con il continuo sviluppo dell'intelligenza artificiale generativa, nel settore musicale è emersa una varietà di piattaforme e strumenti. Queste innovazioni stanno passando da concetti sperimentali ad applicazioni pratiche, ognuna delle quali offre diverse capacità e potenziali utilizzi.

I. Il più utilizzato oggi: Suno.AI

Nel panorama della generazione di musica AI, Suno.AI ha guadagnato un'attenzione significativa. La piattaforma consente agli utenti di creare musica a partire da richieste di testo, generando canzoni complete di voce, strumentazione e testi in vari generi e stili.

Suno.AI ha registrato una base di 12 milioni di utenti e ha completato con successo i round di finanziamento, raggiungendo una valutazione di 500 milioni di dollari. La piattaforma offre livelli gratuiti e a pagamento, con la versione gratuita che consente agli utenti di creare un numero limitato di canzoni al giorno. Le sue applicazioni spaziano dai trailer cinematografici alle colonne sonore dei videogiochi.

Un regista che lavora a un cortometraggio potrebbe utilizzare Suno.AI per generare una colonna sonora personalizzata quando non può assumere un compositore. Le agenzie pubblicitarie stanno esplorando la piattaforma per creare rapidamente jingle e musica di sottofondo per gli spot, modificando potenzialmente il flusso di lavoro per la musica nella pubblicità.

II. Altre piattaforme musicali AI

Sebbene Suno.AI abbia attirato l'attenzione, fa parte di un ecosistema crescente di piattaforme musicali AI.

Con l'evoluzione di queste piattaforme e l'emergere di nuove, le applicazioni dell'IA nella musica continuano a diversificarsi. Dai singoli creatori alle grandi aziende, i potenziali utilizzi abbracciano un'ampia gamma, indicando un futuro in cui l'IA potrebbe svolgere un ruolo sempre più significativo nella creazione e produzione musicale.

3. Impatto sulle diverse parti interessate

Con la continua evoluzione dell'IA generativa, il suo impatto si ripercuote su ogni aspetto dell'industria musicale. Dagli ascoltatori alle grandi case discografiche, ogni gruppo sta sperimentando un cambiamento nel proprio rapporto con la creazione e il consumo di musica. Mentre alcuni guardano a questi cambiamenti con ansia, altri li vedono come la naturale evoluzione di un settore che è sempre stato plasmato dai progressi tecnologici.

I. Ascoltatori

Il viaggio dei consumatori di musica è stato caratterizzato da una crescente personalizzazione e scoperta. Prima dell'intelligenza artificiale, gli ascoltatori si affidavano ai DJ della radio, alle riviste musicali e al passaparola per scoprire nuova musica. Le playlist erano curate faticosamente a mano, spesso limitate dalle librerie musicali personali.

Con l'avvento dell'intelligenza artificiale, nel luglio 2015 piattaforme come Spotify hanno introdotto funzioni come Discover Weekly, utilizzando algoritmi per analizzare le abitudini di ascolto e suggerire nuovi brani. Questo ha segnato un salto significativo nella scoperta musicale personalizzata, esponendo gli ascoltatori a una gamma più ampia di artisti e generi.

Ora, grazie all'intelligenza artificiale generativa, siamo in procinto di vivere un'esperienza ancora più personalizzata. LifeScore è un sistema che non solo consiglia la musica esistente, ma crea nuove composizioni in base all'umore, all'attività o persino ai dati biometrici dell'ascoltatore. Un corridore potrebbe avere una colonna sonora personalizzata generata in tempo reale, che si adatta al suo passo e alla sua frequenza cardiaca, fondendo i suoi generi preferiti in qualcosa di completamente nuovo.

II. Gli artisti

Per i musicisti, il processo creativo è sempre stato influenzato dagli strumenti e dalle tecnologie disponibili. Prima dell'IA, la composizione si basava molto sugli strumenti tradizionali e sulle tecniche di registrazione. L'introduzione dei sintetizzatori e delle workstation audio digitali (DAW) alla fine del XX secolo ha già iniziato a rimodellare le modalità di creazione della musica. Come ha osservato Jean-Michel Jarre, uno dei primi pionieri della musica elettronica: "La tecnologia ha sempre dettato gli stili e non il contrario. È perché abbiamo inventato il violino che Vivaldi ha fatto la musica che ha fatto... Per me, l'intelligenza artificiale non è necessariamente un pericolo se viene usata bene".

Il software di composizione può suggerire progressioni di accordi o melodie, fungendo da partner collaborativo nel processo creativo.

Con l'IA generativa, stiamo assistendo all'emergere della co-scrittura dell'IA. Gli artisti possono ora inserire una melodia di base o un'idea di testo e far sì che un sistema di intelligenza artificiale generi elementi complementari, dando potenzialmente vita a nuove direzioni creative. Alcuni musicisti stanno persino sperimentando l'adattamento dello stile in tempo reale durante le esibizioni dal vivo, utilizzando l'IA per modificare il loro suono al volo in base alle reazioni del pubblico.

Per gli artisti dilettanti, numerose app di formazione fanno un buon uso dell'intelligenza artificiale per proporre esperienze di apprendimento in tempo reale, interattive e personalizzate. Con altri strumenti che consentono di simulare arrangiamenti e gruppi musicali, il costo di apprendimento della creatività si riduce, consentendo a un maggior numero di persone di suonare e divertirsi con la musica.

III. Gli ingegneri

Il ruolo dei tecnici audio è stato quello di un costante adattamento alle nuove tecnologie. Tradizionalmente, il missaggio e il mastering erano processi interamente manuali, che richiedevano un orecchio attento e anni di esperienza. Interrogato per questo articolo, Marius Blanchard, Data Scientist di Spotify, ha dichiarato: "L'AI non è qui per sostituire i musicisti, ma per potenziarli. È uno strumento che può aiutare gli artisti a esplorare nuovi territori creativi e a spingere i confini della creazione musicale".

L'intelligenza artificiale ha già fatto breccia in questo settore, con strumenti come Neutron di iZotope che offrono un'assistenza intelligente al mixaggio. Questi sistemi possono analizzare una traccia e suggerire impostazioni di equalizzazione, livelli di compressione e altri parametri, semplificando il processo di missaggio.

Man mano che l'intelligenza artificiale generativa diventa più sofisticata, potremmo assistere a sistemi di missaggio e masterizzazione completamente automatizzati, in grado di elaborare un intero album con un intervento umano minimo. Tuttavia, molti operatori del settore sostengono che il tocco umano sarà sempre necessario per catturare le sfumature emotive di una performance.

IV. Aziende di musica e piattaforme

Le etichette discografiche e gli editori musicali si sono a lungo affidati all'intuito umano e alle ricerche di mercato per individuare le tendenze e scoprire nuovi talenti. I dirigenti A&R (Artists and Repertoire) setacciavano i club e i nastri demo, alla ricerca del nuovo talento.

L'integrazione dell'intelligenza artificiale ha spostato questo processo verso un processo decisionale basato sui dati. Le piattaforme analizzano i dati di streaming, il coinvolgimento sui social media e altre metriche per identificare gli artisti in ascesa e prevedere il potenziale di successo.

Con l'IA generativa, le aziende musicali stanno esplorando possibilità ancora più radicali. Alcune stanno sperimentando sistemi di IA in grado di generare musica su misura per specifici segmenti di mercato o demografici. Altre utilizzano modelli predittivi per prevedere quali strutture di canzoni o temi lirici avranno probabilmente una risonanza sul pubblico nei mesi successivi.

Mentre il settore è alle prese con questi cambiamenti, la domanda chiave rimane: Come si evolverà l'equilibrio tra creatività umana e assistenza dell'IA? Mentre alcuni temono la perdita del tocco umano nella creazione musicale, altri vedono l'IA come uno strumento che finirà per potenziare la creatività umana, aprendo nuove strade all'espressione e alla collaborazione.

4. Visioni e opportunità future

Mentre l'IA generativa continua a rimodellare l'industria musicale, le parti interessate sono alle prese con un complesso panorama di considerazioni legali, economiche ed etiche. Questa tecnologia trasformativa promette di democratizzare la creazione musicale, sfidando al contempo le nozioni tradizionali di arte e copyright.

I. Considerazioni legali e di mercato

1. Il diritto d'autore nell'era dell'intelligenza artificiale

Prima dell'avvento dell'intelligenza artificiale, le leggi sul copyright nella musica erano relativamente semplici. Compositori ed esecutori detenevano i diritti sulle loro opere originali, con chiare linee guida sul campionamento e sull'uso corretto. Tuttavia, l'introduzione della musica generata dall'IA ha offuscato notevolmente questi confini.

Negli Stati Uniti, la protezione del diritto d'autore si estende alle opere originali, mentre la dottrina europea enfatizza il tocco personale del creatore. Questa distinzione diventa cruciale quando si considera la musica generata dall'intelligenza artificiale. L'Ufficio statunitense per il copyright ha dichiarato che non registrerà le opere prodotte da una macchina o da un semplice processo meccanico che opera in modo casuale o automatico senza l'apporto creativo o l'intervento di un autore umano.

Nel 2023, almeno un caso di alto profilo ha evidenziato i problemi di copyright legati alla musica generata dall'intelligenza artificiale che imita artisti popolari. Un brano intitolato "Heart on My Sleeve" che utilizzava l'intelligenza artificiale per imitare le voci di Drake e The Weeknd è stato caricato sui servizi di streaming e poi prontamente rimosso. Universal Music ha presentato un reclamo a YouTube e il video del brano è stato rimosso. Questo incidente ha sollevato questioni relative ai diritti di personalità e all'uso non autorizzato delle voci degli artisti, anche se create attraverso l'intelligenza artificiale.

Per gli artisti, l'intelligenza artificiale rappresenta un'arma a doppio taglio. Alcuni accolgono la tecnologia come strumento di collaborazione, mentre altri temono che possa svalutare il loro mestiere.

Le aziende musicali devono affrontare una serie di sfide proprie.

2. Proiezioni di mercato

L'intelligenza artificiale nel mercato musicale è pronta a crescere in modo significativo. Gli analisti del settore prevedono che il settore raggiungerà 38,7 miliardi di dollari entro il 2033, rispetto ai 3,9 miliardi di dollari del 2023. Questa decuplicazione riflette la prevista adozione diffusa di strumenti di IA in vari aspetti della produzione, distribuzione e consumo di musica. È interessante notare che gli artisti sono più alla ricerca di strumenti basati sull'intelligenza artificiale per la produzione e la masterizzazione musicale (66%) piuttosto che per la generazione di musica tramite l'intelligenza artificiale (47%). Gli strumenti di abilitazione della creatività sono considerati più importanti di quelli di pura generazione di IA, anche se dobbiamo prepararci ad ascoltare sempre più estratti musicali generati dall'IA.

II. Trasformazioni potenziali

1. Democratizzazione della produzione musicale

L'intelligenza artificiale sta abbassando le barriere di accesso alla creazione musicale. Strumenti che un tempo richiedevano studi costosi e anni di formazione sono ora accessibili tramite app di facile utilizzo. Questa democratizzazione potrebbe portare a un'esplosione di nuovi stili e voci musicali.

Alex Mitchell, CEO di Boomy, fondatore di una startup tecnologica musicale, immagina un futuro in cui chiunque possa essere un compositore. "Ora stiamo vedendo persone in tutto il mondo che creano canzoni istantanee con Boomy, le pubblicano e guadagnano persino una quota di royalty. Per la prima volta, l'espressione musicale è disponibile per un tipo completamente nuovo di creatori e di pubblico". Questa accessibilità potrebbe modificare radicalmente il panorama musicale, facendo emergere talenti che altrimenti non sarebbero stati scoperti.

2. Nuove interazioni tra artista e pubblico

L'intelligenza artificiale sta effettivamente ridisegnando il modo in cui gli artisti si relazionano con il loro pubblico. Alcuni artisti e piattaforme musicali stanno già sperimentando chatbot alimentati dall'intelligenza artificiale che consentono ai fan di interagire con il loro catalogo musicale in modi nuovi. Ad esempio, Spotify ha introdotto nella sua applicazione un chatbot guidato dall'intelligenza artificiale che interagisce con gli utenti per capire le loro preferenze musicali, i loro stati d'animo e le loro abitudini di ascolto. In questo modo il chatbot è in grado di creare playlist personalizzate e di suggerire nuovi brani in base ai gusti di ciascun utente.

Questi chatbot AI vengono utilizzati per migliorare il coinvolgimento dei fan fornendo raccomandazioni personalizzate, aggiornamenti in tempo reale ed esperienze interattive. Possono offrire aggiornamenti sugli artisti, consigliare playlist, facilitare l'acquisto di biglietti e gestire le richieste dei fan, favorendo connessioni più profonde tra gli artisti e il loro pubblico.

Un'artista lungimirante, Holly Herndon, ha recentemente lanciato una versione AI della sua voce con cui i fan possono collaborare per creare brani personalizzati. Questa fusione tra creatività umana e capacità dell'intelligenza artificiale indica un futuro in cui il confine tra artista e pubblico diventa sempre più fluido.

Una conclusione sfaccettata

I. Il ruolo dell'intelligenza artificiale nella creatività

L'integrazione dell'intelligenza artificiale nella creazione musicale solleva profonde domande sulla natura dell'arte. Mentre alcuni sostengono che l'IA sia solo uno strumento, simile a un nuovo apparecchio, altri temono che possa diminuire l'elemento umano che rende la musica emotivamente risonante.

Marius Blanchard, data scientist della Columbia University che lavora nell'industria musicale, offre una prospettiva equilibrata: "Non credo che l'IA sostituirà mai gli artisti; [...] la connessione pubblico-artista vive su molti livelli diversi, al di là della musica. Spero invece che l'IA democratizzi l'accesso a una produzione sonora di qualità e sia una spinta alla creatività per un numero sempre maggiore di artisti, che potranno così esprimere e condividere le loro creazioni."

II. Impatto sui posti di lavoro del settore

Con la crescita delle capacità dell'intelligenza artificiale, alcuni ruoli all'interno dell'industria musicale potrebbero evolversi o diventare obsoleti. Gli ingegneri del suono, ad esempio, potrebbero dover adattare le loro competenze per lavorare con strumenti di missaggio e masterizzazione AI. Tuttavia, è probabile che emergano nuove categorie di lavoro, come i programmatori musicali di IA o i consulenti etici di IA per le industrie creative.

III. Autenticità e connessione emotiva

Forse la domanda più importante che il settore si pone è se la musica generata dall'intelligenza artificiale possa creare le stesse connessioni emotive con gli ascoltatori delle opere create dall'uomo. Sebbene l'intelligenza artificiale sia in grado di analizzare i modelli e creare composizioni tecnicamente valide, l'ineffabile qualità dell'esperienza umana che spesso infonde la grande musica rimane una sfida da replicare.

La musicista elettronica e ricercatrice di intelligenza artificiale Holly Herndon offre una visione ottimistica: "Penso che il modo migliore per andare avanti sia che gli artisti si appoggino agli sviluppi dell'apprendimento automatico", ha detto, suggerendo di "pensare a modi per invitare condizionatamente gli altri a sperimentare con loro".

Riferimenti

Jeff Ens e Philippe Pasquier, (2020). MMM: Esplorazione della generazione musicale condizionale multi traccia con il Transformer.

Music Generation with the Transformer. arXiv preprint arXiv:2008.06048 https://arxiv.org/abs/2008.06048

Andrea Agostinelli et al, (2023). MusicLM: Generating Music From Text. arXiv preprint arXiv:2301.11325 https://arxiv.org/abs/2301.11325

Huang et al, (2018). Music Transformer: Generating Music with Long-Term Structure. arXiv preprint arXiv:1809.04281 https://arxiv.org/abs/1809.04281

Ke Chen et al, (2023). MusicLDM: Enhancing Novelty in Text-to-Music Generation Using Beat-Synchronous Mixup Strategies. arXiv preprint arXiv:2308.01546 https://arxiv.org/abs/1809.04281

BLOG

BLOG