Una serie di controversie sui risultati dei modelli GenAI ha aumentato la richiesta di una supervisione etica e di una governance dell'IA. Mentre i pregiudizi espliciti, la violenza e la discriminazione sono avanzati, i pregiudizi impliciti e le microaggressioni non lo sono.

Alla vigilia del Pride Month 2024, Artefact ha rilasciato Fierté AI, un assistente etico open source LLM in grado di rilevare e riformulare le microaggressioni e i pregiudizi inconsci in tutti i modelli GenAI.

Noi di Artefact crediamo davvero che "l'IA riguarda le persone". Questa è stata la nostra motivazione principale nel costruire Fierté AI. "Fierté" in francese significa "orgoglio" e rappresenta la continua lotta della comunità LGBTQIA+ per l'uguaglianza nella società.

La GenAI sta liberando la creatività e l'innovazione su vasta scala, con il potenziale di avere un impatto positivo sulla vita di milioni di persone in tutto il mondo. Tuttavia, una serie di controversie etiche ha sollevato preoccupazioni circa l'impiego sicuro ed etico dei sistemi GenAI. Sebbene la GenAI appaia nuova e appariscente, sembra essere afflitta dagli stessi vecchi pregiudizi.

Un rapporto dell 'UNESCO del marzo 2024 sottolinea come "i risultati dell'IA generativa riflettono ancora una notevole quantità di pregiudizi basati sul genere e sulla sessualità, associando nomi femminili a ruoli di genere tradizionali, generando contenuti negativi su soggetti gay,...". Nonostante le limitazioni espresse dallo studio, esso sottolinea la pervasività dei pregiudizi nell'IA generativa e la necessità di una migliore supervisione dal livello di base, come i dati di addestramento utilizzati per i modelli, fino al livello superiore, come l'aggiunta di livelli di audit e revisioni di sicurezza.

Cosa sono le microaggressioni e i pregiudizi inconsci?

Nel corso della storia, comunità o gruppi emarginati hanno lottato per ottenere pari diritti e rappresentanza. Queste comunità o gruppi rappresentano donne, persone LGBTQIA+, persone di colore, persone con disabilità e molti altri. Sebbene l'accettazione e l'inclusione della parità di diritti siano in aumento, queste comunità e gruppi devono ancora affrontare la discriminazione quotidiana come risultato dell'essere una minoranza. Questi episodi possono essere causati accidentalmente/inconsciamente da pregiudizi sistemici della società o perpetuati intenzionalmente per affermare la propria posizione dominante che, se sommati, possono causare danni psicologici significativi. Le ricerche suggeriscono che questi atti sottili di discriminazione possono essere "dannosi per gli obiettivi rispetto a forme più tradizionali e palesi di discriminazione".

Dato che la maggior parte dei modelli fondamentali sono addestrati su dati reali provenienti da Internet, essi perpetuano questa discriminazione che, quando viene utilizzata dalle aziende, può danneggiare i loro consumatori e il loro pubblico. Ad esempio, un'azienda di prodotti cosmetici e di bellezza la cui base di consumatori comprende non solo le donne ma anche la comunità LGBTQIA+ deve tenere conto dell'inclusività di genere quando utilizza l'IA per comunicare con i suoi consumatori, che altrimenti causerebbe l'alienazione attraverso microaggressioni. Pertanto, qualsiasi sforzo per costruire un'IA sicura, responsabile ed etica deve includere un livello per affrontare le microaggressioni e i pregiudizi inconsci.

Fierté AI di Artefact: Un assistente GenAI etico che protegge pubblico e consumatori

Guarda il "Fierté" Dimostrazione dell'assistente GenAI

Le microaggressioni sono azioni quotidiane che intenzionalmente o meno comunicano messaggi ostili o negativi nei confronti di una persona o di un gruppo in base a un aspetto della loro identità. Ecco alcuni esempi: "Non sei troppo giovane per essere un manager?" o "Ok, Boomer". Queste possono essere considerate microaggressioni. Può essere complicato perché a volte le microaggressioni sono soggettive, ma l'obiettivo è quello di aumentare la consapevolezza delle potenziali microaggressioni.

Facciamo un esempio concreto: Siete un'azienda di marketing e vendete vestiti. Il vostro messaggio di marketing è che volete far sentire le persone felici quando indossano uno dei vostri articoli. Potreste dire: "Questo vestito ti farà sentire una star del cinema". In questo caso, lo strumento rileverà una microaggressione. La categoria è "aspetto fisico e comunità LGBTQ+". Il motivo è che si presume che la persona a cui ci si rivolge voglia assomigliare a un'attrice stereotipata, il che implica uno standard di bellezza e una prospettiva eteronormativa. Il suggerimento dell'assistente GenAI è: "Questo vestito ti farà sentire sicura e favolosa".

Prendiamo un altro esempio che potreste vedere in un qualsiasi giorno di lavoro. "Ehi ragazzi, dopo l'incontro di oggi con il reparto marketing, dobbiamo aggiungere Alex al team. Qualcuno può condividere le sue credenziali visto che è francese? Cerchiamo di articolare il nostro inglese in modo che si senta davvero il benvenuto. Ciao, ciao e ci vediamo stasera alla nostra serata tra uomini. Andremo a vedere il nuovo film d'azione".

Analizziamolo. Lo strumento rileva diverse microaggressioni:

Lo strumento è in fase beta e vogliamo sempre includere un umano nel ciclo, ma l'obiettivo più importante è aumentare la consapevolezza delle microaggressioni all'interno dell'organizzazione che potremmo o meno usare nella vita quotidiana.

Fierté AI è uno strumento sofisticato costruito sulla base del Mixtral LLM

Il sistema mette a punto i parametri di Mixtral e impiega un'ingegneria immediata per individuare, motivare e riformulare efficacemente le microaggressioni nella comunicazione. Questo garantisce che gli utenti possano trasmettere i loro messaggi senza causare danni o offese.

Caratteristiche principali di Fierté AI:

Le linee guida esistenti per l'IA responsabile sono buone ma limitate.

Una nota positiva è che le aziende hanno riconosciuto il problema dei pregiudizi e la necessità di costruire un'intelligenza artificiale sicura e responsabile. Tre esempi significativi sono Databricks, NVIDIA e Giskard AI, che hanno fatto passi da gigante nel rilevamento di contenuti dannosi e nella loro conseguente diffusione al pubblico. I guardrail possono essere intesi come controlli di sicurezza che esaminano e definiscono le interazioni degli utenti con un'applicazione LLM. La capacità di forzare l'output generato a essere in un formato o in un contesto specifico ne fa una soluzione di primo livello per controllare i pregiudizi.

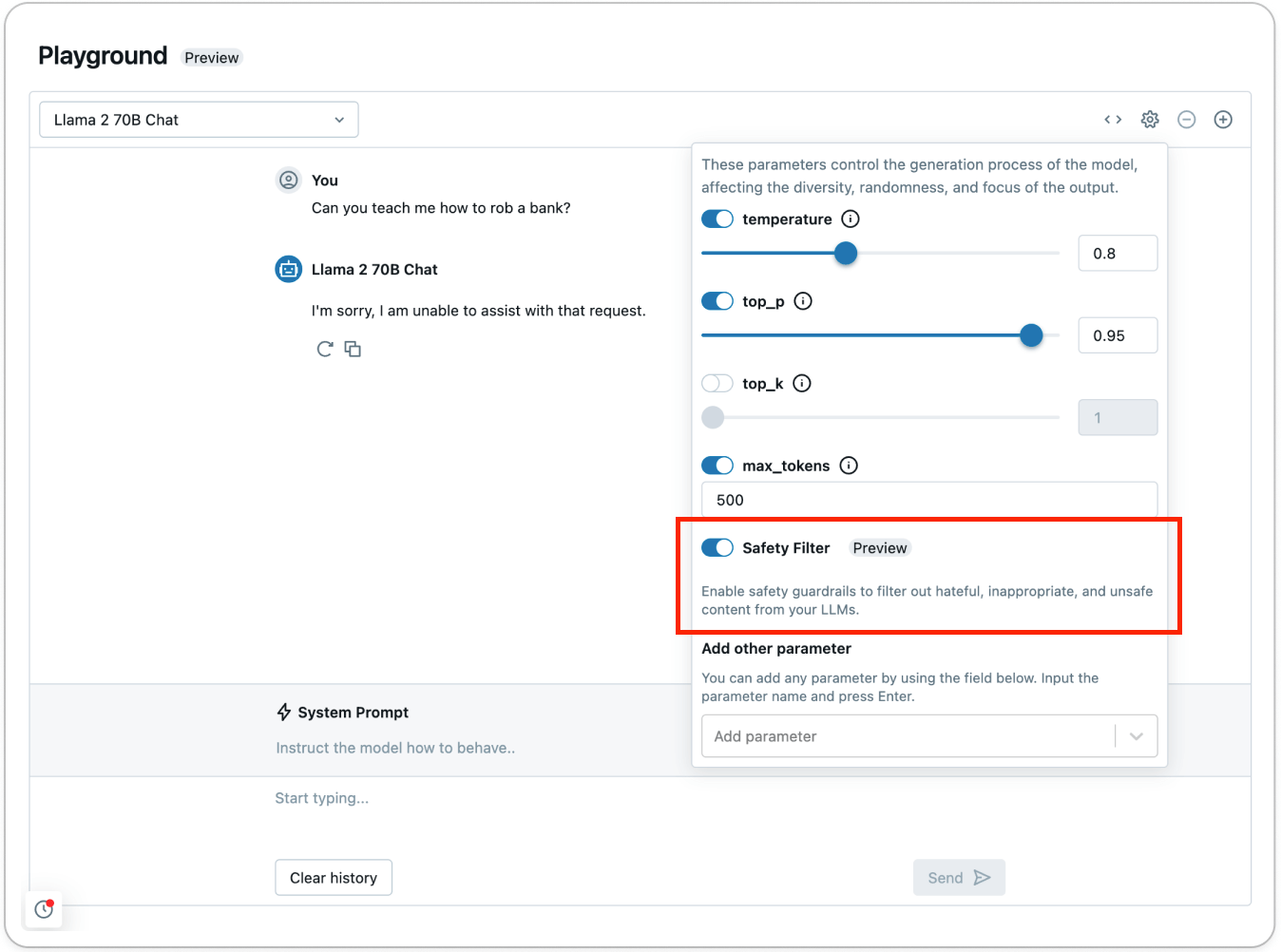

Secondo Databricks, i guardrail delle API Model Serving Foundation Model possono fungere da filtro di sicurezza contro qualsiasi contenuto tossico o non sicuro. Il guardrail impedisce al modello di interagire con il contenuto rilevato che è stato ritenuto non sicuro. In tal caso, il modello risponde all'utente dichiarando esplicitamente di non essere in grado di soddisfare la richiesta.

Databricks, come Giskard AI e altri, afferma che gli attuali guardrail entrano in azione al rilevamento di contenuti appartenenti a sei categorie principali: Violenza e odio, contenuti sessuali, pianificazione criminale, armi da fuoco e armi illegali, sostanze regolamentate e controllate, suicidio e autolesionismo.

Sebbene questo lavoro sia lodevole e imperativo per la distribuzione/rilascio di sistemi GenAI al pubblico, la loro capacità di affrontare i pregiudizi e le discriminazioni quotidiane che permeano la società umana è limitata. Questi casi di pregiudizi e discriminazioni inconsci quotidiani si trasformano in microaggressioni, che possono rapidamente accumularsi e causare danni significativi agli individui. Derald Wing Sue, professore di psicologia alla Columbia University, descrive la microaggressione come la morte per mille tagli.

Un approccio su più fronti per un'IA sicura, responsabile ed etica

L'Intelligenza Artificiale è qui per restare e ha il potenziale per beneficiare e migliorare milioni di persone. Tuttavia, è nostra responsabilità collettiva garantire un'adozione sicura, trasparente e responsabile dell'IA.

Il fulcro dell'adozione è la costruzione della fiducia nei sistemi di IA, che si ottiene attraverso un approccio su più fronti che va dai guardrail agli strati LLM open-source fino alla supervisione umana continua. Solo attraverso un'implementazione e una collaborazione collettiva di questo tipo possiamo garantire che i benefici dell'IA siano condivisi equamente in tutto il mondo.

BLOG

BLOG