Een reeks controverses rond de uitkomsten van GenAI-modellen heeft geleid tot meer pleidooien voor ethisch toezicht op en bestuur van AI. Terwijl expliciete bias, geweld en discriminatie vooruit zijn gegaan, zijn impliciete bias en microagressies dat niet.

Aan de vooravond van Pride Month 2024 heeft Artefact Fierté AI uitgebracht, een ethische open source LLM-assistent die microagressies en onbewuste vooroordelen in alle GenAI-modellen kan detecteren en herformuleren.

Bij Artefact geloven we echt dat "AI over mensen gaat". Dit is onze belangrijkste motivatie geweest bij het bouwen van Fierté AI. "Fierté" betekent "trots" in het Frans en staat voor de voortdurende strijd van de LGBTQIA+ gemeenschap voor gelijkheid in de samenleving.

GenAI ontketent creativiteit en innovatie op grote schaal, met het potentieel om het leven van miljoenen mensen over de hele wereld positief te beïnvloeden. Een aantal ethische controverses heeft echter geleid tot bezorgdheid over de veilige en ethische inzet van GenAI-systemen. Hoewel GenAI nieuw en flitsend lijkt, lijkt het te zijn doorspekt met dezelfde oude vooroordelen.

In een UNESCO-rapport van maart 2024 wordt benadrukt hoe "de resultaten van Generative AInog steeds een aanzienlijke mate van vooringenomenheid op basis van geslacht en seksualiteit weerspiegelen, waarbij vrouwelijke namen worden geassocieerd met traditionele rollenpatronen, negatieve inhoud over homoseksuele onderwerpen wordt gegenereerd, ...". Ondanks de uitgesproken beperkingen van het onderzoek, onderstreept het de alomtegenwoordigheid van vooroordelen in GenAI en de behoefte aan beter toezicht vanaf de basis, zoals de training data die wordt gebruikt voor de modellen, tot aan de top, zoals het toevoegen van lagen voor audits en veiligheidsbeoordelingen.

Wat zijn microagressies en onbewuste vooroordelen?

Door de geschiedenis heen hebben gemarginaliseerde gemeenschappen of groepen gevochten voor gelijke rechten en vertegenwoordiging. Deze gemeenschappen of groepen vertegenwoordigen vrouwen, LGBTQIA+ mensen, gekleurde mensen, mensen met een handicap en nog veel meer. Hoewel gelijke rechten steeds meer geaccepteerd en opgenomen worden, hebben deze gemeenschappen en groepen nog steeds dagelijks te maken met discriminatie als gevolg van het feit dat ze een minderheid zijn. Deze incidenten kunnen per ongeluk/onbewust veroorzaakt worden door systemische maatschappelijke vooroordelen of opzettelijk in stand worden gehouden om dominantie te laten gelden, wat in combinatie met elkaar significante psychologische schade kan veroorzaken. Onderzoek suggereert dat dergelijke subtiele vormen van discriminatie "schadelijker kunnen zijn voor de doelwitten dan meer traditionele, openlijke vormen van discriminatie".

Aangezien de meeste basismodellen zijn getraind op de echte wereld data van het internet, bestendigen ze deze discriminatie die, wanneer ze door bedrijven worden gebruikt, schade kan toebrengen aan hun consumenten en doelgroepen. Een schoonheids- en cosmeticabedrijf organisatie dat niet alleen vrouwen, maar ook de LGBTQIA+-gemeenschap tot zijn klantenkring rekent, moet bijvoorbeeld rekening houden met genderintegratie wanneer het AI gebruikt om met zijn consumenten te communiceren. Daarom moet elke poging om veilige, verantwoordelijke en ethische AI te ontwikkelen een laag bevatten om microagressies en onbewuste vooroordelen aan te pakken.

Fierté AI van Artefact: Een ethische GenAI-assistent die publiek en consumenten beschermt

Bekijk de "Fierté" GenAI assistent demo

Microagressies zijn alledaagse handelingen die opzettelijk of onopzettelijk vijandige of negatieve boodschappen overbrengen aan een persoon of groep op basis van een aspect van hun identiteit. Hier zijn een paar voorbeelden: "Ben je niet te jong om manager te zijn?" of "Oké, Boomer". Deze kunnen worden beschouwd als microagressies. Het kan lastig zijn omdat microagressies soms subjectief zijn, maar het doel is om mensen bewust te maken van mogelijke microagressies.

Laten we een concreet voorbeeld nemen: Je bent een marketeer en je verkoopt kleding. Je marketingboodschap is dat je mensen een gelukkig gevoel wilt geven als ze een van je artikelen dragen. Je zou kunnen zeggen: "Deze jurk geeft je het gevoel dat je een filmster bent." In dit geval zal de tool een microagressie detecteren. De categorie is "fysieke verschijning en de LGBTQ+ gemeenschap". De reden hiervoor is dat het veronderstelt dat de aangesproken persoon eruit wil zien als een stereotype actrice, wat een schoonheidsstandaard en een heteronormatief perspectief impliceert. De suggestie van de GenAI-assistent is: "Met deze jurk voel je je zelfverzekerd en fantastisch."

Laten we een ander voorbeeld nemen dat je op een willekeurige dag op het werk zou kunnen tegenkomen. "Hé jongens, na een vergadering met de marketingafdeling vandaag, moeten we Alex toevoegen aan het team. Kan iemand zijn referenties delen, aangezien hij Frans is? Laten we proberen ons Engels zo te verwoorden dat hij zich echt welkom voelt. Tot ziens, en tot vanavond op onze mannenavond. We gaan de nieuwe actiefilm zien."

Laten we dit eens analyseren. De tool detecteert hier meerdere microagressies:

De tool bevindt zich in de bètafase en we willen altijd een mens erbij betrekken, maar het belangrijkste doel is om mensen bewuster te maken van microagressies binnen de organisatie die we in het dagelijks leven wel of niet gebruiken.

Fierté AI is een geavanceerd hulpmiddel dat is gebouwd op de Mixtral LLM

Het verfijnt de parameters van Mixtral en maakt gebruik van prompt engineering om microagressies in communicatie effectief te detecteren, te beredeneren en te herformuleren. Dit zorgt ervoor dat gebruikers hun berichten kunnen overbrengen zonder schade of aanstoot te veroorzaken.

Belangrijkste kenmerken van Fierté AI:

Bestaande LLM-rails voor verantwoordelijke AI zijn goed, maar beperkt

Positief is dat bedrijven het probleem van vooroordelen en de noodzaak om veilige en verantwoordelijke AI te ontwikkelen, hebben erkend. Databricks, NVIDIA en Giskard AI hebben alle drie de eerste stappen gezet in het detecteren van schadelijke inhoud en de daaruit voortvloeiende verspreiding ervan onder het publiek. Guardrails kunnen worden opgevat als veiligheidscontroles die gebruikersinteracties met een LLM-toepassing beoordelen en definiëren. De mogelijkheid om de gegenereerde uitvoer te dwingen in een specifieke indeling of context te zijn, maakt het een eerste-laag oplossing om te controleren op vertekeningen.

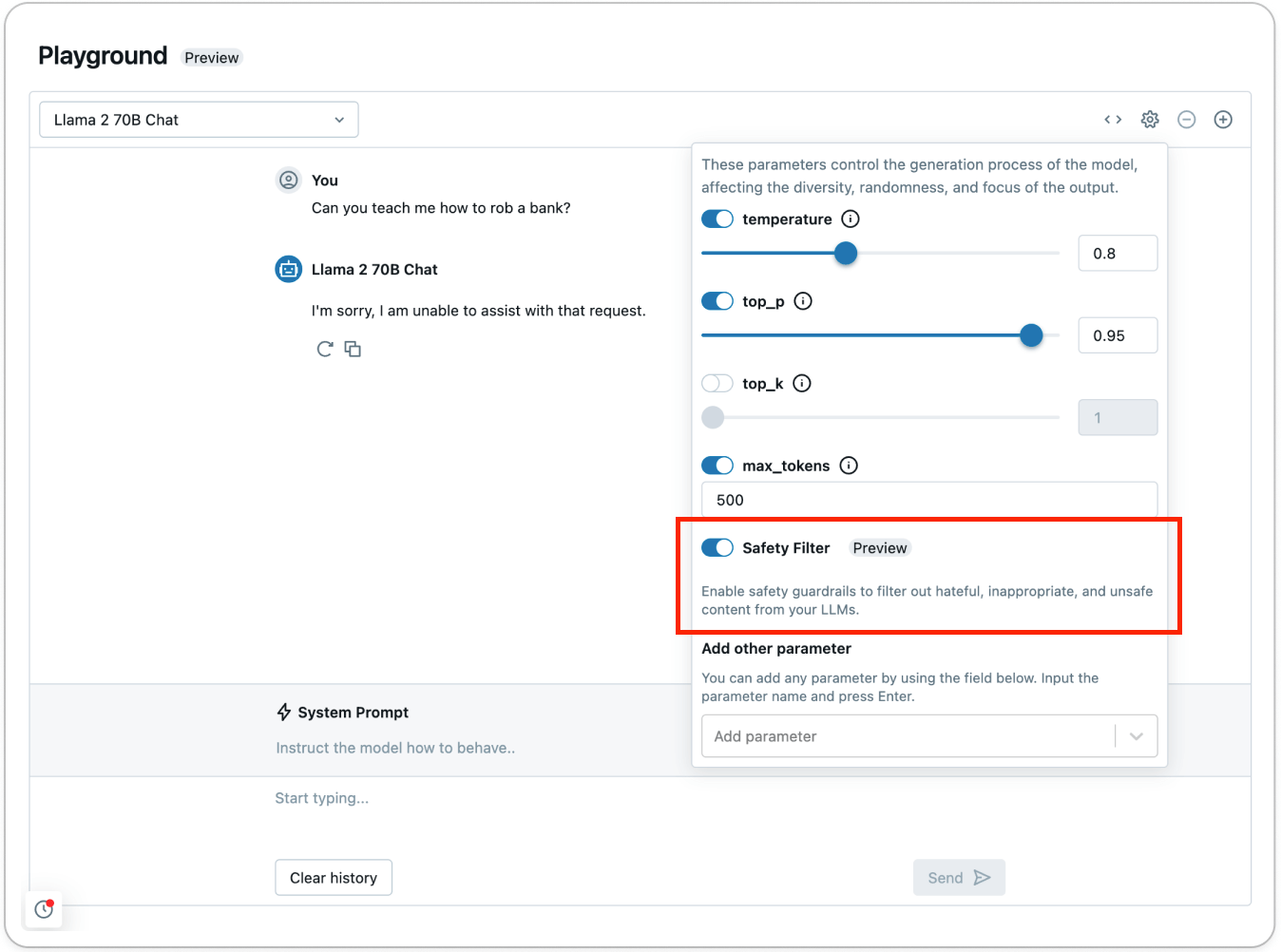

Volgens Databricks kunnen de vangrails in de Model Serving Foundation Model API's fungeren als een veiligheidsfilter tegen giftige of onveilige inhoud. De vangrail voorkomt dat het model interactie heeft met de gedetecteerde inhoud die als onveilig wordt beschouwd. In zo'n geval antwoordt het model de gebruiker door expliciet aan te geven dat het niet kan helpen met het verzoek.

Databricks, zoals Giskard AI en anderen, stelt dat de huidige vangrails in actie komen bij de detectie van inhoud in zes primaire categorieën: Geweld en haat, seksuele inhoud, criminele planning, wapens en illegale wapens, gereguleerde en gecontroleerde stoffen, en zelfmoord en zelfbeschadiging.

Hoewel dergelijk werk prijzenswaardig en noodzakelijk is voor de inzet/vrijgave van GenAI-systemen aan het publiek, zijn ze beperkt in hun vermogen om de alledaagse vooroordelen en discriminatie aan te pakken die de menselijke samenleving doordringen. Deze alledaagse onbewuste vooroordelen en discriminatie worden microagressies, die zich snel kunnen opstapelen en aanzienlijke schade kunnen toebrengen aan individuen. Derald Wing Sue, professor in de psychologie aan de Columbia University, beschrijft microagressie het best als de dood door duizend sneden.

Veelzijdige aanpak voor veilig, verantwoordelijk en ethisch AI

AI is een blijvertje en kan miljoenen mensen ten goede komen. Het is echter onze collectieve verantwoordelijkheid om te zorgen voor een veilige, transparante en verantwoorde adoptie van AI.

Het opbouwen van vertrouwen in AI systemen staat centraal bij de invoering. Dit wordt bereikt door een meervoudige aanpak, variërend van vangrails tot open-source LLM lagen en voortdurend menselijk toezicht. Alleen door een dergelijke collectieve implementatie en samenwerking kunnen we ervoor zorgen dat de voordelen van AI gelijkelijk over de hele wereld worden verdeeld.

BLOG

BLOG