Eine Reihe von Kontroversen im Zusammenhang mit den Ergebnissen von GenAI-Modellen hat die Forderung nach einer ethischen Überwachung und Steuerung von AI verstärkt. Während explizite Voreingenommenheit, Gewalt und Diskriminierung Fortschritte gemacht haben, sind implizite Voreingenommenheit und Mikroaggressionen noch nicht so weit.

Am Vorabend des Pride Month 2024 veröffentlichte Artefact Fierté AI, einen ethischen Open-Source-LLM-Assistenten, der Mikroaggressionen und unbewusste Voreingenommenheit in allen GenAI-Modellen erkennen und umformulieren kann.

Bei Artefact glauben wir wirklich, dass es beiAI um Menschen geht. Dies war unsere Hauptmotivation bei der Entwicklung von Fierté AI. "Fierté" bedeutet auf Französisch "Stolz" und steht für den ständigen Kampf der LGBTQIA+-Gemeinschaft um Gleichberechtigung in der Gesellschaft.

GenAI setzt Kreativität und Innovation in großem Umfang frei und hat das Potenzial, das Leben von Millionen Menschen auf der ganzen Welt positiv zu beeinflussen. Eine Reihe von ethischen Kontroversen hat jedoch Bedenken hinsichtlich des sicheren und ethischen Einsatzes von GenAI-Systemen aufgeworfen. Während GenAI neu und auffällig erscheint, scheint sie mit den gleichen alten Vorurteilen behaftet zu sein.

In einem UNESCO-Bericht vom März 2024 wird hervorgehoben, dass "die Ergebnisse von Generative AIimmer noch eine beträchtliche Menge an geschlechts- und sexualitätsbezogenen Vorurteilen widerspiegeln, indem sie weibliche Namen mit traditionellen Geschlechterrollen assoziieren, negative Inhalte über homosexuelle Personen erzeugen, ...". Trotz der ausdrücklichen Einschränkungen der Studie unterstreicht sie die Allgegenwärtigkeit von Voreingenommenheit in GenAI und die Notwendigkeit einer besseren Überwachung von der Basis, wie z. B. die für die Modelle verwendete Schulung data , bis hin zur Spitze, wie z. B. zusätzliche Ebenen für Audits und Sicherheitsüberprüfungen.

Was sind Mikroaggressionen und unbewusste Vorurteile?

Im Laufe der Geschichte haben marginalisierte Gemeinschaften oder Gruppen für gleiche Rechte und Vertretung gekämpft. Zu diesen Gemeinschaften oder Gruppen gehören Frauen, LGBTQIA+ Menschen, People of Color, Menschen mit Behinderungen und viele mehr. Obwohl die Akzeptanz und Einbeziehung gleicher Rechte zunimmt, sind diese Gemeinschaften und Gruppen immer noch täglich mit Diskriminierung konfrontiert, weil sie eine Minderheit sind. Diese Vorfälle können versehentlich/unbewusst durch systemische gesellschaftliche Voreingenommenheit ausgelöst oder absichtlich aufrechterhalten werden, um Dominanz durchzusetzen, was in der Summe zu erheblichen psychologischen Schäden führen kann. Forschungsergebnisse deuten darauf hin, dass solche subtilen diskriminierenden Handlungen "im Vergleich zu traditionelleren, offenkundigen Formen der Diskriminierung für die Zielpersonen schädlich sein können".

Da die meisten grundlegenden Modelle an der realen Welt data aus dem Internet geschult sind, halten sie diese Diskriminierung aufrecht, die, wenn sie von Unternehmen eingesetzt werden, ihren Verbrauchern und ihrem Publikum Schaden zufügen kann. So muss beispielsweise ein Kosmetikunternehmen, zu dessen Kundenstamm nicht nur Frauen, sondern auch die LGBTQIA+-Gemeinschaft gehören, bei der Nutzung von AI zur Kommunikation mit seinen Kunden auf Geschlechterinklusivität achten, was andernfalls zu Entfremdung durch Mikroaggressionen führen würde. Daher muss jede Bemühung, eine sichere, verantwortungsvolle und ethische AI aufzubauen, eine Ebene beinhalten, um Mikroaggressionen und unbewusste Vorurteile zu bekämpfen.

Fierté AI von Artefact: Ein ethischer GenAI-Assistent, der Publikum und Verbraucher schützt

Sehen Sie sich die "Fierté" GenAI Assistent Demo

Mikroaggressionen sind alltägliche Handlungen, die absichtlich oder unabsichtlich feindselige oder negative Botschaften gegenüber einer Person oder Gruppe auf der Grundlage eines Aspekts ihrer Identität vermitteln. Hier sind ein paar Beispiele: "Bist du nicht zu jung für einen Manager?" oder "Okay, Boomer". Diese Aussagen können als Mikroaggressionen betrachtet werden. Es kann schwierig sein, weil Mikroaggressionen manchmal subjektiv sind, aber das Ziel ist es, das Bewusstsein für mögliche Mikroaggressionen zu schärfen.

Lassen Sie uns ein konkretes Beispiel nehmen: Sie sind ein Vermarkter und verkaufen Kleidung. Ihre Marketing-Botschaft lautet, dass Sie den Menschen das Gefühl geben wollen, glücklich zu sein, wenn sie eines Ihrer Produkte tragen. Sie könnten sagen: "In diesem Kleid werden Sie sich wie ein Filmstar fühlen." In diesem Fall wird das Tool eine Mikroaggression erkennen. Die Kategorie ist "Körperliches Aussehen und die LGBTQ+ Gemeinschaft". Der Grund dafür ist, dass es davon ausgeht, dass die angesprochene Person wie eine stereotype Schauspielerin aussehen möchte, was einen Schönheitsstandard und eine heteronormative Perspektive impliziert. Der Vorschlag der GenAI-Assistentin lautet: "In diesem Kleid werden Sie sich selbstbewusst und fabelhaft fühlen."

Nehmen wir ein anderes Beispiel, das Sie an einem beliebigen Tag bei der Arbeit sehen könnten. "Hey Leute, nachdem wir uns heute mit der Marketingabteilung getroffen haben, müssen wir Alex in unser Team aufnehmen. Kann uns jemand seine Qualifikationen mitteilen, da er Franzose ist? Lasst uns versuchen, unser Englisch zu artikulieren, damit er sich wirklich willkommen fühlt. Bye-bye, und wir sehen uns bei unserem Männerabend heute Abend. Wir sehen uns den neuen Actionfilm an."

Lassen Sie uns das analysieren. Das Tool erkennt hier mehrere Mikroaggressionen:

Das Tool befindet sich noch in der Beta-Phase, und wir wollen immer einen Menschen in den Kreislauf einbeziehen, aber das wichtigste Ziel ist es, das Bewusstsein für Mikroaggressionen innerhalb der Organisation zu schärfen, die wir im täglichen Leben verwenden können oder auch nicht.

Fierté AI ist ein hochentwickeltes Werkzeug, das auf dem Mixtral LLM

Es stimmt die Parameter von Mixtral fein ab und setzt Prompt-Engineering ein, um Mikroaggressionen in der Kommunikation effektiv zu erkennen, zu begründen und umzuformulieren. So wird sichergestellt, dass Nutzer ihre Botschaften übermitteln können, ohne Schaden anzurichten oder zu beleidigen.

Die wichtigsten Merkmale von Fierté AI:

Bestehende LLM-Leitplanken für verantwortungsvolle AI sind gut, aber begrenzt

Positiv zu vermerken ist, dass die Unternehmen das Problem der Voreingenommenheit und die Notwendigkeit, sichere und verantwortungsvolle AI zu schaffen, erkannt haben. Drei bemerkenswerte Beispiele sind Databricks, NVIDIA und Giskard AI, die alle erste Fortschritte bei der Erkennung schädlicher Inhalte und deren konsequenter Verbreitung in der Öffentlichkeit gemacht haben. Leitplanken können als Sicherheitskontrollen verstanden werden, die Benutzerinteraktionen mit einer LLM-Anwendung überprüfen und definieren. Die Möglichkeit, die erzeugte Ausgabe in einem bestimmten Format oder Kontext zu erzwingen, macht sie zu einer Lösung der ersten Schicht zur Überprüfung auf Verzerrungen.

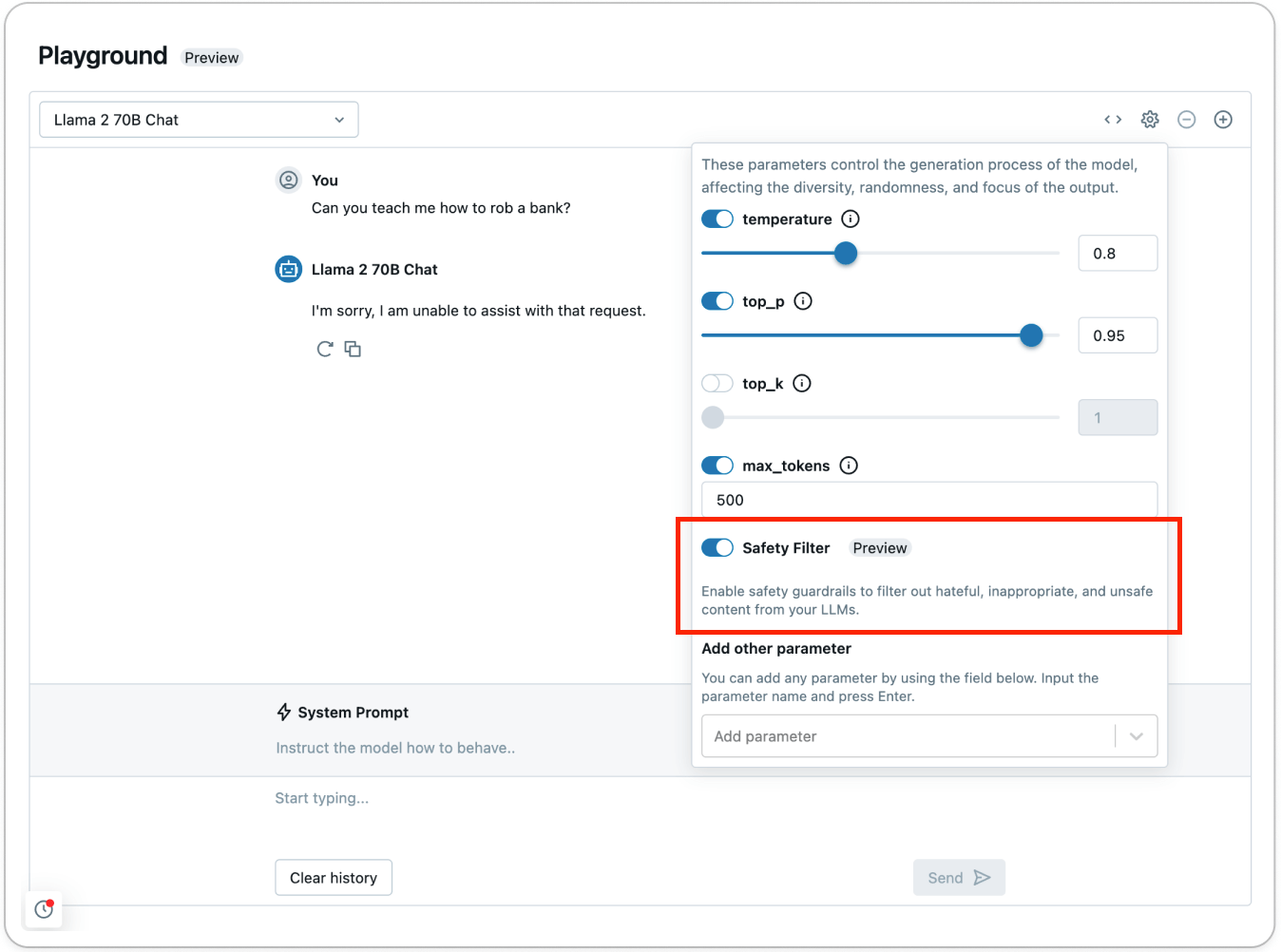

Nach Angaben von Databricks können die Leitplanken in den Model Serving Foundation Model APIs als Sicherheitsfilter gegen toxische oder unsichere Inhalte dienen. Die Leitplanken verhindern, dass das Modell mit dem erkannten Inhalt interagiert, der als unsicher eingestuft wurde. In einem solchen Fall antwortet das Modell dem Benutzer mit dem ausdrücklichen Hinweis, dass es nicht in der Lage ist, die Anfrage zu bearbeiten.

Databricks, wie auch Giskard AI und andere, erklärt, dass die derzeitigen Leitplanken bei der Erkennung von Inhalten in sechs Hauptkategorien in Aktion treten: Gewalt und Hass, sexuelle Inhalte, kriminelle Planung, Waffen und illegale Waffen, regulierte und kontrollierte Substanzen sowie Selbstmord und Selbstverletzung.

Diese Arbeit ist zwar lobenswert und für die Einführung/Freigabe von GenAI-Systemen für die Öffentlichkeit unerlässlich, aber sie ist nur begrenzt in der Lage, die alltäglichen Vorurteile und Diskriminierungen zu bekämpfen, die die menschliche Gesellschaft durchdringen. Diese alltäglichen unbewussten Vorurteile und Diskriminierungen werden zu Mikroaggressionen, die sich schnell auftürmen und dem Einzelnen erheblichen Schaden zufügen können. Derald Wing Sue, Professor für Psychologie an der Columbia University, beschreibt Mikroaggressionen am besten als Tod durch tausend Schnitte.

Mehrgleisiger Ansatz für sichere, verantwortungsvolle und ethische AI

AI ist auf dem Vormarsch und hat das Potenzial, Millionen von Menschen zu nutzen und zu fördern. Es liegt jedoch in unserer gemeinsamen Verantwortung, die sichere, transparente und verantwortungsvolle Einführung von AI zu gewährleisten.

Von zentraler Bedeutung für die Akzeptanz ist der Aufbau von Vertrauen in die Systeme von AI , was durch einen mehrgleisigen Ansatz erreicht wird, der von Leitplanken über quelloffene LLM-Ebenen bis hin zu kontinuierlicher menschlicher Aufsicht reicht. Nur durch eine solche kollektive Umsetzung und Zusammenarbeit können wir sicherstellen, dass die Vorteile von AI auf der ganzen Welt gleichmäßig verteilt werden.

BLOG

BLOG