Una serie de controversias en torno a los resultados de los modelos GenAI ha incrementado la defensa de la supervisión ética y la gobernanza de AI. Mientras que el sesgo explícito, la violencia y la discriminación han avanzado, el sesgo implícito y las microagresiones no lo han hecho.

En vísperas del Mes del Orgullo 2024, Artefact lanzó Fierté AI, un asistente LLM ético de código abierto que puede detectar y reformular microagresiones y sesgos inconscientes en todos los modelos GenAI.

En Artefact, realmente creemos que "AI es sobre las personas". Esta ha sido nuestra principal motivación para construir Fierté AI. "Fierté" significa "orgullo" en francés y representa la lucha constante de la comunidad LGBTQIA+ por la igualdad en la sociedad.

La GenAI está dando rienda suelta a la creatividad y la innovación a gran escala, con el potencial de influir positivamente en la vida de millones de personas en todo el mundo. Sin embargo, una serie de controversias éticas ha suscitado inquietudes sobre el despliegue seguro y ético de los sistemas GenAI. Aunque la GenAI parece nueva y llamativa, parece estar plagada de los mismos viejos prejuicios.

Un informe de la UNESCO de marzo de 2024 destaca cómo "los resultados de Generative AIsiguen reflejando un considerable sesgo basado en el género y la sexualidad, asociando nombres femeninos a roles de género tradicionales, generando contenidos negativos sobre temas homosexuales,...". A pesar de las limitaciones expresadas en el estudio, éste subraya la omnipresencia del sesgo en GenAI y la necesidad de una mejor supervisión desde la base, como la formación data utilizada para los modelos, hasta la cima, como la adición de capas para auditorías y revisiones de seguridad.

¿Qué son las microagresiones y los prejuicios inconscientes?

A lo largo de la historia, las comunidades o grupos marginados han luchado por la igualdad de derechos y representación. Estas comunidades o grupos representan a mujeres, personas LGBTQIA+, personas de color, personas con discapacidad y muchos más. Aunque cada vez hay más aceptación e inclusión de la igualdad de derechos, estas comunidades y grupos siguen sufriendo discriminación a diario por el hecho de ser minoría. Estos incidentes pueden ser provocados accidental o inconscientemente por prejuicios sociales sistémicos o perpetuados intencionadamente para afirmar la dominación, lo que, sumado a otros factores, puede causar daños psicológicos significativos. La investigación sugiere que tales actos sutiles de discriminación pueden ser "perjudiciales para los objetivos en comparación con formas más tradicionales y manifiestas de discriminación."

Dado que la mayoría de los modelos fundacionales se forman en el mundo real data de Internet, perpetúan esta discriminación que, cuando es desplegada por las empresas, puede infligir daño a sus consumidores y audiencias. Por ejemplo, una empresa de belleza y cosméticos Compañia cuya base de consumidores incluya no sólo a mujeres, sino también a la comunidad LGBTQIA+, debe tener en cuenta la inclusión de género cuando utilice AI para comunicarse con sus consumidores, lo que de otro modo causaría alienación a través de microagresiones. Por lo tanto, cualquier esfuerzo por construir una AI segura, responsable y ética debe incluir una capa para abordar las microagresiones y los prejuicios inconscientes.

Fierté AI por Artefact: Un asistente GenAI ético que protege al público y a los consumidores

Ver la demo "Fierté GenAI

Las microagresiones son acciones cotidianas que, intencionadamente o no, transmiten mensajes hostiles o negativos hacia una persona o grupo basándose en un aspecto de su identidad. He aquí algunos ejemplos: "¿No eres demasiado joven para ser directivo?" o "Vale, Boomer". Éstas pueden considerarse microagresiones. Puede ser complicado porque a veces las microagresiones son subjetivas, pero el objetivo es concienciar sobre las posibles microagresiones.

Pongamos un ejemplo concreto: Usted es comercial y vende ropa. Su mensaje de marketing es que quiere que la gente se sienta feliz cuando lleve uno de sus artículos. Podría decir: "Este vestido te hará sentir como una estrella de cine". En este caso, la herramienta detectará una microagresión. La categoría es "apariencia física y la comunidad LGBTQ+". La razón es que asume que la persona a la que se dirige quiere parecerse a una actriz estereotipada, lo que implica un estándar de belleza y una perspectiva heteronormativa. La sugerencia del asistente de GenAI es: "Este vestido te hará sentir segura y fabulosa".

Pongamos otro ejemplo que se puede ver un día cualquiera en el trabajo. "Hola chicos, después de reunirnos hoy con el departamento de marketing, necesitamos incorporar a Alex al equipo. ¿Alguien puede compartir sus credenciales, ya que es francés? Intentemos articular nuestro inglés para que se sienta realmente bienvenido. Adiós, y nos vemos en nuestra noche de hombres esta noche. Vamos a ver la nueva película de acción".

Analicemos esto. La herramienta detecta múltiples microagresiones aquí:

La herramienta está en fase beta y siempre queremos incluir a un humano en el bucle, pero el objetivo más importante es aumentar la concienciación sobre las microagresiones dentro de la organización que podemos o no utilizar en el día a día.

Fierté AI es una sofisticada herramienta basada en Mixtral LLM

Ajusta con precisión los parámetros de Mixtral y emplea ingeniería de avisos para detectar, razonar y reformular eficazmente las microagresiones en la comunicación. Esto garantiza que los usuarios puedan transmitir sus mensajes sin causar daño ni ofender.

Características principales de Fierté AI:

Los mecanismos de protección existentes para los responsables de AI son buenos, pero limitados.

En un tono más positivo, las empresas han reconocido el problema de la parcialidad y la necesidad de construir un sitio web seguro y responsable AI. Cabe destacar a Databricks, NVIDIA y Giskard AI, que han dado los primeros pasos en la detección de contenidos nocivos y su consiguiente difusión al público. Los Guardrails pueden entenderse como controles de seguridad que revisan y definen las interacciones del usuario con una aplicación LLM. La capacidad de forzar que la salida generada esté en un formato o contexto específico le permite ser una solución de primera capa para comprobar la existencia de sesgos.

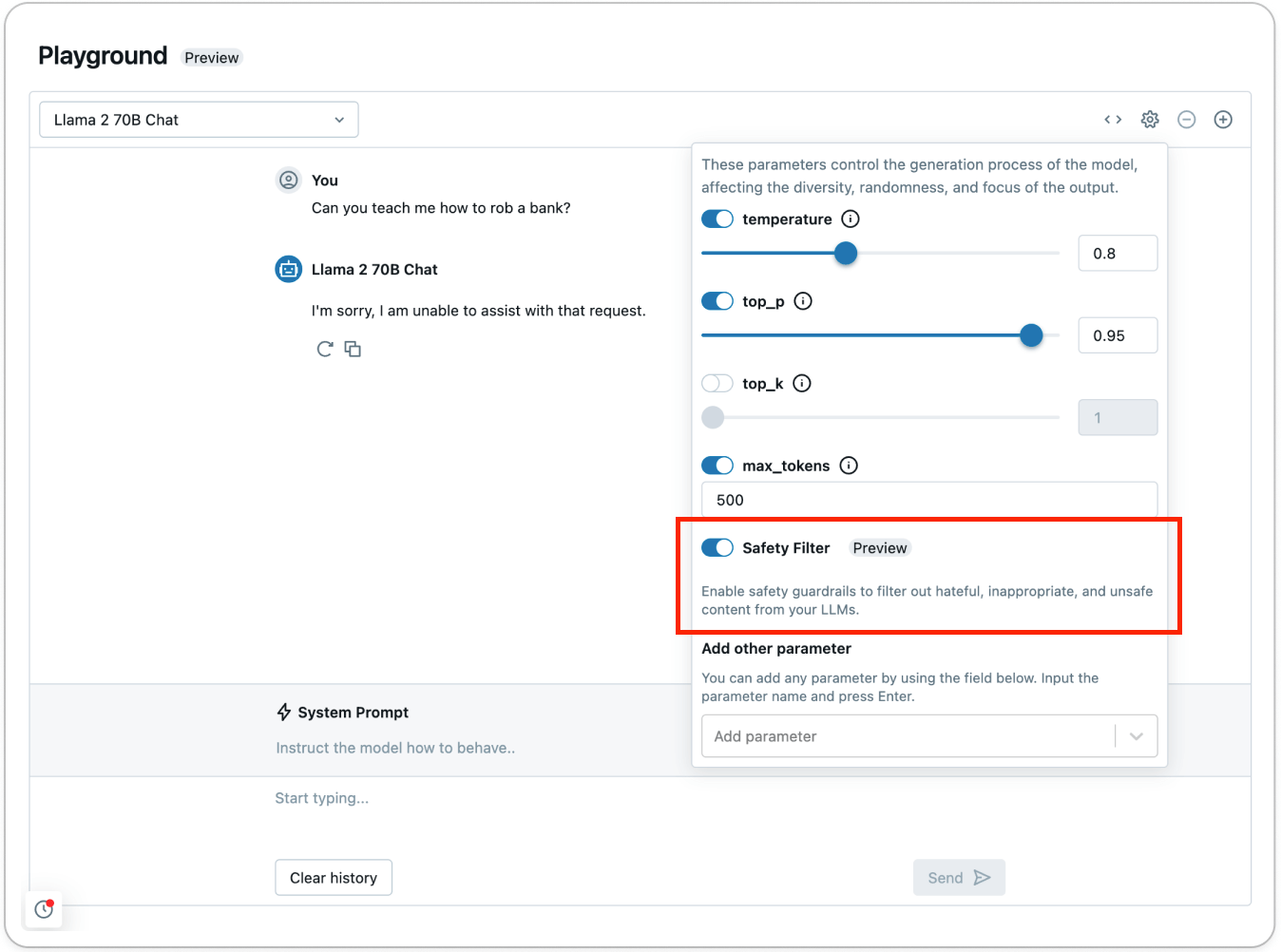

Según Databricks, los guardarraíles de sus API de Model Serving Foundation Model pueden actuar como filtro de seguridad contra cualquier contenido tóxico o inseguro. La barandilla impide que el modelo interactúe con el contenido detectado que se haya considerado inseguro. En tal caso, el modelo responde al usuario indicando explícitamente que no puede atender la solicitud.

Databricks, al igual que Giskard AI y otros, afirma que los actuales controles de seguridad entran en acción al detectar contenidos de seis categorías principales: Violencia y odio, Contenido sexual, Planificación delictiva, Armas de fuego y armas ilegales, Sustancias reguladas y controladas, y Suicidio y autolesiones.

Aunque este trabajo es encomiable e imperativo para el despliegue y la puesta a disposición del público de los sistemas GenAI, su capacidad para abordar los prejuicios y la discriminación cotidianos que impregnan la sociedad humana es limitada. Estos casos de prejuicios y discriminación inconscientes cotidianos se convierten en microagresiones, que pueden acumularse rápidamente y causar daños significativos a las personas. Derald Wing Sue, catedrático de Psicología de la Universidad de Columbia, describe la microagresión como la muerte por mil cortes.

Enfoque múltiple de la seguridad, la responsabilidad y la ética AI

AI está aquí para quedarse y tiene el potencial de beneficiar y elevar a millones de personas. Sin embargo, es nuestra responsabilidad colectiva garantizar la adopción segura, transparente y responsable de AI.

Un elemento central para la adopción es generar confianza en los sistemas de AI , lo que se consigue mediante un enfoque múltiple que va desde los guardarraíles a las capas LLM de código abierto y la supervisión humana continua. Solo a través de este tipo de aplicación y colaboración colectivas podremos garantizar que los beneficios de AI se compartan equitativamente en todo el mundo.

BLOG

BLOG