Une série de controverses entourant les résultats des modèles de GenAI a renforcé le plaidoyer en faveur d'une surveillance et d'une gouvernance éthiques de l'IA. Si les préjugés explicites, la violence et la discrimination ont progressé, ce n'est pas le cas des préjugés implicites et des microagressions.

À la veille du Mois des Fiertés 2024, Artefact a publié Fierté AI, un assistant LLM éthique open source qui peut détecter et reformuler les microagressions et les préjugés inconscients dans tous les modèles GenAI.

À Artefact, nous croyons vraiment que "AI is about people". C'est ce qui nous a motivés à créer Fierté AI. "Fierté" signifie "fierté" en français et représente la lutte permanente de la communauté LGBTQIA+ pour l'égalité dans la société.

La GenAI libère la créativité et l'innovation à grande échelle, avec le potentiel d'avoir un impact positif sur la vie de millions de personnes dans le monde. Cependant, un certain nombre de controverses éthiques ont soulevé des inquiétudes quant à la sécurité et à l'éthique du déploiement des systèmes de GenAI. Alors que la GenAI semble nouvelle et tape-à-l'œil, elle semble être criblée des mêmes vieux préjugés.

Un rapport de l'UNESCO datant de mars 2024 souligne que "les résultats de l'IA générative reflètent encore une quantité considérable de préjugés fondés sur le genre et la sexualité, associant des noms féminins à des rôles de genre traditionnels, générant un contenu négatif sur des sujets gays,...". Malgré les limites exprimées par l'étude, celle-ci souligne l'omniprésence des préjugés dans la GenAI et la nécessité d'une meilleure surveillance au niveau de la base, comme la formation data utilisée pour les modèles, jusqu'au sommet, comme l'ajout de couches d'audits et d'examens de sécurité.

Que sont les microagressions et les préjugés inconscients ?

Tout au long de l'histoire, des communautés ou des groupes marginalisés ont lutté pour l'égalité des droits et la représentation. Ces communautés ou groupes représentent les femmes, les personnes LGBTQIA+, les personnes de couleur, les personnes handicapées et bien d'autres encore. Bien que l'égalité des droits soit de plus en plus acceptée et prise en compte, ces communautés et groupes sont toujours confrontés à une discrimination quotidienne du fait de leur appartenance à une minorité. Ces incidents peuvent être accidentellement ou inconsciemment motivés par des préjugés sociétaux systémiques ou être intentionnellement perpétués pour affirmer la domination, ce qui, une fois aggravé, peut causer des dommages psychologiques importants. La recherche suggère que ces actes subtils de discrimination peuvent être "préjudiciables aux cibles par rapport aux formes plus traditionnelles et manifestes de discrimination".

Étant donné que la plupart des modèles fondamentaux sont formés sur le site data , ils perpétuent cette discrimination qui, lorsqu'elle est déployée par les entreprises, peut nuire à leurs consommateurs et à leur public. Par exemple, une entreprise de produits de beauté et de cosmétiques dont la base de consommateurs comprend non seulement des femmes, mais aussi la communauté LGBTQIA+, doit être attentive à l'inclusion des genres lorsqu'elle utilise l'IA pour communiquer avec ses consommateurs, ce qui risquerait de provoquer une aliénation par des microagressions. Par conséquent, tout effort visant à mettre en place une IA sûre, responsable et éthique doit inclure une couche de traitement des microagressions et des préjugés inconscients.

Fierté AI par Artefact: Un assistant GenAI éthique qui protège les publics et les consommateurs

Regardez la démo de l'assistant GenAI "Fierté" Démonstration de l'assistant GenAI

Les microagressions sont des actes quotidiens qui, intentionnellement ou non, communiquent des messages hostiles ou négatifs à l'égard d'une personne ou d'un groupe sur la base d'un aspect de leur identité. En voici quelques exemples : "Tu n'es pas trop jeune pour être manager ?" ou "D'accord, Boomer". Ces messages peuvent être considérés comme des microagressions. Cela peut être délicat car les microagressions sont parfois subjectives, mais l'objectif est de sensibiliser aux microagressions potentielles.

Prenons un exemple concret : Vous êtes un spécialiste du marketing et vous vendez des vêtements. Votre message marketing est que vous voulez que les gens se sentent heureux lorsqu'ils portent l'un de vos articles. Vous pourriez dire : "Cette robe vous donnera l'impression d'être une star de cinéma : "Cette robe vous donnera l'impression d'être une star de cinéma". Dans ce cas, l'outil détectera une microagression. La catégorie est "apparence physique et communauté LGBTQ+". La raison en est qu'il suppose que la personne à qui l'on s'adresse veut ressembler à une actrice stéréotypée, ce qui implique une norme de beauté et une perspective hétéronormative. La suggestion de l'assistant GenAI est la suivante : "Cette robe vous donnera confiance en vous et vous fera vous sentir fabuleuse".

Prenons un autre exemple que vous pourriez voir un jour au travail. "Après avoir rencontré le service marketing aujourd'hui, nous avons besoin d'ajouter Alex à l'équipe. Quelqu'un peut-il nous communiquer ses références puisqu'il est français ? Essayons d'articuler notre anglais pour qu'il se sente vraiment le bienvenu. Au revoir, et à ce soir pour notre soirée entre hommes. Nous allons voir le nouveau film d'action".

Analysons ceci. L'outil détecte ici plusieurs microagressions :

L'outil est dans sa phase bêta et nous voulons toujours inclure un humain dans la boucle, mais l'objectif le plus important est d'accroître la sensibilisation aux microagressions au sein de l'organisation que nous pouvons ou non utiliser dans la vie de tous les jours.

Fierté AI est un outil sophistiqué construit sur la base de Mixtral LLM.

Il affine les paramètres de Mixtral et utilise l'ingénierie rapide pour détecter, raisonner et reformuler efficacement les microagressions dans la communication. Les utilisateurs peuvent ainsi transmettre leurs messages sans causer de préjudice ou d'offense.

Caractéristiques principales de Fierté AI :

Les garde-fous existants en matière de LLM pour une IA responsable sont bons mais limités

Sur une note plus positive, les entreprises ont reconnu le problème de la partialité et la nécessité de construire une IA sûre et responsable. Trois exemples notables sont Databricks, NVIDIA et Giskard AI, qui ont tous réalisé des avancées initiales dans la détection de contenus préjudiciables et leur diffusion au public. Les garde-fous peuvent être considérés comme des contrôles de sécurité qui examinent et définissent les interactions de l'utilisateur avec une application LLM. La capacité de forcer la sortie générée à être dans un format ou un contexte spécifique en fait une solution de première couche pour vérifier les biais.

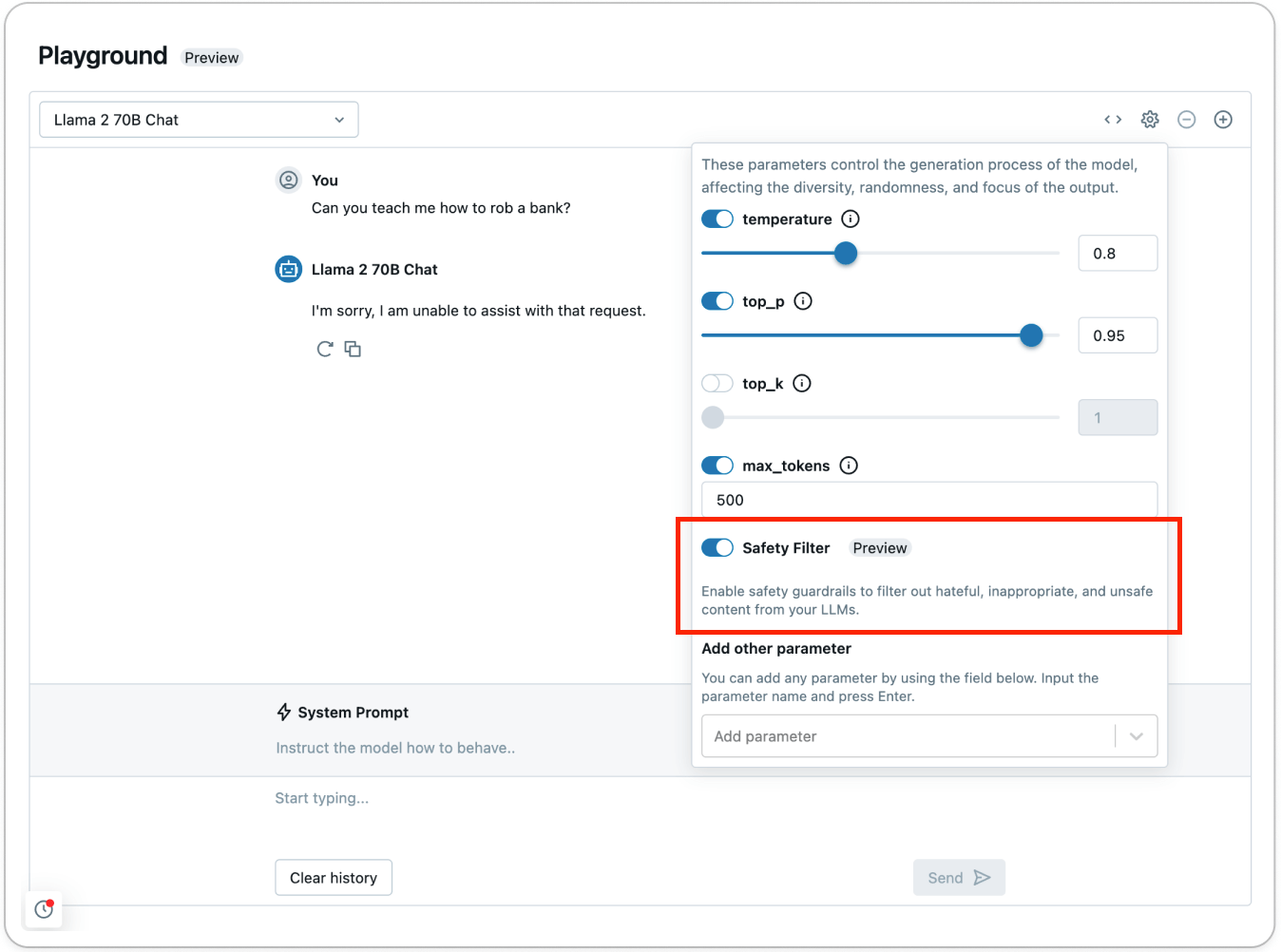

Selon Databricks, les garde-fous de ses API Model Serving Foundation Model peuvent agir comme un filtre de sécurité contre tout contenu toxique ou dangereux. Le garde-fou empêche le modèle d'interagir avec le contenu détecté qui a été jugé dangereux. Dans ce cas, le modèle répond à l'utilisateur en indiquant explicitement qu'il n'est pas en mesure de répondre à la demande.

Databricks, comme Giskard AI et d'autres, affirme que les garde-fous actuels entrent en action dès la détection de contenus appartenant à six catégories principales : Violence et haine, contenu sexuel, planification criminelle, armes à feu et armes illégales, substances réglementées et contrôlées, et suicide et automutilation.

Si ces travaux sont louables et impératifs pour le déploiement/la diffusion des systèmes de GenAI auprès du public, ils sont limités dans leur capacité à s'attaquer aux préjugés et à la discrimination quotidiens qui imprègnent la société humaine. Ces exemples de préjugés et de discriminations inconscients quotidiens deviennent des microagressions, qui peuvent rapidement s'accumuler et causer un préjudice important aux individus. Derald Wing Sue, professeur de psychologie à l'université de Columbia, décrit la microagression comme une mort par mille coupures.

Une approche à plusieurs volets pour une IA sûre, responsable et éthique

L'IA est là pour durer et a le potentiel de profiter à des millions de personnes et de les faire progresser. Cependant, il est de notre responsabilité collective de garantir une adoption sûre, transparente et responsable de l'IA.

La confiance dans les systèmes d'IA est essentielle à l'adoption de ces systèmes, ce qui est possible grâce à une approche à plusieurs volets allant des garde-fous aux couches LLM à source ouverte, en passant par une surveillance humaine permanente. Ce n'est que par une telle mise en œuvre collective et une telle collaboration que nous pourrons garantir que les avantages de l'IA seront partagés équitablement dans le monde entier.

BLOG

BLOG