TL;DR

Questo articolo presenta LLMOps, una branca specializzata che fonde DevOps e MLOps per gestire le sfide poste dai Large Language Models (LLM). Gli LLM, come il GPT di OpenAI, utilizzano ampi dati testuali per attività quali la generazione di testi e la traduzione linguistica. LLMOps affronta problemi come la personalizzazione, le modifiche alle API, la deriva dei dati, la valutazione dei modelli e il monitoraggio attraverso strumenti come LangSmith, TruLens e W&B Prompts. Garantisce l'adattabilità, la valutazione e il monitoraggio degli LLM in scenari reali, offrendo una soluzione completa per le organizzazioni che utilizzano questi modelli linguistici avanzati.

Per guidarvi in questa discussione, inizieremo con una rivisitazione dei principi fondamentali di DevOps e MLOps, quindi ci concentreremo su LLMOps, iniziando con una breve introduzione agli LLM e al loro utilizzo da parte delle organizzazioni. Successivamente, approfondiremo le principali sfide operative poste dalla tecnologia LLM e il modo in cui LLMOps le affronta efficacemente.

Principi fondamentali per LLMOps: DevOps e MLOps

DevOps, acronimo di Development and Operations, è un insieme di pratiche che mirano ad automatizzare il processo di consegna del software, rendendolo più efficiente, affidabile e scalabile. I principi fondamentali di DevOps sono: collaborazione, automazione, test continuo, monitoraggio e orchestrazione del deployment.

MLOps, acronimo di Machine Learning Operations, è un'estensione delle pratiche DevOps specificamente concepita per la gestione del ciclo di vita dei modelli di apprendimento automatico. Affronta le sfide uniche poste dalla natura iterativa e sperimentale dello sviluppo dell'apprendimento automatico. Introduce attività aggiuntive come la gestione e il versionamento dei dati, la sperimentazione e la formazione dei modelli.

LLMOps: gestire la distribuzione e la manutenzione di modelli linguistici di grandi dimensioni

LLMOps, acronimo di Large Language Model Operations, è un ramo specializzato di MLOps, specificamente progettato per gestire le sfide e i requisiti unici della gestione di modelli linguistici di grandi dimensioni (LLM).

Ma prima, cosa sono esattamente gli LLM?

Gli LLM sono un tipo di modello di apprendimento profondo che utilizza enormi quantità di dati testuali per stimare miliardi di parametri. Questi parametri consentono agli LLM di comprendere e generare testi di qualità umana, tradurre lingue, riassumere informazioni complesse e svolgere varie attività di elaborazione del linguaggio naturale.

Come le organizzazioni utilizzano gli LLM

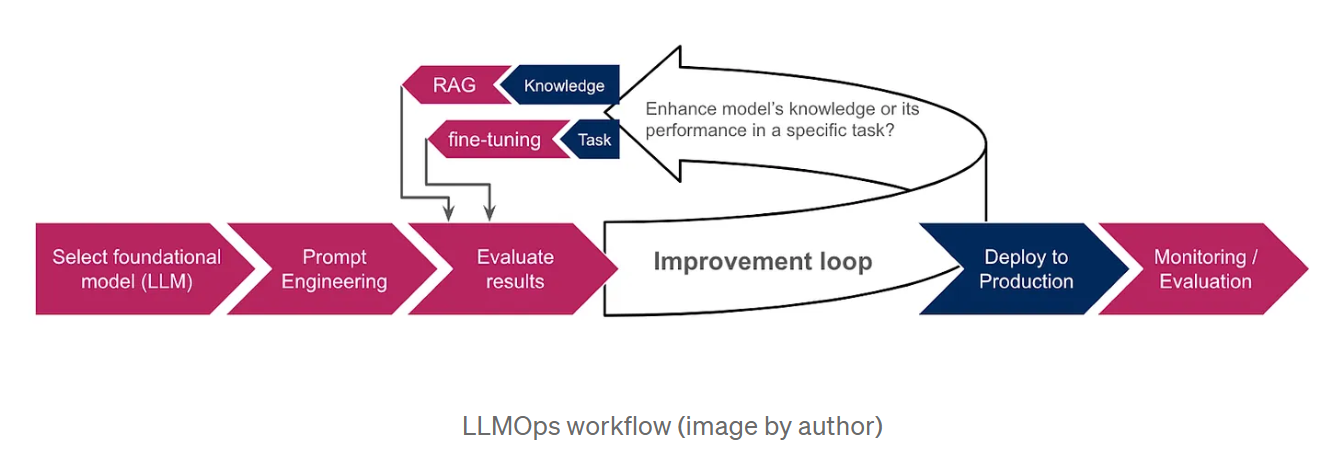

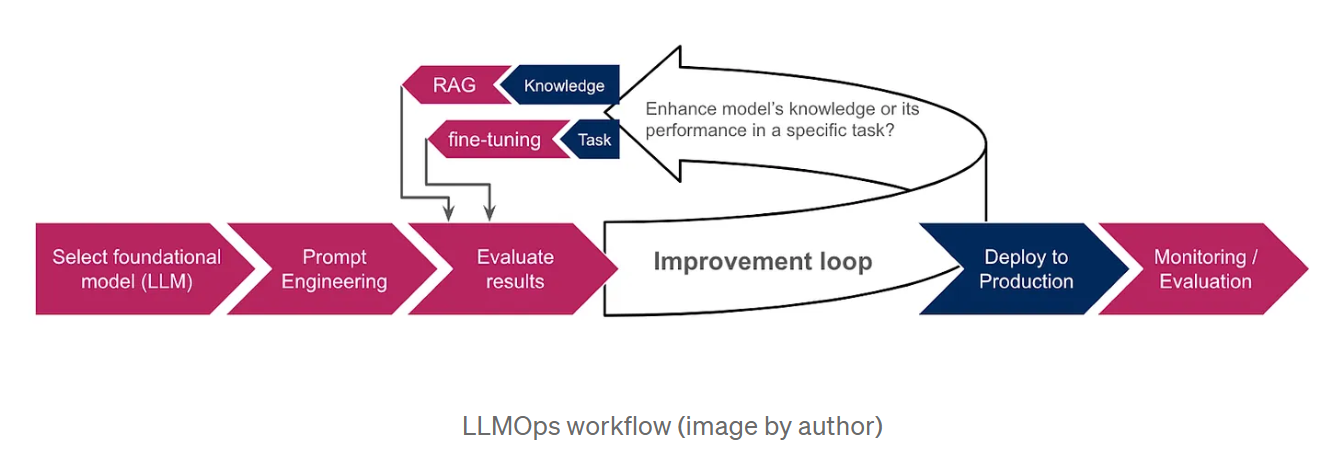

Poiché la formazione di LLM da zero è estremamente costosa e richiede molto tempo, le organizzazioni optano per modelli di base pre-addestrati, come GPT di OpenAI o LaMDA di Google AI, come punto di partenza. Questi modelli, già addestrati su grandi quantità di dati, possiedono conoscenze approfondite e sono in grado di svolgere diversi compiti, tra cui la generazione di testi, la traduzione di lingue e la scrittura di diversi tipi di contenuti creativi. Per personalizzare ulteriormente i risultati del LLM in base a compiti o domini specifici, le organizzazioni impiegano tecniche come il prompt engineering, la retrieval-augmented generation (RAG) e il fine-tuning. Il prompt engineering prevede la creazione di istruzioni chiare e concise che guidano il LLM verso il risultato desiderato, mentre la RAG basa il modello su informazioni aggiuntive provenienti da fonti di dati esterne, migliorandone le prestazioni e la rilevanza. Il fine-tuning, invece, consiste nel regolare i parametri del LLM utilizzando dati aggiuntivi specifici per le esigenze dell'organizzazione. Lo schema seguente fornisce una panoramica del flusso di lavoro LLMOps, illustrando come queste tecniche si integrano nel processo complessivo.

Perché abbiamo bisogno di LLMOps

I rapidi progressi della tecnologia LLM hanno portato alla luce diverse sfide operative che richiedono approcci specializzati.

Alcune di queste sfide includono :

La necessità di personalizzazione: Mentre i LLM sono pre-addestrati su enormi quantità di dati, la personalizzazione è essenziale per ottenere prestazioni ottimali su compiti specifici. Ciò ha portato allo sviluppo di nuove tecniche di personalizzazione, come il prompt engineering, la retrieval-augmented generation(RAG) e il fine-tuning. La RAG aiuta a fondare il modello sulle informazioni più accurate, fornendogli una base di conoscenza esterna, mentre il fine-tuning è più adatto quando si vuole che il modello esegua compiti specifici o che si attenga a un particolare formato di risposta, come JSON o SQL. La scelta tra RAG e fine-tuning dipende dall'obiettivo di migliorare la conoscenza del modello o le sue prestazioni in un compito specifico.

Modifiche alle API: A differenza dei modelli ML tradizionali, gli LLM sono spesso accessibili tramite API di terze parti, che possono essere modificate o addirittura deprecate, rendendo necessario un continuo monitoraggio e adattamento. Ad esempio, la documentazione di Open AI menziona esplicitamente che i suoi modelli sono soggetti ad aggiornamenti regolari, che possono richiedere agli utenti di aggiornare il proprio software o di migrare a modelli o endpoint più recenti.

La deriva dei dati si riferisce a una variazione delle proprietà statistiche dei dati di input, che si verifica spesso in produzione quando i dati incontrati si discostano da quelli su cui sono stati addestrati gli LLM. Questo può portare alla generazione di informazioni imprecise o non aggiornate. Per esempio, nel caso del modello GPT-3.5, le informazioni erano limitate fino a settembre 2021, prima che la data di scadenza fosse estesa a gennaio 2022. Di conseguenza, non poteva rispondere a domande su eventi più recenti, causando la frustrazione degli utenti.

Valutazione del modello: Nell'apprendimento automatico tradizionale, per valutare i nostri modelli ci affidiamo a metriche come l'accuratezza, la precisione e il richiamo. Tuttavia, la valutazione dei LLM è molto più complessa, soprattutto in assenza di dati di verità a terra e quando si ha a che fare con output in linguaggio naturale piuttosto che con valori numerici.

Monitoraggio: Il monitoraggio continuo degli LLM e delle applicazioni basate su LLM è fondamentale. È anche più complicato perché coinvolge molteplici aspetti che devono essere considerati per garantire l'efficacia e l'affidabilità complessiva di questi modelli linguistici. Discuteremo questi aspetti in modo più dettagliato nella prossima sezione.

Come LLMOps affronta queste sfide

LLMOps si basa sulle fondamenta di MLOps, introducendo al contempo componenti specifiche per i LLM:

Gestione dell'ingegneria e della messa a punto dei prompt: LLMOps fornisce strumenti come sistemi di controllo delle versioni dei prompt per tenere traccia e gestire le diverse versioni dei prompt. Si integra anche con framework di fine-tuning per automatizzare e ottimizzare il processo di fine-tuning. Un esempio importante di questi strumenti è LangSmith, un framework progettato specificamente per la gestione dei flussi di lavoro LLM. Le sue caratteristiche complete comprendono il versioning immediato, che consente la sperimentazione controllata e la riproducibilità. Inoltre, LangSmith facilita la messa a punto degli LLM utilizzando i dati delle corse dopo un eventuale filtraggio e arricchimento per migliorare le prestazioni del modello.

Gestione delle modifiche API: LLMOps stabilisce processi per monitorare le modifiche alle API, avvisare gli operatori di potenziali interruzioni e consentire il rollback se necessario.

Adattamento dei modelli ai dati in evoluzione: LLMOps facilita l'adattamento dei LLM all'evoluzione dei dati, garantendo che i modelli rimangano pertinenti e performanti quando i modelli di dati cambiano. Ciò potrebbe essere ottenuto monitorando le distribuzioni dei dati e innescando processi di adattamento quando vengono rilevati cambiamenti significativi. Questi processi possono includere:

-> riqualificazione o messa a punto: A seconda dell'entità della deriva dei dati e delle risorse disponibili, si può ricorrere alla riqualificazione o alla messa a punto per mitigarne l'impatto.

-> Adattamento al dominio: Messa a punto dell'LLM su un set di dati del dominio di destinazione.

-> Distillazione della conoscenza: Formazione di un modello più piccolo sfruttando le conoscenze e l'esperienza di un modello più grande, più potente e aggiornato.

Valutazione specifica per i LLM: LLMOps impiega nuovi strumenti di valutazione adattati ai LLM. Questi includono:

-> metriche basate sul testo, come la perplessità, una misura statistica della capacità del modello di prevedere la parola successiva in una sequenza. Inoltre, le metriche BLEU e ROUGE, che confrontano il testo generato dalla macchina con uno o più testi di riferimento generati dall'uomo. Sono comunemente utilizzate per compiti di traduzione e riassunto.

-> Analisi degli embeddings (rappresentazioni vettoriali di parole o frasi), per valutare la capacità del modello di comprendere parole specifiche del contesto e cogliere le somiglianze semantiche. Le tecniche di visualizzazione e di clustering possono aiutarci anche nel rilevamento dei bias.

-> LLM valutatori: Utilizzare altri LLM per valutare il nostro modello. Ad esempio, questo può essere fatto attribuendo un punteggio all'output del modello valutato in base a metriche predefinite, come la fluidità, la coerenza, la pertinenza e l'accuratezza dei fatti.

-> Integrazione del feedback umano: LLMOps incorpora meccanismi per raccogliere e incorporare il feedback umano nel ciclo di vita del ML, migliorando le prestazioni del LLM e affrontando i pregiudizi.

TruLens è uno strumento che consente di integrare queste valutazioni nelle applicazioni di LLM attraverso un approccio programmatico noto come Feedback Functions.

Monitoraggio specifico dell'LLM: LLMOps integra un monitoraggio continuo per tenere traccia delle metriche delle prestazioni dell'LLM, identificare potenziali problemi e rilevare derive o distorsioni del concetto. Questo include:

-> Monitoraggio funzionale, con il monitoraggio del numero di richieste, dei tempi di risposta, dell'utilizzo dei token, dei tassi di errore e dei costi.

-> Monitoraggio dei prompt, per garantire la leggibilità e rilevare la tossicità e altre forme di abuso. W&B Prompts è un insieme di strumenti progettati per il monitoraggio delle applicazioni basate su LLM. Può essere utilizzato per analizzare gli input e gli output dei vostri LLM, visualizzare i risultati intermedi e archiviare e gestire in modo sicuro i vostri prompt.

-> Monitoraggio delle risposte; per garantire la pertinenza e la coerenza del modello. Ciò include la prevenzione della generazione di contenuti allucinatori o fittizi, nonché l'esclusione di materiale dannoso o inappropriato. La trasparenza può aiutarci a comprendere meglio la risposta del modello. Può essere stabilita rivelando le fonti di risposta (in RAG) o chiedendo al modello di giustificare il suo ragionamento (catena di pensiero).

Questi dati di monitoraggio possono essere utilizzati per migliorare l'efficienza operativa. Possiamo migliorare la gestione dei costi implementando avvisi sull'utilizzo dei token e impiegando strategie come la memorizzazione nella cache delle risposte precedenti. In questo modo, possiamo riutilizzarle per query simili senza dover invocare nuovamente l'LLM. Inoltre, possiamo ridurre al minimo la latenza optando per modelli più piccoli quando possibile e limitando il numero di token generati.

Conclusione

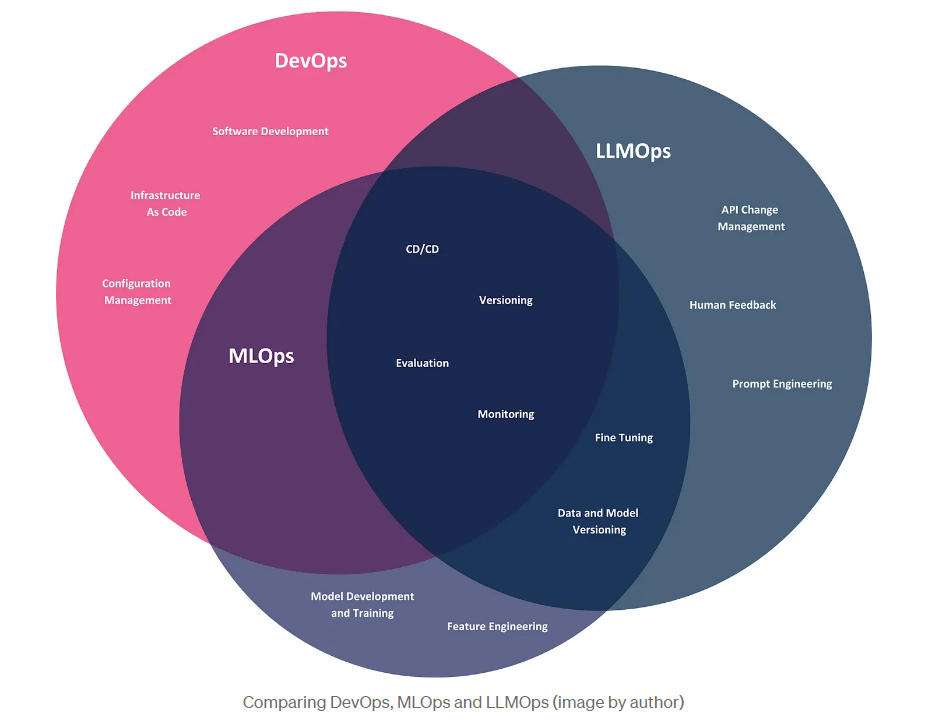

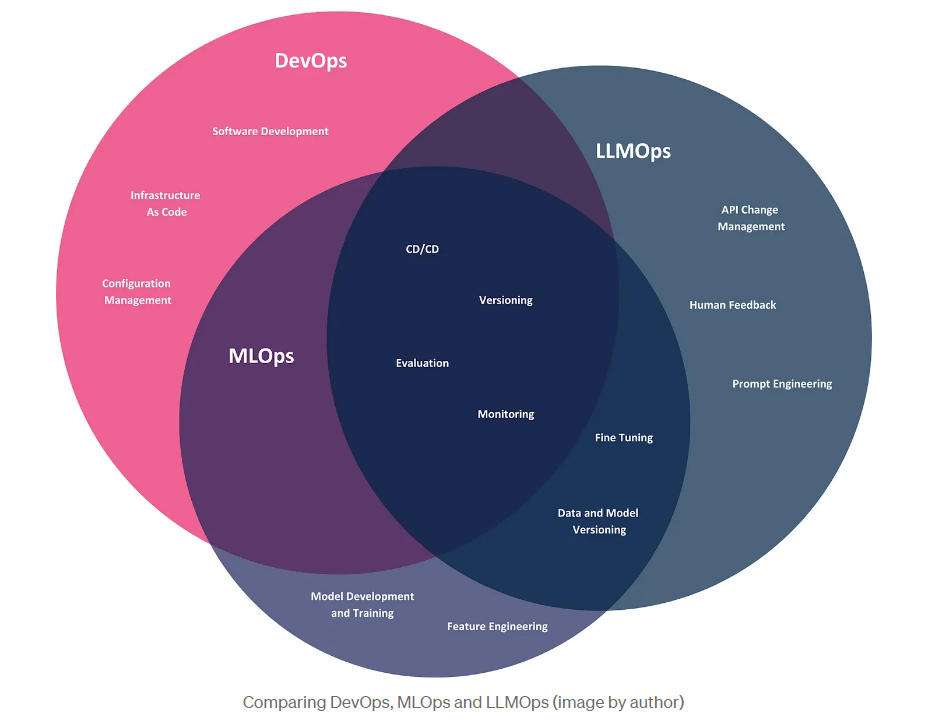

In questo articolo abbiamo esplorato l'emergere di LLMOps, un discendente di DevOps e MLOps, specificamente progettato per affrontare le sfide operative poste dai grandi modelli linguistici. Concludiamo con un confronto visivo di queste tre metodologie, illustrando la loro portata nel contesto delle aziende utilizzatrici di LLM, che sfruttano questi modelli per creare prodotti e risolvere problemi aziendali.

Sebbene le tre metodologie condividano pratiche comuni come CI/CD, versioning e valutazione, ognuna di esse ha aree di interesse distinte. DevOps copre l'intero ciclo di vita dello sviluppo del software, dallo sviluppo alla distribuzione e alla manutenzione. MLOps estende DevOps per affrontare le sfide specifiche dei modelli di apprendimento automatico, tra cui l'automazione dell'addestramento, della distribuzione e del monitoraggio dei modelli. LLMOps, l'ultima iterazione di queste metodologie, si concentra specificamente sugli LLM. Anche se le aziende utilizzatrici di LLM non hanno bisogno di sviluppare i propri modelli, devono comunque affrontare sfide operative, come la gestione delle modifiche alle API e la personalizzazione dei modelli attraverso tecniche come il prompt engineering e il fine-tuning.

BLOG

BLOG