TL;DR

In diesem Artikel wird LLMOps vorgestellt, ein spezieller Zweig, der DevOps und MLOps zur Bewältigung der Herausforderungen von Large Language Models (LLMs) vereint. LLMs, wie OpenAIs GPT, verwenden umfangreiche Texte data für Aufgaben wie Texterstellung und Sprachübersetzung. LLMOps befasst sich mit Themen wie Anpassung, API-Änderungen, data Drift, Modellbewertung und Überwachung durch Tools wie LangSmith, TruLens und W&B Prompts. Es gewährleistet die Anpassbarkeit, Bewertung und Überwachung von LLMs in realen Szenarien und bietet eine umfassende Lösung für Unternehmen, die diese fortschrittlichen Sprachmodelle nutzen.

Um Sie durch diese Diskussion zu führen, werden wir zunächst die Grundprinzipien von DevOps und MLOps wiederholen und uns dann auf LLMOps konzentrieren, beginnend mit einer kurzen Einführung in LLMs und deren Nutzung durch Unternehmen. Als Nächstes werden wir uns mit den wichtigsten betrieblichen Herausforderungen befassen, die durch die LLM-Technologie aufgeworfen werden, und wie LLMOps diese effektiv angeht.

Grundlegende Prinzipien für LLMOps: DevOps und MLOps

DevOps, die Abkürzung für Development and Operations, ist eine Reihe von Praktiken, die darauf abzielen, den Softwarebereitstellungsprozess zu automatisieren und ihn effizienter, zuverlässiger und skalierbarer zu machen. Zu den Kernprinzipien von DevOps gehören: Zusammenarbeit, Automatisierung, kontinuierliche Tests, Überwachung und Orchestrierung der Bereitstellung.

MLOps, kurz für Machine Learning Operations, ist eine Erweiterung der DevOps-Praktiken, die speziell auf das Lebenszyklusmanagement von Machine Learning-Modellen zugeschnitten ist. Es befasst sich mit den einzigartigen Herausforderungen, die durch die iterative und experimentelle Natur der Entwicklung von maschinellem Lernen entstehen. Es werden zusätzliche Aufgaben wie data Versionierung und Verwaltung sowie Experimente und Modelltraining eingeführt.

LLMOps: Verwaltung der Bereitstellung und Wartung großer Sprachmodelle

LLMOps, kurz für Large Language Model Operations, ist ein spezialisierter Zweig von MLOps, der speziell für die besonderen Herausforderungen und Anforderungen der Verwaltung großer Sprachmodelle (LLMs) entwickelt wurde.

Aber zunächst einmal: Was genau sind LLMs?

LLMs sind eine Art von Deep-Learning-Modellen, die große Mengen an Text data verwenden, um Milliarden von Parametern zu schätzen. Diese Parameter ermöglichen es LLMs, Texte in menschlicher Qualität zu verstehen und zu generieren, Sprachen zu übersetzen, komplexe Informationen zusammenzufassen und verschiedene Aufgaben der natürlichen Sprachverarbeitung durchzuführen.

Wie Organisationen LLMs nutzen

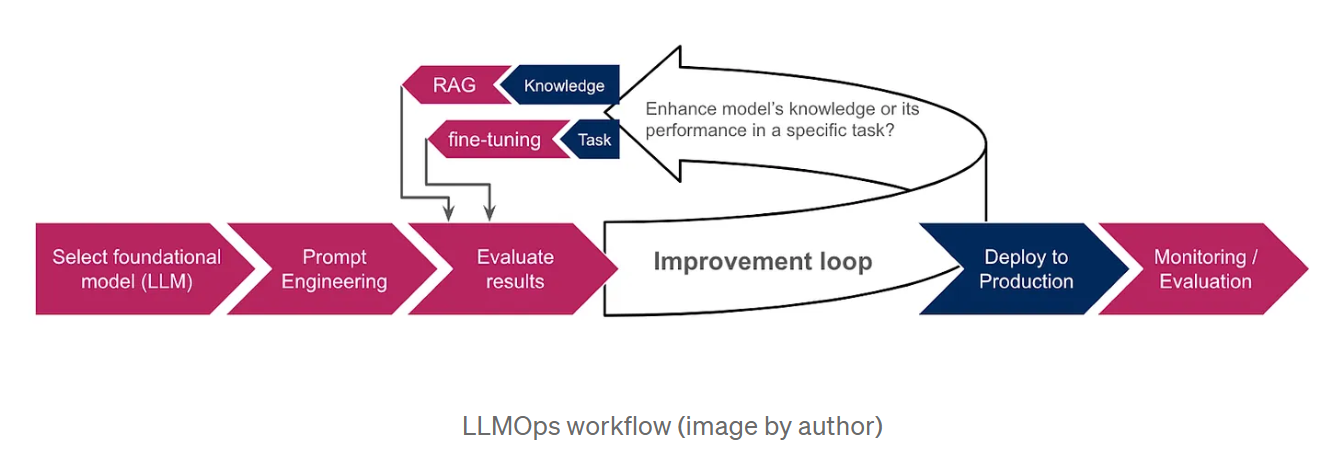

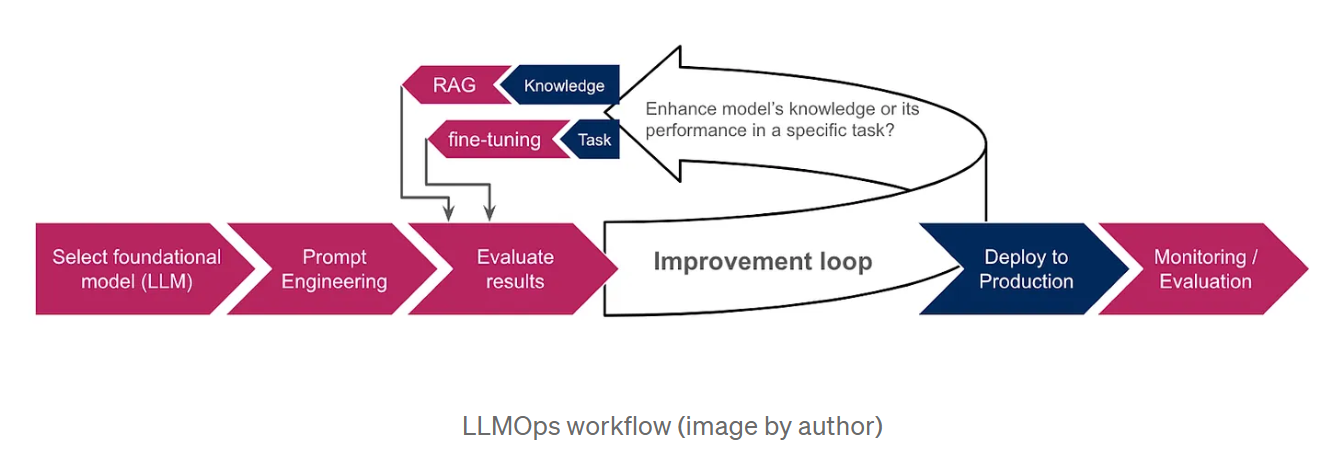

Da es extrem teuer und zeitaufwändig ist, LLMs von Grund auf zu trainieren, entscheiden sich Unternehmen für vortrainierte Basismodelle wie GPT von OpenAI oder LaMDA von Google AIals Ausgangspunkt. Diese Modelle, die bereits auf großen Mengen von data trainiert wurden, verfügen über ein umfangreiches Wissen und können verschiedene Aufgaben ausführen, darunter die Generierung von Text, die Übersetzung von Sprachen und das Schreiben verschiedener Arten von kreativen Inhalten. Zur weiteren Anpassung der LLM-Ausgabe an bestimmte Aufgaben oder Bereiche setzen Organisationen Techniken wie Prompt Engineering, Retrieval-Augmented Generation (RAG) und Fine-Tuning ein. Prompt-Engineering beinhaltet die Erstellung klarer und präziser Anweisungen, die das LLM zum gewünschten Ergebnis führen, während RAG das Modell auf zusätzliche Informationen aus externen data Quellen stützt und so seine Leistung und Relevanz erhöht. Die Feinabstimmung beinhaltet andererseits die Anpassung der Parameter des LLM unter Verwendung zusätzlicher data , die auf die Bedürfnisse der Organisation zugeschnitten sind. Das nachstehende Schema bietet einen Überblick über den LLMOps-Workflow und veranschaulicht, wie diese Techniken in den Gesamtprozess integriert werden.

Warum wir LLMOps brauchen

Die rasanten Fortschritte in der LLM-Technologie haben mehrere operative Herausforderungen ans Licht gebracht, die spezielle Ansätze erfordern.

Zu diesen Herausforderungen gehören unter anderem:

Die Notwendigkeit der Anpassung: Während LLMs auf riesigen Mengen von data vortrainiert sind, ist die Anpassung für eine optimale Leistung bei spezifischen Aufgaben unerlässlich. Dies hat zur Entwicklung neuer Anpassungstechniken wie Prompt Engineering, Retrieval-Augmented Generation(RAG) und Feinabstimmung geführt. RAG hilft dabei, das Modell auf die genauesten Informationen zu gründen, indem es ihm eine externe Wissensbasis zur Verfügung stellt, während die Feinabstimmung besser geeignet ist, wenn das Modell bestimmte Aufgaben erfüllen oder ein bestimmtes Antwortformat wie JSON oder SQL einhalten soll. Die Wahl zwischen RAG und Feinabstimmung hängt davon ab, ob wir das Wissen des Modells erweitern oder seine Leistung bei einer bestimmten Aufgabe verbessern wollen.

API-Änderungen: Im Gegensatz zu herkömmlichen ML-Modellen erfolgt der Zugriff auf LLMs häufig über APIs von Drittanbietern, die geändert oder sogar veraltet sein können, was eine kontinuierliche Überwachung und Anpassung erforderlich macht. In der Dokumentation von Open AI wird beispielsweise ausdrücklich darauf hingewiesen, dass die Modelle regelmäßig aktualisiert werden, was dazu führen kann, dass die Nutzer ihre Software aktualisieren oder auf neuere Modelle oder Endpunkte umsteigen müssen.

Data Drift, bezieht sich auf eine Verschiebung der statistischen Eigenschaften der Eingabedaten data, die häufig in der Produktion auftritt, wenn die angetroffene data von der data abweicht, auf der die LLMs trainiert wurden. Dies kann dazu führen, dass ungenaue oder veraltete Informationen generiert werden. Beim GPT-3.5-Modell beispielsweise waren die Informationen bis September 2021 begrenzt, bevor der Stichtag auf Januar 2022 verlängert wurde. Folglich konnte es keine Fragen zu neueren Ereignissen beantworten, was zur Frustration der Nutzer führte.

Modellbewertung: Beim traditionellen maschinellen Lernen stützen wir uns zur Bewertung unserer Modelle auf Metriken wie Genauigkeit, Präzision und Wiedererkennung. Die Bewertung von LLMs ist jedoch wesentlich komplizierter, vor allem wenn keine Grundwahrheit data vorliegt und wenn es sich um natürliche Sprachausgaben und nicht um numerische Werte handelt.

Überwachung: Die kontinuierliche Überwachung von LLMs und LLM-basierten Anwendungen ist entscheidend. Sie ist auch komplizierter, weil sie mehrere Aspekte umfasst, die berücksichtigt werden müssen, um die allgemeine Wirksamkeit und Zuverlässigkeit dieser Sprachmodelle zu gewährleisten. Wir werden diese Aspekte im nächsten Abschnitt ausführlicher erörtern.

Wie LLMOps diese Herausforderungen angeht

LLMOps baut auf der Grundlage von MLOps auf und führt spezielle Komponenten ein, die auf LLMs zugeschnitten sind:

Prompt-Engineering und Feinabstimmungsmanagement: LLMOps bietet Werkzeuge wie Versionskontrollsysteme für Prompts, um verschiedene Versionen von Prompts zu verfolgen und zu verwalten. Es lässt sich auch in Feinabstimmungs-Frameworks integrieren, um den Feinabstimmungsprozess zu automatisieren und zu optimieren. Ein herausragendes Beispiel für diese Tools ist LangSmith, ein Framework, das speziell für die Verwaltung von LLM-Workflows entwickelt wurde. Seine umfassenden Funktionen umfassen eine sofortige Versionierung, die kontrolliertes Experimentieren und Reproduzierbarkeit ermöglicht. Darüber hinaus erleichtert LangSmith die Feinabstimmung von LLMs unter Verwendung vondata nach eventueller Filterung und Anreicherung zur Verbesserung der Modellleistung.

Verwaltung von API-Änderungen: LLMOps führt Prozesse zur Überwachung von API-Änderungen ein, warnt die Betreiber vor möglichen Störungen und ermöglicht bei Bedarf Rollbacks.

Modellanpassung an sich verändernde data: LLMOps erleichtert die Anpassung von LLMs an sich verändernde data Landschaften und stellt sicher, dass Modelle relevant und leistungsfähig bleiben, wenn sich data Muster verändern. Dies könnte durch die Überwachung von data Verteilungen und die Auslösung von Anpassungsprozessen erreicht werden, wenn signifikante Veränderungen festgestellt werden. Diese Prozesse können Folgendes umfassen:

-> Umschulung oder Feinabstimmung: Je nach dem Ausmaß der data Drift und den verfügbaren Ressourcen kann entweder eine Umschulung oder eine Feinabstimmung vorgenommen werden, um die Auswirkungen zu mildern.

-> Bereichsanpassung: Feinabstimmung des LLM auf einem Datensatz aus dem Zielgebiet.

-> Wissensdestillation: Training eines kleineren Modells durch Nutzung des Wissens und der Erfahrung eines größeren, leistungsfähigeren und aktuelleren Modells.

LLM-spezifische Bewertung: LLMOps setzt neue, an LLMs angepasste Bewertungsinstrumente ein. Diese beinhalten:

-> Textbasierte Metriken, wie z.B. Perplexität; ein statistisches Maß dafür, wie gut das Modell in der Lage ist, das nächste Wort in einer Sequenz vorherzusagen. Sowie BLEU- und ROUGE-Metriken, die maschinell erstellte Texte mit einem oder mehreren von Menschen erstellten Referenztexten vergleichen. Sie werden üblicherweise für Übersetzungs- und Zusammenfassungsaufgaben verwendet.

-> Analyse von Einbettungen (Vektordarstellungen für Wörter oder Phrasen), um die Fähigkeit des Modells zu bewerten, kontextspezifische Wörter zu verstehen und semantische Ähnlichkeiten zu erfassen. Visualisierungs- und Clustering-Techniken können uns auch bei der Erkennung von Verzerrungen helfen.

-> Auswertende LLMs: Verwendung anderer LLMs zur Bewertung unseres Modells. Dies kann z. B. dadurch geschehen, dass der Ausgabe des evaluierten Modells auf der Grundlage vordefinierter Metriken, wie z. B. Geläufigkeit, Kohärenz, Relevanz und sachliche Richtigkeit, eine Punktzahl zugewiesen wird.

-> Integration von menschlichem Feedback: LLMOps umfasst Mechanismen zur Erfassung und Einbeziehung von menschlichem Feedback in den ML-Lebenszyklus, um die LLM-Leistung zu verbessern und Verzerrungen zu beseitigen.

TruLens ist ein Werkzeug, das die Integration dieser Bewertungen in LLM-Anwendungen durch einen programmatischen Ansatz ermöglicht, der als Feedbackfunktionen bekannt ist.

LLM-spezifische Überwachung: LLMOps integriert eine kontinuierliche Überwachung, um LLM-Leistungsmetriken zu verfolgen, potenzielle Probleme zu identifizieren und Konzeptabweichungen oder Verzerrungen zu erkennen. Dies beinhaltet:

-> Funktionsüberwachung; durch Verfolgung der Anzahl der Anfragen, der Antwortzeit, der Token-Nutzung, der Fehlerraten und der Kosten.

-> Überwachung der Prompts, um die Lesbarkeit zu gewährleisten und um Toxizität und andere Formen des Missbrauchs zu erkennen. W&B Prompts ist eine Reihe von Tools, die für die Überwachung von LLM-basierten Anwendungen entwickelt wurden. Damit können Sie die Eingaben und Ausgaben Ihrer LLMs analysieren, die Zwischenergebnisse einsehen und Ihre Prompts sicher speichern und verwalten.

-> Antwortüberwachung; um die Relevanz und Konsistenz des Modells zu gewährleisten. Dazu gehört die Verhinderung der Erzeugung halluzinatorischer oder fiktiver Inhalte sowie der Ausschluss von schädlichem oder unangemessenem Material. Transparenz kann uns helfen, die Reaktion des Modells besser zu verstehen. Sie kann hergestellt werden, indem man Antwortquellen offenlegt (in RAG) oder das Modell auffordert, seine Argumentation zu begründen (Gedankenkette).

Diese Überwachung data kann zur Verbesserung der betrieblichen Effizienz genutzt werden. Wir können das Kostenmanagement verbessern, indem wir Warnungen über die Verwendung von Token implementieren und Strategien wie die Zwischenspeicherung früherer Antworten anwenden. So können wir sie für ähnliche Abfragen wiederverwenden, ohne den LLM erneut aufrufen zu müssen. Darüber hinaus können wir die Latenzzeit minimieren, indem wir uns für kleinere Modelle entscheiden, wann immer dies möglich ist, und die Anzahl der generierten Token einschränken.

Schlussfolgerung

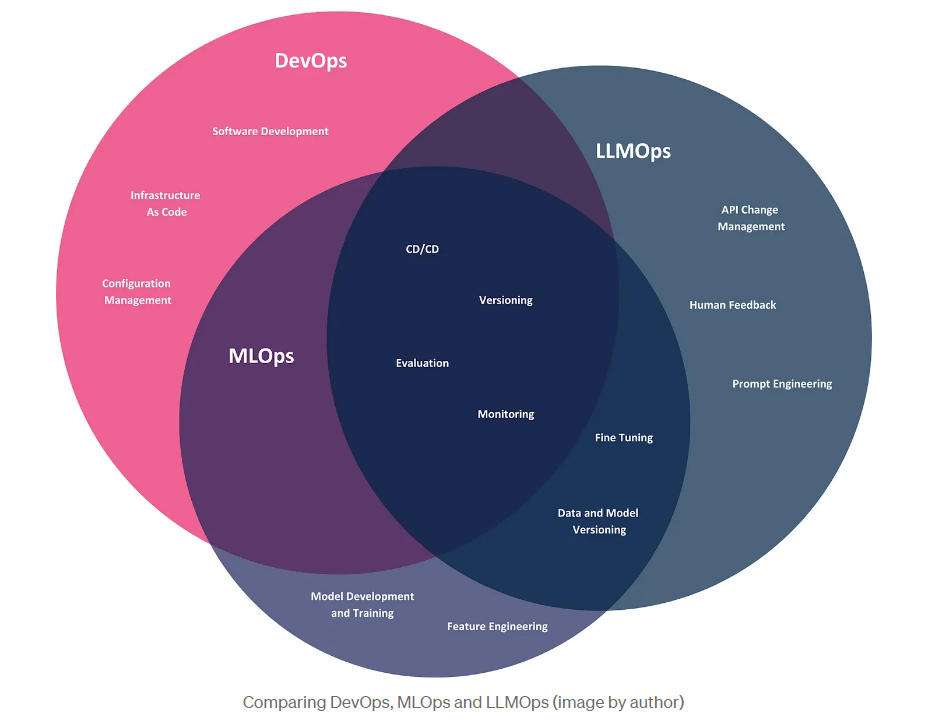

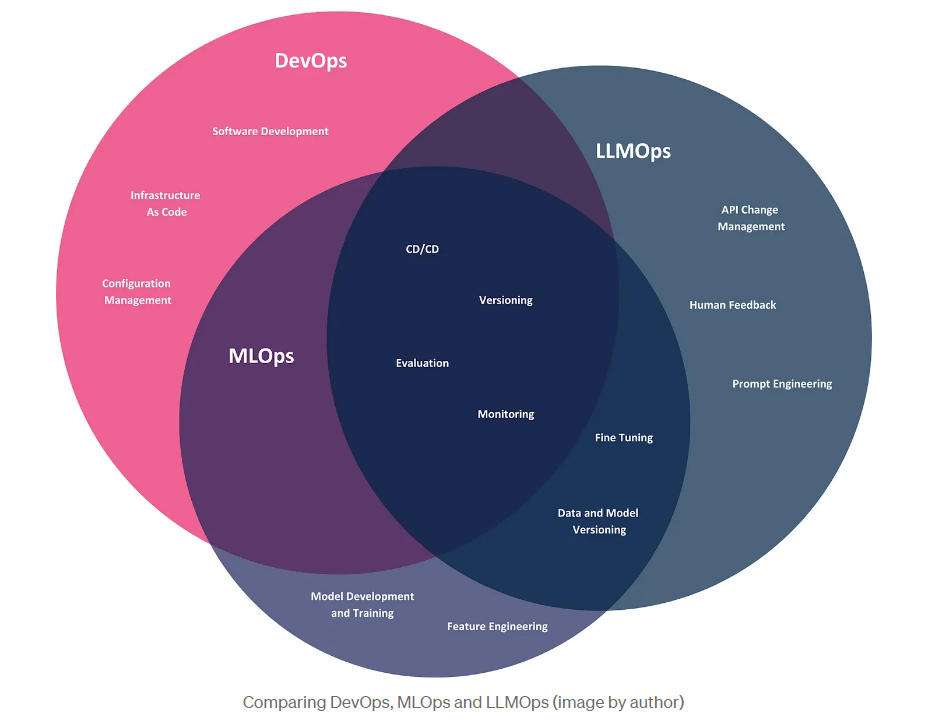

In diesem Artikel haben wir das Aufkommen von LLMOps untersucht, einem Abkömmling von DevOps und MLOps, der speziell für die Bewältigung der operativen Herausforderungen großer Sprachmodelle entwickelt wurde. Lassen Sie uns mit einem visuellen Vergleich dieser drei Methoden abschließen, der ihren Anwendungsbereich im Kontext von LLM-Anwenderunternehmen veranschaulicht, die diese Modelle nutzen, um Produkte zu entwickeln und Geschäftsprobleme zu lösen.

Die drei Methoden haben zwar gemeinsame Praktiken wie CI/CD, Versionierung und Evaluierung, aber sie haben jeweils unterschiedliche Schwerpunkte. DevOps umfasst den gesamten Lebenszyklus der Softwareentwicklung, von der Entwicklung bis zur Bereitstellung und Wartung. MLOps erweitert DevOps, um die spezifischen Herausforderungen von Modellen für maschinelles Lernen zu bewältigen, einschließlich der Automatisierung von Modelltraining, Bereitstellung und Überwachung. LLMOps, die neueste Iteration dieser Methoden, konzentriert sich speziell auf LLMs. Auch wenn LLM-Anwenderunternehmen keine eigenen Modelle entwickeln müssen, stehen sie dennoch vor operativen Herausforderungen, einschließlich der Verwaltung von API-Änderungen und der Anpassung von Modellen durch Techniken wie Prompt Engineering und Feinabstimmung.

BLOG

BLOG