TL;DR

Este artículo presenta LLMOps, una rama especializada que fusiona DevOps y MLOps para gestionar los retos que plantean los grandes modelos lingüísticos (LLM). Los LLM, como el GPT de OpenAI, utilizan un extenso texto data para tareas como la generación de texto y la traducción de idiomas. LLMOps aborda cuestiones como la personalización, los cambios de API, la desviación de data , la evaluación de modelos y la supervisión mediante herramientas como LangSmith, TruLens y W&B Prompts. Garantiza la adaptabilidad, la evaluación y la supervisión de los LLM en escenarios reales, ofreciendo una solución integral para las organizaciones que aprovechan estos modelos lingüísticos avanzados.

Para guiarle a través de este debate, comenzaremos revisando los principios fundamentales de DevOps y MLOps, después nos centraremos en LLMOps, comenzando con una breve introducción a los LLM y su utilización por parte de las organizaciones. A continuación, profundizaremos en los principales retos operativos que plantea la tecnología LLM y cómo LLMOps los aborda de forma eficaz.

Principios fundamentales para LLMOps : DevOps y MLOps

DevOps, abreviatura de Development and Operations (desarrollo y operaciones), es un conjunto de prácticas cuyo objetivo es automatizar el proceso de entrega de software, haciéndolo más eficiente, fiable y escalable. Los principios básicos de DevOps incluyen: colaboración, automatización, pruebas continuas, monitorización y orquestación del despliegue.

MLOps, abreviatura de Machine Learning Operations (operaciones de aprendizaje automático), es una extensión de las prácticas DevOps adaptada específicamente a la gestión del ciclo de vida de los modelos de aprendizaje automático. Aborda los desafíos únicos que plantea la naturaleza iterativa y experimental del desarrollo del aprendizaje automático. Introduce tareas adicionales como el versionado y la gestión de data , así como la experimentación y el entrenamiento de modelos.

LLMOps: gestión de la implantación y el mantenimiento de grandes modelos lingüísticos

LLMOps, abreviatura de Large Language Model Operations (operaciones con grandes modelos lingüísticos), es una rama especializada de MLOps diseñada específicamente para hacer frente a los retos y requisitos exclusivos de la gestión de grandes modelos lingüísticos (LLM).

Pero primero, ¿qué son exactamente los LLM?

Los LLM son un tipo de modelo de aprendizaje profundo que utiliza cantidades masivas de texto data para estimar miles de millones de parámetros. Estos parámetros permiten a los LLM comprender y generar texto de calidad humana, traducir idiomas, resumir información compleja y realizar diversas tareas de procesamiento del lenguaje natural.

Cómo utilizan las organizaciones los LLM

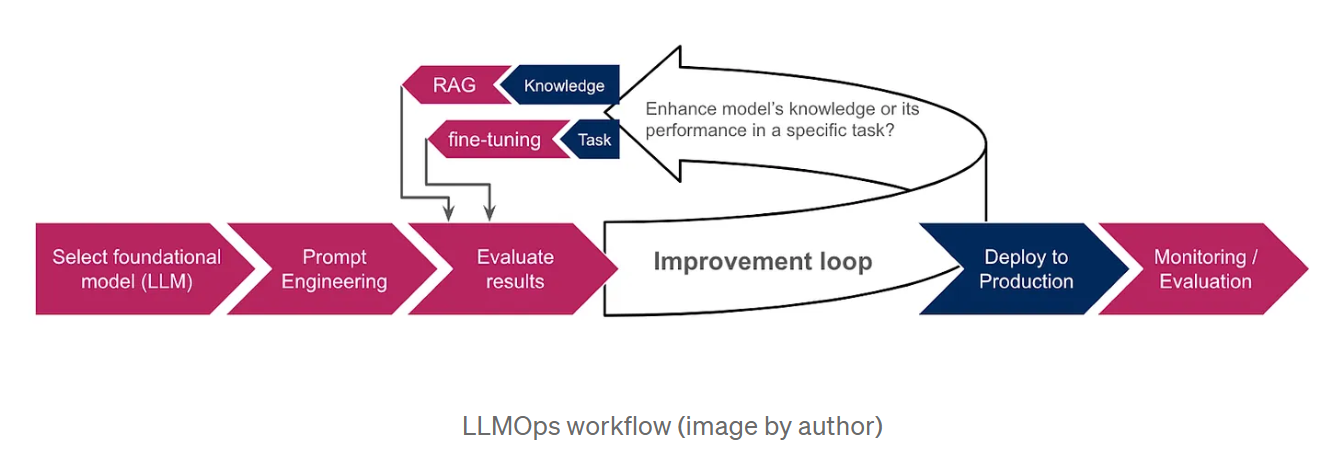

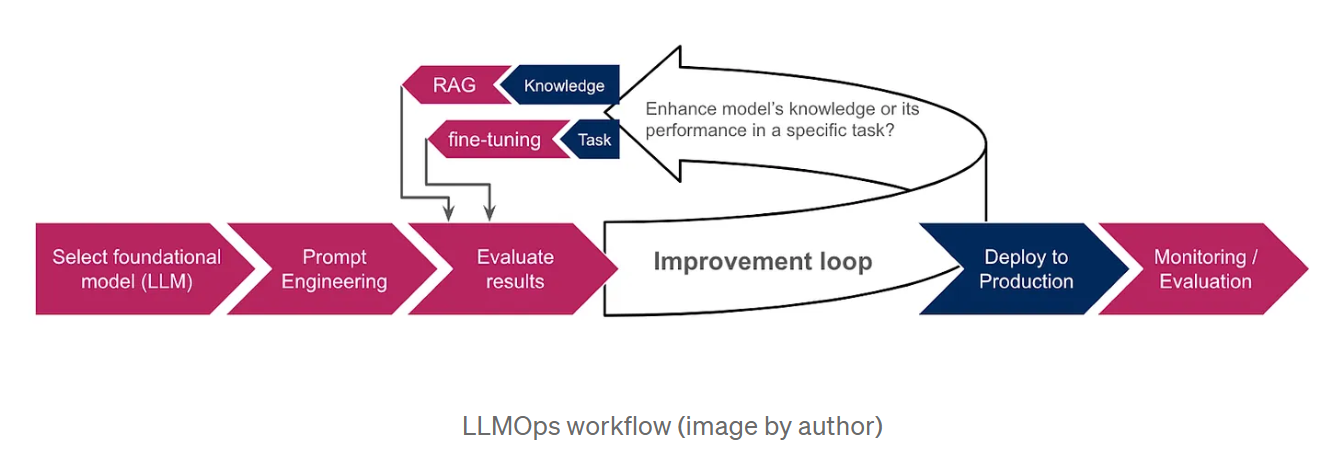

Dado que entrenar a los LLM desde cero es extremadamente caro y requiere mucho tiempo, las organizaciones optan por modelos básicos preentrenados, como GPT de OpenAI o LaMDA de Google AI, como punto de partida. Estos modelos, al estar ya entrenados con grandes cantidades de data, poseen amplios conocimientos y pueden realizar diversas tareas, como generar texto, traducir idiomas y escribir distintos tipos de contenidos creativos. Para adaptar aún más los resultados del LLM a tareas o dominios específicos, las organizaciones emplean técnicas como la ingeniería de instrucciones, la generación aumentada por recuperación (RAG) y el ajuste fino. La ingeniería de avisos consiste en elaborar instrucciones claras y concisas que guíen al LLM hacia el resultado deseado, mientras que la RAG basa el modelo en información adicional procedente de fuentes externas data , lo que mejora su rendimiento y relevancia. El ajuste fino, por su parte, consiste en ajustar los parámetros del LLM utilizando data adicionales específicos para las necesidades de la organización. El siguiente esquema ofrece una visión general del flujo de trabajo del LLMOps e ilustra cómo se integran estas técnicas en el proceso global.

Por qué necesitamos LLMOps

Los rápidos avances de la tecnología LLM han sacado a la luz varios retos operativos que requieren enfoques especializados.

Algunos de estos retos son :

Necesidad de personalización: Aunque los LLM están preentrenados en grandes cantidades de data, la personalización es esencial para un rendimiento óptimo en tareas específicas. Esto ha llevado al desarrollo de nuevas técnicas de personalización, como la ingeniería rápida, la generación aumentada por recuperación(RAG) y el ajuste fino. La RAG ayuda a basar el modelo en la información más precisa al proporcionarle una base de conocimientos externa, mientras que el ajuste fino es más adecuado cuando queremos que el modelo realice tareas específicas o se adhiera a un formato de respuesta concreto, como JSON o SQL. La elección entre RAG y ajuste fino depende de si pretendemos mejorar los conocimientos del modelo o mejorar su rendimiento en una tarea específica.

Cambios de API: A diferencia de los modelos de ML tradicionales, a menudo se accede a los LLM a través de API de terceros, que pueden modificarse o incluso quedar obsoletas, lo que requiere una supervisión y adaptación continuas. Por ejemplo, la documentación de Open AI menciona explícitamente que sus modelos están sujetos a actualizaciones periódicas, lo que puede requerir que los usuarios actualicen su software o migren a modelos o endpoints más recientes.

Data Laderiva se refiere a un cambio en las propiedades estadísticas de la entrada data, que suele ocurrir en la producción cuando la data encontrada se desvía de la data con la que se entrenaron los LLM. Esto puede dar lugar a la generación de información inexacta o desfasada. Por ejemplo, con el modelo GPT-3.5, su información estaba limitada hasta septiembre de 2021, antes de que la fecha límite se ampliara a enero de 2022. En consecuencia, no podía responder a preguntas sobre acontecimientos más recientes, lo que provocaba la frustración de los usuarios.

Evaluación de modelos: En el aprendizaje automático tradicional, nos basamos en métricas como la exactitud, la precisión y la recuperación para evaluar nuestros modelos. Sin embargo, la evaluación de los LLM es mucho más complicada, sobre todo si no se dispone de la verdad sobre el terreno data y si se trata de resultados en lenguaje natural en lugar de valores numéricos.

Supervisión: La monitorización continua de los LLM y de las aplicaciones basadas en ellos es crucial. También es más complicado porque implica múltiples aspectos que deben tenerse en cuenta para garantizar la eficacia y fiabilidad generales de estos modelos lingüísticos. Discutiremos estos aspectos con más detalle en la siguiente sección.

Cómo aborda LLMOps estos retos

LLMOps se basa en los fundamentos de MLOps e introduce componentes especializados adaptados a los LLM:

Ingeniería de avisos y gestión de la puesta a punto: LLMOps proporciona herramientas como los sistemas de control de versiones de avisos para rastrear y gestionar las distintas versiones de los avisos. También se integra con marcos de ajuste para automatizar y optimizar el proceso de ajuste. Un ejemplo destacado de estas herramientas es LangSmith, un marco diseñado específicamente para gestionar flujos de trabajo LLM. Sus completas características incluyen un rápido control de versiones, lo que permite la experimentación controlada y la reproducibilidad. Además, LangSmith facilita el ajuste fino de los LLM utilizando las ejecuciones dedata tras un eventual filtrado y enriquecimiento para mejorar el rendimiento del modelo.

Gestión de cambios en la API: LLMOps establece procesos para supervisar los cambios en la API, alertar a los operadores de posibles interrupciones y permitir la reversión en caso necesario.

Adaptación de los modelos a los cambios de data: LLMOps facilita la adaptación de los LLM a la evolución de los paisajes de data , garantizando que los modelos sigan siendo relevantes y eficaces a medida que cambian los patrones de data . Esto podría lograrse monitorizando las distribuciones de data y activando procesos de adaptación cuando se detecten cambios significativos. Estos procesos pueden incluir:

-> Reajuste o puesta a punto: Dependiendo de la magnitud de la desviación de data y de los recursos disponibles, puede recurrirse al reentrenamiento o al ajuste fino para mitigar su impacto.

-> Adaptación al dominio: Ajuste fino del LLM en un conjunto de datos del dominio de destino.

-> Destilación del conocimiento: Entrenamiento de un modelo más pequeño aprovechando los conocimientos y la experiencia de un modelo más grande, potente y actualizado.

Evaluación específica del LLM: El LLMOps emplea nuevas herramientas de evaluación adaptadas a los LLM. Entre ellas se incluyen:

-> Métricas basadas en texto, como la perplejidad; una medida estadística de lo bien que el modelo es capaz de predecir la siguiente palabra de una secuencia. Así como las métricas BLEU y ROUGE, que comparan el texto generado por la máquina con uno o más textos de referencia generados por humanos. Se suelen utilizar en tareas de traducción y resumen.

-> Análisis de incrustaciones (representaciones vectoriales de palabras o frases), para evaluar la capacidad del modelo de comprender palabras específicas del contexto y captar similitudes semánticas. Las técnicas de visualización y agrupación pueden ayudarnos también en la detección de sesgos.

-> LLMs evaluadores: Utilizar otros LLMs para evaluar nuestro modelo. Por ejemplo, esto puede hacerse atribuyendo una puntuación a la salida del modelo evaluado basada en métricas predefinidas, como fluidez, coherencia, relevancia y precisión factual.

-> Integración de la retroalimentación humana: LLMOps incorpora mecanismos para recoger e incorporar el feedback humano en el ciclo de vida del ML, mejorando el rendimiento del LLM y abordando los sesgos.

TruLens es una herramienta que permite la integración de estas evaluaciones en las aplicaciones LLM a través de un enfoque programático conocido como Funciones de Retroalimentación.

Supervisión específica del LLM: LLMOps integra una supervisión continua para realizar un seguimiento de las métricas de rendimiento de LLM, identificar posibles problemas y detectar desviaciones o sesgos conceptuales. Esto incluye:

-> Monitorización funcional; mediante el seguimiento del número de peticiones, tiempo de respuesta, uso de tokens, tasas de error y coste.

-> Supervisión de las instrucciones, para garantizar la legibilidad y detectar toxicidad y otras formas de abuso. W&B Prompts es un conjunto de herramientas diseñadas para monitorizar aplicaciones basadas en LLM. Puede utilizarse para analizar las entradas y salidas de sus LLM, visualizar los resultados intermedios y almacenar y gestionar de forma segura sus prompts.

-> Monitorización de respuestas; para garantizar la pertinencia y coherencia del modelo. Esto incluye evitar la generación de contenidos alucinantes o ficticios, así como garantizar la exclusión de material nocivo o inapropiado. La transparencia puede ayudarnos a comprender mejor la respuesta del modelo. Puede establecerse revelando las fuentes de respuesta (en GAR) o pidiendo al modelo que justifique su razonamiento (cadena de pensamiento).

Esta supervisión data puede utilizarse para mejorar la eficacia operativa. Podemos mejorar la gestión de costes implementando alertas sobre el uso de tokens y empleando estrategias como el almacenamiento en caché de respuestas anteriores. Esto nos permite reutilizarlas para consultas similares sin tener que invocar de nuevo al LLM. Además, podemos minimizar la latencia optando por modelos más pequeños siempre que sea posible y limitando el número de tokens generados.

Conclusión

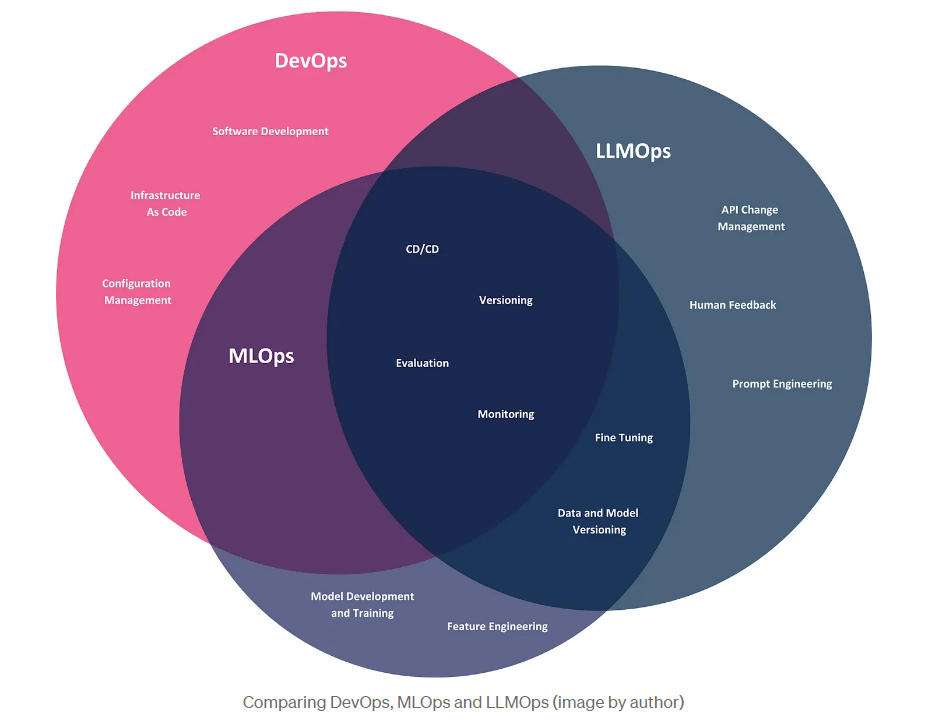

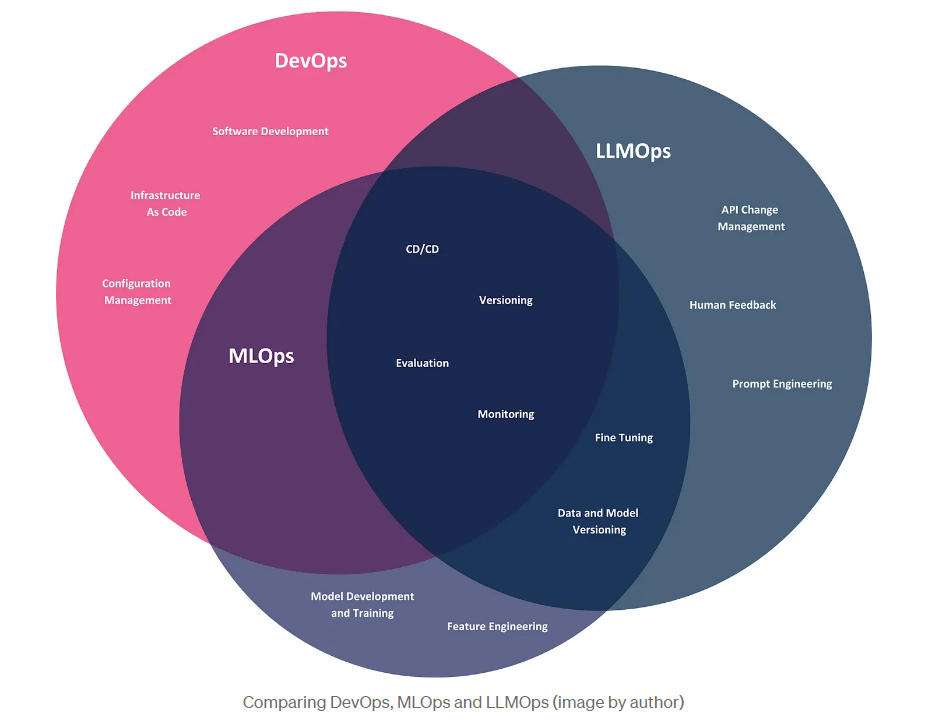

En este artículo, exploramos la aparición de LLMOps, un descendiente de DevOps y MLOps, diseñado específicamente para abordar los retos operativos que plantean los grandes modelos lingüísticos. Concluyamos con una comparación visual de estas tres metodologías, ilustrando su alcance en el contexto de las empresas usuarias de LLM, que aprovechan estos modelos para crear productos y resolver problemas empresariales.

Aunque las tres metodologías comparten prácticas comunes como CI/CD, versionado y evaluación, cada una tiene áreas de interés distintas. DevOps abarca todo el ciclo de vida del desarrollo de software, desde el desarrollo hasta la implantación y el mantenimiento. MLOps amplía DevOps para abordar los retos específicos de los modelos de aprendizaje automático, incluida la automatización de la formación, la implantación y la supervisión de modelos. LLMOps, la última iteración de estas metodologías, se centra específicamente en los LLM. Aunque las empresas usuarias de LLM no necesitan desarrollar sus propios modelos, siguen enfrentándose a retos operativos, como la gestión de los cambios de API y la personalización de los modelos mediante técnicas como la ingeniería rápida y el ajuste fino.

BLOG

BLOG