TL;DR

Dit artikel introduceert LLMOps, een gespecialiseerde tak die DevOps en MLOps samenvoegt om de uitdagingen van Large Language Models (LLM's) aan te gaan. LLM's, zoals OpenAI's GPT, gebruiken uitgebreide tekst data voor taken als tekstgeneratie en taalvertaling. LLMOps pakt problemen als aanpassing, API-veranderingen, data drift, modelevaluatie en monitoring aan met tools als LangSmith, TruLens en W&B Prompts. Het zorgt voor aanpasbaarheid, evaluatie en bewaking van LLM's in echte scenario's en biedt een allesomvattende oplossing voor organisaties die gebruik maken van deze geavanceerde taalmodellen.

Om u door deze discussie te leiden, gaan we eerst in op de basisprincipes van DevOps en MLOps. Daarna richten we ons op LLMOps, te beginnen met een korte introductie van LLM's en het gebruik ervan door organisaties. Vervolgens gaan we in op de belangrijkste operationele uitdagingen van LLM-technologie en hoe LLMOps deze effectief aanpakt.

Basisprincipes voor LLMOps: DevOps en MLOps

DevOps, een afkorting van Development and Operations, is een verzameling praktijken die tot doel hebben het softwareleveringsproces te automatiseren, waardoor het efficiënter, betrouwbaarder en schaalbaarder wordt. De kernprincipes van DevOps zijn onder andere: samenwerking, automatisering, continu testen, bewaking en implementatie-orkestratie.

MLOps, kort voor Machine Learning Operations, is een uitbreiding van DevOps-praktijken die specifiek is afgestemd op het levenscyclusbeheer van modellen voor machinaal leren. Het richt zich op de unieke uitdagingen van de iteratieve en experimentele aard van machine learning-ontwikkeling. Het introduceert extra taken zoals data versiebeheer, experimenteren en modeltraining.

LLMOps: Beheer van de implementatie en het onderhoud van grote taalmodellen

LLMOps, kort voor Large Language Model Operations, is een gespecialiseerde tak van MLOps die speciaal is ontworpen om de unieke uitdagingen en vereisten van het beheren van grote taalmodellen (LLM's) aan te kunnen.

Maar eerst, wat zijn LLM's precies?

LLM's zijn een soort deep learning-modellen die enorme hoeveelheden tekst data gebruiken om miljarden parameters te schatten. Met deze parameters kunnen LLM's tekst van menselijke kwaliteit begrijpen en genereren, talen vertalen, complexe informatie samenvatten en verschillende natuurlijke taalverwerkingstaken uitvoeren.

Hoe organisaties LLM's gebruiken

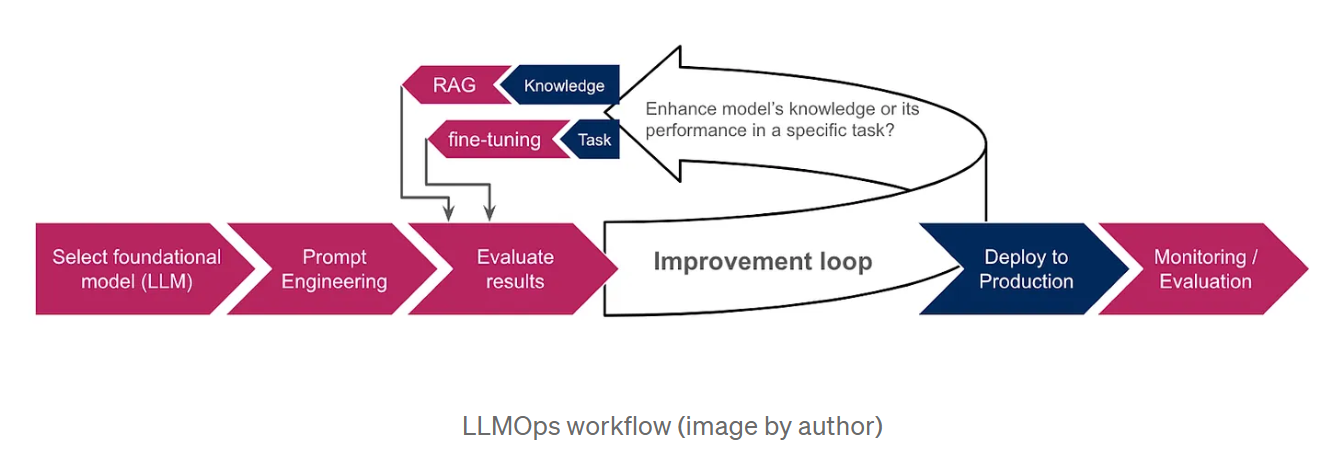

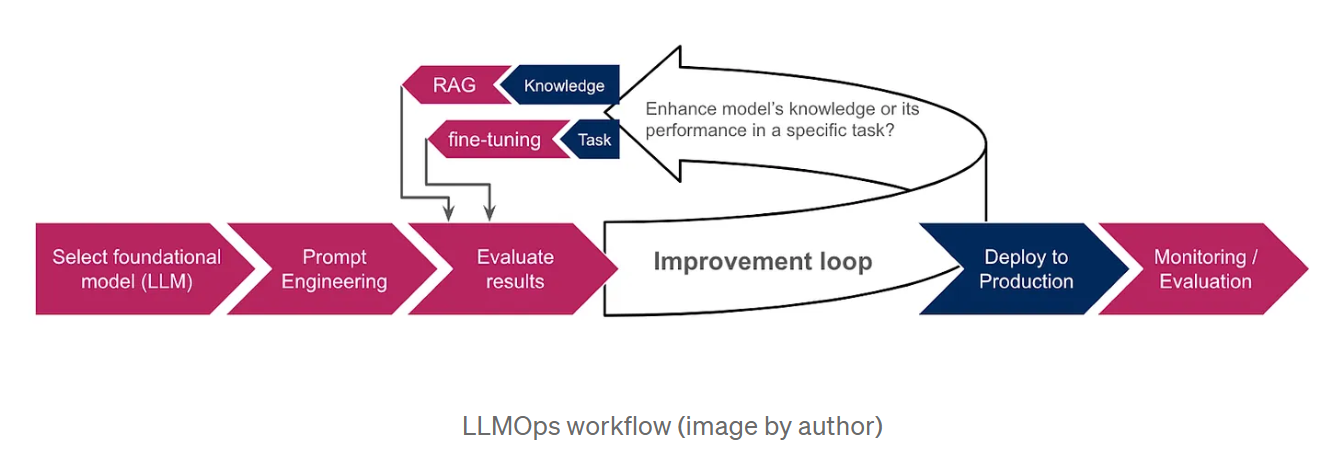

Omdat het trainen van LLM's vanaf nul extreem duur en tijdrovend is, kiezen organisaties voor voorgetrainde basismodellen, zoals OpenAI's GPT of Google AI's LaMDA, als uitgangspunt. Deze modellen, die al getraind zijn op grote hoeveelheden data, beschikken over uitgebreide kennis en kunnen verschillende taken uitvoeren, waaronder het genereren van tekst, het vertalen van talen en het schrijven van verschillende soorten creatieve content. Om de output van de LLM verder aan te passen aan specifieke taken of domeinen, maken organisaties gebruik van technieken zoals prompt engineering, retrieval-augmented generation (RAG) en fine-tuning. Prompt engineering omvat het maken van duidelijke en beknopte instructies die de LLM naar het gewenste resultaat leiden, terwijl RAG het model baseert op aanvullende informatie van externe data bronnen, waardoor de prestaties en relevantie worden verbeterd. Bij fine-tuning worden de parameters van de LLM aangepast met behulp van extra data die specifiek zijn voor de behoeften van de organisatie. Het onderstaande schema geeft een overzicht van de LLMOps workflow en illustreert hoe deze technieken in het algemene proces zijn geïntegreerd.

Waarom we LLMOps nodig hebben

De snelle vooruitgang in LLM-technologie heeft verschillende operationele uitdagingen aan het licht gebracht die een gespecialiseerde aanpak vereisen.

Enkele van deze uitdagingen zijn :

De behoefte aan maatwerk: Hoewel LLM's vooraf worden getraind op enorme hoeveelheden data, is aanpassing essentieel voor optimale prestaties bij specifieke taken. Dit heeft geleid tot de ontwikkeling van nieuwe aanpassingstechnieken, zoals prompt engineering, retrieval-augmented generation(RAG) en fine-tuning. RAG helpt om het model te baseren op de meest nauwkeurige informatie door het te voorzien van een externe kennisbank, terwijl fijnafstemming meer geschikt is als we willen dat het model specifieke taken uitvoert, of zich houdt aan een bepaald antwoordformaat zoals JSON of SQL. De keuze tussen RAG en fine-tuning hangt af van de vraag of we de kennis van het model willen vergroten of zijn prestaties in een specifieke taak willen verbeteren.

API wijzigingen: In tegenstelling tot traditionele ML-modellen zijn LLM's vaak toegankelijk via API's van derden, die kunnen worden gewijzigd of zelfs afgeschaft, waardoor ze voortdurend moeten worden gecontroleerd en aangepast. De documentatie van Open AI vermeldt bijvoorbeeld expliciet dat hun modellen regelmatig worden bijgewerkt, waardoor gebruikers mogelijk hun software moeten bijwerken of moeten migreren naar nieuwere modellen of eindpunten.

Data drift, verwijst naar een verschuiving in de statistische eigenschappen van de invoer data, die vaak optreedt in de productie wanneer de aangetroffen data afwijkt van de data waarop de LLM's werden getraind. Dit kan leiden tot het genereren van onnauwkeurige of verouderde informatie. Bij het GPT-3.5-model was de informatie bijvoorbeeld beperkt tot september 2021 voordat de afsluitdatum werd verlengd tot januari 2022. Daardoor kon het geen vragen beantwoorden over recentere gebeurtenissen, wat leidde tot frustratie bij gebruikers.

Modelevaluatie: Bij traditioneel machinaal leren vertrouwen we op metrieken als acccuracy, precision en recall om onze modellen te beoordelen. Het evalueren van LLM's is echter aanzienlijk ingewikkelder, vooral bij afwezigheid van ground truth data en wanneer we te maken hebben met natuurlijke taaluitvoer in plaats van numerieke waarden.

Bewaking: Continue monitoring van LLM's en op LLM gebaseerde toepassingen is cruciaal. Het is ook gecompliceerder omdat er meerdere aspecten bij komen kijken die overwogen moeten worden om de algehele effectiviteit en betrouwbaarheid van deze taalmodellen te garanderen. We zullen deze aspecten in meer detail bespreken in de volgende paragraaf.

Hoe LLMOps deze uitdagingen aanpakt

LLMOps bouwt voort op het fundament van MLOps en introduceert gespecialiseerde componenten op maat van LLM's :

Prompt engineering en fijnafstemmingsbeheer: LLMOps biedt tools zoals prompt versiecontrolesystemen om verschillende versies van prompts op te sporen en te beheren. Het integreert ook met frameworks voor fine-tuning om het fine-tuning proces te automatiseren en te optimaliseren. Een prominent voorbeeld van deze tools is LangSmith, een framework dat speciaal is ontworpen voor het beheren van LLM workflows. De uitgebreide functies omvatten onmiddellijke versiebeheer, waardoor gecontroleerde experimenten en reproduceerbaarheid mogelijk zijn. Bovendien vergemakkelijkt LangSmith de fijnafstemming van LLM's met behulp van runs'data na eventuele filtering en verrijking om de modelprestaties te verbeteren.

API-veranderingsbeheer: LLMOps stelt processen in voor het monitoren van API-veranderingen, het waarschuwen van operators voor mogelijke verstoringen en het mogelijk maken van rollbacks indien nodig.

Aanpassing van modellen aan veranderende data: LLMOps vergemakkelijkt de aanpassing van LLM's aan veranderende data landschappen, zodat modellen relevant blijven en blijven presteren als data patronen verschuiven. Dit kan worden bereikt door data distributies te monitoren en aanpassingsprocessen in gang te zetten wanneer significante veranderingen worden gedetecteerd. Deze processen kunnen bestaan uit:

-> Herscholing of fijnafstemming: Afhankelijk van de mate van data drift en de beschikbare middelen, kan ofwel hertraining of fijnafstemming worden toegepast om de impact te beperken.

-> Aanpassing aan domein: Fijnafstemming van de LLM op een dataset van het doeldomein.

-> Kennisdistillatie: Een kleiner model trainen door gebruik te maken van de kennis en expertise van een groter, krachtiger, bijgewerkt model.

Specifieke evaluatie voor LLM's: LLMOps gebruikt nieuwe evaluatie-instrumenten die zijn aangepast aan LLM's. Deze omvatten:

-> Tekstgebaseerde metriek, zoals perplexiteit; een statistische maat voor hoe goed het model in staat is om het volgende woord in een reeks te voorspellen. Maar ook BLEU- en ROUGE-metrieken, die machinaal gegenereerde tekst vergelijken met een of meer referentieteksten die door mensen zijn gegenereerd. Ze worden vaak gebruikt voor vertaal- en samenvat taken.

-> Het analyseren van embeddings (vectorrepresentaties voor woorden of zinnen), om het vermogen van het model te beoordelen om contextspecifieke woorden te begrijpen en semantische overeenkomsten vast te leggen. Visualisatie- en clusteringstechnieken kunnen ons ook helpen bij het detecteren van vertekeningen.

-> Evaluator LLM's: Andere LLM's gebruiken om ons model te evalueren. Dit kan bijvoorbeeld worden gedaan door een score toe te kennen aan de uitvoer van het geëvalueerde model op basis van vooraf gedefinieerde metrieken, zoals vloeiendheid, samenhang, relevantie en feitelijke nauwkeurigheid.

-> Integratie van menselijke feedback: LLMOps bevat mechanismen voor het verzamelen en integreren van menselijke feedback in de ML-levenscyclus, waardoor de prestaties van LLM worden verbeterd en vooroordelen worden aangepakt.

TruLens is een hulpmiddel dat integratie van deze evaluaties in LLM-toepassingen mogelijk maakt via een programmatische aanpak die bekend staat als Feedbackfuncties.

LLM-specifieke bewaking: LLMOps integreert voortdurende bewaking om de prestatiegegevens van LLM bij te houden, mogelijke problemen te identificeren en conceptdrift of vertekening te detecteren. Dit omvat:

-> Functionele bewaking; door het aantal verzoeken, responstijd, tokengebruik, foutpercentages en kosten bij te houden.

-> Prompt monitoring; om de leesbaarheid te garanderen en toxiciteit en andere vormen van misbruik te detecteren. W&B Prompts is een set van tools ontworpen voor het monitoren van LLM-gebaseerde applicaties. Het kan worden gebruikt om de invoer en uitvoer van uw LLM's te analyseren, de tussenresultaten te bekijken en uw prompts veilig op te slaan en te beheren.

-> Response monitoring; om de relevantie en consistentie van het model te garanderen. Dit omvat het voorkomen van het genereren van hallucinante of fictieve inhoud en het uitsluiten van schadelijk of ongepast materiaal. Transparantie kan ons helpen om het antwoord van het model beter te begrijpen. Dit kan worden bereikt door antwoordbronnen te onthullen (in RAG) of door het model te vragen zijn redenering te rechtvaardigen (denkketen).

Deze monitoring data kan worden gebruikt om de operationele efficiëntie te verbeteren. We kunnen het kostenbeheer verbeteren door waarschuwingen over tokengebruik te implementeren en strategieën toe te passen zoals het cachen van eerdere antwoorden. Hierdoor kunnen we ze hergebruiken voor soortgelijke queries zonder de LLM opnieuw aan te roepen. Daarnaast kunnen we de latentie minimaliseren door te kiezen voor kleinere modellen wanneer dat haalbaar is en door het aantal gegenereerde tokens te beperken.

Conclusie

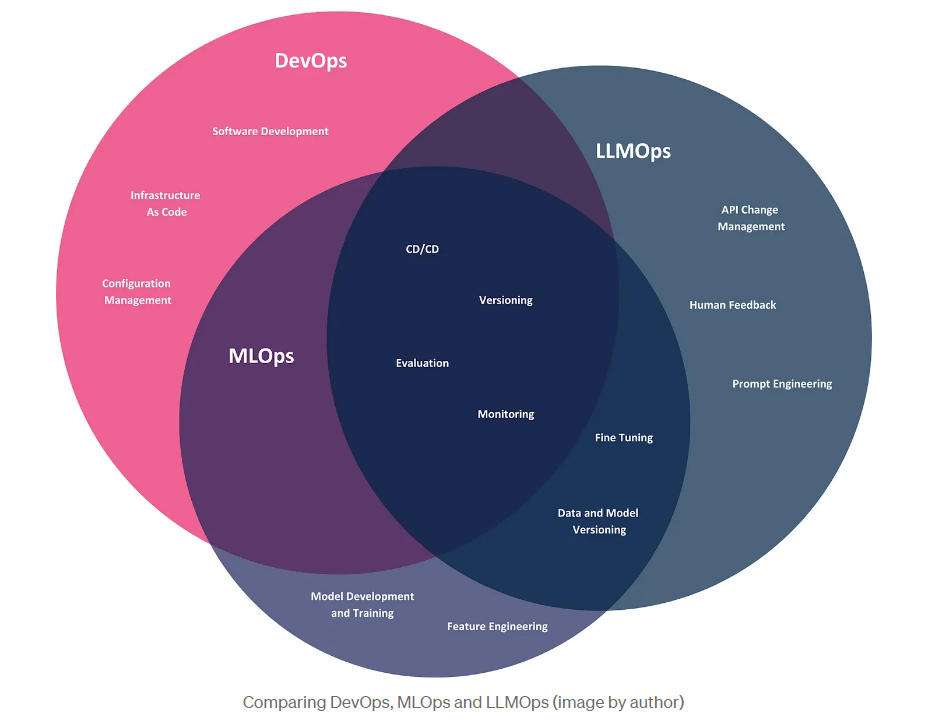

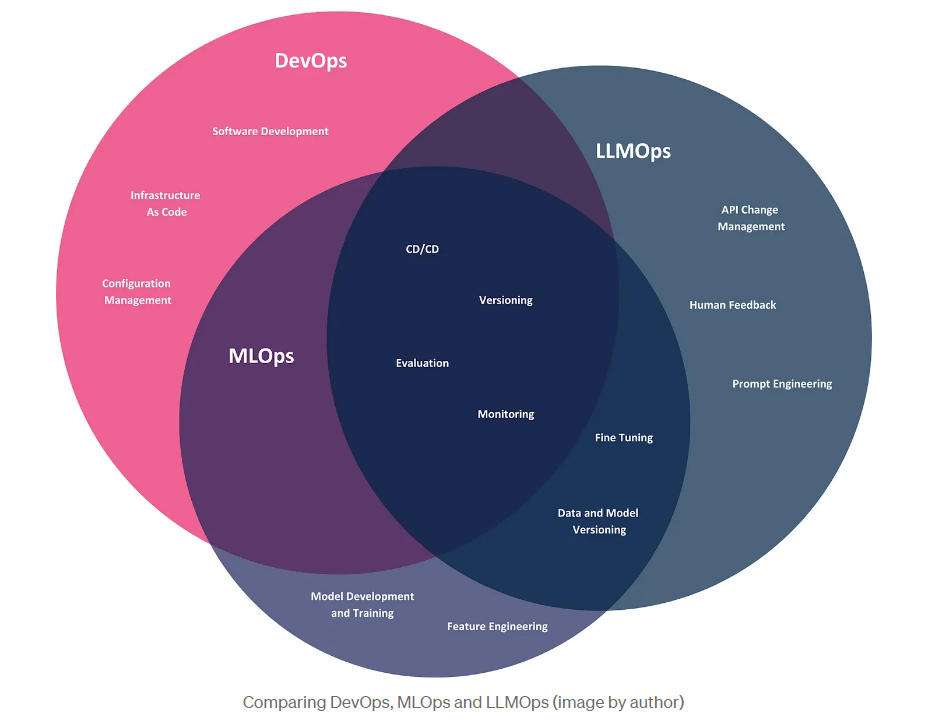

In dit artikel onderzochten we de opkomst van LLMOps, een afstammeling van DevOps en MLOps, specifiek ontworpen om de operationele uitdagingen van grote taalmodellen aan te pakken. Laten we afsluiten met een visuele vergelijking van deze drie methodologieën, waarbij we hun reikwijdte illustreren binnen de context van bedrijven die gebruik maken van LLM, die deze modellen gebruiken om producten te maken en bedrijfsproblemen op te lossen.

Hoewel de drie methodologieën gemeenschappelijke praktijken delen, zoals CI/CD, versiebeheer en evaluatie, hebben ze elk hun eigen aandachtsgebieden. DevOps omvat de volledige levenscyclus van softwareontwikkeling, van ontwikkeling tot implementatie en onderhoud. MLOps breidt DevOps uit om de specifieke uitdagingen van machine learning-modellen aan te pakken, waaronder het automatiseren van modeltraining, implementatie en monitoring. LLMOps, de nieuwste iteratie van deze methodologieën, richt zich specifiek op LLM's. Hoewel LLM-gebruikers hun eigen modellen niet hoeven te ontwikkelen, hebben ze nog steeds te maken met operationele uitdagingen, zoals het beheren van API-wijzigingen en het aanpassen van modellen via technieken zoals prompt engineering en fine-tuning.

BLOG

BLOG