TL;DR

Cet article présente LLMOps, une branche spécialisée fusionnant DevOps et MLOps pour gérer les défis posés par les grands modèles de langage (LLM). Les LLM, comme le GPT d'OpenAI, utilisent un vaste texte data pour des tâches telles que la génération de texte et la traduction linguistique. LLMOps aborde des questions telles que la personnalisation, les changements d'API, data drift, l'évaluation des modèles et la surveillance grâce à des outils tels que LangSmith, TruLens et W&B Prompts. Il garantit l'adaptabilité, l'évaluation et le contrôle des LLM dans des scénarios réels, offrant ainsi une solution complète aux organisations qui exploitent ces modèles linguistiques avancés.

Pour vous guider dans cette discussion, nous commencerons par revoir les principes fondamentaux de DevOps et MLOps, puis nous nous concentrerons sur LLMOps, en commençant par une brève introduction aux LLM et à leur utilisation par les organisations. Ensuite, nous nous pencherons sur les principaux défis opérationnels posés par la technologie LLM et sur la manière dont le LLMOps les aborde efficacement.

Principes fondamentaux pour LLMOps : DevOps et MLOps

DevOps, abréviation de Development and Operations, est un ensemble de pratiques visant à automatiser le processus de livraison de logiciels, le rendant plus efficace, plus fiable et plus évolutif. Les principes fondamentaux de DevOps comprennent : la collaboration, l'automatisation, les tests continus, la surveillance et l'orchestration du déploiement.

MLOps, abréviation de Machine Learning Operations, est une extension des pratiques DevOps spécifiquement adaptée à la gestion du cycle de vie des modèles d'apprentissage automatique. Elle répond aux défis uniques posés par la nature itérative et expérimentale du développement de l'apprentissage automatique. L'introduction de tâches supplémentaires telles que data versioning et la gestion, ainsi que l'expérimentation et la formation des modèles.

LLMOps : Gestion du déploiement et de la maintenance de grands modèles linguistiques

LLMOps, abréviation de Large Language Model Operations, est une branche spécialisée de MLOps spécialement conçue pour relever les défis et répondre aux exigences uniques de la gestion de grands modèles linguistiques (LLM).

Mais tout d'abord, qu'est-ce qu'un LLM exactement ?

Les LLM sont un type de modèle d'apprentissage profond qui utilise des quantités massives de texte data pour estimer des milliards de paramètres. Ces paramètres permettent aux LLM de comprendre et de générer des textes de qualité humaine, de traduire des langues, de résumer des informations complexes et d'effectuer diverses tâches de traitement du langage naturel.

Comment les organisations utilisent-elles les masters en droit ?

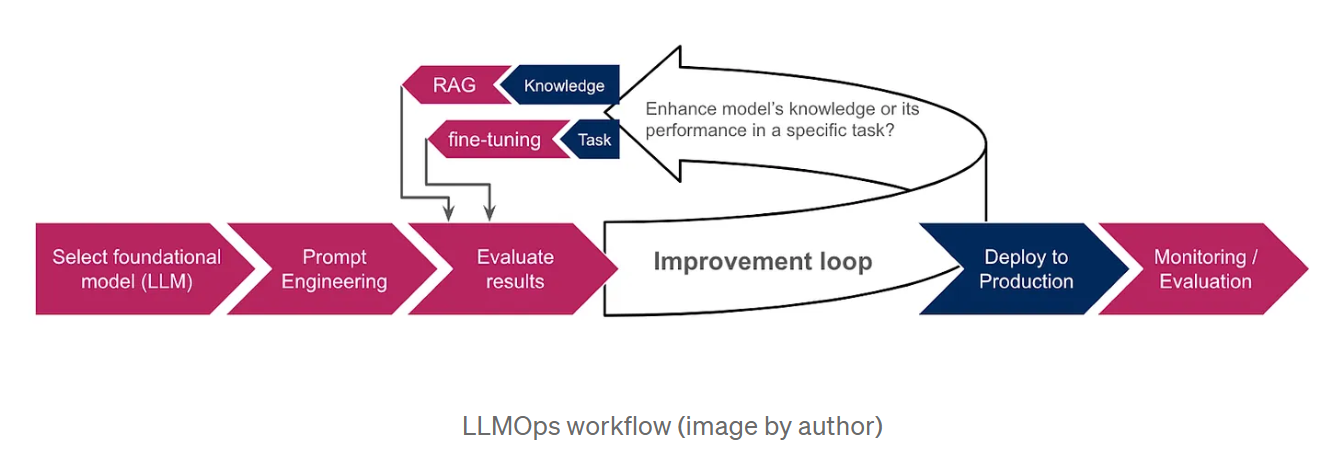

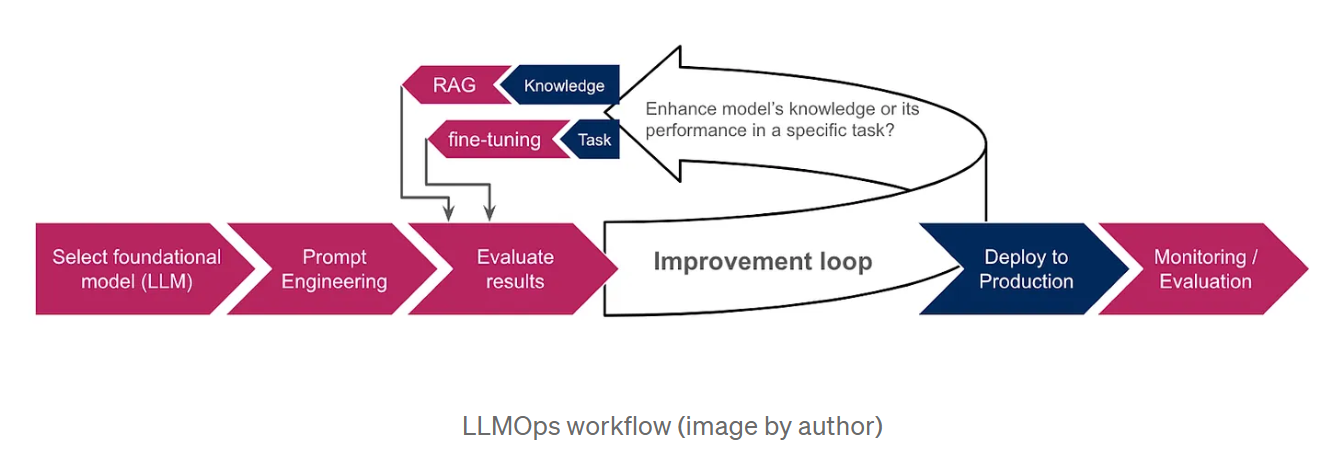

La formation de LLM à partir de zéro étant extrêmement coûteuse et chronophage, les organisations optent pour des modèles de base pré-entraînés, tels que GPT d'OpenAI ou LaMDA de Google AI, comme point de départ. Ces modèles, qui ont déjà été formés sur de grandes quantités de données data, possèdent des connaissances étendues et peuvent effectuer diverses tâches, notamment la génération de texte, la traduction de langues et la rédaction de différents types de contenu créatif. Pour personnaliser davantage les résultats du LLM en fonction de tâches ou de domaines spécifiques, les organisations utilisent des techniques telles que l'ingénierie des messages, la génération augmentée par la recherche (RAG) et le réglage fin. L'ingénierie des messages implique la création d'instructions claires et concises qui guident le LLM vers le résultat souhaité, tandis que la RAG fonde le modèle sur des informations supplémentaires provenant de sources externes ( data ), améliorant ainsi ses performances et sa pertinence. Le réglage fin, quant à lui, consiste à ajuster les paramètres du LLM à l'aide de data supplémentaires spécifiques aux besoins de l'organisation. Le schéma ci-dessous donne un aperçu du flux de travail des LLMOps, illustrant la manière dont ces techniques s'intègrent dans le processus global.

Pourquoi nous avons besoin des LLMOps

Les progrès rapides de la technologie LLM ont mis en lumière plusieurs défis opérationnels qui nécessitent des approches spécialisées.

Parmi ces défis, on peut citer :

Le besoin de personnalisation: Alors que les LLM sont pré-entraînés sur des quantités massives de data, la personnalisation est essentielle pour obtenir des performances optimales dans des tâches spécifiques. Cela a conduit au développement de nouvelles techniques de personnalisation, telles que l'ingénierie des requêtes, la génération augmentée par la recherche(RAG) et le réglage fin. La RAG aide le modèle à s'appuyer sur les informations les plus précises en lui fournissant une base de connaissances externe, tandis que le réglage fin convient mieux lorsque nous voulons que le modèle exécute des tâches spécifiques ou respecte un format de réponse particulier tel que JSON ou SQL. Le choix entre le RAG et le réglage fin dépend de la question de savoir si nous voulons améliorer les connaissances du modèle ou ses performances dans le cadre d'une tâche spécifique.

Changements d'API: Contrairement aux modèles ML traditionnels, les LLM sont souvent accessibles via des API tierces, qui peuvent être modifiées ou même supprimées, ce qui nécessite une surveillance et une adaptation continues. Par exemple, la documentation d'Open AI mentionne explicitement que ses modèles font l'objet de mises à jour régulières, ce qui peut obliger les utilisateurs à mettre à jour leur logiciel ou à migrer vers des modèles ou des points de terminaison plus récents.

Data Ladérive fait référence à un changement dans les propriétés statistiques de l'entrée data, qui se produit fréquemment en production lorsque le site data rencontré s'écarte du site data sur lequel les LLM ont été formés. Cela peut conduire à la génération d'informations inexactes ou obsolètes. Par exemple, avec le modèle GPT-3.5, ses informations étaient limitées jusqu'en septembre 2021 avant que la date limite ne soit repoussée à janvier 2022. Par conséquent, il ne pouvait pas répondre aux questions concernant des événements plus récents, ce qui a provoqué la frustration des utilisateurs.

L'évaluation des modèles: Dans l'apprentissage automatique traditionnel, nous nous appuyons sur des mesures telles que l'exactitude, la précision et le rappel pour évaluer nos modèles. Cependant, l'évaluation des LLM est beaucoup plus complexe, en particulier en l'absence de vérité de terrain data et lorsqu'il s'agit de résultats en langage naturel plutôt que de valeurs numériques.

Contrôle: Le contrôle continu des LLM et des applications basées sur les LLM est crucial. Il est également plus compliqué car il implique de multiples aspects qui doivent être pris en compte pour garantir l'efficacité et la fiabilité globales de ces modèles de langage. Nous discuterons de ces aspects plus en détail dans la section suivante.

Comment les LLMOps relèvent ces défis

LLMOps s'appuie sur les fondements de MLOps tout en introduisant des éléments spécialisés adaptés aux LLM :

Ingénierie des invites et gestion des ajustements: LLMOps fournit des outils tels que des systèmes de contrôle des versions d' invites pour suivre et gérer les différentes versions des invites. Il s'intègre également à des cadres de mise au point afin d'automatiser et d'optimiser le processus de mise au point. Un exemple frappant de ces outils est LangSmith, un cadre spécialement conçu pour gérer les flux de travail LLM. Ses caractéristiques complètes comprennent le versionnage rapide, permettant une expérimentation contrôlée et la reproductibilité. En outre, LangSmith facilite le réglage fin des LLM en utilisant le sitedata après un filtrage et un enrichissement éventuels pour améliorer la performance du modèle.

Gestion des modifications de l'API: Les LLMOps mettent en place des processus pour surveiller les modifications de l'API, alerter les opérateurs en cas de perturbations potentielles et permettre des retours en arrière si nécessaire.

Adaptation du modèle à l'évolution de data: LLMOps facilite l'adaptation des LLM à l'évolution des paysages data , en veillant à ce que les modèles restent pertinents et performants à mesure que les modèles data changent. Ceci pourrait être réalisé en surveillant data les distributions et en déclenchant des processus d'adaptation lorsque des changements significatifs sont détectés. Ces processus peuvent comprendre

-> le recyclage ou le réglage fin: En fonction de l'ampleur de la dérive de data et des ressources disponibles, il est possible de recourir à un recyclage ou à un réglage fin pour en atténuer l'impact.

-> Adaptation au domaine: Ajustement fin du LLM sur un ensemble de données du domaine cible.

-> Distillation des connaissances: Formation d'un modèle plus petit en tirant parti des connaissances et de l'expertise d'un modèle plus grand, plus puissant et plus récent.

Évaluation spécifique à l'EFTLV: LLMOps utilise de nouveaux outils d'évaluation adaptés aux LLM. Ceux-ci incluent :

-> Des mesures basées sur le texte, telles que la perplexité, une mesure statistique de la capacité du modèle à prédire le mot suivant dans une séquence. Ainsi que les mesures BLEU et ROUGE, qui comparent un texte généré par une machine à un ou plusieurs textes de référence générés par des humains. Elles sont couramment utilisées pour les tâches de traduction et de résumé.

-> L'analyse des embeddings (représentations vectorielles des mots ou des phrases), pour évaluer la capacité du modèle à comprendre les mots spécifiques au contexte et à capturer les similarités sémantiques. Les techniques de visualisation et de regroupement peuvent également nous aider à détecter les biais.

-> LLM d'évaluation: Utilisation d'autres LLM pour évaluer notre modèle. Par exemple, cela peut se faire en attribuant un score à la sortie du modèle évalué sur la base de métriques prédéfinies, telles que la fluidité, la cohérence, la pertinence et l'exactitude factuelle.

-> Intégration du retour d'information humain: LLMOps incorpore des mécanismes de collecte et d'incorporation du feedback humain dans le cycle de vie de la ML, améliorant ainsi les performances de la LLM et traitant les biais.

TruLens est un outil qui permet l'intégration de ces évaluations dans les applications LLM par le biais d'une approche programmatique connue sous le nom de fonctions de rétroaction.

Suivi spécifique au LLM: Les LLMOps intègrent un contrôle continu pour suivre les mesures de performance des LLM, identifier les problèmes potentiels et détecter les dérives ou les distorsions du concept. Ceci inclut :

-> Surveillance fonctionnelle; en suivant le nombre de demandes, le temps de réponse, l'utilisation des jetons, les taux d'erreur et les coûts.

-> Le contrôle des messages-guides, afin de garantir la lisibilité et de détecter la toxicité et d'autres formes d'abus. W&B Prompts est un ensemble d'outils conçus pour surveiller les applications basées sur le LLM. Il peut être utilisé pour analyser les entrées et les sorties de vos LLM, visualiser les résultats intermédiaires et stocker et gérer vos invites en toute sécurité.

-> Surveillance des réponses: garantir la pertinence et la cohérence du modèle. Il s'agit notamment d'empêcher la génération de contenus hallucinatoires ou fictifs, ainsi que d'assurer l'exclusion de contenus nuisibles ou inappropriés. La transparence peut nous aider à mieux comprendre la réponse du modèle. Elle peut être établie en révélant les sources de réponse (dans RAG) ou en invitant le modèle à justifier son raisonnement (chaîne de pensée).

Cette surveillance data peut être utilisée pour améliorer l'efficacité opérationnelle. Nous pouvons améliorer la gestion des coûts en mettant en œuvre des alertes sur l'utilisation des jetons et en employant des stratégies telles que la mise en cache des réponses précédentes. Cela nous permet de les réutiliser pour des requêtes similaires sans invoquer à nouveau le LLM. En outre, nous pouvons minimiser la latence en optant pour des modèles plus petits lorsque cela est possible et en limitant le nombre de jetons générés.

Conclusion

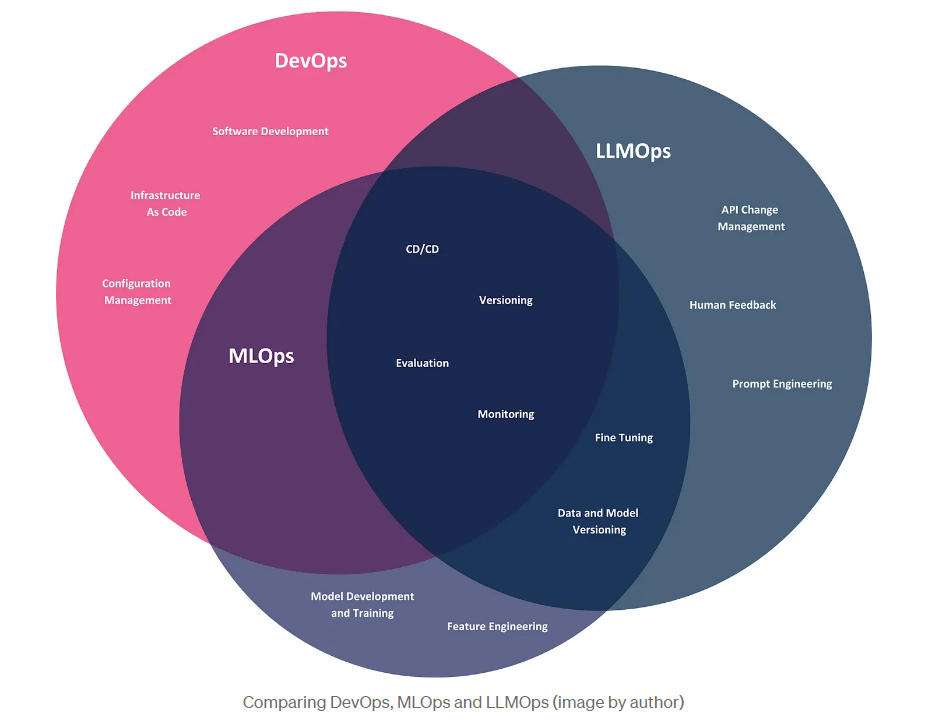

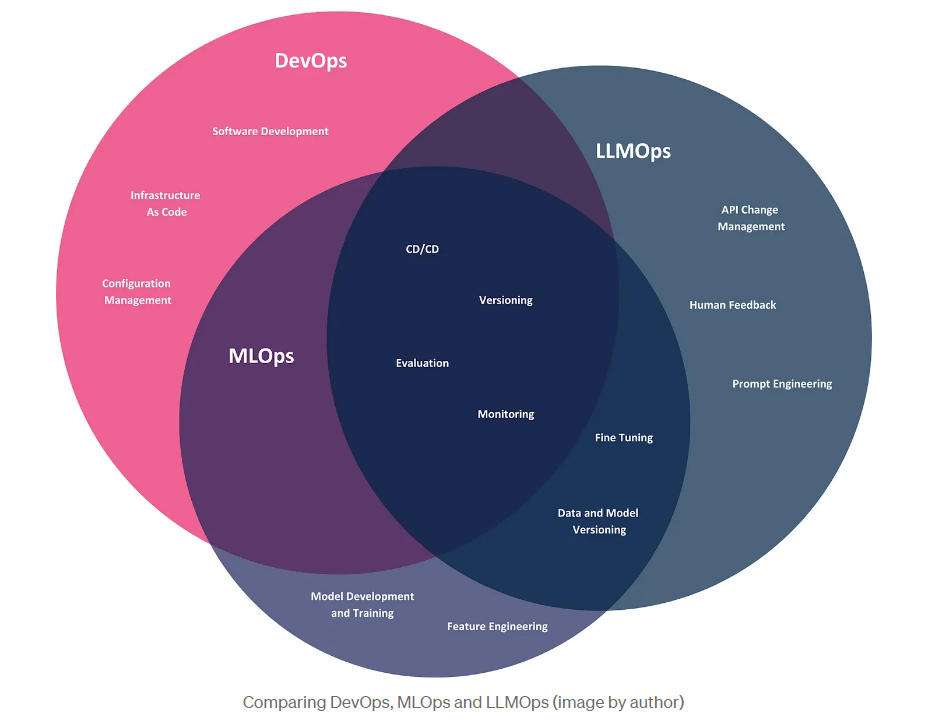

Dans cet article, nous avons exploré l'émergence de LLMOps, un descendant de DevOps et MLOps, spécifiquement conçu pour répondre aux défis opérationnels posés par les grands modèles de langage. Terminons par une comparaison visuelle de ces trois méthodologies, illustrant leur portée dans le contexte des entreprises utilisatrices de LLM, qui tirent parti de ces modèles pour créer des produits et résoudre des problèmes commerciaux.

Bien que ces trois méthodologies partagent des pratiques communes telles que CI/CD, le versionnage et l'évaluation, elles ont chacune des domaines d'intérêt distincts. DevOps couvre l'ensemble du cycle de développement des logiciels, du développement au déploiement et à la maintenance. MLOps étend DevOps pour répondre aux défis spécifiques des modèles d'apprentissage automatique, y compris l'automatisation de la formation, du déploiement et de la surveillance des modèles. LLMOps, la dernière itération de ces méthodologies, se concentre spécifiquement sur les LLM. Même si les entreprises utilisatrices de LLM n'ont pas besoin de développer leurs propres modèles, elles sont toujours confrontées à des défis opérationnels, notamment la gestion des changements d'API et la personnalisation des modèles grâce à des techniques telles que l'ingénierie prompte et le réglage fin.

BLOG

BLOG