Dieser Artikel wurde von Artefact Experten in Zusammenarbeit mit der French Tech Corporate Community für den Medium Blog geschrieben.

Die Fülle und Vielfalt der Reaktionen auf ChatGPT und andere generative KI, ob skeptisch oder enthusiastisch, zeigen die Veränderungen, die sie mit sich bringen, und die Auswirkungen, die sie weit über die üblichen Technologiekreise hinaus haben. Dies steht in krassem Gegensatz zu früheren Generationen von AI, die im Wesentlichen prädiktiv waren und im Allgemeinen Gegenstand von Artikeln oder Thesen waren, die auf den Bereich der Forschung und Innovation beschränkt waren.

Für Unternehmen unterscheidet sich die generative AI auch von früheren künstlichen Intelligenzen. Vergleicht man sie mit den ähnlichsten Technologien wie der Verarbeitung natürlicher Sprache (NLP) für Textkorpora oder der Computer Vision für audiovisuelle Medien data, so bringen generative KI vier wesentliche Veränderungen mit sich, die den Unternehmen bewusst werden, während sie mit ihnen experimentieren.

Erstens beschleunigt die generative AI im Vergleich zu früheren AI die Einführung von Anwendungsfällen in dem Sinne, dass sie den Konzeptnachweis beschleunigt. Zweitens eröffnen sie neue Möglichkeiten, indem sie eine einfachere, effizientere und weniger kostspielige Anreicherung von unstrukturierten data ermöglichen. Darüber hinaus sind die mit generativen AI erzielten Ergebnisse in Bezug auf Qualität, Quantität und Vielfalt neuartig im Vergleich zu den bisher verwendeten Modellen. All diese Faktoren bedeuten, dass wir uns mit den gestiegenen Erwartungen der Endnutzer auseinandersetzen müssen, die durch den Hype um diese Technologie angeheizt wurden. Auf diese vier Punkte gehen wir im Folgenden ein.

Generative AI ermöglicht schnellere Tests des Mehrwerts von Anwendungsfällen

Im Bereich der generativen AI ist die Entwicklung von Anwendungsfällen oft schneller und weniger arbeitsintensiv als bei bisherigen KI. Der Ansatz der generativen AI wird häufig mit dem Zusammenbau von Legosteinen verglichen, bei dem bereits vorhandene Komponenten kombiniert werden können, um neue Ergebnisse zu erzielen. Diese Leichtigkeit des Experimentierens und der Implementierung kann kürzere Entwicklungszyklen ermöglichen. Darüber hinaus beschleunigt eine dialogische Interaktion mit den Nutzern die Akzeptanz.

Ein data Anwendungsfall kann auf ein Geschäftsproblem, data, ein Modell und eine Aufforderung reduziert werden. Traditionell ist die Erstellung und Optimierung des Modells der komplexeste und zeitaufwändigste Teil des Prozesses. Mit generativen AI wird dieser Schritt einfacher. Generative AI bietet vorgefertigte, gebrauchsfertige Modelle, die es Unternehmen ermöglichen, von fortgeschrittenem Fachwissen zu profitieren, ohne viel Zeit in die Entwicklung und Verfeinerung von Modellen zu investieren. In der Praxis sind Modelle (wie GPT 4.0 von Azure) "on-demand" verfügbar oder können über APIs bereitgestellt werden (wie Gemini Pro BARD von Google). Einige Anbieter bieten sogar speziell abgestimmte Modelle für bestimmte Bereiche an, z. B. für die Erstellung juristischer, medizinischer oder finanzieller Texte.

Sobald das Modell eingesetzt wird, besteht die einzige verbleibende Aufgabe darin, das generative Modell AI zu "erden", d. h. die vom Modell erzeugten Ergebnisse mit Informationen aus der realen Welt zu verknüpfen, um das Modell zu zwingen, innerhalb eines bestimmten Rahmens zu reagieren. Dies beinhaltet oft das Hinzufügen von Einschränkungen oder zusätzlichen Informationen, um das Modell zu Ergebnissen zu führen, die in einem bestimmten Kontext kohärent und relevant sind. Dies ist jedoch weit entfernt von der Zeit, die für das Training der AI Modelle benötigt wird, die wir bis jetzt verwendet haben.

Nehmen wir zur Veranschaulichung das Beispiel eines Anwendungsfalls für die Analyse des Wortlauts im Call Center. Laut einer Studie von Artefact dauerte die Entwicklung eines solchen Anwendungsfalls unter Verwendung von Modellen, die auf früheren AI basierten, in der Regel drei bis vier Wochen ab dem Zeitpunkt, an dem die data abgerufen und nutzbar gemacht wurde. Heute, dank der generativen AI, dauert dieser Prozess nur noch eine Woche, was einen Beschleunigungsfaktor von mehr als drei bedeutet. Die größte Herausforderung besteht darin, die geeignete Geschäftsklassifizierung für die Anpassung des Modells zu wählen.

Generative AI erweitert den Geltungsbereich von AI auf bisher wenig oder falsch genutzte data

Einige Ölfelder sind nur rentabel, wenn die Ölpreise in die Höhe schnellen. Das gleiche Prinzip lässt sich auf data anwenden. Bestimmte unstrukturierte data können nun dank generativer AI ausgewertet werden, wodurch sich ein völlig neues Feld von nutzbaren data für das Training oder die Feinabstimmung von Modellen eröffnet und zahlreiche Perspektiven für Anwendungen bietet, die auf bestimmte Bereiche spezialisiert sind.

Und es gibt ein neues Versprechen: das der generativen KI, die in der Lage ist, jede Art von data in ihren Trainingsprozessen zu verarbeiten und zu kombinieren und dabei die zeitraubende und mühsame Arbeit der Strukturierung und Verbesserung der Qualität von data zu umgehen, um sie nutzbar zu machen. Ein Versprechen, das nach den derzeitigen Beobachtungen noch nicht erfüllt ist.

Das generative AI hat nicht nur von einem echten Durchbruch bei den Aufmerksamkeitsmechanismen profitiert. Es hat auch von der ständig wachsenden - und notwendigen - Leistung von Maschinen profitiert.

Aufmerksamkeitsmechanismen funktionieren ähnlich wie die Fähigkeit des Menschen, sich auf einen wichtigen Teil eines Bildes oder Textes zu konzentrieren, wenn er versucht, etwas zu verstehen oder zu gestalten. Stellen Sie sich vor, Sie versuchen, eine Landschaft von einem Foto zu zeichnen. Anstatt das ganze Bild auf einmal zu betrachten, konzentrieren Sie sich auf bestimmte Teile, die Ihnen wichtig erscheinen, wie z. B. Berge oder Bäume. So können Sie wichtige Details besser erkennen und eine genauere Zeichnung anfertigen. In ähnlicher Weise ermöglichen Aufmerksamkeitsmechanismen dem Modell, sich bei der Erstellung von Inhalten auf bestimmte Teile eines Bildes oder Textes zu konzentrieren. Anstatt die gesamte Eingabe auf einmal zu verarbeiten, kann sich das Modell auf die relevantesten und wichtigsten Teile konzentrieren, um genauere und aussagekräftigere Ergebnisse zu erzielen. So kann es lernen, Bilder, Texte oder andere Arten von Inhalten effizienter und realistischer zu erstellen.

Aufmerksamkeitsmechanismen lassen sich sehr gut parallelisieren. Die Verwendung mehrerer Aufmerksamkeitsmechanismen bietet eine reichhaltigere und robustere Darstellung von data und führt zu einer verbesserten Leistung bei verschiedenen Aufgaben wie maschineller Übersetzung, Texterzeugung, Sprachsynthese, Bilderzeugung und vielen anderen.

Infolgedessen sind Anwendungsfälle, die vor nicht allzu langer Zeit noch unmöglich schienen, nun vollständig zugänglich geworden. Dies gilt beispielsweise für die Berechnung der Redezeit in den Medien während der Präsidentschaftswahlen. Noch vor zwei Jahren war die genaue Berechnung der Redezeit der einzelnen Kandidaten ein mühsames Unterfangen. Heute ist dies dank des Einsatzes von generativen Verfahren AI möglich.

Was die Rechenkapazitäten betrifft, so hat OpenAI vor sechs Jahren eine Analyse veröffentlicht, aus der hervorgeht, dass der Rechenaufwand für die wichtigsten Trainingssitzungen von AI seit 2012 exponentiell gestiegen ist, mit einer Verdopplungszeit von 3,4 Monaten (zum Vergleich: Moore's Law hatte eine Verdopplungszeit von zwei Jahren). Seit 2012 hat sich dieses Maß um mehr als das 300.000-fache erhöht (eine Verdopplungszeit von zwei Jahren würde nur eine Versiebenfachung bedeuten).

Generative AI Modelle benötigen oft enorme Mengen an Rechenleistung für das Training, insbesondere da die Modelle so konzipiert sind, dass sie generalistisch sind und große Mengen an Inhalten für das Training benötigen. Für die Verarbeitung großer Datensätze und die Ausführung komplexer Optimierungsalgorithmen werden leistungsstarke Rechenressourcen wie High-End-GPUs oder TPUs benötigt. Die neue NVIDIA A100 Tensor Core GPU scheint eine noch nie dagewesene Beschleunigung zu bieten. Laut Nvidia bietet der A100 eine bis zu 20 Mal höhere Leistung als die vorherige Generation und kann in sieben GPU-Instanzen partitioniert werden, um sich dynamisch an wechselnde Anforderungen anzupassen. Berichten zufolge verfügt sie außerdem über die weltweit schnellste Speicherbandbreite mit über zwei Terabyte pro Sekunde (TB/s) für die Ausführung der größten Modelle und Datensätze.

Es sei darauf hingewiesen, dass Verbesserungen in der Datenverarbeitung ein Schlüsselelement des Fortschritts von artificial intelligence waren. Solange dieser Trend anhält, sollten wir auf die Auswirkungen von Systemen vorbereitet sein, die die heutigen Möglichkeiten bei weitem übertreffen und die Grenzen weiter verschieben werden, während wir den Wert dieser Systeme gegen die Kosten abwägen, die sie verursachen, insbesondere in Bezug auf Energie und Umwelt. Wir werden diese Punkte in einem späteren Artikel erörtern.

Generative AI verbessert die Vielfalt, Qualität und Quantität der erzielten Ergebnisse

Die generative Methode AI unterscheidet sich von der früheren Methode AI eindeutig durch ihre Auswirkungen auf die von den Modellen generierten Ergebnisse. Nicht nur die Quantität der erzeugten Ergebnisse ist gestiegen, sondern auch ihre Qualität und Vielfalt. All diese positiven Aspekte müssen jedoch durch eine geringere Reproduzierbarkeit der generativen AI Modelle aufgewogen werden.

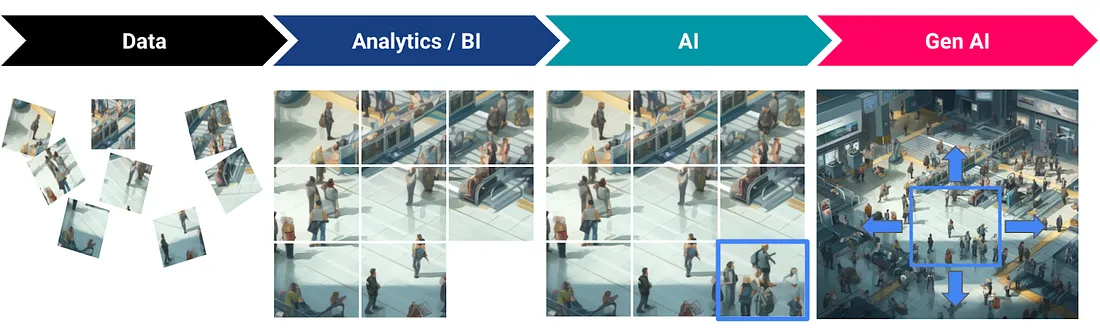

Betrachtet man das Bild eines Puzzles, so kann die Analyse von data mit dem Zusammenbau verglichen werden, bei dem jedes Teil von data ein Teil darstellt, das angeordnet werden muss, um ein kohärentes Bild zu ergeben. AI spielt eine entscheidende Rolle bei dem Versuch, die fehlenden data zu ergänzen, indem die verfügbaren Informationen genutzt werden, um diese fehlenden Teile abzuleiten und neu zu erstellen. Die generative AI geht über die bloße Vervollständigung von data hinaus, indem sie neue data erstellt, die von bereits Vorhandenem inspiriert sind. Dieser Prozess erweitert die Analysemöglichkeiten und ermöglicht es, neue Informationen aus den vorhandenen data zu entdecken, wodurch der generative Aspekt in den Vordergrund rückt.

Im Gegensatz zu früheren Generationen von AI, die dazu neigen, oft ähnliche Ergebnisse zu liefern, sind generative AI Modelle in der Lage, eine größere Vielfalt an Ergebnissen zu erzeugen, indem sie verschiedene Varianten und Alternativen untersuchen. Diese größere Vielfalt macht es möglich, reichhaltigere und vielfältigere Inhalte zu generieren, die vom quantitativen zum qualitativen Bereich übergehen und ein breiteres Spektrum an Bedürfnissen und Präferenzen abdecken.

OpenAI war kürzlich in Hollywood, um sein neuestes Modell namens "Sora" vorzustellen, das in der Lage ist, Videos aus Text zu generieren. "Zu hören, dass es all diese Dinge kann, ist eine Sache, aber die Fähigkeiten tatsächlich zu sehen, war erstaunlich", sagte Hollywood-Produzent Mike Perry und hob die Vielfalt und Qualität der Fähigkeiten hervor, die generative Systeme bieten AI.

Aufgrund ihrer Fähigkeit, einen größeren Raum von Möglichkeiten zu erkunden, können generative AI Modelle jedoch weniger reproduzierbar sein als frühere KI, und die Genauigkeit der Ergebnisse wird beeinträchtigt. Konkret bedeutet dies, dass es schwieriger ist, bei jedem Durchlauf des Modells genau die gleichen Ergebnisse zu erzielen, was bei bestimmten unternehmenskritischen Anwendungen zu Problemen hinsichtlich der Zuverlässigkeit und Vorhersagbarkeit führen kann.

Diese Einschränkung stellt eine große Herausforderung für Anwendungen von generativen AI dar, die präzise Antworten erfordern. Und es ist ein Bereich, an dem die Unternehmen in ihren aktuellen Entwicklungen arbeiten: die Modelle besser auf hochspezifische Bereiche zu spezialisieren, um die Genauigkeit der Antworten zu verbessern, und die Robustheit von regelbasierten Modellen oder Abfragen auf strukturierten data mit der Benutzerfreundlichkeit und Interaktion mit den Nutzern generativer KI zu kombinieren, indem letztere mit den Ergebnissen der ersteren verbunden werden.

Gestiegene Erwartungen der Endnutzer

Wenn es darum geht, die Erwartungen und die Beziehung der Endnutzer zur Technologie zu steuern, stellt die generative Methode AI eine Reihe spezifischer Herausforderungen dar. Aufgrund ihrer Fähigkeit, schnell Ergebnisse zu erzielen, kann die generative AI besonders hohe Erwartungen wecken. Umgekehrt kann das Auftreten von Halluzinationen und unerwünschten Ergebnissen das Vertrauen der Nutzer in diese Lösungen stark beeinträchtigen.

Generative AI ist in der Lage, schnell und automatisiert Ergebnisse zu liefern, was bei den Endnutzern den Eindruck erwecken kann, dass die Technologie in der Lage ist, alle ihre Probleme sofort und effizient zu lösen. Dies kann zu unverhältnismäßigen Erwartungen an die tatsächlichen Fähigkeiten von generativen AI führen und zu Enttäuschungen, wenn die Ergebnisse diese hohen Erwartungen nicht vollständig erfüllen.

Generative AI ist natürlich nicht perfekt und kann manchmal unerwartete oder unerwünschte Ergebnisse liefern, wie z. B. inkonsistente, falsche oder unangemessene Inhalte. Das Auftreten solcher unerwünschten Ergebnisse kann dazu führen, dass der Endnutzer das Vertrauen in die Technologie verliert und ihre Zuverlässigkeit und Nützlichkeit in Frage stellt. Es kann auch Bedenken hinsichtlich der Sicherheit und des Datenschutzes von data aufkommen lassen, wenn unerwartete Ergebnisse die Integrität der durch generative AI erzeugten Informationen gefährden.

Im Februar 2023 gab der Google-Chatbot Bard (umbenannt in Gemini) auf die Frage nach den Entdeckungen des James-Webb-Weltraumteleskops der NASA falsche Informationen. Er behauptete fälschlicherweise, das Teleskop habe die ersten Fotos eines Exoplaneten aufgenommen. Diese Aussage ist falsch, da die ersten Fotos eines Exoplaneten aus dem Jahr 2004 stammen, während das James-Webb-Teleskop erst im Jahr 2021 gestartet wurde (Quelle: CNET France Team, 2024).

Es ist daher von entscheidender Bedeutung, dass sich die Endnutzer generativer Systeme AI ihrer Grenzen bewusst sind. Daher bemühen sich die meisten Unternehmen, die diese Lösungen einsetzen, die Nutzer bei der Nutzung zu unterstützen: Schulung in der Kunst des Promptens, Erläuterung der Grenzen dieser Systeme, Klärung der Frage, welche Erwartungen erfüllt werden können und welche nicht, und Erinnerung an die geltenden Regeln in Bezug auf den Schutz data .

Mehr als ein Jahr nach der Veröffentlichung von ChatGPT sind die Erwartungen an diese neue Technologie so hoch wie eh und je. Der mit ihr verbundene Wert muss sich jedoch erst noch in konkreten Anwendungsfällen materialisieren. In unserem nächsten Artikel werden wir Themen im Zusammenhang mit der Einführung der Technologie in Unternehmen und deren Verbreitung im gesamten Unternehmen erörtern.

Unter der Leitung von:

BLOG

BLOG