Artefact Research Center

Überbrückung der Kluft zwischen akademischen und industriellen Anwendungen.

Forschung zu transparenteren und ethischeren Modellen, um die Einführung von AI zu fördern.

Beispiele für AI Vorurteile

- AppleCard vergibt Hypotheken auf der Grundlage rassistischer Kriterien

- Lensa AI sexualisiert Selfies von Frauen

- Rassistische Facebook-Bildklassifizierung mit afro-amerikanischen Affen

- Microsoft Twitter Chatbot wird nazistisch, sexistisch und aggressiv

- ChatGPT, der einen Code schreibt, der besagt, dass gute Wissenschaftler weiße Männer sind

Aktuelle Herausforderung

AI Modelle sind in vielen Anwendungsfällen genau und einfach zu implementieren, bleiben aber aufgrund von Black Boxes und ethischen Fragen unkontrollierbar.

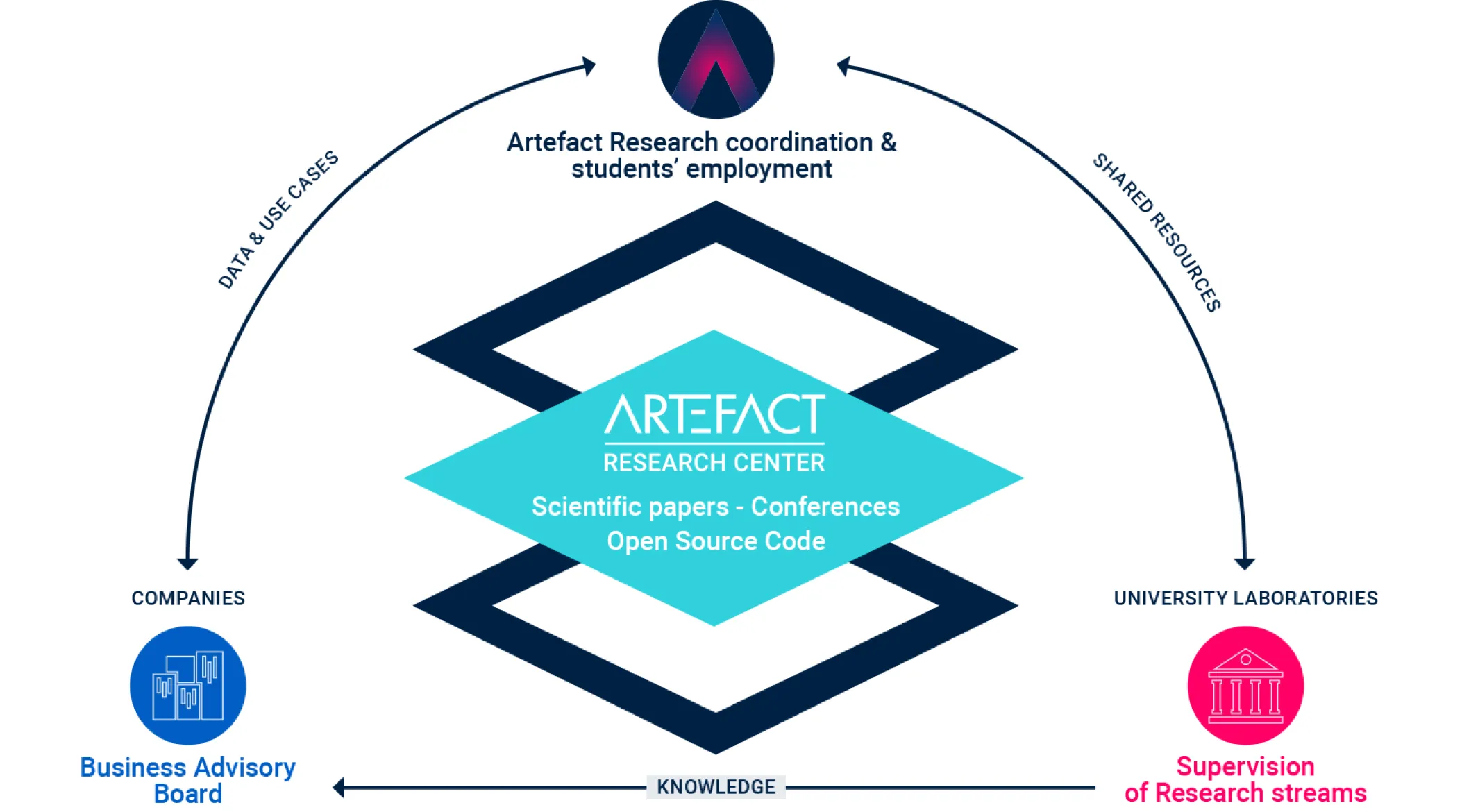

Der Auftrag von Artefact Research Center .

Ein vollständiges Ökosystem, das die Lücke zwischen

Grundlagenforschung und greifbaren industriellen Anwendungen überbrückt.

Emmanuel MALHERBE

Leiter der Forschung

Forschungsgebiet: Deep Learning, Maschinelles Lernen

Angefangen mit einer Promotion über NLP-Modelle, die an die elektronische Personalbeschaffung angepasst sind, hat Emmanuel immer ein effizientes Gleichgewicht zwischen reiner Forschung und wirkungsvollen Anwendungen gesucht. Zu seinen Forschungserfahrungen gehören 5G-Zeitreihenprognosen für Huawei Technologies und Computer-Vision-Modelle für Friseur- und Make-up-Kunden bei L'Oréal. Bevor er zu Artefact kam, arbeitete er in Shanghai als Leiter der AI Forschung für L'Oréal Asien. Heute ist seine Position bei Artefact eine perfekte Gelegenheit und ein ideales Umfeld, um die Kluft zwischen Wissenschaft und Industrie zu überbrücken und seine praxisnahe Forschung zu fördern, während er sich auf industrielle Anwendungen auswirkt.

Ein komplettes Ökosystem, das die Kluft zwischen Grundlagenforschung und konkreten industriellen Anwendungen überbrückt.

Transversale Forschungsbereiche

Mit unserer einzigartigen Positionierung zielen wir darauf ab, die allgemeinen Herausforderungen von AI anzugehen, sei es im Bereich der statistischen Modellierung oder der Managementforschung.

Diese Fragen sind transversal zu all unseren Themen und nähren unsere Forschung.

Themen

Wir arbeiten an mehreren Promotionsthemen an der Schnittstelle zwischen industriellen Anwendungsfällen und den Grenzen des Stands der Technik.

Für jedes Thema arbeiten wir mit Universitätsprofessoren zusammen und haben Zugang zu data , was uns ermöglicht, die wichtigsten Forschungsbereiche in einem bestimmten realen Szenario anzugehen.

1 - Vorhersage und Preisgestaltung

Modellierung der Zeitreihen als Ganzes mit einem kontrollierbaren, multivariaten Prognosemodell. Eine solche Modellierung wird es uns ermöglichen, die Preis- und Werbeplanung anzugehen, indem wir die optimalen Parameter finden, die die Absatzprognose erhöhen. Mit einem solchen ganzheitlichen Ansatz wollen wir die Kannibalisierung und Komplementarität zwischen Produkten erfassen. So können wir die Vorhersage kontrollieren und garantieren, dass die Vorhersagen konsistent sind.

2 - Erklärbares und kontrollierbares Scoring

Eine weit verbreitete Familie von Modellen des maschinellen Lernens basiert auf Entscheidungsbäumen: Random Forests, Boosting. Während ihre Genauigkeit oft dem neuesten Stand der Technik entspricht, leiden solche Modelle unter einem Black-Box-Gefühl, das dem Nutzer nur begrenzte Kontrolle bietet. Unser Ziel ist es, ihre Erklärbarkeit und Transparenz zu erhöhen, indem wir die Schätzung der SHAP-Werte im Falle unausgewogener Datensätze verbessern. Wir wollen auch einige Garantien für solche Modelle bieten, z. B. für nicht trainierte Stichproben oder durch die Ermöglichung besserer monotoner Beschränkungen.

3 - Optimierung des Sortiments

Das Sortiment ist ein wichtiges Geschäftsproblem für Einzelhändler, das bei der Auswahl der in den Geschäften zu verkaufenden Produkte auftritt. Mithilfe großer industrieller Datensätze und neuronaler Netze wollen wir robustere und besser interpretierbare Modelle entwickeln, die die Wahlmöglichkeiten der Kunden bei einem Produktsortiment besser erfassen. Der Umgang mit Kannibalisierung und Komplementaritäten zwischen Produkten sowie ein besseres Verständnis der Kundengruppen sind der Schlüssel zur Ermittlung einer optimalen Produktauswahl in einem Geschäft.

4 - AI Übernahme in Unternehmen

Die Herausforderung für eine bessere Einführung von AI in Unternehmen besteht darin, einerseits die Modelle von AI zu verbessern und andererseits die menschlichen und organisatorischen Aspekte zu verstehen. An der Schnittstelle zwischen qualitativer Managementforschung und Sozialforschung soll in diesem Schwerpunkt untersucht werden, wo Unternehmen Schwierigkeiten bei der Einführung von AI Tools haben. Die bestehenden Rahmenwerke für die Übernahme von Innovationen sind für Innovationen im Bereich des maschinellen Lernens nicht ganz geeignet, da es typische Unterschiede bei der Regulierung, der Ausbildung der Menschen oder der Voreingenommenheit gibt, wenn es um AI geht, und erst recht bei generativen AI.

5 - Data Nachhaltigkeit

Das Projekt wird qualitative und quantitative Forschungsmethoden einsetzen und zwei Schlüsselfragen behandeln: Wie können Unternehmen ihre soziale und ökologische Nachhaltigkeitsleistung effektiv messen? Warum führen Nachhaltigkeitsmaßnahmen oft nicht zu signifikanten Veränderungen in der Unternehmenspraxis?

Einerseits zielt das Projekt darauf ab, data Metriken zu erforschen und Indikatoren zu identifizieren, um organisatorische Abläufe mit sozialen und ökologischen Nachhaltigkeitszielen in Einklang zu bringen. Andererseits wird sich das Projekt darauf konzentrieren, diese Nachhaltigkeitsmaßnahmen in konkrete Maßnahmen innerhalb der Unternehmen umzusetzen.

6 - Voreingenommenheit in der Computer Vision

Wenn ein Modell eine Vorhersage auf der Grundlage eines Bildes trifft, das z. B. ein Gesicht zeigt, hat es Zugang zu sensiblen Informationen wie der ethnischen Zugehörigkeit, dem Geschlecht oder dem Alter, die seine Schlussfolgerungen verfälschen können. Unser Ziel ist es, einen Rahmen zu entwickeln, um solche Verzerrungen mathematisch zu messen, und Methoden vorzuschlagen, um diese Verzerrungen während des Modelltrainings zu reduzieren. Darüber hinaus würde unser Ansatz Zonen starker Verzerrungen statistisch aufdecken, um zu erklären, zu verstehen und zu kontrollieren, wo solche Modelle die Verzerrungen in data verstärken.

7 - LLM für Informationsbeschaffung

Eine wichtige Anwendung von LLMs ist die Verbindung mit einem Korpus von Dokumenten, die industrielles Wissen oder Informationen darstellen. In einem solchen Fall gibt es einen Schritt der Informationsbeschaffung, für den LLMs einige Einschränkungen aufweisen, wie z.B. die Größe des Eingabetextes, der für die Indizierung von Dokumenten zu klein ist. In ähnlicher Weise kann der Halluzinationseffekt auch in der endgültigen Antwort auftreten, die wir mit Hilfe des abgerufenen Dokuments und der Modellunsicherheit zur Inferenzzeit erkennen wollen.

ArtefactForscher auf Teilzeitbasis

Neben unserem Team, das sich der Forschung widmet, haben wir mehrere Mitarbeiter, die einige Zeit mit wissenschaftlicher Forschung und der Veröffentlichung von Artikeln verbringen. Indem sie auch als Berater arbeiten, inspirieren sie sich an realen Problemen, die bei unseren Kunden auftreten.

Veröffentlichungen

Medium-Blogartikel von unseren Technik-Experten.

Sortimentsoptimierung mit diskreten Auswahlmodellen in Python

Die Sortimentsoptimierung ist ein entscheidender Prozess im Einzelhandel, bei dem es darum geht, den idealen Produktmix zu finden, um die Nachfrage der Verbraucher zu befriedigen und gleichzeitig die vielen logistischen...

Ist das Präferenz-Alignment immer die beste Option zur Verbesserung der LLM-basierten Übersetzung? Eine empirische Analyse

Neuronale Metriken für die Bewertung der maschinellen Übersetzung (MT) sind aufgrund ihrer besseren Korrelation mit menschlichen Beurteilungen im Vergleich zu traditionellen lexikalischen Metriken zunehmend in den Vordergrund gerückt

Wahl-Lernen: Groß angelegte Wahlmodellierung für betriebliche Kontexte durch die Brille des maschinellen Lernens

Modelle der diskreten Auswahl zielen auf die Vorhersage von Wahlentscheidungen ab, die Individuen aus einem Menü von Alternativen, dem sogenannten Sortiment, treffen. Bekannte Anwendungsfälle sind die Vorhersage einer...

Die Ära der Generative AI: Was sich ändert

Die Fülle und Vielfalt der Reaktionen auf ChatGPT und andere generative KI, ob skeptisch oder enthusiastisch, zeigen die Veränderungen, die sie mit sich bringen, und die Auswirkungen...

Wie es Artefact gelungen ist, ein faires und dennoch einfaches Karrieresystem für Softwareingenieure zu entwickeln

In der dynamischen und sich ständig weiterentwickelnden Technologiebranche von heute kann sich eine berufliche Laufbahn oft wie ein gewundener Pfad durch einen dichten Wald von Möglichkeiten anfühlen. Mit der schnellen...

Warum Sie LLMOps brauchen

Dieser Artikel stellt LLMOps vor, einen spezialisierten Zweig, der DevOps und MLOps für die Bewältigung der Herausforderungen von Large Language Models (LLMs) zusammenführt...

Entfesselung der Leistungsfähigkeit der LangChain Expression Language (LCEL): von der Machbarkeitsstudie zur Produktion

LangChain hat sich in weniger als einem Jahr zu einer der meistgenutzten Python-Bibliotheken für die Interaktion mit LLMs entwickelt, aber LangChain war hauptsächlich eine Bibliothek...

Wie wir den Profil-ID-Abgleich mit Treasure Data Unification und SQL durchgeführt haben

In diesem Artikel erläutern wir die Herausforderungen des ID-Abgleichs und demonstrieren unseren Ansatz zur Erstellung einer einheitlichen Profil-ID in der Customer Data Platform, insbesondere...

Snowflake's Snowday '23: Schneeballschlacht zum Data Wissenschaftserfolg

Während wir über die Erkenntnisse nachdenken, die wir während der "Snowday"-Veranstaltung am 1. und 2. November gewonnen haben, gibt es eine Kaskade von...

Wie wir Software-Ingenieure interviewen und einstellen bei Artefact

Wir erläutern die Fähigkeiten, die wir suchen, die verschiedenen Schritte des Verfahrens und die Verpflichtungen, die wir gegenüber allen Bewerbern eingehen.

Kodierung kategorialer Merkmale in der Prognose: Machen wir es alle falsch?

Wir schlagen eine neuartige Methode zur Kodierung kategorialer Merkmale vor, die speziell auf Vorhersageanwendungen zugeschnitten ist.

Wie wir ein einfaches System zur Überwachung von Wildtieren in der Google Cloud eingerichtet haben

Wir haben mit Smart Parks zusammengearbeitet, einem niederländischen Unternehmen, das fortschrittliche Sensorlösungen zum Schutz bedrohter Wildtiere anbietet...