Auteurs

À l'ère de la transformation numérique, les entreprises accumulent en permanence des ensembles de data massives dont l'échelle et la complexité ne cessent de croître.

Pour les entreprises, un lac de data n'est pas seulement un moyen technique de stocker différents types de data, mais aussi une infrastructure permettant d'améliorer l'efficacité de l'analyse des data , de soutenir la prise de décision data et d'accélérer le développement de l'IA. Cependant, dans le traitement en temps réel, l'analyse des data en continu et les scénarios commerciaux complexes (par exemple, l'analyse du comportement des utilisateurs, la gestion des stocks, la détection des fraudes), les architectures de lac de data traditionnelles peinent à répondre à la demande de réponse rapide.

En tant que nouvelle génération de technologie de lac de data en temps réel, Apache PAIMON est compatible avec Apache Flink, Spark et d'autres moteurs de calcul grand public, et prend en charge le traitement en continu et par lots, les requêtes rapides et l'optimisation des performances, ce qui en fait un outil important pour accélérer la transformation de l'IA.

Principes de PAIMON

Apache PAIMON est un système de stockage et d'analyse qui prend en charge la mise à jour de data en temps réel à grande échelle et permet des requêtes efficaces grâce aux arbres LSM (log structure merge tree) et aux formats de stockage en colonnes (tels que ORC/Parquet). Il est profondément intégré à Flink pour intégrer les data changement provenant de Kafka, des journaux et des bases de données d'entreprise, et prend en charge le streaming et le batch streaming pour obtenir des mises à jour en temps réel à faible latence et des requêtes rapides.

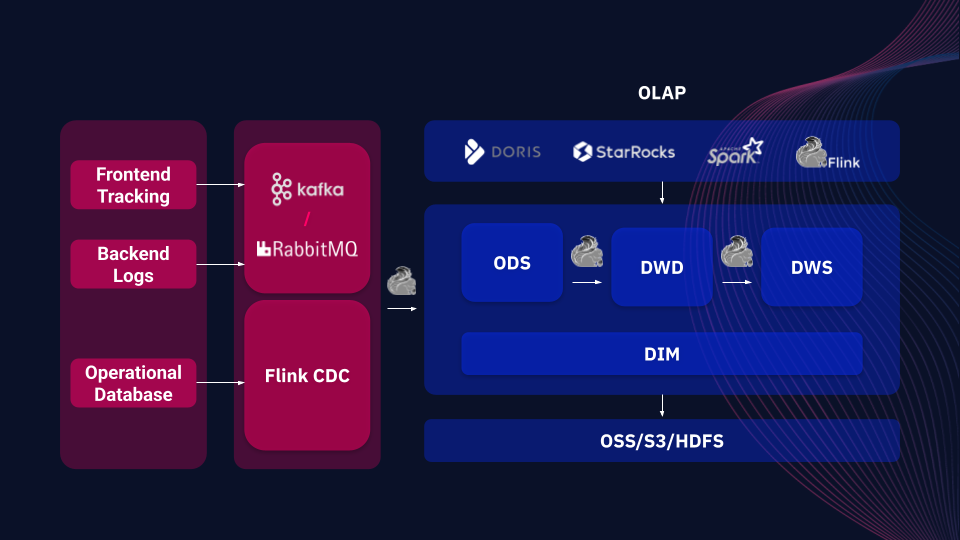

Exemple d'architecture de flux de data backend basée sur PAIMON

Comparé à d'autres cadres de lacs de data (par exemple Apache Iceberg et Delta Lake), PAIMON offre un support natif unique pour le traitement unifié flux-batch, qui non seulement traite efficacement les data par lots, mais répond également en temps réel aux data modifiées (par exemple CDC). Il est également compatible avec une variété de systèmes de stockage distribués (par exemple OSS, S3, HDFS) et s'intègre avec des outils OLAP (par exemple Spark, StarRocks, Doris) pour assurer un stockage sécurisé et des lectures efficaces, fournissant un support flexible pour la prise de décision rapide et l'analyse des data dans l'entreprise.

Principaux cas d'utilisation de PAIMON

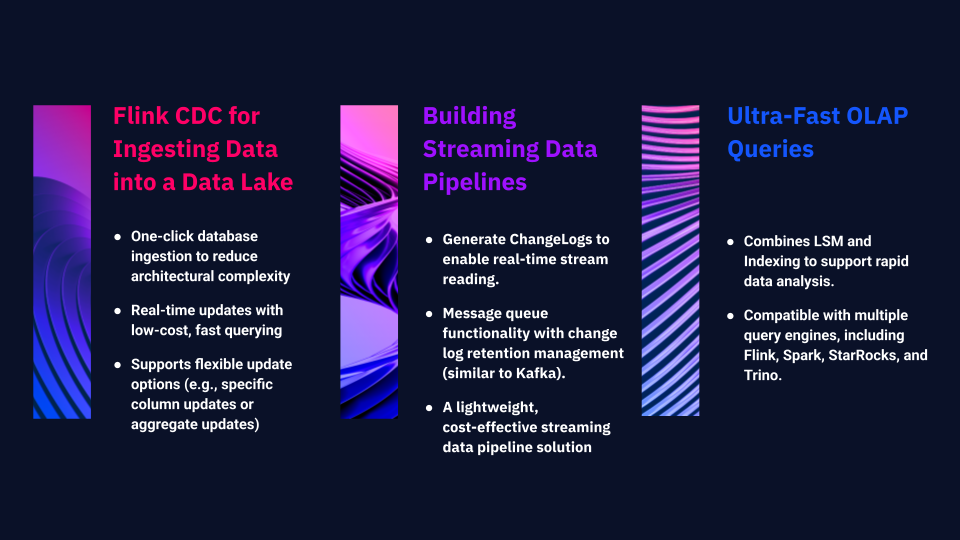

1. Flink CDC pour l'ingestion de Data dans un lac de Data

PAIMON simplifie et optimise ce processus. En un seul clic, la base de données entière peut être rapidement importée dans le lac de data , ce qui réduit considérablement la complexité de l'architecture. PAIMON prend en charge les mises à jour en temps réel et les requêtes rapides à faible coût. En outre, il offre des options de mise à jour flexibles qui permettent l'application de colonnes spécifiques ou de différents types de mises à jour agrégées.

2. Construire des pipelines de Data en continu

PAIMON peut être utilisé pour construire un pipeline de data en continu complet, avec des capacités telles que :

Générer un ChangeLog, permettant un accès en lecture en continu à des enregistrements entièrement mis à jour, facilitant ainsi la construction de puissants pipelines de data en continu.

PAIMON évolue vers un système de file d'attente de messages avec des mécanismes de consommation. Dans sa dernière version, il inclut la gestion du cycle de vie des journaux de modifications, permettant aux utilisateurs de définir des périodes de rétention (par exemple, les journaux peuvent être conservés pendant sept jours ou plus), à l'instar de Kafka. Il en résulte une solution de pipeline de streaming légère et rentable.

3. Requêtes OLAP ultra-rapides

Alors que les deux premiers cas d'utilisation garantissent un flux de data en temps réel, PAIMON prend également en charge les requêtes OLAP à grande vitesse pour analyser les data stockées. En combinant LSM et indexation, PAIMON permet une analyse rapide des data . Son écosystème prend en charge des moteurs d'interrogation tels que Flink, Spark, StarRocks et Trino, ce qui permet d'effectuer des requêtes efficaces sur les data stockées dans PAIMON.

Cas d'utilisation de lARTEFACT

Cas 1: Améliorer l'efficacité de l'analyse des Data en temps réel

Cas 2 : Mise en place d'un système fiable de suivi des activités en temps réel

Les cas ci-dessus résument l'expérience pratique d'ARTEFACTdans la mise en œuvre d'Apache PAIMON pour les clients. En tant que technologie de lac de data en temps réel, PAIMON offre aux entreprises une solution très efficace et flexible pour relever des défis complexes en matière de traitement des data .

BLOG

BLOG