Autoren

In der Ära der digitalen Transformation sammeln Unternehmen kontinuierlich riesige data an, die immer umfangreicher und komplexer werden.

Für Unternehmen ist ein data Lake nicht nur ein technisches Mittel zur Speicherung verschiedener data, sondern auch eine Infrastruktur zur Verbesserung der Effizienz der data , zur Unterstützung data Entscheidungen und zur Beschleunigung der Entwicklung von AI. Bei der Verarbeitung von Echtzeitdaten, der Analyse von data und komplexen Geschäftsszenarien (z. B. Analyse des Nutzerverhaltens, Bestandsverwaltung, Betrugserkennung) können herkömmliche data jedoch nur schwer den Anforderungen an eine schnelle Reaktion gerecht werden.

Eine neue Generation von data , Apache PAIMON ist mit Apache Flink, Spark und anderen Mainstream-Computing-Engines kompatibel und unterstützt Streaming- und Batch-Verarbeitung, schnelle Abfragen und Leistungsoptimierung, was es zu einem wichtigen Werkzeug für die Beschleunigung der AI macht.

PAIMON-Grundsätze

Apache PAIMON ist ein Speicher- und Analysesystem, das groß angelegte data in Echtzeit unterstützt und effiziente Abfragen durch LSM-Bäume (Log Structure Merge Tree) und spaltenförmige Speicherformate (wie ORC/Parquet) ermöglicht. Es ist tief in Flink integriert, um data aus Kafka, Protokollen und Unternehmensdatenbanken zu integrieren, und unterstützt Stream- und Batch-Streaming, um Echtzeit-Updates mit niedriger Latenz und schnelle Abfragen zu erreichen.

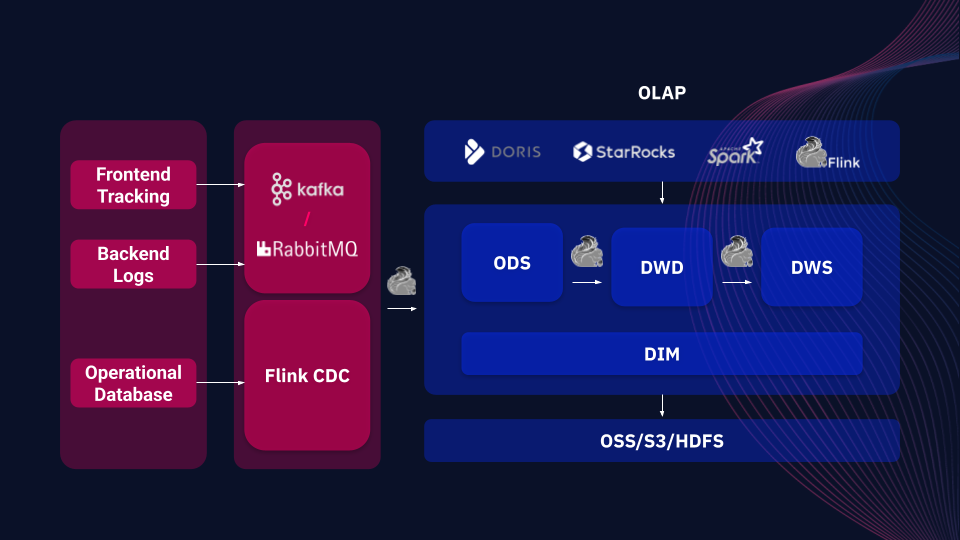

Beispiel einer PAIMON-basierten data

Im Vergleich zu anderen data (z. B. Apache Iceberg und Delta Lake) bietet PAIMON eine einzigartige native Unterstützung für eine einheitliche Stream-Batch-Verarbeitung, die nicht nur data effizient verarbeitet, sondern auch in Echtzeit auf geänderte data reagiert (z. B. CDC). PAIMON ist außerdem mit einer Vielzahl von verteilten Speichersystemen (z. B. OSS, S3, HDFS) kompatibel und lässt sich in OLAP-Tools (z. B. Spark, StarRocks, Doris) integrieren, um eine sichere Speicherung und effiziente Lesevorgänge zu gewährleisten und so eine flexible Unterstützung für die schnelle Entscheidungsfindung und data im Unternehmen zu bieten.

Wichtige PAIMON-Anwendungsfälle

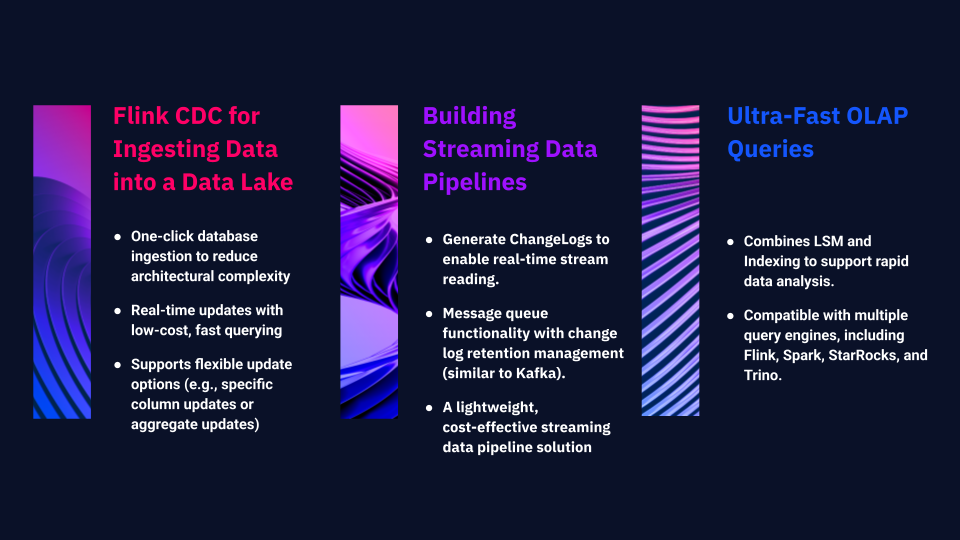

1. Flink CDC für das Ingesting von Data in einen Data Lake

PAIMON vereinfacht und optimiert diesen Prozess. Mit einem einzigen Klick kann die gesamte Datenbank schnell in den data Lake importiert werden, wodurch die Komplexität der Architektur erheblich reduziert wird. Es unterstützt Echtzeit-Updates und schnelle Abfragen zu geringen Kosten. Darüber hinaus bietet es flexible Aktualisierungsoptionen, die die Anwendung spezifischer Spalten oder verschiedener Arten von aggregierten Aktualisierungen ermöglichen.

2. Aufbau von Streaming Data Pipelines

PAIMON kann zum Aufbau einer vollständigen data verwendet werden und bietet unter anderem folgende Funktionen:

Erzeugen eines ChangeLogs, das den Lesezugriff auf vollständig aktualisierte Datensätze ermöglicht und den Aufbau leistungsfähiger data erleichtert.

PAIMON entwickelt sich zu einem Nachrichtenwarteschlangensystem mit Verbrauchermechanismen. In seiner neuesten Version enthält es eine Lebenszyklusverwaltung für Änderungsprotokolle, die es den Benutzern ermöglicht, Aufbewahrungszeiträume zu definieren (z. B. können Protokolle sieben Tage oder länger aufbewahrt werden), ähnlich wie bei Kafka. So entsteht eine leichtgewichtige, kostengünstige Streaming-Pipeline-Lösung.

3. Ultra-schnelle OLAP-Abfragen

Während die ersten beiden Anwendungsfälle einen data in Echtzeit gewährleisten, unterstützt PAIMON auch Hochgeschwindigkeits-OLAP-Abfragen zur Analyse gespeicherter data. Durch die Kombination von LSM und Indizierung ermöglicht PAIMON eine schnelle data . Das Ökosystem unterstützt Abfrage-Engines wie Flink, Spark, StarRocks und Trino und ermöglicht so effiziente Abfragen auf gespeicherte data innerhalb von PAIMON.

ARTEFACT Anwendungsfälle

Fall 1: Verbesserung der Effizienz der Data

Fall 2: Aufbau einer zuverlässigen Echtzeit-Geschäftsüberwachung

Die oben genannten Fälle fassen die praktischen Erfahrungen von ARTEFACTbei der Implementierung von Apache PAIMON für Kunden zusammen. Als data bietet PAIMON Unternehmen eine hocheffiziente und flexible Lösung für die Bewältigung komplexer data .

BLOG

BLOG