Autores

En la era de la transformación digital, las empresas acumulan continuamente conjuntos de datos masivos de escala y complejidad crecientes.

Para las empresas, un lago de data no es solo un medio técnico para almacenar diferentes tipos de data, sino también una infraestructura para mejorar la eficiencia del análisis de data , apoyar la toma de decisiones data y acelerar el desarrollo de AI. Sin embargo, en el procesamiento en tiempo real, el análisis de data en streaming y los escenarios empresariales complejos (por ejemplo, el análisis del comportamiento de los usuarios, la gestión de inventarios o la detección de fraudes), las arquitecturas de lago de data tradicionales tienen dificultades para satisfacer la demanda de respuesta rápida.

Como una nueva generación de tecnología de lago de data en tiempo real, Apache PAIMON es compatible con Apache Flink, Spark y otros motores de computación convencionales, y admite el procesamiento en streaming y por lotes, las consultas rápidas y la optimización del rendimiento, lo que la convierte en una herramienta importante para acelerar la transformación de AI .

Principios PAIMON

Apache PAIMON es un sistema de almacenamiento y análisis que admite la actualización de data a gran escala en tiempo real y realiza consultas eficientes mediante árboles LSM (árbol de fusión de estructuras de registro) y formatos de almacenamiento en columnas (como ORC/Parquet). Está profundamente integrado con Flink para integrar data cambios de Kafka, registros y bases de datos empresariales, y admite streaming de flujos y lotes para lograr actualizaciones en tiempo real de baja latencia y consultas rápidas.

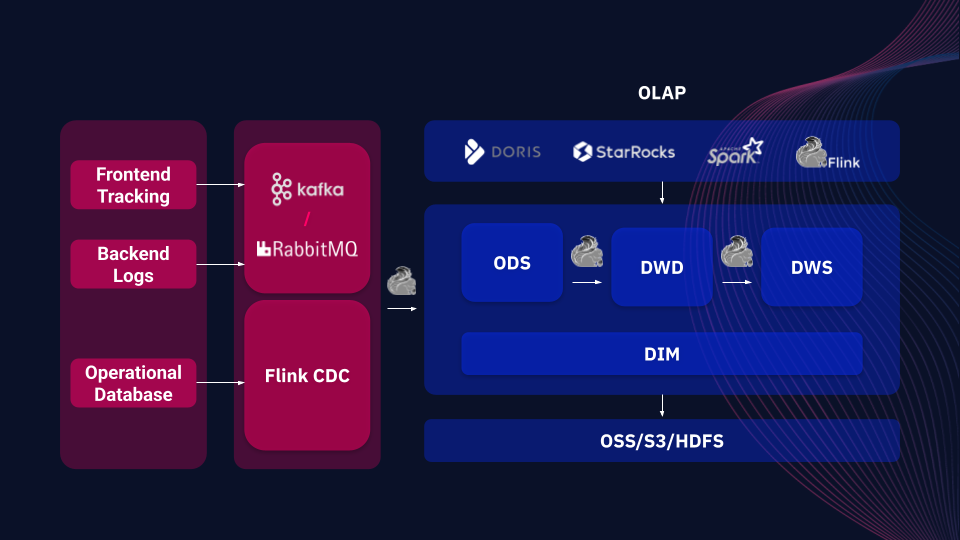

Ejemplo de arquitectura de flujo de data backend basada en PAIMON

En comparación con otros frameworks de lagos de data (p. ej., Apache Iceberg y Delta Lake), PAIMON ofrece de forma exclusiva soporte nativo para el procesamiento unificado de flujo por lotes, que no solo gestiona de forma eficiente data por lotes, sino que también responde en tiempo real a los data modificados (p. ej., CDC). También es compatible con una variedad de sistemas de almacenamiento distribuido (por ejemplo, OSS, S3, HDFS) y se integra con herramientas OLAP (por ejemplo, Spark, StarRocks, Doris) para garantizar un almacenamiento seguro y lecturas eficientes, proporcionando un soporte flexible para la toma rápida de decisiones y el análisis de data en la empresa.

Casos clave de PAIMON

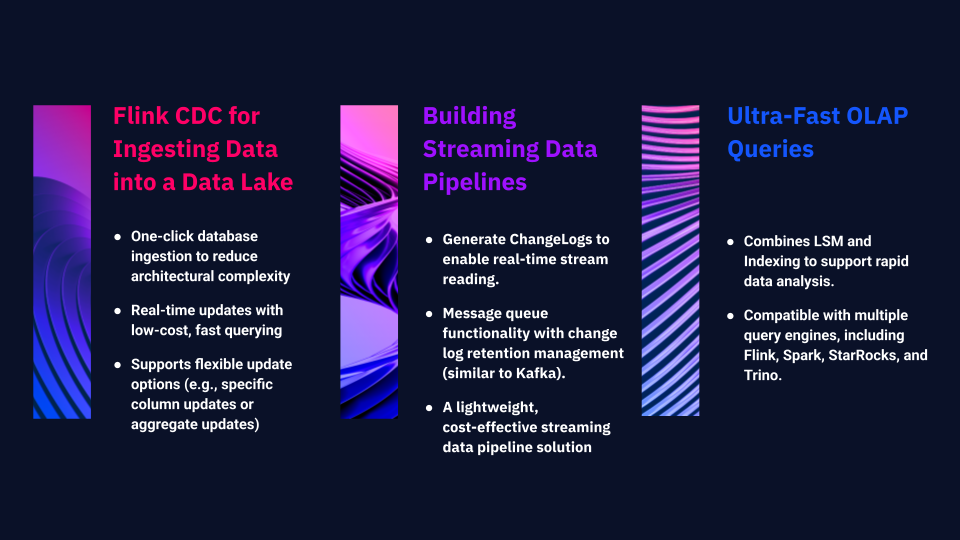

1. Flink CDC para la ingesta de Data en un lago de Data

PAIMON simplifica y optimiza este proceso. Con un solo clic, toda la base de datos puede importarse rápidamente al lago de data , lo que reduce enormemente la complejidad de la arquitectura. Admite actualizaciones en tiempo real y consultas rápidas a bajo coste. Además, proporciona opciones de actualización flexibles que permiten la aplicación de columnas específicas o diferentes tipos de actualizaciones agregadas.

2. Creación de cadenas de flujo de Data

PAIMON se puede utilizar para construir un canal de data de flujo completo, con capacidades que incluyen:

Generar ChangeLog, permitiendo el acceso de lectura en streaming a registros totalmente actualizados, facilitando la construcción de potentes pipelines de data en streaming.

PAIMON está evolucionando hacia un sistema de colas de mensajes con mecanismos de consumo. En su última versión, incluye la gestión del ciclo de vida de los registros de cambios, lo que permite a los usuarios definir periodos de retención (por ejemplo, los registros pueden conservarse durante siete días o más), de forma similar a Kafka. De este modo, se crea una solución de canalización de flujo ligera y rentable.

3. Consultas OLAP ultrarrápidas

Mientras que los dos primeros casos de uso garantizan el flujo de data en tiempo real, PAIMON también admite consultas OLAP de alta velocidad para analizar data almacenados. Al combinar LSM e indexación, PAIMON permite un análisis rápido de data . Su ecosistema admite motores de consulta como Flink, Spark, StarRocks y Trino, lo que permite realizar consultas eficientes sobre data almacenados dentro de PAIMON.

Casos prácticos de ARTEFACT

Caso 1: Mejorar la eficacia del análisis de Data en tiempo real

Caso 2: Creación de un sistema fiable de supervisión empresarial en tiempo real

Los casos anteriores resumen la experiencia práctica de ARTEFACTen la implementación de Apache PAIMON para clientes. Como tecnología de lago de data en tiempo real, PAIMON Servicios empresas una solución altamente eficiente y flexible para hacer frente a los retos de procesamiento de data complejos.

BLOG

BLOG