Auteurs

In het tijdperk van digitale transformatie verzamelen bedrijven voortdurend enorme data met een toenemende schaal en complexiteit.

Voor bedrijven is een data lake niet alleen een technisch middel om verschillende soorten data op te slaan, maar ook een infrastructuur om de efficiëntie van data te verbeteren, data besluitvorming te ondersteunen en de ontwikkeling van AI te versnellen. Bij real-time verwerking, streaming data en complexe bedrijfsscenario's (bijv. analyse van gebruikersgedrag, voorraadbeheer, fraudedetectie) hebben traditionele data lake-architecturen echter moeite om aan de vraag naar snelle respons te voldoen.

Als een nieuwe generatie van real-time data lake technologie, Apache PAIMON is compatibel met Apache Flink, Spark en andere mainstream computing engines, en ondersteunt streaming en batch processing, snelle query's en prestatieoptimalisatie, waardoor het een belangrijk hulpmiddel is voor het versnellen van AI .

PAIMON Principes

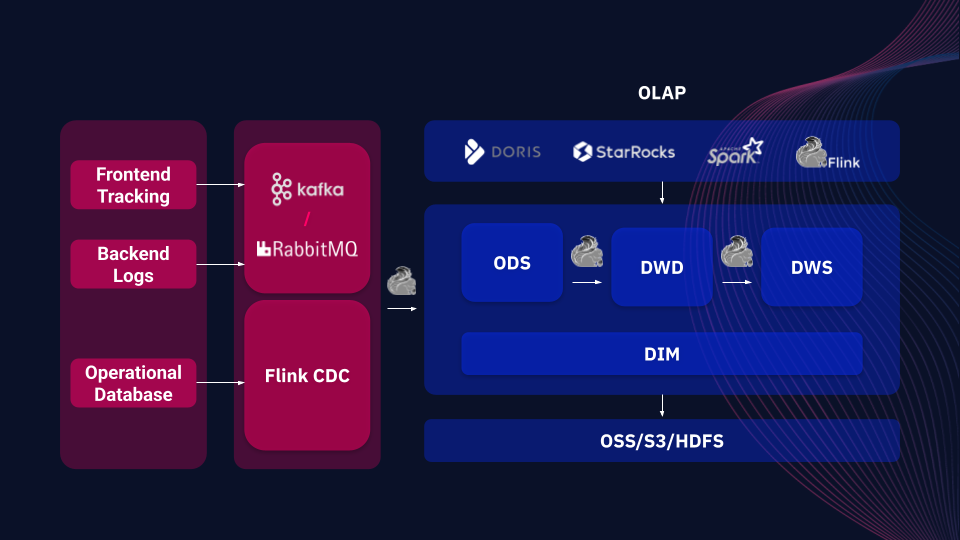

Apache PAIMON is een opslag- en analysesysteem dat grootschalige realtime data ondersteunt en efficiënte query's mogelijk maakt via LSM-bomen (logstructuur merge tree) en kolomvormige opslagformaten (zoals ORC/Parquet). Het is diep geïntegreerd met Flink om data van Kafka, logs en bedrijfsdatabases te integreren en ondersteunt stream- en batchstreaming om updates en snelle query's met een lage latentie en in realtime te realiseren.

Voorbeeld van op PAIMON gebaseerde backend data

Vergeleken met andere data lake frameworks (bijv. Apache Iceberg en Delta Lake) biedt PAIMON unieke native ondersteuning voor unified stream-batch processing, die niet alleen efficiënt omgaat met data, maar ook in real-time reageert op gewijzigde data (bijv. CDC). Het is ook compatibel met een verscheidenheid aan gedistribueerde opslagsystemen (bijv. OSS, S3, HDFS) en integreert met OLAP-tools (bijv. Spark, StarRocks, Doris) om veilige opslag en efficiënt lezen te garanderen, wat flexibele ondersteuning biedt voor snelle besluitvorming en data in de onderneming.

Belangrijkste PAIMON-gebruiksgevallen

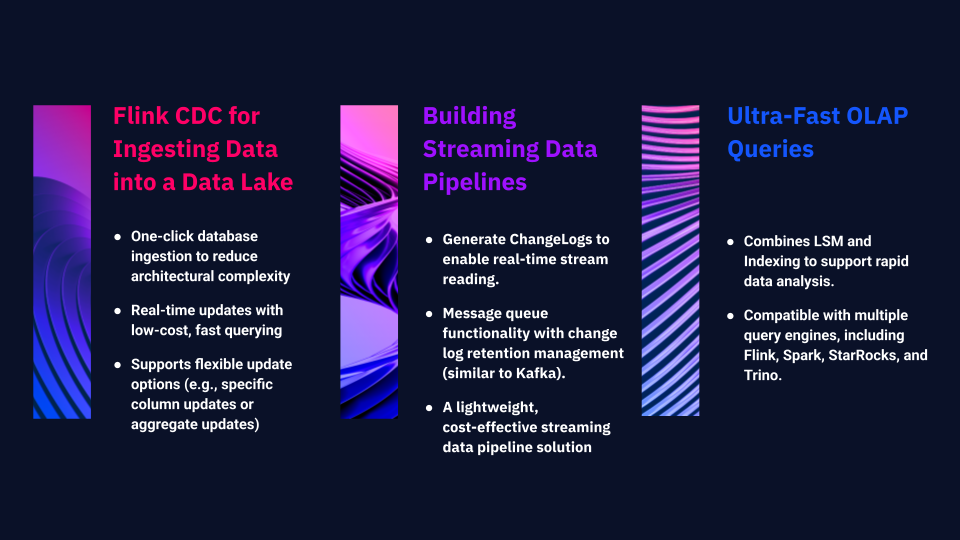

1. Flink CDC voor het invoeren van Data in een Data Lake

PAIMON vereenvoudigt en optimaliseert dit proces. Met een enkele klik kan de volledige database snel in het data lake worden geïmporteerd, waardoor de complexiteit van de architectuur sterk wordt verminderd. Het ondersteunt real-time updates en snelle queries tegen lage kosten. Daarnaast biedt het flexibele updateopties die de toepassing van specifieke kolommen of verschillende soorten geaggregeerde updates mogelijk maken.

2. Streaming Data bouwen

PAIMON kan worden gebruikt om een complete streaming data te bouwen, met mogelijkheden zoals:

Genereer ChangeLog, waardoor streaming leestoegang tot volledig bijgewerkte records mogelijk is, waardoor het eenvoudiger wordt om krachtige streaming data pipelines te bouwen.

PAIMON ontwikkelt zich tot een berichtwachtrijsysteem met consumentenmechanismen. In de nieuwste versie bevat het lifecycle management voor change logs, waardoor gebruikers retentieperiodes kunnen definiëren (logs kunnen bijvoorbeeld zeven dagen of langer bewaard worden), vergelijkbaar met Kafka. Dit creëert een lichtgewicht, kosteneffectieve streaming pipeline oplossing.

3. Ultrasnelle OLAP-query's

Terwijl de eerste twee gebruikssituaties zorgen voor een real-time data , ondersteunt PAIMON ook snelle OLAP-query's om opgeslagen data te analyseren. Door LSM en indexering te combineren, maakt PAIMON snelle data mogelijk. Het ecosysteem ondersteunt query-engines zoals Flink, Spark, StarRocks en Trino, waardoor efficiënte query's op opgeslagen data binnen PAIMON mogelijk zijn.

ARTEFACT Gebruikscases

Casus 1: Efficiëntere real-time Data

Casus 2: Betrouwbare realtime bedrijfsmonitoring bouwen

Bovenstaande cases zijn een samenvatting van ARTEFACT's praktische ervaring met het implementeren van Apache PAIMON voor klanten. Als een real-time data lake technologie, services PAIMON bedrijven een zeer efficiënte en flexibele oplossing om complexe data aan te gaan.

BLOG

BLOG