Du studio à la diffusion en continu : L'influence de l'IA sur la musique et son impact sur le marché

La première performance en direct documentée associant l'IA générative et un musicien a eu lieu en novembre 2022, lorsque le pianiste David Dolan (Guildhall School of Music and Drama) a improvisé en dialoguant avec un système d'IA semi-autonome conçu par le compositeur Oded Ben-Tal (Kingston University). Ce concert révolutionnaire a démontré les possibilités créatives de l'IA en tant que partenaire de collaboration dans le domaine de la musique. Depuis lors, des musiciens et même des non-musiciens ont adopté l'IA générative, produisant des compositions complètes avec des voix, des instruments et même des sons provenant d'instruments inexistants. Cela marque le début d'une nouvelle ère où l'IA remodèle la création et la production musicales. Alors que l'intelligence artificielle continue de remodeler les industries, le monde de la musique connaît sa propre révolution. Des amateurs aux grandes maisons de disques, tous les acteurs de l'industrie sont aux prises avec les implications de cette technologie.

L'industrie musicale, historiquement façonnée par les avancées technologiques, entre dans une nouvelle phase de transformation. L'intégration de l'IA promet de redéfinir la manière dont la musique est créée, produite et consommée, compte tenu de l'impact considérable de l'industrie musicale sur les plateformes de divertissement, de médias et de diffusion en continu qui hébergent des millions de titres.

L'IA générative, la technologie à l'origine de ce changement radical, est rapidement passée de la recherche universitaire à des applications pratiques. Des modèles tels que Music Transformer et MusicLM repoussent les limites du possible, traduisant des concepts abstraits en compositions harmonieuses. Ces systèmes d'IA, formés sur de vastes ensembles de données musicales, peuvent désormais générer des mélodies originales, des harmonies et même des chansons entières avec une compétence étonnante.

Cependant, comme toute révolution technologique, l'essor de l'IA dans la musique suscite à la fois de l'enthousiasme et de l'inquiétude. Les artistes et les professionnels du secteur sont divisés quant à son impact potentiel. Certains y voient un puissant outil de créativité et de démocratisation, tandis que d'autres s'inquiètent des conséquences pour l'art humain et la sécurité de l'emploi.

Le paysage de l'industrie musicale est déjà en train de changer. Les plateformes de streaming tirent parti de l'IA pour créer des listes de lecture personnalisées, tandis que les logiciels de production intègrent des outils de mixage et de mastering assistés par l'IA. Même les grandes maisons de disques explorent le potentiel de l'IA pour la recherche de talents et la prévision des tendances.

Alors que nous entrons dans cette nouvelle ère, les questions ne manquent pas. Comment l'IA va-t-elle remodeler les rôles des artistes, des producteurs et des ingénieurs ? Quelles considérations juridiques et éthiques devons-nous prendre en compte ? Et peut-être plus important encore, comment cette technologie affectera-t-elle la connexion émotionnelle entre les musiciens et leur public ?

Dans cet article, nous allons explorer l'état actuel de l'IA générative dans la musique, ses applications dans différents secteurs de l'industrie et l'avenir potentiel qu'elle annonce. De la technologie qui sous-tend ces modèles d'IA aux défis pratiques liés à leur mise sur le marché, nous examinerons comment cette innovation est prête à transformer l'une des industries créatives les plus aimées et les plus influentes au monde.

À l'heure où l'industrie musicale entre dans l'ère de l'IA, il est évident que les futurs compositeurs ne seront peut-être pas uniquement des humains, ce qui constitue un changement important pour l'industrie qui navigue dans cette nouvelle frontière.

1. La technologie de l'IA générative pour la musique

De la composition au code : Les percées de l'IA générative en musique

Le passage de la composition traditionnelle à la musique générée par l'IA a été tout simplement révolutionnaire. Nous connaissons bien la génération de texte à l'aide de chatGPT et la génération d'images à l'aide de Stable diffusion et MidJourney. Les principales percées en matière de génération de musique résident dans l'adaptation de ces puissants modèles aux spécificités de la musique data.

I. GPT pour la musique (génération discrète)

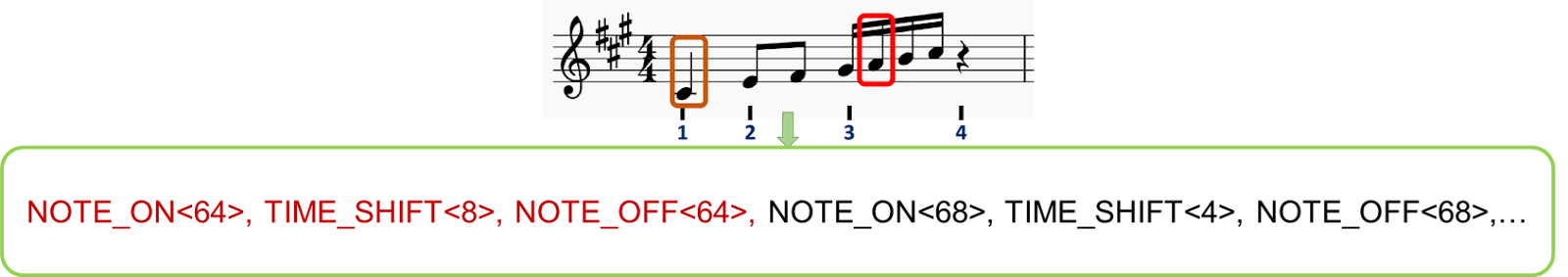

Tout comme GPT modélise le langage des processus, des principes similaires peuvent être appliqués aux éléments musicaux. La clé réside dans la tokenisation, c'est-à-dire la décomposition de la musique en unités discrètes et gérables. Le processus d'application des modèles GPT à la musique par le biais de la tokenisation est une étape cruciale pour permettre à l'IA de comprendre et de générer de la musique. Voici une explication plus détaillée :

1. La tokenisation de la musique : Tout comme les modèles GPT décomposent le texte en tokens (mots ou sous-mots), la musique doit être décomposée en unités discrètes que l'IA peut traiter. Nous explorons ci-dessous deux méthodes de tokenisation :

i. Les notes peuvent être considérées comme des éléments discrets contenant de multiples informations :

a) La hauteur : La note spécifique jouée (par exemple, do, ré, mi, etc.)

b) Durée : La durée pendant laquelle la note est tenue (par exemple, quart de note, demi-note).

c) Vitesse : La force ou la douceur avec laquelle la note est jouée.

d) Instrument : L'instrument qui joue la note

ii. Exemple : une note C4 jouée sur un quart de temps peut être représentée par des jetons : ; ; , tandis qu'une note G3 jouée sur un demi temps peut être représentée par des jetons ; ;

( nous pouvons ajouter des jetons pour les vitesses, les structures de mesure, les instruments, les genres,...)

iii. Création de séquences numériques :

Ces séries de notes-tokens sont ensuite concaténées et organisées en séquences, de la même manière que les mots forment des phrases dans les modèles de langage. Chaque jeton se voit attribuer un identifiant numérique unique, ce qui permet au modèle GPT de recevoir une entrée similaire à celle de la génération de texte.

iv. Exemple : une phrase musicale se présente comme suit : [123 ; 8 ; 456 ; 118 ; 12 ; 451 ;]: [123 ; 8 ; 456 ; 118 ; 12 ; 451 ;...] où chaque chiffre représente un événement musical spécifique.

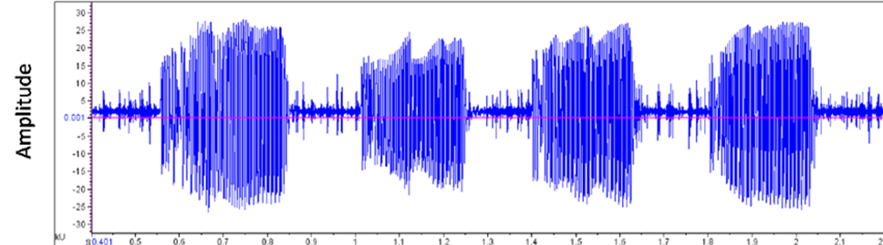

i. Les fichiers audio sont stockés dans les ordinateurs sous forme d'ondes, représentant l'amplitude du signal dans le temps. Ce qui donne une représentation plus riche que les simples partitions.

ii. Cette onde peut être divisée en segments représentant le "sens de la musique" à l'aide d'un modèle entraîné (similaire à BERT pour les vecteurs de mots) qui crée une version de l'entrée audio avec des jetons.

iii. Les vecteurs obtenus peuvent être conditionnés par une intégration conjointe de l'audio et du texte, créant ainsi des jetons représentant à la fois les caractéristiques audio et la description textuelle, ce qui permet à l'utilisateur d'utiliser un texte comme entrée pendant l'inférence.

2. Formation à l'IA :

3. Génération :

Music Transformer, développé par le projet Magenta de Google, a marqué une étape importante dans ce domaine. En étant l'un des premiers à Postuler le mécanisme d'attention de Transformer - une pierre angulaire des modèles de langage - pour les séquences musicales, il a atteint une cohérence remarquable dans les compositions de longue durée. D'autres modèles ont suivi, chacun repoussant les limites de ce que l'IA pouvait accomplir en matière de création musicale.

II. Modèles de diffusion pour la musique (génération continue)

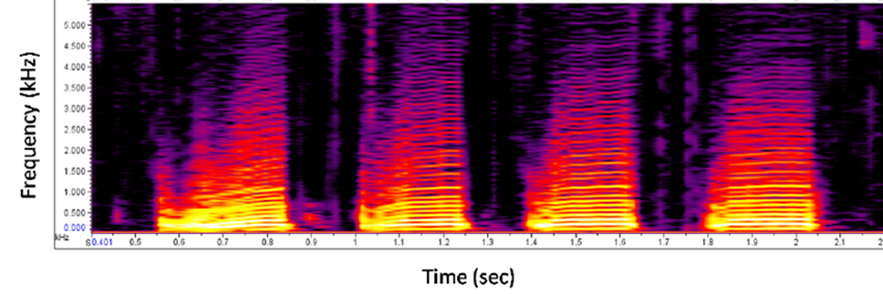

Les modèles de diffusion, tels que MidJourney ou Stable Diffusion, ont été largement adoptés et utilisés pour la génération d'images. Les images générées sont de plus en plus détaillées et personnalisables et font preuve d'une grande cohérence tout en ajoutant des détails de style ou de résolution dans une invite. Cette personnalisation est une caractéristique intéressante pour la génération de musique également. Comment transformer la musique en image ?

La musique comme une image :

En considérant les spectrogrammes comme des images et en les alignant sur une description textuelle, il est possible d'exercer un contrôle puissant sur la génération, ce qui permet aux utilisateurs de demander la musique qu'ils souhaitent comme ils le feraient pour des images avec MidJourney.

Combler le fossé entre l'innovation et l'industrie : Les défis de la génération de musique par l'IA :

Nous avons exploré deux façons différentes de générer de la musique à l'aide de l'IA. Toutes ces technologies ont donné lieu à des démonstrations impressionnantes et divertissantes. Cependant, le chemin qui mène des expériences de laboratoire aux produits prêts à être commercialisés est semé d'embûches. Les obstacles techniques ne manquent pas, qu'il s'agisse d'assurer une qualité constante dans différents styles musicaux ou de gérer les exigences informatiques de la génération en temps réel. Les défis commerciaux sont tout aussi redoutables, car les développeurs s'efforcent de trouver le bon public et les bons cas d'utilisation pour leurs compositeurs d'IA.

La gestion et les considérations juridiques ajoutent encore à la complexité. La constitution et la direction d'équipes à l'intersection de la musique et de l'IA requièrent un mélange unique de compétences. Parallèlement, le paysage éthique et juridique reste largement inexploré, soulevant des questions sur les droits d'auteur, la paternité des œuvres et la nature même de la créativité à l'ère de l'IA.

À mesure que nous approfondissons les applications et les produits actuels issus de cette révolution technologique, il devient évident que l'impact de l'IA sur l'industrie musicale sera considérable et touchera toutes les parties prenantes, des auditeurs aux grandes maisons de disques.

2. Applications et produits actuels

Alors que l'IA générative continue de se développer, une variété de plateformes et d'outils ont vu le jour dans l'industrie de la musique. Ces innovations passent du stade de concepts expérimentaux à celui d'applications pratiques, chacune offrant des capacités et des utilisations potentielles différentes.

I. Le plus utilisé aujourd'hui : Suno.AI

Dans le paysage de la génération de musique par l'IA, Suno.AI a attiré l'attention. Cette plateforme permet aux utilisateurs de créer de la musique à partir d'invites textuelles, en générant des chansons complètes comprenant des voix, des instruments et des paroles dans différents genres et styles.

Suno.AI a fait état d'une base de 12 millions d'utilisateurs et de tours de financement réussis, atteignant une évaluation de 500 millions de dollars. La plateforme propose des versions gratuites et payantes, la version gratuite permettant aux utilisateurs de créer un nombre limité de chansons par jour. Ses applications vont des maquettes de bandes-annonces de films aux bandes sonores de jeux vidéo.

Un cinéaste travaillant sur un court métrage peut utiliser Suno.AI pour générer une bande sonore personnalisée lorsqu'il n'est pas en mesure d'engager un compositeur. Les agences de publicité explorent la plateforme pour créer rapidement des jingles et des musiques de fond pour les spots publicitaires, ce qui pourrait modifier leur flux de travail pour la musique dans la publicité.

II. Autres plateformes musicales d'IA

Si Suno.AI a attiré l'attention, elle fait partie d'un écosystème croissant de plateformes musicales basées sur l'IA.

À mesure que ces plateformes évoluent et que de nouvelles apparaissent, les applications de l'IA dans la musique continuent de se diversifier. Des créateurs individuels aux grandes entreprises, les utilisations potentielles couvrent un large éventail, ce qui laisse présager un avenir où l'IA pourrait jouer un rôle de plus en plus important dans la création et la production musicales.

3. Impact sur les différentes parties prenantes

Alors que l'IA générative continue d'évoluer, son impact se répercute sur toutes les facettes de l'industrie musicale. Des auditeurs aux grandes maisons de disques, chaque groupe voit sa relation avec la création et la consommation de musique évoluer. Si certains s'inquiètent de ces changements, d'autres y voient la progression naturelle d'une industrie qui a toujours été façonnée par les avancées technologiques.

I. Les auditeurs

Le parcours des consommateurs de musique a été marqué par une personnalisation et une découverte croissantes. Avant l'IA, les auditeurs s'en remettaient aux DJ, aux magazines musicaux et au bouche-à-oreille pour découvrir de nouvelles musiques. Les listes de lecture étaient minutieusement élaborées à la main, souvent limitées par les bibliothèques musicales personnelles.

Avec l'avènement de l'IA, des plateformes comme Spotify ont introduit des fonctionnalités telles que Discover Weekly en juillet 2015, utilisant des algorithmes pour analyser les habitudes d'écoute et suggérer de nouveaux titres. Cela a marqué une étape importante dans la découverte personnalisée de la musique, exposant les auditeurs à un plus large éventail d'artistes et de genres.

Aujourd'hui, grâce à l'IA générative, nous sommes sur le point de vivre une expérience encore plus personnalisée. LifeScore est un système qui ne se contente pas de recommander des musiques existantes, mais crée de nouvelles compositions en fonction de l'humeur, de l'activité ou même des données biométriques de l'auditeur data. Un joggeur pourrait avoir une bande sonore personnalisée générée en temps réel, s'adaptant à son rythme et à sa fréquence cardiaque, mélangeant ses genres préférés pour en faire quelque chose d'entièrement nouveau.

II. Les artistes

Pour les musiciens, le processus créatif a toujours été influencé par les outils et les technologies disponibles. Avant l'IA, la composition reposait largement sur les instruments traditionnels et les techniques d'enregistrement. L'introduction des synthétiseurs et des stations de travail audio numériques (DAW) à la fin du 20e siècle a déjà commencé à remodeler la façon dont la musique était créée. Comme l'a noté Jean-Michel Jarre, pionnier de la musique électronique : "C'est la technologie qui a toujours dicté les styles et non l'inverse. C'est parce que nous avons inventé le violon que Vivaldi a fait la musique qu'il a faite... Pour moi, l'IA n'est pas nécessairement un danger si elle est bien utilisée".

Les logiciels de composition peuvent suggérer des progressions d'accords ou des mélodies, jouant ainsi un rôle de partenaire dans le processus de création.

Avec l'IA générative, nous assistons à l'émergence de la coécriture par l'IA. Les artistes peuvent désormais saisir une mélodie de base ou une idée lyrique et demander à un système d'IA de générer des éléments complémentaires, ce qui peut donner lieu à de nouvelles orientations créatives. Certains musiciens expérimentent même l'adaptation du style en temps réel pendant les concerts, en utilisant l'IA pour modifier leur son à la volée en fonction des réactions du public.

Pour les artistes amateurs, de nombreuses applications de formation font bon usage de l'IA pour proposer des expériences d'apprentissage en temps réel, interactives et personnalisées. Grâce à d'autres outils permettant de simuler des arrangements et des groupes, le coût d'apprentissage de la créativité est réduit, ce qui permet à un plus grand nombre de personnes de jouer et d'apprécier la musique.

III. Ingénieurs

Le rôle des ingénieurs du son a toujours été de s'adapter aux nouvelles technologies. Traditionnellement, le mixage et le mastering étaient des processus entièrement manuels, nécessitant une oreille attentive et des années d'expérience. Interrogé dans le cadre de cet article, Marius Blanchard, Data Scientist chez Spotify, a déclaré : "L'IA n'est pas là pour remplacer les musiciens, mais pour leur donner les moyens d'agir : "L'IA n'est pas là pour remplacer les musiciens, mais pour leur donner les moyens d'agir. C'est un outil qui peut aider les artistes à explorer de nouveaux territoires créatifs et à repousser les limites de la création musicale."

L'IA a déjà fait des percées dans ce domaine, avec des outils comme Neutron d'iZotope qui offrent une assistance intelligente au mixage. Ces systèmes peuvent analyser une piste et suggérer des réglages d'égalisation, des niveaux de compression et d'autres paramètres, rationalisant ainsi le processus de mixage.

À mesure que l'IA générative devient plus sophistiquée, nous pourrions voir des systèmes de mixage et de masterisation entièrement automatisés capables de traiter un album entier avec une intervention humaine minimale. Toutefois, de nombreux acteurs du secteur affirment que la touche humaine sera toujours nécessaire pour capturer les nuances émotionnelles d'une performance.

IV. Sociétés de musique et de plates-formes

Les maisons de disques et les éditeurs de musique ont longtemps compté sur l'intuition humaine et les études de marché pour repérer les tendances et découvrir de nouveaux talents. Les responsables A&R (Artistes et Répertoire) parcouraient les clubs et les cassettes de démo, à la recherche de la prochaine grande vedette.

L'intégration de l'IA a fait évoluer ce processus vers une prise de décision data. Les plateformes analysent les data streaming, l'engagement dans les médias sociaux et d'autres paramètres pour identifier les artistes en pleine ascension et prédire le potentiel de succès.

Avec l'IA générative, les entreprises musicales explorent des possibilités encore plus radicales. Certaines expérimentent des systèmes d'IA capables de générer de la musique adaptée à des segments de marché ou à des données démographiques spécifiques. D'autres utilisent des modèles prédictifs pour prévoir quelles structures de chansons ou quels thèmes lyriques sont susceptibles de trouver un écho auprès du public dans les mois à venir.

Alors que l'industrie est aux prises avec ces changements, la question clé demeure : Comment évoluera l'équilibre entre la créativité humaine et l'assistance de l'IA ? Alors que certains craignent la perte de la touche humaine dans la création musicale, d'autres considèrent l'IA comme un outil qui, à terme, renforcera la créativité humaine, en ouvrant de nouvelles voies d'expression et de collaboration.

4. Visions et opportunités futures

Alors que l'IA générative continue de remodeler l'industrie musicale, les parties prenantes sont aux prises avec un paysage complexe de considérations juridiques, économiques et éthiques. Cette technologie transformatrice promet de démocratiser la création musicale tout en remettant en question les notions traditionnelles d'art et de droit d'auteur.

I. Considérations juridiques et commerciales

1. Le droit d'auteur à l'ère de l'IA

Avant l'apparition de l'IA, les lois sur le droit d'auteur dans le domaine de la musique étaient relativement simples. Les compositeurs et les interprètes détenaient des droits sur leurs œuvres originales, avec des directives claires sur l'échantillonnage et l'utilisation équitable. Toutefois, l'introduction de la musique générée par l'IA a considérablement brouillé ces lignes.

Aux États-Unis, la protection du droit d'auteur s'étend aux œuvres originales, tandis que la doctrine européenne met l'accent sur la touche personnelle du créateur. Cette distinction devient cruciale lorsqu'il s'agit de musique générée par l'IA. Le Bureau américain du droit d'auteur a déclaré qu'il n'enregistrerait pas les œuvres produites par une machine ou un simple processus mécanique qui fonctionne de manière aléatoire ou automatique sans apport créatif ou intervention d'un auteur humain.

En 2023, au moins une affaire très médiatisée a mis en lumière les problèmes de droit d'auteur liés à la musique générée par l'IA qui imite des artistes populaires. Un morceau intitulé "Heart on My Sleeve", qui utilisait l'IA pour imiter les voix de Drake et de The Weeknd, a été téléchargé sur des services de diffusion en continu, puis rapidement retiré. Universal Music a déposé une plainte sur YouTube et la vidéo du morceau a été retirée. Cet incident a soulevé des questions concernant les droits de la personnalité et l'utilisation non autorisée des voix d'artistes, même si elles sont créées par l'IA. Cette action a créé un précédent sur la manière dont l'industrie pourrait traiter les contenus créés par l'IA qui ressemblent étroitement aux œuvres d'artistes existants.

Pour les artistes, l'IA est une arme à double tranchant. Certains considèrent la technologie comme un outil de collaboration, tandis que d'autres craignent qu'elle ne dévalorise leur art.

Les entreprises musicales sont confrontées à leurs propres défis.

2. Projections du marché

L'IA sur le marché de la musique est sur le point de connaître une croissance significative. Les analystes prévoient que le secteur atteindra 38,7 milliards de dollars d'ici 2033, contre 3,9 milliards de dollars en 2023. Cette multiplication par dix reflète l'adoption généralisée prévue des outils d'IA dans les différents aspects de la production, de la distribution et de la consommation de la musique. Il est intéressant de noter que les artistes recherchent davantage des outils alimentés par l'IA pour la production et le mastering de la musique (66 %) que pour la génération de musique par l'IA (47 %). Les outils favorisant la créativité sont considérés comme plus importants que les outils de génération d'IA pure, même si nous devons nous préparer à écouter de plus en plus d'extraits musicaux générés par l'IA.

II. Transformations potentielles

1. Démocratisation de la production musicale

L'IA abaisse les barrières à l'entrée de la création musicale. Des outils qui nécessitaient autrefois des studios coûteux et des années de formation sont désormais accessibles grâce à des applications conviviales. Cette démocratisation pourrait conduire à une explosion de nouveaux styles musicaux et de nouvelles voix.

Fondateur d'une startup de technologie musicale, Alex Mitchell, PDG de Boomy, imagine un avenir où tout le monde pourra être compositeur. "Aujourd'hui, nous voyons des gens du monde entier créer des chansons instantanées avec Boomy, les publier et même gagner des droits d'auteur. Pour la première fois, l'expression musicale est accessible à un tout nouveau type de créateur et de public". Cette accessibilité pourrait modifier radicalement le paysage musical, en révélant des talents qui n'auraient pas été découverts autrement.

2. Nouvelles interactions entre l'artiste et le public

L'IA est en effet en train de remodeler la manière dont les artistes se connectent à leur public. Certains artistes et plateformes musicales expérimentent déjà des chatbots alimentés par l'IA qui permettent aux fans d'interagir avec leur catalogue musical de manière inédite. Par exemple, Spotify a introduit dans son application un chatbot piloté par l'IA qui interagit avec les utilisateurs pour comprendre leurs préférences musicales, leurs humeurs et leurs habitudes d'écoute. Cela permet au chatbot de créer des listes de lecture personnalisées et de suggérer de nouveaux titres adaptés aux goûts uniques de chaque utilisateur.

Ces chatbots d'IA sont utilisés pour améliorer l'engagement des fans en fournissant des recommandations personnalisées, des mises à jour en temps réel et des expériences interactives. Ils peuvent proposer des mises à jour sur les artistes, recommander des listes de lecture, faciliter l'achat de billets et gérer les demandes de renseignements des fans, favorisant ainsi des liens plus profonds entre les artistes et leur public.

Holly Herndon, une artiste avant-gardiste, a récemment lancé une version IA de sa voix avec laquelle les fans peuvent collaborer pour créer des morceaux personnalisés. Ce mélange de créativité humaine et de capacités de l'IA laisse entrevoir un avenir où la frontière entre l'artiste et le public deviendra de plus en plus fluide.

Une conclusion à multiples facettes

I. Le rôle de l'IA dans la créativité

L'intégration de l'IA dans la création musicale soulève de profondes questions sur la nature de l'art. Si certains affirment que l'IA n'est qu'un outil, comparable à un nouvel instrument, d'autres craignent qu'elle ne diminue l'élément humain qui donne à la musique une résonance émotionnelle.

Marius Blanchard, Data Scientist de l'université de Columbia et travaillant dans l'industrie musicale, offre une perspective équilibrée : "Je ne crois pas que l'IA remplacera jamais les artistes ; [...] le lien entre le public et l'artiste existe à de nombreux niveaux différents, au-delà de la musique. J'espère plutôt que l'IA démocratisera l'accès à une production sonore de qualité et stimulera la créativité d'un nombre croissant d'artistes pour qu'ils puissent exprimer et partager leurs créations."

II. Impact sur les emplois dans l'industrie

À mesure que les capacités de l'IA se développent, certains rôles au sein de l'industrie musicale pourraient évoluer ou devenir obsolètes. Les ingénieurs du son, par exemple, devront peut-être adapter leurs compétences pour travailler avec les outils de mixage et de masterisation de l'IA. Toutefois, de nouvelles catégories d'emplois sont susceptibles d'émerger, comme les programmeurs musicaux en IA ou les consultants en IA éthique pour les industries créatives.

III. Authenticité et connexion émotionnelle

La question la plus importante qui se pose à l'industrie est peut-être de savoir si la musique générée par l'IA peut créer les mêmes liens émotionnels avec les auditeurs que les œuvres créées par l'homme. Si l'IA peut analyser des modèles et créer des compositions techniquement efficaces, la qualité ineffable de l'expérience humaine qui imprègne souvent la grande musique reste difficile à reproduire.

Holly Herndon, musicienne électronique et chercheuse en IA, est optimiste: "Je pense que la meilleure façon d'avancer est que les artistes s'appuient sur les développements de l'apprentissage automatique", a-t-elle déclaré, suggérant qu'ils "réfléchissent à des moyens d'inviter conditionnellement d'autres personnes à expérimenter avec eux".

Références

Jeff Ens et Philippe Pasquier, (2020). MMM : Exploring Conditional Multi-Track

Music Generation with the Transformer. arXiv preprint arXiv:2008.06048 https://arxiv.org/abs/2008.06048

Andrea Agostinelli et al, (2023). MusicLM : Generating Music From Text. arXiv preprint arXiv:2301.11325 https://arxiv.org/abs/2301.11325

Huang et al, (2018). Music Transformer : Generating Music with Long-Term Structure. arXiv preprint arXiv:1809.04281 https://arxiv.org/abs/1809.04281

Ke Chen et al, (2023). MusicLDM : Enhancing Novelty in Text-to-Music Generation Using Beat-Synchronous Mixup Strategies. arXiv preprint arXiv:2308.01546 https://arxiv.org/abs/1809.04281

BLOG

BLOG