Vom Studio zum Streaming: AI Einfluss auf die Gestaltung der Musik und ihre Auswirkungen auf den Markt

AI Die erste dokumentierte Live-Performance, bei der ein Musiker und der Pianist David Dolan (Guildhall School of Music and Drama) im Dialog mit einem halbautonomen AI System des Komponisten Oded Ben-Tal (Kingston University) improvisierten, fand im November 2022 statt. Dieses bahnbrechende Konzert zeigte die kreativen Möglichkeiten von AI als kollaborativer Partner in der Musik. Seitdem haben sich Musiker und sogar Nicht-Musiker die generative AI zu eigen gemacht und vollständige Kompositionen mit Gesang, Instrumenten und sogar Klängen von nicht vorhandenen Instrumenten produziert. Dies markiert den Beginn einer neuen Ära, in der AI das Musikschaffen und die Musikproduktion umgestaltet. Während artificial intelligence weiterhin die Industrie umgestaltet, erlebt die Musikwelt ihre eigene Revolution. Von Hobbyisten bis hin zu großen Plattenfirmen setzen sich alle Beteiligten mit den Auswirkungen dieser Technologie auseinander.

Die Musikindustrie, die seit jeher von technologischen Fortschritten geprägt ist, tritt nun in eine neue Phase der Transformation ein. Angesichts des großen Einflusses der Musikindustrie auf Unterhaltung, Medien und Streaming-Plattformen, auf denen Millionen von Titeln gespeichert sind, verspricht die Integration von AI , die Art und Weise, wie Musik erstellt, produziert und konsumiert wird, neu zu definieren.

Generative AI, die Technologie, die hinter diesem seismischen Wandel steht, hat sich schnell von der akademischen Forschung zu praktischen Anwendungen entwickelt. Modelle wie Music Transformer und MusicLM verschieben die Grenzen des Machbaren und setzen abstrakte Konzepte in harmonische Kompositionen um. Diese Systeme ( AI ), die an riesigen Datensätzen von Musikstücken trainiert wurden, können nun mit erstaunlicher Kompetenz Originalmelodien, Harmonien und sogar ganze Lieder erzeugen.

Doch wie jede technologische Revolution ist auch der Aufstieg von AI in der Musikbranche sowohl mit Aufregung als auch mit Besorgnis verbunden. Künstler und Branchenexperten sind sich über die möglichen Auswirkungen uneins. Einige sehen darin ein mächtiges Werkzeug für Kreativität und Demokratisierung, während andere sich Sorgen über die Auswirkungen auf die menschliche Kunst und die Sicherheit der Arbeitsplätze machen.

Die Landschaft der Musikindustrie ist bereits im Wandel begriffen. Streaming-Plattformen nutzen AI für personalisierte Wiedergabelisten, während Produktionssoftware AI-unterstützte Mixing- und Mastering-Tools einbezieht. Sogar große Plattenfirmen erforschen das Potenzial von AIfür das Talentscouting und die Trendvorhersage.

Während wir in diese neue Ära eintauchen, tauchen viele Fragen auf. Wie wird AI die Rollen von Künstlern, Produzenten und Technikern verändern? Welche rechtlichen und ethischen Überlegungen müssen wir anstellen? Und was vielleicht am wichtigsten ist: Wie wird sich diese Technologie auf die emotionale Verbindung zwischen Musikern und ihren audience auswirken?

In diesem Artikel erkunden wir den aktuellen Stand der generativen AI in der Musik, ihre Anwendungen in verschiedenen Bereichen der Branche und die potenzielle Zukunft, die sie ankündigt. Von der Technologie, die hinter diesen AI Modellen steckt, bis hin zu den praktischen Herausforderungen bei der Markteinführung werden wir untersuchen, wie diese Innovation eine der beliebtesten und einflussreichsten Kreativindustrien der Welt verändern kann.

Mit dem Eintritt der Musikindustrie in die AI-gesteuerte Ära ist es offensichtlich, dass die Komponisten der Zukunft nicht mehr nur Menschen sein werden, was einen bedeutenden Wandel in der Branche darstellt.

1. Die Technologie hinter der generativen AI für Musik

Von der Komposition zum Code: Die Durchbrüche der generativen AI in der Musik

Der Weg von der traditionellen Komposition zur AI-generierten Musik war bahnbrechend. Wir sind mit der Texterzeugung mit chatGPT und der Bilderzeugung mit Stable Diffusion und MidJourney vertraut. Die großen Durchbrüche bei der Musikgenerierung liegen in der Anpassung dieser leistungsstarken Modelle an die Besonderheiten der Musik data.

I. GPT für Musik (diskrete Erzeugung)

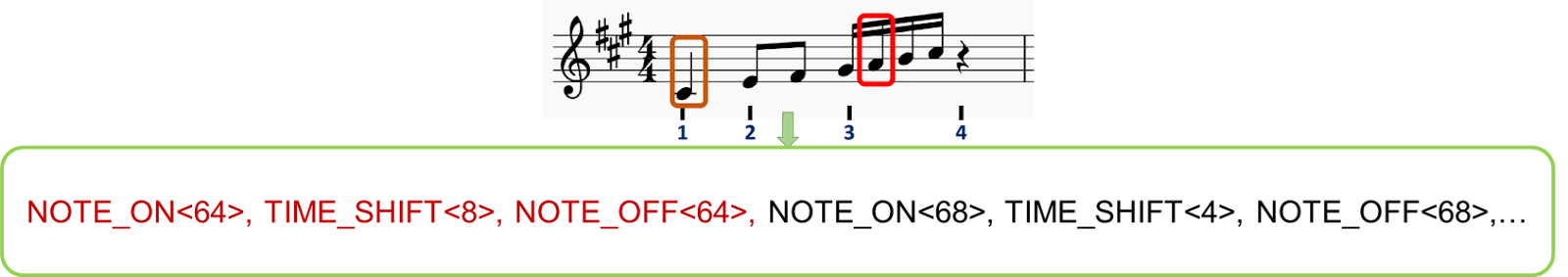

So wie GPT-Modelle Sprache verarbeiten, können ähnliche Prinzipien auf musikalische Elemente angewendet werden. Der Schlüssel liegt in der Tokenisierung - der Zerlegung von Musik in diskrete, handhabbare Einheiten. Der Prozess der Anwendung von GPT-Modellen auf Musik durch Tokenisierung ist ein entscheidender Schritt, der es AI ermöglicht, Musik zu verstehen und zu erzeugen. Hier ist eine ausführlichere Erklärung:

1. Tokenisierung in der Musik: Genauso wie GPT-Modelle Text in Token (Wörter oder Unterwörter) zerlegen, muss Musik in diskrete Einheiten zerlegt werden, die AI verarbeiten kann. Im Folgenden werden zwei Methoden zur Tokenisierung untersucht:

i. Noten können als diskrete Elemente betrachtet werden, die mehrere Informationen enthalten:

a) Tonhöhe: Die spezifische Note, die gespielt wird (z. B. C, D, E, usw.)

b) Dauer: Wie lange die Note gehalten wird (z. B. Viertelnote, halbe Note)

c) Anschlagsstärke: Wie laut oder leise die Note gespielt wird

d) Instrument: Welches Instrument die Note spielt

ii. Beispiel: Eine C4-Note, die über einen Viertelschlag gespielt wird, könnte mit den Token : ; ; dargestellt werden, während eine G3-Note, die über einen halben Schlag gespielt wird, mit ; dargestellt werden könnte;

( wir können Token für Geschwindigkeiten, Taktstrukturen, Instrumente, Genres,... hinzufügen)

iii. Erstellung numerischer Sequenzen:

Diese Serien von Notizen und Token werden dann verkettet und in Sequenzen angeordnet, ähnlich wie Wörter in Sprachmodellen Sätze bilden. Jedem Token wird eine eindeutige numerische ID zugewiesen, so dass das GPT-Modell eine ähnliche Eingabe wie bei der Texterstellung erhält.

iv. Beispiel: Eine musikalische Phrase sieht so aus: [123; 8; 456; 118; 12; 451;...], wobei jede Zahl ein bestimmtes musikalisches Ereignis darstellt.

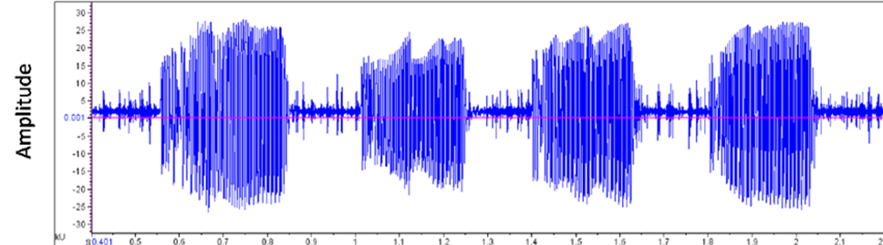

i. Audiodateien werden in Computern in einem Wellenformat gespeichert, das die Amplitude des Signals über die Zeit darstellt. Dies bietet eine umfassendere Darstellung als einfache Notenblätter.

ii. Diese Welle kann mit Hilfe eines trainierten Modells (ähnlich wie BERT für Wortvektoren), das eine tokenisierte Version des Audioinputs erstellt, in Segmente unterteilt werden, die die "Bedeutung der Musik" darstellen.

iii. Die sich daraus ergebenden Vektoren können durch eine gemeinsame Audio- und Texteinbettung konditioniert werden, wodurch Tokens entstehen, die sowohl Audioeigenschaften als auch Textbeschreibungen repräsentieren, so dass der Benutzer während der Inferenz einen Text-Prompt als Eingabe verwenden kann.

2. AI Ausbildung:

3. Generation:

Der Music Transformer, der im Rahmen des Magenta-Projekts von Google entwickelt wurde, war ein wichtiger Meilenstein in diesem Bereich. Er war einer der ersten, der den Aufmerksamkeitsmechanismus des Transformers - ein Eckpfeiler von Sprachmodellen - auf musikalische Sequenzen anwandte und so eine bemerkenswerte Kohärenz in langen Kompositionen erreichte. Andere Modelle folgten, wobei jedes die Grenzen dessen, was AI bei der Musikproduktion erreichen kann, weiter auslotete.

II. Diffusionsmodelle für Musik (Kontinuierliche Erzeugung)

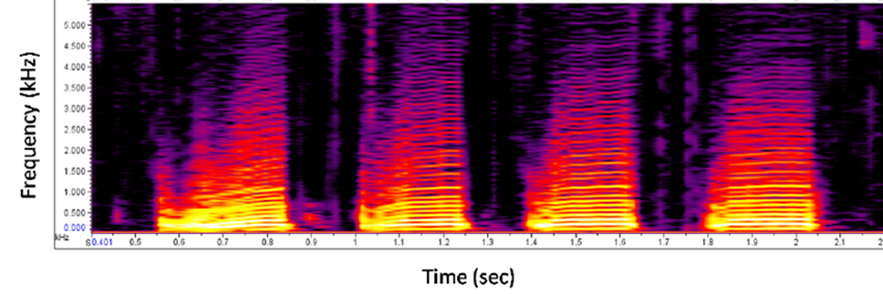

Diffusionsmodelle wie MidJourney oder Stable Diffusion wurden weitgehend übernommen und für die Bilderzeugung verwendet. Die erzeugten Bilder werden immer detaillierter und anpassbarer und zeigen eine große Konsistenz, während sie in einer Eingabeaufforderung Stil- oder Auflösungsdetails hinzufügen. Diese Personalisierung ist auch ein interessantes Merkmal für die Musikgenerierung. Wie können wir Musik in ein Bild verwandeln?

Musik als Bild:

Indem man Spektrogramme als Bilder betrachtet und sie mit einer Textbeschreibung versieht, ist es möglich, eine starke Kontrolle über die Erzeugung zu haben, die es den Benutzern ermöglicht, ihre gewünschte Musik so anzufordern, wie sie es mit MidJourney für Bilder tun würden.

Überbrückung der Kluft zwischen Innovation und Industrie: Herausforderungen bei der AI Musikerzeugung:

Wir haben 2 verschiedene Möglichkeiten zur Erzeugung von Musik mit AI erforscht. Alle diese Technologien haben zu beeindruckenden und unterhaltsamen Demos geführt. Der Weg von Laborexperimenten zu marktreifen Produkten ist jedoch mit Herausforderungen verbunden. Die technischen Hürden sind zahlreich und reichen von der Sicherstellung einer gleichbleibenden Qualität über verschiedene Musikstile hinweg bis hin zur Bewältigung der Rechenanforderungen der Echtzeitgenerierung. Die Marktherausforderungen sind ebenso entmutigend, da die Entwickler damit zu kämpfen haben, die richtigen audience und Anwendungsfälle für ihre AI Komponisten zu finden.

Management- und rechtliche Überlegungen machen die Sache noch komplexer. Der Aufbau und die Leitung von Teams an der Schnittstelle von Musik und AI erfordert eine einzigartige Mischung von Fähigkeiten. Gleichzeitig bleibt die ethische und rechtliche Landschaft weitgehend unerforscht und wirft Fragen zum Urheberrecht, zur Urheberschaft und zum Wesen der Kreativität im Zeitalter von AI auf.

Wenn wir uns eingehender mit den aktuellen Anwendungen und Produkten befassen, die aus dieser technologischen Revolution hervorgehen, wird deutlich, dass die Auswirkungen von AI auf die Musikindustrie weitreichend sein werden und alle Interessengruppen vom Hörer bis zu den großen Plattenfirmen betreffen.

2. Aktuelle Anwendungen und Produkte

Im Zuge der Weiterentwicklung der generativen Technologie AI sind in der Musikindustrie eine Vielzahl von Plattformen und Tools entstanden. Diese Innovationen entwickeln sich von experimentellen Konzepten zu praktischen Anwendungen und bieten jeweils unterschiedliche Fähigkeiten und Einsatzmöglichkeiten.

I. Die heute am häufigsten verwendeten: Suno.AI

In der Landschaft der AI Musikproduktion hat Suno.AI große Aufmerksamkeit erlangt. Die Plattform ermöglicht es den Nutzern, Musik anhand von Textaufforderungen zu erstellen und komplette Songs mit Gesang, Instrumenten und Texten in verschiedenen Genres und Stilen zu generieren.

Suno.AI hat eine Nutzerbasis von 12 Millionen und erfolgreiche Finanzierungsrunden abgeschlossen und eine Bewertung von 500 Millionen Dollar erreicht. Die Plattform bietet sowohl kostenlose als auch kostenpflichtige Versionen an, wobei die kostenlose Version den Nutzern erlaubt, eine begrenzte Anzahl von Songs pro Tag zu erstellen. Die Anwendungen reichen von Filmtrailer-Mockups bis hin zu Soundtracks für Videospiele.

Ein Filmemacher, der an einem Kurzfilm arbeitet, könnte Suno.AI nutzen, um einen individuellen Soundtrack zu erstellen, wenn er keinen Komponisten einstellen kann. Werbeagenturen erkunden die Plattform, um schnell Jingles und Hintergrundmusik für Werbespots zu erstellen, was ihren Arbeitsablauf für Musik in der Werbung verändern könnte.

II. Andere AI Musikplattformen

Während Suno.AI Aufmerksamkeit erregt hat, ist es Teil eines wachsenden Ökosystems von AI Musikplattformen.

Da sich diese Plattformen weiterentwickeln und neue entstehen, werden die Anwendungen von AI in der Musik immer vielfältiger. Von einzelnen Musikschaffenden bis hin zu großen Unternehmen reichen die potenziellen Einsatzmöglichkeiten, was auf eine Zukunft hindeutet, in der AI eine immer wichtigere Rolle bei der Schaffung und Produktion von Musik spielen könnte.

3. Auswirkungen auf verschiedene Stakeholder

Die Entwicklung der generativen Technologie AI wirkt sich auf alle Bereiche der Musikindustrie aus. Von den Hörern bis hin zu den großen Plattenfirmen erlebt jede Gruppe einen Wandel in ihrer Beziehung zur Musikproduktion und zum Musikkonsum. Während einige diese Veränderungen mit Sorge betrachten, sehen andere sie als die natürliche Entwicklung einer Branche, die schon immer von technologischen Fortschritten geprägt war.

I. Hörer

Die Reise der Musikkonsumenten ist eine Reise der zunehmenden Personalisierung und Entdeckung. Vor AI verließen sich die Hörer auf Radio-DJs, Musikzeitschriften und Mundpropaganda, um neue Musik zu entdecken. Playlists wurden mühsam von Hand zusammengestellt und waren oft durch persönliche Musikbibliotheken begrenzt.

Mit dem Aufkommen von AI führten Plattformen wie Spotify im Juli 2015 Funktionen wie Discover Weekly ein, die Algorithmen nutzen, um Hörgewohnheiten zu analysieren und neue Titel vorzuschlagen. Dies bedeutete einen bedeutenden Sprung in der personalisierten Musikentdeckung und machte die Hörer mit einer breiteren Palette von Künstlern und Genres bekannt.

Jetzt, mit der generativen AI, stehen wir an der Schwelle zu einem noch besser zugeschnittenen Erlebnis. LifeScore ist ein System, das nicht nur bestehende Musik empfiehlt, sondern auch neue Kompositionen auf der Grundlage der Stimmung, der Aktivität oder sogar der biometrischen Daten des Hörers erstellt data. Für einen Jogger könnte ein maßgeschneiderter Soundtrack in Echtzeit generiert werden, der sich an sein Tempo und seine Herzfrequenz anpasst und seine Lieblingsgenres zu etwas völlig Neuem verbindet.

II. Künstler

Für Musiker war der kreative Prozess schon immer von den verfügbaren Werkzeugen und Technologien beeinflusst. Vor AI stützte sich die Komposition stark auf traditionelle Instrumente und Aufnahmetechniken. Die Einführung von Synthesizern und digitalen Audio-Workstations (DAWs) im späten 20. Jahrhundert begann bereits, die Art und Weise, wie Musik geschaffen wurde, zu verändern. Jean-Michel Jarre, ein früher Pionier der elektronischen Musik , bemerkte dazu: "Die Technologie hat schon immer die Stile diktiert und nicht andersherum. Weil wir die Geige erfunden haben, hat Vivaldi die Musik gemacht, die er gemacht hat... Für mich ist AI nicht notwendigerweise eine Gefahr, wenn sie gut genutzt wird".

Kompositionssoftware kann Akkordfolgen oder Melodien vorschlagen und so als Kooperationspartner im kreativen Prozess dienen.

Mit dem generativen AI können wir das Aufkommen von AI Co-Writing beobachten. Künstler können nun eine Grundmelodie oder eine Textidee eingeben und ein AI System ergänzende Elemente generieren lassen, die möglicherweise neue kreative Richtungen einschlagen. Einige Musiker experimentieren sogar mit Stilanpassungen in Echtzeit bei Live-Auftritten, indem sie AI nutzen, um ihren Sound auf der Grundlage der Reaktionen von audience zu verändern.

Für Laienkünstler gibt es mehrere Schulungs-Apps, die AI nutzen, um interaktive und personalisierte Lernerfahrungen in Echtzeit anzubieten. Mit anderen Tools, die es ermöglichen, Arrangements und Bands zu simulieren, werden die Lernkosten für Kreativität gesenkt und mehr Menschen können Musik spielen und genießen.

III. Ingenieure

Die Rolle des Toningenieurs ist von einer ständigen Anpassung an neue Technologien geprägt. Traditionell waren Abmischung und Mastering rein manuelle Prozesse, die ein scharfes Ohr und jahrelange Erfahrung erforderten. Für diesen Artikel befragt, sagte Marius Blanchard, Data Scientist bei Spotify: "AI ist nicht dazu da, um Musiker zu ersetzen, sondern um sie zu befähigen. Es ist ein Werkzeug, das Künstlern helfen kann, neue kreative Territorien zu erkunden und die Grenzen der Musikproduktion zu erweitern."

AI hat in diesem Bereich bereits Fortschritte gemacht, denn Tools wie Neutron von iZotope bieten intelligente Unterstützung beim Mischen. Diese Systeme können einen Track analysieren und EQ-Einstellungen, Kompressionsstufen und andere Parameter vorschlagen, um den Mischprozess zu optimieren.

Da die generative Technologie AI immer ausgefeilter wird, werden wir vielleicht vollautomatische Misch- und Mastering-Systeme sehen, die ein ganzes Album mit minimalen menschlichen Eingriffen bearbeiten können. Viele in der Branche argumentieren jedoch, dass die menschliche Note immer notwendig sein wird, um die emotionalen Nuancen einer Performance einzufangen.

IV. Musik- und Plattformunternehmen

Plattenfirmen und Musikverlage haben sich lange Zeit auf menschliche Intuition und Marktforschung verlassen, um Trends zu erkennen und neue Talente zu entdecken. A&R-Manager (Artists and Repertoire) durchforsteten Clubs und Demobänder auf der Suche nach dem nächsten großen Ding.

Durch die Integration von AI hat sich dieser Prozess hin zu einer data Entscheidungsfindung verlagert. Plattformen analysieren data, Social-Media-Engagement und andere Metriken, um aufstrebende Künstler zu identifizieren und ihr Hitpotenzial vorherzusagen.

Mit der generativen AI erforschen Musikunternehmen sogar noch radikalere Möglichkeiten. Einige experimentieren mit AI Systemen, die Musik generieren können, die auf bestimmte Marktsegmente oder Demografien zugeschnitten ist. Andere nutzen Vorhersagemodelle, um zu prognostizieren, welche Songstrukturen oder lyrischen Themen in den kommenden Monaten beim Publikum ankommen werden.

Während sich die Branche mit diesen Veränderungen auseinandersetzt, bleibt die Schlüsselfrage bestehen: Wie wird sich das Gleichgewicht zwischen menschlicher Kreativität und AI Unterstützung entwickeln? Während die einen den Verlust der menschlichen Note bei der Musikproduktion befürchten, sehen andere AI als ein Werkzeug, das letztlich die menschliche Kreativität fördert und neue Wege für Ausdruck und Zusammenarbeit eröffnet.

4. Zukunftsvisionen und Chancen

Während die generative AI die Musikindustrie umgestaltet, müssen sich die Beteiligten mit einer komplexen Landschaft rechtlicher, wirtschaftlicher und ethischer Überlegungen auseinandersetzen. Diese transformative Technologie verspricht eine Demokratisierung des Musikschaffens und stellt gleichzeitig traditionelle Vorstellungen von Kunst und Urheberrecht in Frage.

I. Rechtliche und marktwirtschaftliche Erwägungen

1. Urheberrecht im Zeitalter der AI

Vor dem Aufkommen von AIwaren die Urheberrechtsgesetze für Musik relativ einfach. Komponisten und Interpreten besaßen die Rechte an ihren Originalwerken, und es gab klare Richtlinien für Sampling und faire Nutzung. Mit der Einführung von AI-generierter Musik haben sich diese Grenzen jedoch erheblich verwischt.

In den USA erstreckt sich der Urheberrechtsschutz auf Originalwerke, während die europäische Doktrin die persönliche Note des Schöpfers betont. Diese Unterscheidung wird entscheidend, wenn es um AI-generierte Musik geht. Das US-Urheberrechtsamt hat erklärt, dass es keine Werke registrieren wird, die von einer Maschine oder einem rein mechanischen Prozess erzeugt werden, der zufällig oder automatisch ohne schöpferischen Beitrag oder Eingriff eines menschlichen Urhebers funktioniert.

Im Jahr 2023 gab es mindestens einen aufsehenerregenden Fall, der die urheberrechtlichen Bedenken in Bezug auf AI-generierte Musik, die bekannte Künstler imitiert, deutlich machte. Ein Titel namens "Heart on My Sleeve", bei dem AI die Stimmen von Drake und The Weeknd nachahmte, wurde auf Streaming-Dienste hochgeladen und dann umgehend entfernt. Universal Music reichte eine Klage bei YouTube ein, woraufhin das Video des Titels vom Netz genommen wurde. Dieser Vorfall warf Fragen zu Persönlichkeitsrechten und der unerlaubten Verwendung von Künstlerstimmen auf, selbst wenn diese über AI erstellt wurden. Diese Aktion schuf einen Präzedenzfall dafür, wie die Branche mit AI erstellten Inhalten umgehen könnte, die den Werken bestehender Künstler sehr ähnlich sind.

Für Künstler ist AI ein zweischneidiges Schwert. Einige begrüßen die Technologie als Instrument der Zusammenarbeit, während andere befürchten, dass sie ihr Handwerk entwerten könnte.

Musikunternehmen stehen vor ihren eigenen Herausforderungen.

2. Marktprojektionen

AI auf dem Musikmarkt steht ein erhebliches Wachstum bevor. Branchenanalysten gehen davon aus, dass der Sektor bis 2033 ein Volumen von 38,7 Mrd. USD erreichen wird, gegenüber 3,9 Mrd. USD im Jahr 2023. Dieser zehnfache Anstieg spiegelt die erwartete breite Akzeptanz von AI in verschiedenen Bereichen der Musikproduktion, des Vertriebs und des Konsums wider. Interessanterweise suchen Künstler eher nach AI gestützten Tools für die Musikproduktion und das Musik-Mastering (66 %) als für die AI Musikerzeugung (47 %). Kreativitätsfördernde Werkzeuge werden als wichtiger angesehen als reine AI-Generierungswerkzeuge, auch wenn wir uns darauf einstellen müssen, immer mehr AI-generierte Musikausschnitte zu hören.

II. Mögliche Umwandlungen

1. Demokratisierung der Musikproduktion

AI senkt die Einstiegshürden für die Musikproduktion. Werkzeuge, die früher teure Studios und eine jahrelange Ausbildung erforderten, sind jetzt über benutzerfreundliche Apps zugänglich. Diese Demokratisierung könnte zu einer Explosion neuer Musikstile und Stimmen führen.

Alex Mitchell, CEO von Boomy, Gründer eines Musiktechnologie-Startups, stellt sich eine Zukunft vor, in der jeder ein Komponist sein kann. "Jetzt sehen wir, wie Menschen auf der ganzen Welt mit Boomy sofort Songs erstellen, sie veröffentlichen und sogar Tantiemen verdienen. Zum ersten Mal ist der musikalische Ausdruck für eine völlig neue Art von Urhebern und audience zugänglich. Diese Zugänglichkeit könnte die Musiklandschaft grundlegend verändern und möglicherweise Talente ans Tageslicht bringen, die sonst vielleicht unentdeckt geblieben wären.

2. Neue Künstler -Audience Interaktionen

AI verändert in der Tat die Art und Weise, wie Künstler mit ihren audience in Kontakt treten. Einige Künstler und Musikplattformen experimentieren bereits mit AI-gesteuerten Chatbots, die es Fans ermöglichen, auf neuartige Weise mit ihrem Musikkatalog zu interagieren. Spotify hat zum Beispiel einen AI-gesteuerten Chatbot in seine Anwendung integriert, der mit den Nutzern interagiert, um ihre Musikvorlieben, Stimmungen und Hörgewohnheiten zu verstehen. So kann der Chatbot individuelle Wiedergabelisten zusammenstellen und neue Titel vorschlagen, die auf den individuellen Geschmack des Nutzers zugeschnitten sind.

Diese AI Chatbots werden eingesetzt, um das Engagement der Fans zu verbessern, indem sie personalisierte Empfehlungen, Echtzeit-Updates und interaktive Erfahrungen bieten. Sie können Künstler-Updates anbieten, Playlists empfehlen, Ticketkäufe erleichtern und Fananfragen verwalten und so eine tiefere Verbindung zwischen Künstlern und ihren audience fördern.

Eine vorausschauende Künstlerin, Holly Herndon, hat vor kurzem eine AI Version ihrer Stimme auf den Markt gebracht, mit der Fans zusammenarbeiten können, um personalisierte Tracks zu erstellen. Diese Verschmelzung von menschlicher Kreativität und den Möglichkeiten von AI weist auf eine Zukunft hin, in der die Grenzen zwischen Künstler und audience zunehmend fließend werden.

Eine vielschichtige Schlussfolgerung

I. AIDie Rolle der Kreativität

Die Integration von AI in die Musikproduktion wirft tiefgreifende Fragen über das Wesen der Kunst auf. Während einige argumentieren, dass AI lediglich ein Werkzeug ist, ähnlich wie ein neues Instrument, befürchten andere, dass es das menschliche Element, das der Musik eine emotionale Resonanz verleiht, schwächt.

Marius Blanchard, Data Wissenschaftler von der Columbia University und in der Musikindustrie tätig, bietet eine ausgewogene Perspektive: "Ich glaube nicht, dass AI jemals Künstler ersetzen wird; [...] die Verbindung audience- Künstler lebt auf vielen verschiedenen Ebenen über die Musik hinaus. Stattdessen hoffe ich, dass AI den Zugang zu qualitativ hochwertiger Klangproduktion demokratisiert und mehr und mehr Künstlern einen Kreativitätsschub gibt, damit sie ihre Kreationen ausdrücken und teilen können."

II. Auswirkungen auf die Arbeitsplätze in der Industrie

Mit den wachsenden Möglichkeiten von AI können sich bestimmte Funktionen in der Musikindustrie verändern oder überflüssig werden. Toningenieure beispielsweise müssen ihre Fähigkeiten möglicherweise an die Arbeit mit AI Mixing- und Mastering-Tools anpassen. Es werden aber wahrscheinlich auch neue Berufskategorien entstehen, wie AI Musikprogrammierer oder ethische AI Berater für die Kreativbranche.

III. Authentizität und emotionale Bindung

Die vielleicht wichtigste Frage, mit der sich die Branche konfrontiert sieht, ist, ob die von AI erzeugte Musik die gleichen emotionalen Verbindungen zu den Zuhörern herstellen kann wie von Menschen geschaffene Werke. Während AI Muster analysieren und technisch versierte Kompositionen erstellen kann, bleibt es eine Herausforderung, die unaussprechliche Qualität menschlicher Erfahrung, die große Musik oft durchdringt, zu reproduzieren.

Die elektronische Musikerin und Forscherin Holly Herndon ( AI ) ist optimistisch: "Ich denke, der beste Weg nach vorne ist, dass Künstler sich an die Entwicklungen des maschinellen Lernens anlehnen", sagt sie und schlägt vor, dass sie "Wege finden, andere bedingt zum Experimentieren mit ihnen einzuladen".

Referenzen

Jeff Ens und Philippe Pasquier, (2020). MMM : Erforschung der bedingten Mehrspur

Music Generation with the Transformer. arXiv preprint arXiv:2008.06048 https://arxiv.org/abs/2008.06048

Andrea Agostinelli et al, (2023). MusicLM: Generating Music From Text. arXiv preprint arXiv:2301.11325 https://arxiv.org/abs/2301.11325

Huang et al, (2018). Music Transformer: Generating Music with Long-Term Structure. arXiv preprint arXiv:1809.04281 https://arxiv.org/abs/1809.04281

Ke Chen et al, (2023). MusicLDM: Enhancing Novelty in Text-to-Music Generation Using Beat-Synchronous Mixup Strategies. arXiv preprint arXiv:2308.01546 https://arxiv.org/abs/1809.04281

BLOG

BLOG