Del estudio al streaming: AI Influencia en la configuración de la música y su impacto en el mercado

La primera actuación en directo documentada en la que se mezclaron un sistema generativo AI y un músico tuvo lugar en noviembre de 2022, cuando el pianista David Dolan (Guildhall School of Music and Drama) improvisó en diálogo con un sistema semiautónomo AI diseñado por el compositor Oded Ben-Tal (Universidad de Kingston). Este concierto pionero demostró las posibilidades creativas de AI como socio colaborador en la música. Desde entonces, músicos e incluso no músicos han adoptado el sistema generativo AI, produciendo composiciones completas con voces, instrumentos e incluso sonidos de instrumentos inexistentes. Esto marca el comienzo de una nueva era en la que AI está remodelando la creación y producción musical. Mientras Inteligencia Artificial sigue transformando industrias, el mundo de la música experimenta su propia revolución. Desde los aficionados a los grandes sellos discográficos, todos los agentes del sector se enfrentan a las implicaciones de esta tecnología.

La industria musical, históricamente moldeada por los avances tecnológicos, está entrando en una nueva fase de transformación. Con la amplia repercusión de la industria musical en el entretenimiento, los medios de comunicación y las plataformas de streaming que albergan millones de canciones, la integración de AI promete redefinir la forma de crear, producir y consumir música.

Generative AI, la tecnología que está detrás de este cambio sísmico, ha evolucionado rápidamente de la investigación académica a las aplicaciones prácticas. Modelos como Music Transformer y MusicLM están ampliando los límites de lo posible, traduciendo conceptos abstractos en composiciones armoniosas. Estos sistemas de AI , entrenados en vastos conjuntos de datos de piezas musicales, pueden ahora generar melodías originales, armonías e incluso canciones enteras con asombrosa destreza.

Sin embargo, como ocurre con cualquier revolución tecnológica, el auge de AI en la música suscita tanto entusiasmo como ansiedad. Los artistas y los profesionales del sector están divididos sobre su posible impacto. Algunos lo ven como una poderosa herramienta de creatividad y democratización, mientras que a otros les preocupan las implicaciones para el arte humano y la seguridad laboral.

El panorama de la industria musical ya está cambiando. Las plataformas de streaming aprovechan AI para crear listas de reproducción personalizadas, mientras que los programas de producción incorporan herramientas de mezcla y masterización asistidas por AI. Incluso los grandes sellos discográficos están explorando el potencial de AIpara la búsqueda de talentos y la predicción de tendencias.

A medida que nos adentramos en esta nueva era, abundan las preguntas. ¿Cómo modificará AI las funciones de artistas, productores e ingenieros? ¿Qué consideraciones legales y éticas debemos tener en cuenta? Y quizá lo más importante, ¿cómo afectará esta tecnología a la conexión emocional entre los músicos y su Audiencia?

En este artículo analizaremos el estado actual de la tecnología generativa AI en la música, sus aplicaciones en distintos sectores de la industria y el futuro potencial que anuncia. Desde la tecnología que hay detrás de estos modelos de AI hasta los retos prácticos que plantea su comercialización, examinaremos cómo esta innovación está llamada a transformar una de las industrias creativas más queridas e influyentes del mundo.

A medida que la industria musical se adentra en esta era impulsada por AI, es evidente que los futuros compositores podrían no ser únicamente humanos, lo que supone un cambio significativo a medida que la industria navega por esta nueva frontera.

1. La tecnología de la música generativa AI

De la composición al código: Los avances de la música generativa AI

El paso de la composición tradicional a la música generada por AI ha sido todo un hito. Estamos familiarizados con la generación de textos mediante chatGPT y la generación de imágenes con Stable diffusion y MidJourney. Los mayores avances en la generación de música residen en la adaptación de esos potentes modelos a las especificidades de la música data.

I. GPT para Música (generación discreta)

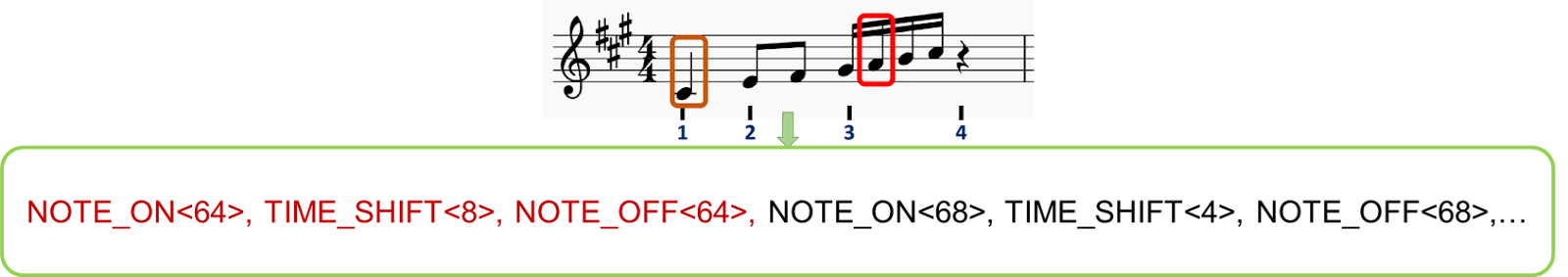

Al igual que los modelos GPT procesan el lenguaje, pueden aplicarse principios similares a los elementos musicales. La clave está en la tokenización, es decir, en dividir la música en unidades discretas y manejables. El proceso de aplicación de los modelos GPT a la música mediante la tokenización es un paso crucial para que AI pueda comprender y generar música. Aquí tienes una explicación más detallada:

1. Tokenización de la música: Del mismo modo que los modelos GPT dividen el texto en tokens (palabras o subpalabras), la música debe dividirse en unidades discretas que AI pueda procesar. A continuación exploramos dos métodos de tokenización:

i. Las notas pueden considerarse elementos discretos que contienen información múltiple:

a) Tono: La nota específica que se está tocando (por ejemplo, Do, Re, Mi, etc.)

b) Duración: El tiempo que se mantiene la nota (por ejemplo, negra, blanca).

c) Velocidad: Intensidad o suavidad con la que se toca la nota.

d) Instrumento: Instrumento que toca la nota

ii. Ejemplo : una nota C4 tocada durante un cuarto de tiempo podría representarse con tokens : ; ; , mientras que una nota G3 tocada durante medio tiempo podría tokenizarse en ; ;

( podemos añadir tokens para velocidades, estructuras de compás, instrumentos, géneros,...)

iii. Creación de secuencias numéricas:

Estas series de notas-tokens se concatenan y ordenan en secuencias, de forma similar a como las palabras forman frases en los modelos lingüísticos. A cada token se le asigna un ID numérico único, lo que permite al modelo GPT recibir una entrada similar a la de la generación de texto.

iv. Ejemplo : Una frase musical tiene el aspecto siguiente [123; 8; 456; 118; 12; 451;...] donde cada número representa un evento musical específico.

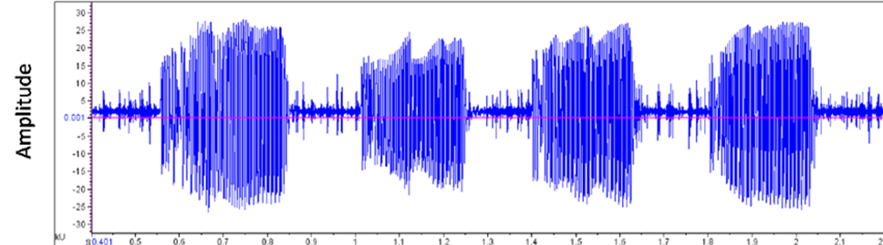

i. Los archivos de audio se almacenan en los ordenadores en formato de onda, que representa la amplitud de la señal a lo largo del tiempo. Lo que proporciona una representación más rica que las simples partituras.

ii. Esta onda puede dividirse en segmentos que representen el "significado de la música" utilizando un modelo entrenado (similar al BERT para vectores de palabras) que crea una versión tokenizada de la entrada de audio.

iii. Los vectores resultantes pueden condicionarse mediante una incrustación conjunta de audio y texto, creando tokens que representen tanto las características de audio como la descripción textual, lo que permite al usuario utilizar un texto-pista como entrada durante la inferencia.

2. AI formación:

3. Generación:

Music Transformer, desarrollado por el proyecto Magenta de Google, marcó un hito importante en este campo. Al ser uno de los primeros en aplicar el mecanismo de atención de Transformer -piedra angular de los modelos lingüísticos- a secuencias musicales, consiguió una notable coherencia en composiciones largas. Otros modelos siguieron su ejemplo, cada uno de ellos ampliando los límites de lo que AI podía lograr en la creación musical.

II. Modelos de difusión de la música (generación continua)

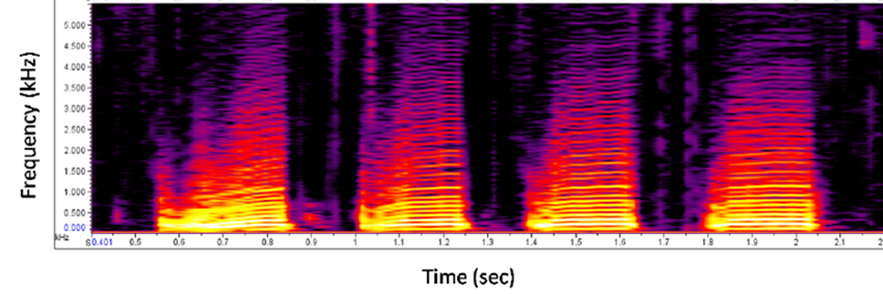

Los modelos de difusión, como MidJourney o Stable Diffusion, han sido ampliamente adoptados y utilizados para la generación de imágenes. Las imágenes generadas son cada vez más detalladas y personalizables, mostrando una gran coherencia al tiempo que se añaden detalles de estilo o resolución en un aviso. Esta personalización es una característica interesante también para la generación de música. ¿Cómo podemos convertir la música en una imagen?

La música como imagen:

Al considerar los espectrogramas como imágenes y alinearlos con una descripción de texto, es posible tener un potente control sobre la generación, permitiendo a los usuarios indicar la música que desean como harían con las imágenes con MidJourney.

Acortando distancias entre la innovación y la industria: Retos de la generación de música en AI :

Hemos explorado 2 formas diferentes de generar música utilizando AI. Todas estas tecnologías han dado lugar a demostraciones impresionantes y entretenidas. Sin embargo, el camino desde los experimentos de laboratorio hasta los productos listos para el mercado está plagado de retos. Abundan los obstáculos técnicos, desde garantizar una calidad uniforme en distintos estilos musicales hasta gestionar las exigencias informáticas de la generación en tiempo real. Los retos del mercado son igualmente desalentadores, ya que los desarrolladores se esfuerzan por encontrar la dirección Audiencia y los casos de uso adecuados para sus compositores AI .

Las consideraciones legales y de gestión añaden complejidad. Crear y dirigir equipos en la intersección de la música y AI requiere una combinación única de habilidades. Mientras tanto, el panorama ético y jurídico sigue siendo en gran medida inexplorado, planteando cuestiones sobre los derechos de autor, la autoría y la propia naturaleza de la creatividad en la era de AI.

A medida que profundizamos en las aplicaciones y productos que están surgiendo de esta revolución tecnológica, queda claro que el impacto de AI en la industria musical será de gran alcance y afectará a todas las partes interesadas, desde los oyentes hasta los grandes sellos discográficos.

2. Aplicaciones y productos actuales

A medida que AI generativa sigue desarrollándose, han surgido diversas plataformas y herramientas en la industria musical. Estas innovaciones están pasando de conceptos experimentales a aplicaciones prácticas, y cada una de ellas ofrece distintas capacidades y usos potenciales.

I. El más utilizado en la actualidad: Suno.AI

En el panorama de la generación de música AI , Suno.AI ha acaparado una gran atención. La plataforma permite a los usuarios crear música a partir de mensajes de texto, generando canciones completas con voz, instrumentación y letra de diversos géneros y estilos.

Suno.AI ha registrado una base de usuarios de 12 millones y ha completado con éxito rondas de financiación, alcanzando una valoración de 500 millones de dólares. La plataforma Servicios es gratuita y de pago. La versión gratuita permite a los usuarios crear un número limitado de canciones al día. Sus aplicaciones abarcan desde maquetas de tráilers de películas hasta bandas sonoras de videojuegos.

Un cineasta que trabaje en un cortometraje puede utilizar Suno.AI para generar una banda sonora personalizada cuando no pueda contratar a un compositor. Las agencias de publicidad están explorando la plataforma para crear rápidamente jingles y música de fondo para anuncios, lo que podría alterar su flujo de trabajo para la música en publicidad.

II. Otras plataformas musicales AI

Aunque Suno.AI ha acaparado la atención, forma parte de un creciente ecosistema de plataformas musicales AI .

A medida que estas plataformas evolucionan y surgen otras nuevas, las aplicaciones de AI en la música siguen diversificándose. Desde creadores individuales hasta grandes corporaciones, los usos potenciales abarcan un amplio abanico, lo que indica un futuro en el que AI podría desempeñar un papel cada vez más significativo en la creación y producción musical.

3. Impacto en las distintas partes interesadas

A medida que la web generativa AI sigue evolucionando, su impacto repercute en todas las facetas de la industria musical. Desde los oyentes hasta los grandes sellos discográficos, cada grupo está experimentando un cambio en su relación con la creación y el consumo de música. Mientras algunos ven estos cambios con inquietud, otros los consideran la progresión natural de una industria que siempre ha estado marcada por los avances tecnológicos.

I. Oyentes

El viaje de los consumidores de música se ha caracterizado por una personalización y un descubrimiento cada vez mayores. Antes de AI, los oyentes dependían de los DJ de radio, las revistas musicales y el boca a boca para descubrir nueva música. Las listas de reproducción se elaboraban minuciosamente a mano, a menudo limitadas por las bibliotecas musicales personales.

Con la llegada de AI, plataformas como Spotify introdujeron en julio de 2015 funciones como Discover Weekly, que utilizan algoritmos para analizar los hábitos de escucha y sugerir nuevas canciones. Esto supuso un salto significativo en el descubrimiento personalizado de música, exponiendo a los oyentes a una gama más amplia de artistas y géneros.

Ahora, con la tecnología generativa AI, estamos a punto de conseguir una experiencia aún más personalizada. LifeScore es un sistema que no sólo recomienda la música existente, sino que crea nuevas composiciones basadas en el estado de ánimo, la actividad o incluso la biometría del oyente data. Un corredor puede tener una banda sonora personalizada generada en tiempo real, que se adapta a su ritmo y frecuencia cardiaca, mezclando sus géneros favoritos en algo totalmente nuevo.

II. Artistas

Para los músicos, el proceso creativo siempre ha estado influido por las herramientas y tecnologías disponibles. Antes de AI, la composición dependía en gran medida de los instrumentos tradicionales y las técnicas de grabación. La introducción de sintetizadores y estaciones de trabajo de audio digital (DAW) a finales del siglo XX empezó a cambiar la forma de crear música. Como señaló Jean-Michel Jarre, uno de los pioneros de la música electrónica: "La tecnología siempre ha dictado los estilos y no al revés. Vivaldi hizo la música que hizo porque inventamos el violín... Para mí, AI no es necesariamente un peligro si se utiliza bien".

Los programas de composición pueden sugerir progresiones de acordes o melodías y colaborar en el proceso creativo.

Con AI generativo, estamos asistiendo a la aparición de la co-escritura en AI . Ahora, los artistas pueden introducir una melodía básica o una idea lírica y hacer que un sistema AI genere elementos complementarios, lo que puede desencadenar nuevas direcciones creativas. Algunos músicos están incluso experimentando con la adaptación del estilo en tiempo real durante las actuaciones en directo, utilizando AI para transformar su sonido sobre la marcha basándose en las reacciones de Audiencia .

Para los artistas aficionados, múltiples apps de formación están aprovechando AI para proponer experiencias de aprendizaje en tiempo real, interactivas y personalizadas. Con otras herramientas que permiten simular arreglos y bandas, se reduce el coste de aprendizaje de la creatividad, lo que permite a más gente tocar y disfrutar de la música.

III. Ingenieros

La función de los ingenieros de sonido ha sido adaptarse constantemente a las nuevas tecnologías. Tradicionalmente, la mezcla y la masterización eran procesos totalmente manuales, que requerían un oído agudo y años de experiencia. Interrogado para este artículo, Marius Blanchard, Data Scientist at Spotify's mencionó: "AI no está aquí para sustituir a los músicos, sino para darles poder. Es una herramienta que puede ayudar a los artistas a explorar nuevos territorios creativos y ampliar los límites de la creación musical."

AI ya ha hecho incursiones en este campo, con herramientas como Neutron, de iZotope, que ofrece asistencia inteligente para mezclar. Estos sistemas pueden analizar una pista y sugerir ajustes de ecualización, niveles de compresión y otros parámetros, agilizando el proceso de mezcla.

A medida que el sistema generativo AI se vuelva más sofisticado, es posible que veamos sistemas de mezcla y masterización totalmente automatizados capaces de procesar un álbum entero con una intervención humana mínima. Sin embargo, muchos en la industria sostienen que el toque humano siempre será necesario para captar los matices emocionales de una actuación.

IV. Empresas musicales y plataformas

Los sellos discográficos y los editores de música han confiado durante mucho tiempo en la intuición humana y los estudios de mercado para detectar tendencias y descubrir nuevos talentos. Los ejecutivos de A&R (Artistas y Repertorio) rastreaban clubes y maquetas en busca de la próxima gran novedad.

La integración de AI ha desplazado este proceso hacia la toma de decisiones data. Las plataformas analizan data streaming, la participación en las redes sociales y otras métricas para identificar a los artistas en alza y predecir su potencial de éxito.

Con AI, las empresas musicales exploran posibilidades aún más radicales. Algunas están experimentando con sistemas AI que pueden generar música adaptada a segmentos de mercado o demográficos específicos. Otras utilizan modelos predictivos para prever qué estructuras de canciones o temas líricos resonarán probablemente entre el público en los próximos meses.

Mientras la industria se enfrenta a estos cambios, la pregunta clave sigue siendo: ¿Cómo evolucionará el equilibrio entre la creatividad humana y la asistencia de AI ? Mientras algunos temen la pérdida del toque humano en la creación musical, otros ven en AI una herramienta que, en última instancia, potenciará la creatividad humana, abriendo nuevas vías de expresión y colaboración.

4. Visiones de futuro y oportunidades

A medida que la tecnología generativa AI sigue transformando la industria musical, las partes interesadas se enfrentan a un complejo panorama de consideraciones jurídicas, económicas y éticas. Esta tecnología transformadora promete democratizar la creación musical al tiempo que desafía las nociones tradicionales de arte y derechos de autor.

I. Consideraciones jurídicas y de mercado

1. Los derechos de autor en la era AI

Antes de la aparición de AI, la legislación sobre derechos de autor en la música era relativamente sencilla. Los compositores e intérpretes tenían derechos sobre sus obras originales, con directrices claras sobre el muestreo y el uso justo. Sin embargo, la introducción de la música generada por AI ha desdibujado considerablemente estas líneas.

En Estados Unidos, la protección de los derechos de autor se extiende a las obras originales, mientras que la doctrina europea hace hincapié en el toque personal del creador. Esta distinción resulta crucial al considerar la música generada por AI. La Oficina de Derechos de Autor de EE.UU. ha declarado que no registrará las obras producidas por una máquina o un mero proceso mecánico que funcione de forma aleatoria o automática sin aportación creativa o intervención de un autor humano.

En 2023, al menos un caso muy sonado puso de manifiesto los problemas de derechos de autor en torno a la música generada por AI que imitaba a artistas populares. Un tema llamado "Heart on My Sleeve" que utilizaba AI para imitar las voces de Drake y The Weeknd se subió a los servicios de streaming y se retiró inmediatamente. Universal Music presentó una reclamación en YouTube, y el vídeo de la canción fue retirado. Este incidente planteó cuestiones en torno a los derechos de la personalidad y el uso no autorizado de las voces de los artistas, incluso si se han creado a través de AI . Esta acción sentó un precedente sobre cómo la industria podría tratar los contenidos creados a través de AI que se asemejan mucho al trabajo de artistas existentes.

Para los artistas, AI es un arma de doble filo. Algunos aceptan la tecnología como una herramienta de colaboración, mientras que otros temen que pueda devaluar su oficio.

Las empresas musicales se enfrentan a sus propios retos.

2. Proyecciones de mercado

AI en el mercado de la música está preparado para un crecimiento significativo. Los analistas de la industria prevén que el sector alcance los 38.700 millones de dólares en 2033, frente a los 3.900 millones de 2023. Esta multiplicación por diez refleja la adopción generalizada prevista de las herramientas de AI en diversos aspectos de la producción, distribución y consumo de música. Curiosamente, los artistas buscan más las herramientas de AI para la producción y masterización musical (66%) que para la generación de música AI (47%). Las herramientas que potencian la creatividad se consideran más importantes que las puramente generadoras de AI, aunque tengamos que prepararnos para escuchar cada vez más extractos de música generada por AI.

II. Transformaciones potenciales

1. Democratización de la producción musical

AI está reduciendo las barreras de acceso a la creación musical. Las herramientas que antes requerían costosos estudios y años de formación son ahora accesibles a través de aplicaciones fáciles de usar. Esta democratización podría dar lugar a una explosión de nuevos estilos y voces musicales.

Alex Mitchell, CEO de Boomy, fundador de una startup de tecnología musical, imagina un futuro en el que cualquiera pueda ser compositor. "Ahora vemos a gente de todo el mundo crear canciones instantáneas con Boomy, publicarlas e incluso obtener ingresos por derechos de autor. Por primera vez, la expresión musical está al alcance de un tipo totalmente nuevo de creador y Audiencia" . Esta accesibilidad podría alterar radicalmente el panorama musical y descubrir talentos que de otro modo habrían pasado desapercibidos.

2. Nuevo artista -Audiencia Interacciones

AI está cambiando la forma en que los artistas conectan con su Audiencia. Algunos artistas y plataformas musicales ya están experimentando con chatbots basados en AI que permiten a los fans interactuar con su catálogo musical de formas novedosas. Por ejemplo, Spotify introdujo en su aplicación un chatbot basado en AI que interactúa con los usuarios para conocer sus preferencias musicales, estados de ánimo y hábitos de escucha. Esto permite al chatbot crear listas de reproducción personalizadas y sugerir nuevas canciones adaptadas a los gustos de cada usuario.

Estos chatbots de AI se están utilizando para mejorar el compromiso de los fans ofreciéndoles recomendaciones personalizadas, actualizaciones en tiempo real y experiencias interactivas. Pueden ofrecer actualizaciones de los artistas, recomendar listas de reproducción, facilitar la compra de entradas y gestionar las consultas de los fans, fomentando conexiones más profundas entre los artistas y sus Audiencia.

Una artista con visión de futuro, Holly Herndon, lanzó recientemente una versión AI de su voz con la que los fans pueden colaborar para crear pistas personalizadas. Esta mezcla de creatividad humana y capacidades de AI apunta a un futuro en el que la línea entre artista y Audiencia será cada vez más fluida.

Una conclusión polifacética

I. AIEl papel de la creatividad

La integración de AI en la creación musical plantea profundos interrogantes sobre la naturaleza del arte. Mientras algunos sostienen que AI no es más que una herramienta, similar a un nuevo instrumento, otros temen que pueda disminuir el elemento humano que hace que la música tenga resonancia emocional.

Marius Blanchard, Data Científico de la Universidad de Columbia y que trabaja en la industria musical Servicios una perspectiva equilibrada: "No creo que AI sustituya nunca a los artistas; [...] la conexión Audiencia-artista vive en muchos niveles diferentes más allá de la música. En cambio, espero que AI democratice el acceso a la producción de sonido de calidad y sea un impulso a la creatividad para que cada vez más artistas expresen y compartan sus creaciones."

II. Repercusiones en el empleo del sector

A medida que aumenten las capacidades de AI , algunas funciones de la industria musical pueden evolucionar o quedar obsoletas. Los ingenieros de sonido, por ejemplo, puede que tengan que adaptar sus conocimientos para trabajar con las herramientas de mezcla y masterización AI . Sin embargo, es probable que surjan nuevas categorías laborales, como AI programadores musicales o AI consultores éticos para las industrias creativas.

III. Autenticidad y conexión emocional

Quizás la cuestión más importante a la que se enfrenta la industria es si la música generada por AI puede forjar las mismas conexiones emocionales con los oyentes que las obras creadas por humanos. Aunque AI puede analizar patrones y crear composiciones técnicamente competentes, la inefable cualidad de la experiencia humana que suele impregnar la gran música sigue siendo difícil de reproducir.

El músico electrónico e investigador de AI Holly Herndon Servicios tiene una visión optimista: "Creo que la mejor forma de avanzar es que los artistas se apoyen en los avances del aprendizaje automático", afirma, y sugiere que "piensen en formas de invitar condicionalmente a otros a experimentar con ellos".

Referencias

Jeff Ens y Philippe Pasquier, (2020). MMM : Exploring Conditional Multi-Track

Music Generation with the Transformer. arXiv preprint arXiv:2008.06048 https://arxiv.org/abs/2008.06048

Andrea Agostinelli et al, (2023). MusicLM: Generating Music From Text. arXiv preprint arXiv:2301.11325 https://arxiv.org/abs/2301.11325

Huang et al, (2018). Music Transformer: Generating Music with Long-Term Structure. arXiv preprint arXiv:1809.04281 https://arxiv.org/abs/1809.04281

Ke Chen et al, (2023). MusicLDM: Enhancing Novelty in Text-to-Music Generation Using Beat-Synchronous Mixup Strategies. arXiv preprint arXiv:2308.01546 https://arxiv.org/abs/1809.04281

BLOG

BLOG