Auteur

Auteur

Auteur

À l'ère du numérique, les organisations sont confrontées au défi de suivre le rythme sans précédent de la génération de data et de la pléthore de systèmes d'entreprise et de technologies numériques qui collectent tous les types de data. À cela s'ajoute la nécessité d'analyser rapidement et efficacement ces grands volumes de data pour générer des informations et des renseignements afin de maximiser leur valeur commerciale. Par conséquent, les plateformes de big data sont devenues une base essentielle pour les organisations afin de déployer efficacement des solutions de data qui fournissent des décisions commerciales data temps opportun et un avantage concurrentiel.

"Data Les solutions d'analyse et d'intelligence se multiplient dans les organisations pour favoriser la croissance de l'entreprise. Les organisations devraient créer de grandes plateformes data comme fondations solides pour déployer les solutions data à grande échelle. Ces plateformes data doivent être conçues pour les entreprises, car elles ne valent que par les informations et les renseignements qu'elles permettent d'obtenir ; elles doivent être conçues pour être à l'épreuve du temps et bénéficier des progrès constants des services et des technologies d'infrastructure data ."Oussama Ahmad, Data Partenaire consultant à Artefact

Objectifs clés de la plateforme Big Data

Les plates-formes Big data visent à supprimer data les silos et à intégrer les différents types de sources data nécessaires à la mise en œuvre de solutions avancées d'analyse et de renseignement data . Elles fournissent une infrastructure évolutive et flexible pour la collecte, le stockage et l'analyse de grands volumes de data provenant de sources multiples. Ces plateformes doivent s'appuyer sur les meilleurs services et technologies de gestion data et remplir trois objectifs clés :

Infrastructure de la plateforme Big Data

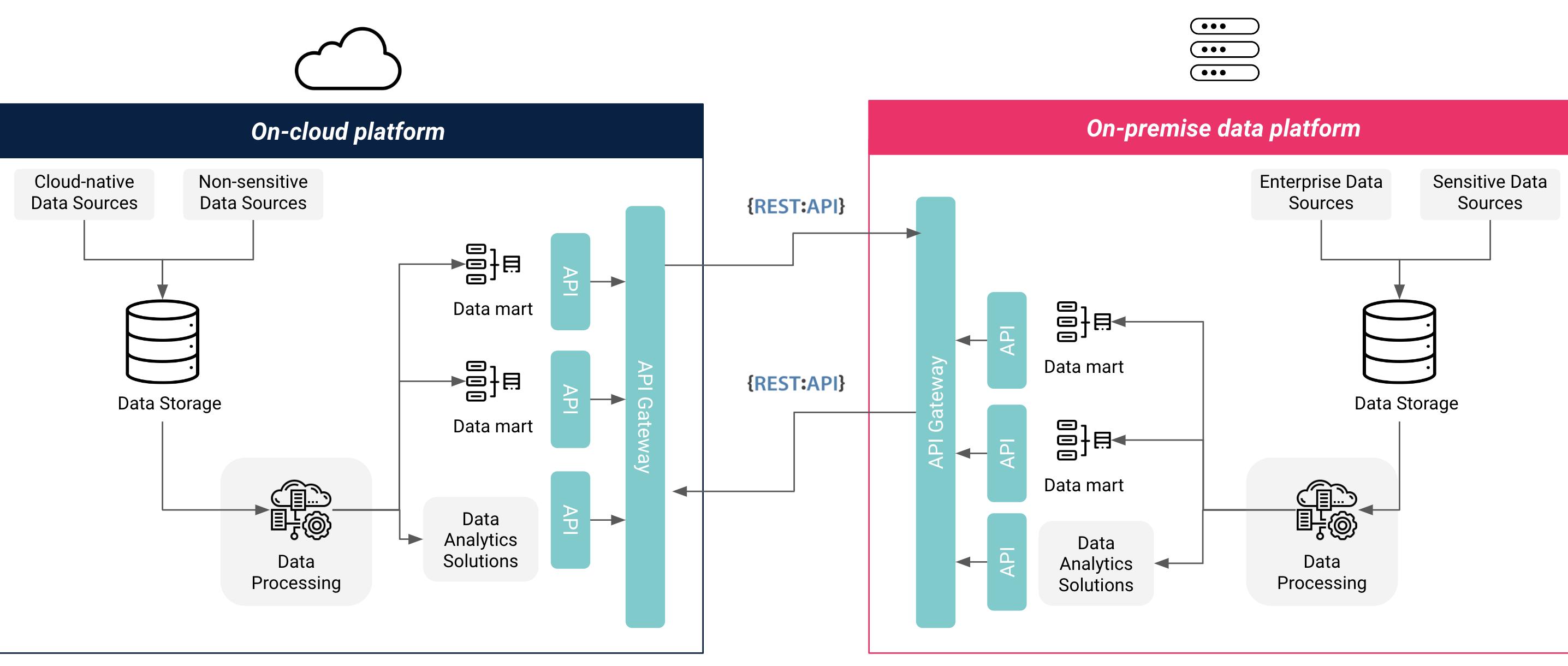

Il existe plusieurs options d'infrastructure pour une plateforme big data : entièrement sur site, entièrement cloud ou hybride cloud, chacune ayant ses propres avantages et défis. Les organisations doivent tenir compte d'un certain nombre de facteurs lorsqu'elles choisissent l'option d'infrastructure la plus appropriée pour leur plateforme big data , notamment les exigences en matière de sécurité et de résidence des data , les intégrations de sources de data , les exigences en matière de fonctionnalité et d'évolutivité, ainsi que les coûts et les délais. Une architecture entièrement cloud offre des coûts plus faibles et plus prévisibles, des services et des intégrations prêts à l'emploi et une évolutivité rapide, mais elle ne permet pas de contrôler le matériel et peut ne pas être conforme aux réglementations relatives à la confidentialité et à la résidence des data . Une architecture entièrement sur site offre un contrôle total sur le matériel et la sécurité des data , respecte généralement les réglementations relatives à la confidentialité et à la résidence des données, mais entraîne des coûts plus élevés et nécessite une planification à long terme pour l'évolutivité. Une architecture hybride cloud offre le meilleur des deux mondes, facilitant une migration complète vers le cloud à une date ultérieure, mais peut nécessiter une configuration plus complexe.

De nombreuses organisations choisissent une infrastructure hybride pour leurs plateformes big data en raison d'exigences organisationnelles visant à conserver les data hautement sensibles (telles que les data clients et financières) sur leurs propres serveurs, ou en raison de l'absence de fournisseurs de services cloud (CSP) certifiés par le gouvernement qui répondent aux exigences locales en matière de confidentialité et de résidence des data . Ces organisations préfèrent également conserver les sources de data cloud ou non sensibles dans le cloud afin d'optimiser les coûts de stockage et de ressources informatiques et de profiter des services d'analyse de data et d'apprentissage automatique prêts à l'emploi disponibles auprès des CSP. D'autres organisations qui n'ont pas d'exigences organisationnelles ou réglementaires en matière de résidence des data au sein de l'entreprise ou du pays optent pour une infrastructure entièrement cloud pour un temps de mise en œuvre plus rapide, des coûts optimisés et des ressources facilement évolutives.

Figure 1 : Infrastructure hybride de plateforme de Data en Cloud et sur site

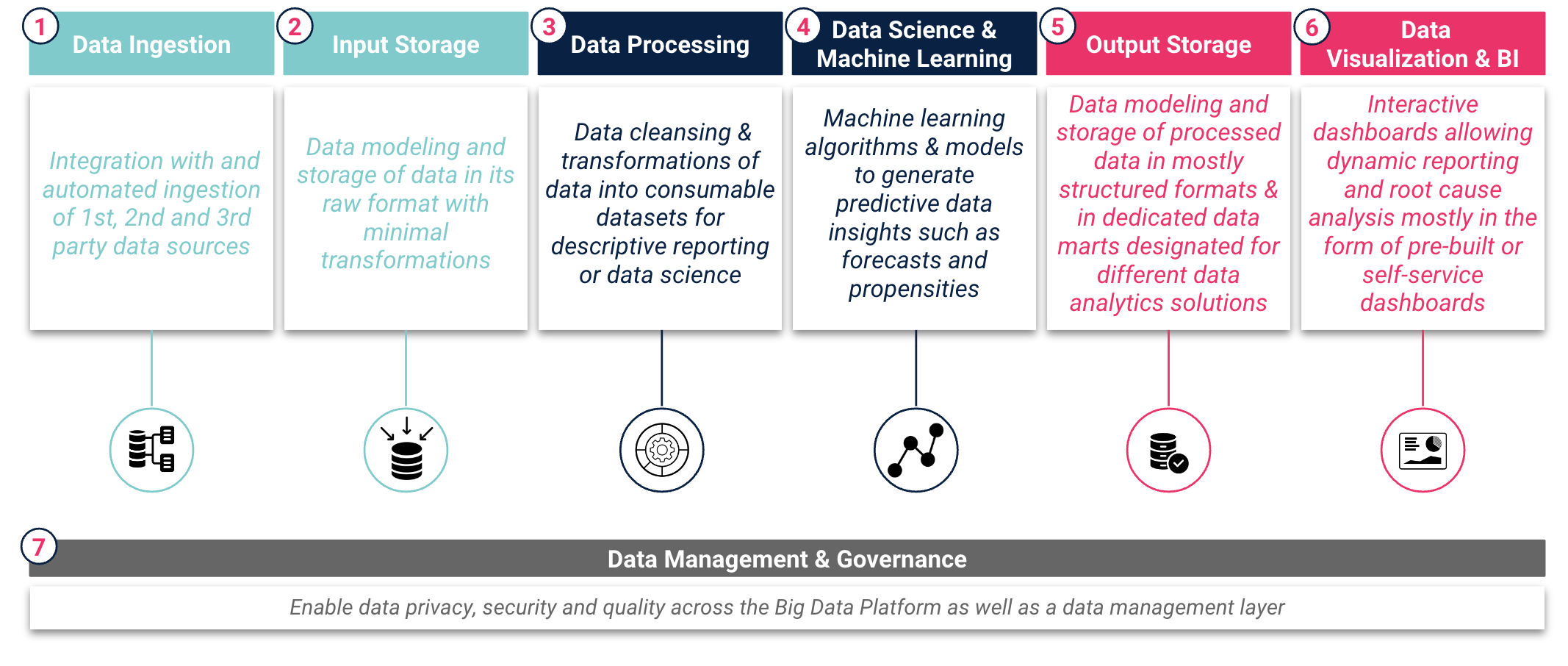

Une grande plateforme data implique généralement la mise en place de sept couches principales qui reflètent le cycle de vie data , depuis les "données brutes data" jusqu'aux "informations" et aux "connaissances". Les organisations doivent examiner attentivement les services et outils appropriés requis pour chacune des couches afin d'assurer un flux de données transparent et une génération efficace d'informations data . Ces services et outils doivent remplir des fonctions clés dans chaque couche de la grande plateforme data , comme le montre la figure 2 : Plateforme Big Data Data Couches.

Figure 2 : Plate-forme Big Data Data Couches

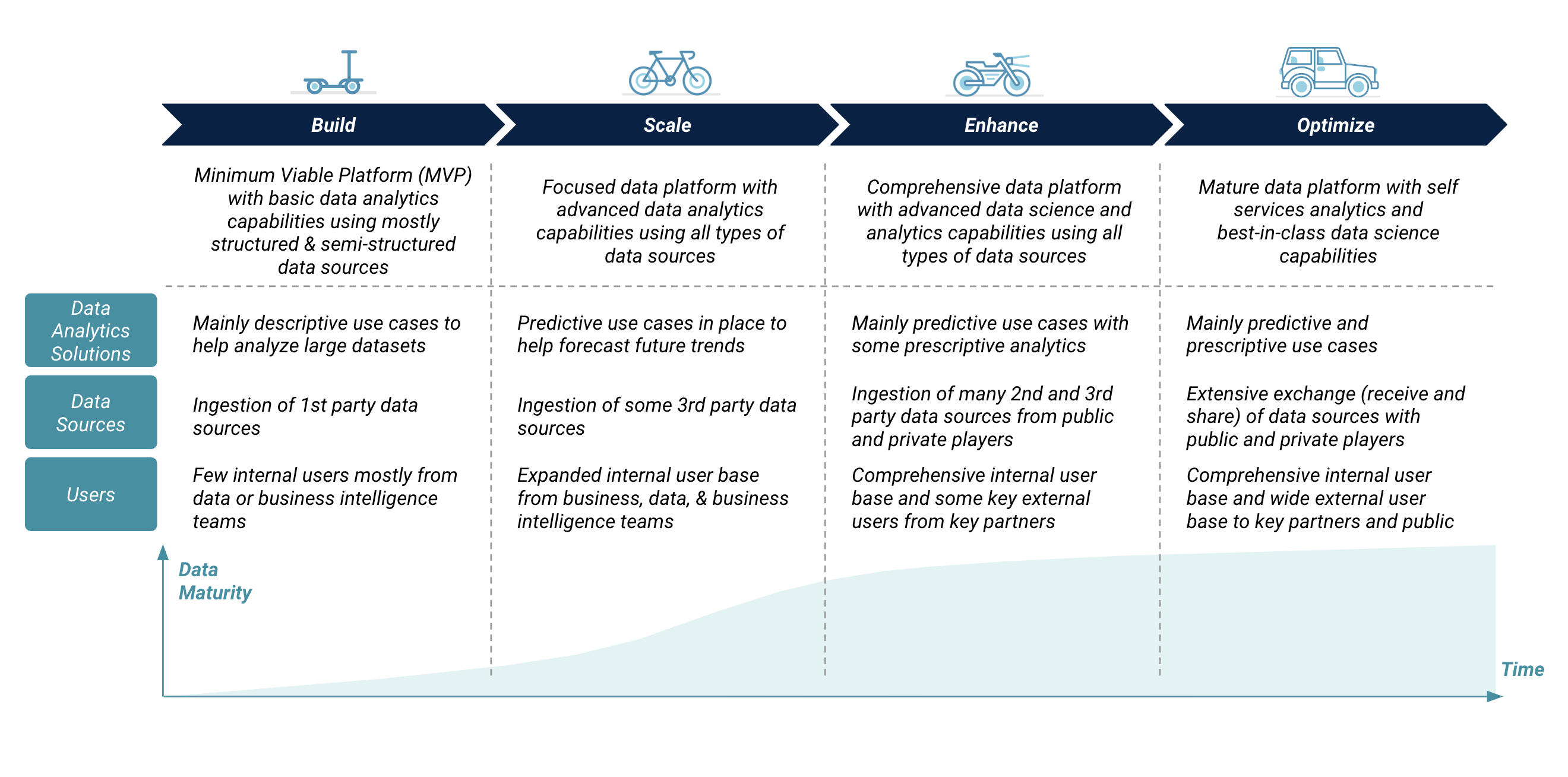

Évolution de la plateforme Big Data

Le développement d'une grande plateforme data devrait se faire en plusieurs étapes, en commençant par une plateforme minimale viable (MVP) et en poursuivant par des mises à niveau progressives. Une organisation doit synchroniser l'évolution de sa grande plateforme data avec les exigences accrues en matière d'informations et de renseignements plus larges et plus rapides data pour la prise de décisions commerciales. Ces exigences accrues ont une incidence sur la complexité de la plate-forme data en termes de solutions analytiques data , de volumes et de types de sources data et d'utilisateurs internes et externes. L'évolution de la plateforme big data comprend l'ajout de ressources de stockage et de calcul supplémentaires, de caractéristiques et de fonctionnalités avancées, ainsi que l'amélioration de la sécurité et de la gestion de la plateforme.

Figure 3 : Évolution de la plate-forme Big Data

"Nous avons constaté que de nombreuses organisations ont tendance à construire des plates-formes Big data avec des fonctionnalités avancées et inutiles dès le premier jour, ce qui augmente le coût de possession de la technologie. Le déploiement d'une grande plateforme data devrait commencer par une plateforme minimale viable et évoluer en fonction des exigences commerciales et technologiques. Dès les premières étapes de la construction de la plateforme, les organisations devraient mettre en place une solide couche de gouvernance et de gestion data qui garantisse data la qualité, la confidentialité, la sécurité et la conformité avec les lois locales et régionales data ."Anthony Cassab, Data Directeur conseil à Artefact

Lignes directrices pour une plateforme Big Data à l'épreuve du temps

Une plateforme de big data doit être construite conformément à des lignes directrices architecturales clés afin de garantir sa pérennité et de permettre l'extensibilité des ressources, la portabilité entre différentes infrastructures sur site et cloud , la mise à niveau et le remplacement des services, ainsi que l'expansion des mécanismes de collecte et de partage des data .

"Une plateforme adaptable et modulaire qui peut évoluer en fonction des besoins de l'entreprise est préférable à une plateforme "boîte noire" qui est bien intégrée mais ne permet qu'une personnalisation limitée. Ces architectures de plateforme peuvent être construites entièrement ou partiellement dans le cloud pour tirer parti des avantages de l'informatique cloud , tels que l'évolutivité et la rentabilité, tout en répondant aux exigences de confidentialité et de sécurité des réglementations en matière de protection des data ".Faisal Najmuddin, Data Engineering Manager at Artefact

En résumé, une grande plateforme data présente de nombreux avantages pour les organisations, tels que la centralisation des sources data , la mise en œuvre de solutions analytiques avancées data et l'accès à l'échelle de l'entreprise aux solutions et sources analytiques data . Toutefois, la mise en œuvre d'une grande plateforme data implique un certain nombre de décisions stratégiques, telles que le choix de la ou des bonnes infrastructures, l'adoption d'une architecture à l'épreuve du temps, la sélection de services standard et "migrables", l'examen minutieux des réglementations en matière de protection data et, enfin, la définition d'un plan d'évolution optimal étroitement lié aux exigences de l'entreprise et qui maximise le retour sur investissement data .

BLOG

BLOG