Autor

Autor

Autor

Im heutigen digitalen Zeitalter stehen Unternehmen vor der Herausforderung, mit der beispiellosen Geschwindigkeit der data und der Fülle von Unternehmenssystemen und digitalen Technologien, die alle Arten von data sammeln, Schritt zu halten. Gleichzeitig besteht die Notwendigkeit, diese großen data schnell und effizient zu analysieren, um Erkenntnisse und Informationen zu generieren und so den Geschäftswert zu maximieren. Infolgedessen sind data zu einer wesentlichen Grundlage für Unternehmen geworden, um data effizient einzusetzen, die zeitnahe data Geschäftsentscheidungen und Wettbewerbsvorteile ermöglichen.

"Data Analyse- und Intelligenzlösungen verbreiten sich in Unternehmen, um das Geschäftswachstum zu fördern. Unternehmen sollten große data Plattformen als solide Grundlage für den Einsatz von data Lösungen in großem Umfang aufbauen. Diese data Plattformen sollten speziell für Unternehmen entwickelt werden, da sie nur so gut sind wie die Geschäftseinblicke und die Intelligenz, die sie ermöglichen; und sie sollten zukunftssicher sein und von den ständigen Fortschritten bei data Infrastrukturdiensten und -technologien profitieren."Oussama Ahmad, Data Beratungspartner bei Artefact

Hauptziele der Plattform Big Data

Big data Plattformen zielen darauf ab, data Silos aufzubrechen und die verschiedenen Arten von data Quellen zu integrieren, die für die Implementierung fortschrittlicher data Analyse- und Intelligence-Lösungen erforderlich sind. Sie bieten eine skalierbare und flexible Infrastruktur für das Sammeln, Speichern und Analysieren großer Mengen von data aus verschiedenen Quellen. Diese Plattformen sollten die besten data Verwaltungsdienste und -technologien nutzen und drei Hauptziele erfüllen:

Infrastruktur der Plattform Big Data

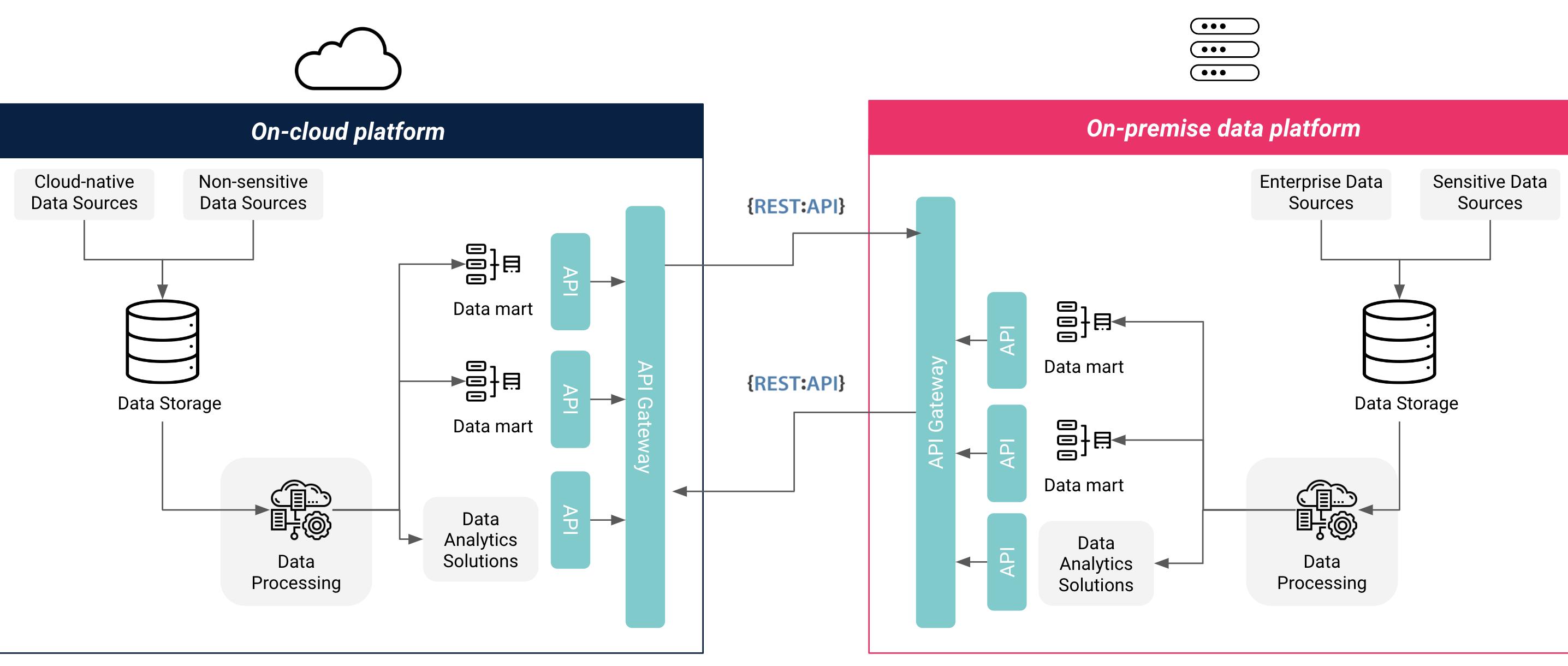

Es gibt mehrere Infrastrukturoptionen für eine data : vollständig vor Ort, vollständig cloud oder als Hybrid aus cloud, jede mit ihren eigenen Vorteilen und Herausforderungen. Unternehmen sollten bei der Auswahl der am besten geeigneten Infrastrukturoption für ihre data eine Reihe von Faktoren berücksichtigen, darunter die Anforderungen an die data und -speicherung, die Integration von data , die Anforderungen an Funktionalität und Skalierbarkeit sowie Kosten und Zeit. Eine vollständig cloud Architektur bietet niedrigere und besser vorhersehbare Kosten, sofort einsatzbereite Dienste und Integrationen sowie schnelle Skalierbarkeit, hat aber keine Kontrolle über die Hardware und erfüllt möglicherweise nicht die Vorschriften zum Datenschutz und zur data . Eine vollständig vor Ort installierte Architektur bietet die volle Kontrolle über die Hardware und die data , erfüllt in der Regel die Vorschriften zum Datenschutz und zur Datenaufbewahrung, verursacht jedoch höhere Kosten und erfordert eine langfristige Planung für die Skalierung. Eine hybride cloud bietet das Beste aus beiden Welten und erleichtert die vollständige Migration in die cloud zu einem späteren Zeitpunkt, kann aber eine komplexere Einrichtung erfordern.

Viele Unternehmen entscheiden sich für eine hybride Infrastruktur für ihre data , weil sie hochsensible data (z. B. Kunden- und data) auf ihren eigenen Servern aufbewahren müssen oder weil es keine staatlich zertifizierten cloud (CSPs) gibt, die die lokalen data und Residenzanforderungen erfüllen. Diese Unternehmen ziehen es auch vor, cloud oder nicht sensible data in der cloud zu halten, um die Kosten für Speicher- und Rechenressourcen zu optimieren und die Vorteile von sofort verfügbaren data und maschinellen Lerndiensten von CSPs zu nutzen. Andere Unternehmen, die keine organisatorischen oder gesetzlichen Anforderungen an die data innerhalb des Unternehmens oder Landes haben, entscheiden sich für eine vollständig cloud Infrastruktur, um die Implementierungszeit zu verkürzen, die Kosten zu optimieren und leicht skalierbare Ressourcen zu nutzen.

Abbildung 1: Hybride Cloud und Data

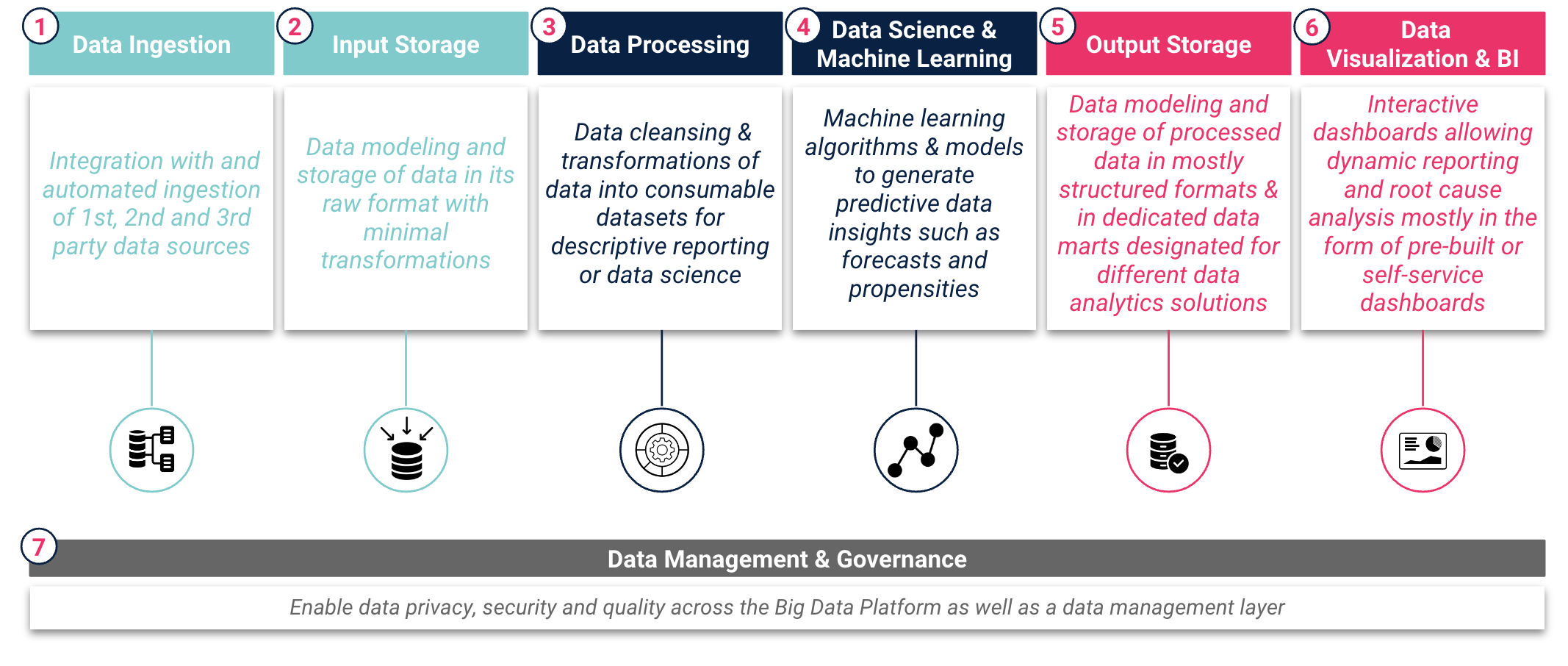

Eine große data Plattform umfasst in der Regel sieben Hauptebenen, die den data Lebenszyklus von "Rohdaten data" über "Informationen" bis hin zu "Erkenntnissen" widerspiegeln. Unternehmen sollten sorgfältig prüfen, welche Dienste und Werkzeuge für jede dieser Ebenen erforderlich sind, um einen nahtlosen Datenfluss und eine effiziente Generierung von data Erkenntnissen zu gewährleisten. Diese Dienste und Werkzeuge sollten in jeder Schicht der Big data Plattform Schlüsselfunktionen übernehmen, wie in Abbildung 2: Big Data Plattform Data Schichten dargestellt.

Abbildung 2: Big Data Plattform Data Schichten

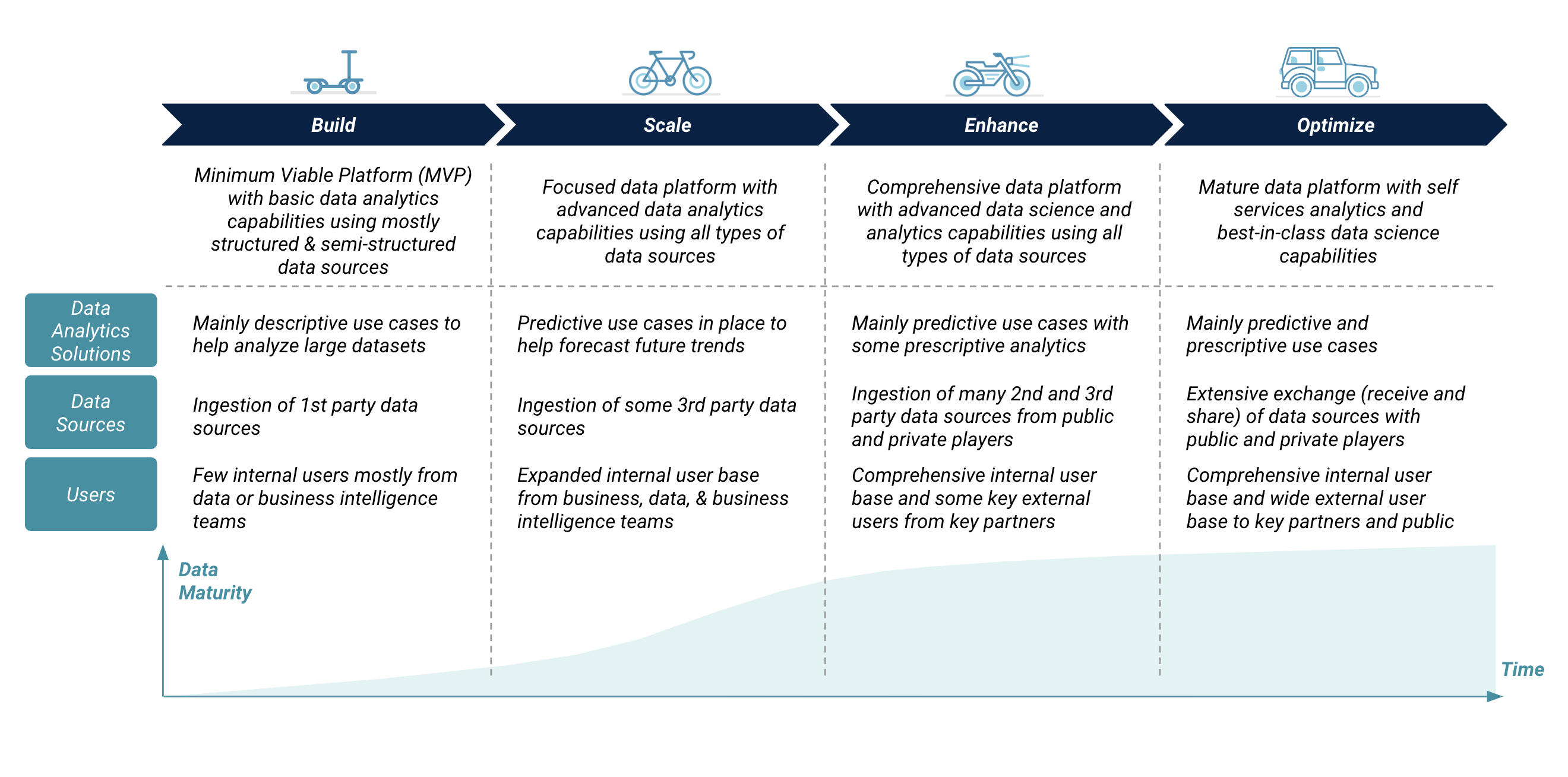

Entwicklung der Plattform Big Data

Die Entwicklung einer großen data Plattform sollte mehrere Stufen durchlaufen, beginnend mit einer Minimum Viable Platform (MVP) und fortgesetzt mit schrittweisen Upgrades. Ein Unternehmen sollte die Entwicklung seiner großen data Plattform mit den gestiegenen Anforderungen an umfassendere und schnellere data Erkenntnisse und Informationen für Geschäftsentscheidungen synchronisieren. Diese gestiegenen Anforderungen wirken sich auf die Komplexität der großen data Plattform in Bezug auf data Analyselösungen, data Quellvolumen und -typen sowie interne und externe Benutzer aus. Die Entwicklung der großen data Plattform umfasst die Hinzufügung von mehr Speicher- und Rechenressourcen, erweiterte Funktionen und Funktionalitäten sowie Verbesserungen bei der Sicherheit und Verwaltung der Plattform.

Schaubild 3: Big Data Plattformentwicklung

"Wir haben festgestellt, dass viele Unternehmen dazu neigen, große data Plattformen vom ersten Tag an mit erweiterten und unnötigen Funktionen auszustatten, was die Betriebskosten der Technologie erhöht. Die Bereitstellung einer großen data Plattform sollte mit einer minimal funktionsfähigen Plattform beginnen und auf der Grundlage der geschäftlichen und technischen Anforderungen weiterentwickelt werden. data In den frühen Phasen des Aufbaus der Plattform sollten Unternehmen eine robuste data Governance- und Verwaltungsebene implementieren, die die Qualität, den Datenschutz, die Sicherheit und die Einhaltung lokaler und regionaler data Gesetze gewährleistet."Anthony Cassab, Data Beratungsdirektor bei Artefact

Leitlinien für eine zukunftssichere Big Data Plattform

Eine data sollte nach wichtigen architektonischen Richtlinien aufgebaut werden, um sicherzustellen, dass sie zukunftssicher ist und eine einfache Skalierbarkeit der Ressourcen, die Übertragbarkeit auf verschiedene lokale und cloud , die Aufrüstung und den Austausch von Diensten sowie die Erweiterung der Mechanismen zur data und -weitergabe ermöglicht.

"Eine anpassungsfähige und modulare Plattform, die mit den sich entwickelnden Geschäftsanforderungen skaliert werden kann, ist einer "Black Box"-Plattform vorzuziehen, die zwar gut integriert ist, aber nur begrenzte Anpassungen zulässt. Diese Plattformarchitekturen können ganz oder teilweise in der cloud aufgebaut werden, um die Vorteile des cloud Computing, wie Skalierbarkeit und Kosteneffizienz, zu nutzen und gleichzeitig die Anforderungen an den Schutz der Privatsphäre und die Sicherheit der data zu erfüllen.Faisal Najmuddin, Data Technischer Leiter bei Artefact

Zusammenfassend lässt sich sagen, dass eine große data Plattform Unternehmen zahlreiche Vorteile bietet, wie z. B. die Zentralisierung von data Quellen, die Ermöglichung fortschrittlicher data Analyselösungen und die Bereitstellung eines unternehmensweiten Zugriffs auf data Analyselösungen und Quellen. Die Implementierung einer großen data Plattform bringt jedoch eine Reihe strategischer Entscheidungen mit sich, wie z. B. die Auswahl der richtigen Infrastruktur(en), die Annahme einer zukunftssicheren Architektur, die Auswahl von Standard- und "migrierbaren" Diensten, die sorgfältige Berücksichtigung der data Schutzvorschriften und schließlich die Festlegung eines optimalen Entwicklungsplans, der eng mit den Geschäftsanforderungen verknüpft ist und die Rendite der data Investition maximiert.

BLOG

BLOG