Lors de la conférence sur l'IA générative Artefact , qui s'est tenue le 20 avril 2023, des acteurs clés dans le domaine de l'IA générative ont partagé leurs connaissances et échangé des idées sur cette nouvelle technologie et sur la manière dont les entreprises peuvent l'utiliser pour améliorer leur productivité.

Les derniers modèles d'IA générative sont capables d'avoir des conversations sophistiquées avec les utilisateurs, de créer un contenu apparemment original (images, audio, texte) à partir de leur formation data, et d'effectuer des tâches manuelles ou répétitives telles que la rédaction de courriels, le codage ou la synthèse de documents complexes. Il est essentiel que les décideurs élaborent dès aujourd'hui une stratégie claire et convaincante en matière d'IA générative et donnent la priorité à la gouvernance data et à la conception des solutions commerciales d'AIGen.

Hôtes de la conférence et orateurs principaux :

IA générative : explorer de nouvelles frontières créatives

Dans son introduction à la conférence, Vincent Luciani a déclaré : "Partout, les gens sont enthousiasmés par cette nouvelle technologie et par l'impact qu'elle aura sur les organisations et les employés. Jusqu'à présent, l'IA se résumait à des applications relativement déterministes renforcées par l'apprentissage automatique. Nous pouvions prédire, personnaliser, optimiser, mais pas vraiment créer.

"Mais aujourd'hui, pour la première fois, on assiste à une véritable interaction entre l'homme et la machine. Une véritable forme d'intelligence émerge désormais de cette technologie et de ces algorithmes, même si la communauté scientifique est divisée sur la question de savoir s'il s'agit d'une révolution ou d'une évolution...

"Nous avons déjà parlé d'humains augmentés ou d'activités augmentées, nous parlerons bientôt d'entreprises augmentées. Avant de présenter un rapide aperçu des sujets qui seront abordés lors de la conférence et de céder la parole aux orateurs principaux, il a rappelé à l'auditoire que

"Malgré l'arrivée constante de nouvelles applications d'IA générative, la retenue est cruciale : une transformation commerciale réussie ne se fait pas du jour au lendemain, elle nécessite de la réflexion, de la recherche, de la préparation."Vincent Luciani, PDG et cofondateur de Artefact

Perspectives et opportunités sur le marché de l'IA générative

Le premier orateur, Hanan Ouazan, a commencé par donner un aperçu des modèles de texte, en commençant par l'article révolutionnaire de Google de 2017 intitulé "Attention is all you need" (l'attention est tout ce dont vous avez besoin) de Google, qui a conduit à la création des Transformers, qui sont à la base de presque tous les grands modèles de langage (LLM) utilisés aujourd'hui. "Comme vous le savez, la recherche prend du temps, mais aujourd'hui, nous sommes dans une période d'accélération, où nous voyons chaque jour de nouveaux modèles qui capitalisent sur un meilleur accès à data et à l'infrastructure."

Hanan a exploré plusieurs facettes de la démocratisation et de l'accessibilité des modèles d'IA générative, soulignant en particulier l'accélération de l'adoption de la technologie : "Le rythme est stupéfiant : ChatGPT a atteint 1 million d'utilisateurs en seulement cinq jours".

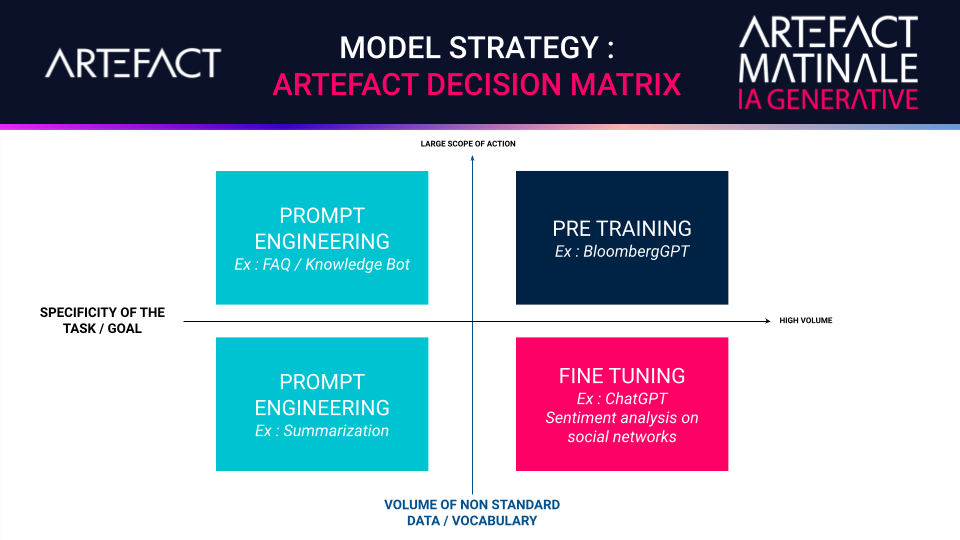

En ce qui concerne les stratégies de la méthode de formation LLM, il a présenté les avantages de la préformation, du réglage fin et de l'ingénierie rapide, en citant des cas d'utilisation industrielle pour chacun d'entre eux et en présentant la matrice de décision de la stratégie de modèle de Artefact.

Outre le coût de possession, les performances et les limites, Hanan a également parlé de la gestion du changement et de l'impact que l'IA générative pourrait avoir sur l'emploi.

"L'informatique changera certainement nos méthodes de travail, mais à l'adresse Artefact, nous ne pensons pas qu'elle tuera les professions : elle augmentera les capacités des personnes qui les exercent.Hanan Ouazan, partenaire Data Science & Lead Generative AI at Artefact

Une plateforme photo générative alimentée par l'IA pour le commerce électronique

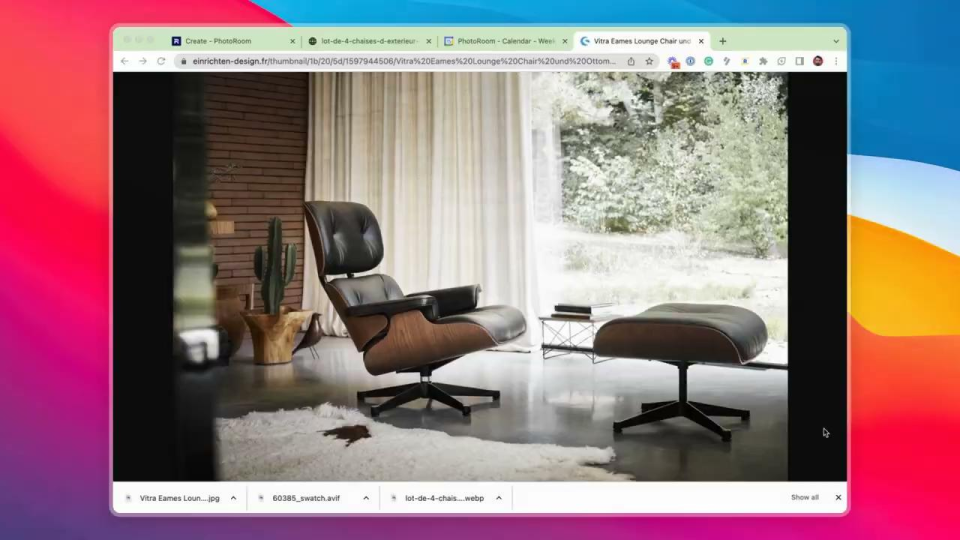

Matthieu Rouif est le PDG et cofondateur de PhotoRoom, une application qui permet à ses 80 millions d'utilisateurs de créer des photos de qualité studio avec un smartphone, en utilisant Stable Diffusion, une technologie d'IA générative pour les images.

Depuis l'explosion des places de marché du commerce électronique, stimulée par la pandémie de COVID-19, deux milliards de photos sont éditées chaque année. L'application PhotoRoom joue un rôle important en automatisant le détourage, l'affichage des ombres et la génération d'arrière-plans réalistes pour les marchands. "Nous utilisons l'IA générative pour offrir aux clients des photos qui ont l'air d'avoir été prises par un photographe professionnel, en ajoutant même des arrière-plans uniques et réalistes générés par l'IA en moins d'une seconde", explique Matthieu.

"Nous aidons nos clients à développer leurs activités en leur fournissant des photos abondantes, de haute qualité et à faible coût, qui respectent leur marque et présentent leurs produits sous le meilleur jour possible afin d'attirer et de fidéliser les clients".Matthieu Rouif, PDG et cofondateur de PhotoRoom

Repenser l'IA pour les entreprises

Igor Carron est le PDG et cofondateur de LightOn, une entreprise française à l'origine de la nouvelle plateforme d'IA générative Paradigm, plus puissante que GPT-3. Elle apporte les modèles les plus avancés pour faire fonctionner les serveurs et data tout en garantissant la souveraineté de data pour les entreprises.

Dans son discours d'ouverture, Igor a évoqué les origines de son entreprise. "Lorsque nous avons créé LightOn en 2016, nous construisions du matériel qui utilisait la lumière pour effectuer des calculs pour l'IA. C'était une approche inhabituelle, mais elle a fonctionné - notre Optical Processing Unit (OPU), le premier coprocesseur photonique d'IA au monde, a maintenant été utilisé par des chercheurs du monde entier et intégré sur l'un des plus grands supercalculateurs au monde.

"Depuis 2020, après l'apparition de GPT, nous avons cherché à comprendre comment notre matériel pouvait être utilisé pour construire nos propres LLM - à la fois pour notre propre usage et pour des clients extérieurs. Nous avons appris à fabriquer des LLM et sommes devenus assez bons dans ce domaine. Mais lorsque nous nous sommes adressés pour la première fois à des personnes en 2021 et 2022, elles n'avaient aucune idée de ce qu'était le GPT3, et nous avons donc dû éduquer notre public cible.

"Nous avons travaillé avec un client pour créer un modèle plus grand, récemment publié à 40 milliards, entraîné d'une manière unique pour concurrencer GPT3, mais en utilisant beaucoup moins de paramètres. Cela signifie que vous pouvez disposer d'une infrastructure beaucoup moins lourde et l'utiliser sans que cela ne vous coûte un bras".

Igor insiste sur la valeur des modèles linguistiques de grande taille :

"Je pense qu'à l'avenir, la plupart des entreprises seront basées sur le LLM. Ces outils leur permettront de générer une véritable valeur ajoutée à partir de leur propre site data."Igor Carron, PDG et cofondateur de LightOn

"Ce que nous offrons aux clients aujourd'hui est un produit appelé Paradigm : il permet aux entreprises de gérer leurs propres flux data au sein de leurs organisations et de réutiliser ce site data pour recycler et améliorer ces modèles. Cela garantit que leurs processus ou produits internes peuvent bénéficier de l'intelligence tirée de leurs interactions avec leurs LLM.

"De nombreux acteurs de l'écosystème français ou européen sont dépendants de l'Open AI API ou d'autres concurrents nord-américains." Igor met en garde : "Le danger d'envoyer votre site data à une API publique est qu'il sera réutilisé pour entraîner des modèles successifs. Dans quelques années, si vous demandez à ChatGPT-8 ou -9 ou autre "Où est l'or ?", il vous dira où est l'or !". Il recommande vivement aux entreprises de commencer à utiliser le site data qu'elles génèrent en interne pour entraîner leurs modèles.

Une stratégie nationale pour l'intelligence artificielle générative

Yohann Ralle, le dernier intervenant, est un spécialiste de l'IA générative au ministère de l'économie, des finances et de la souveraineté industrielle et numérique en France. Il a commencé par expliquer sa "formule magique" pour construire un LLM de pointe : puissance de calcul + ensembles de données + recherche fondamentale :

"Pour la puissance de calcul, le gouvernement français a investi dans un bien commun numérique, le supercalculateur Jean Zay, conçu pour servir la communauté de l'IA. Il a permis l'entraînement du modèle européen multilingue BLOOM ".Yohann Ralle, spécialiste de l'IA générative au ministère de l'Économie, des Finances et de la Souveraineté industrielle et numérique en France.

"En ce qui concerne les jeux de données, des initiatives telles que Agdatahub ont permis d'agréger, d'annoter et de qualifier l'apprentissage et les tests data afin de développer une IA efficace et digne de confiance - qui peut également contribuer à la compétitivité française. Quant à la recherche fondamentale, la stratégie nationale a permis de structurer l'écosystème de recherche et développement en IA avec la création des instituts 3IA, le financement de contrats doctoraux, les lancements des projets IRT Saint Exupéry et SystemX, de multiples programmes de formation d'étudiants et bien plus encore à travers la France et l'Europe."

Table ronde sur l'IA générative animée par Vincent Luciani, PDG de Artefact

L'IA a-t-elle passé le test de Turing (c'est-à-dire a-t-elle atteint le niveau d'intelligence humaine) ?

Si la question a suscité des réponses mitigées, le consensus général est que si l'intelligence est bien présente, l'intentionnalité ne l'est pas.

Matthieu : "On a l'impression qu'il y a quelqu'un, à condition de ne pas poser de questions sur les dates. Il y a un côté temporel qui ne fonctionne pas."

Igor : "Ma question est de savoir pourquoi vous avez posé cette question ? Parce que le test de Turing n'est pas très intéressant pour les entreprises. Mais en termes d'interaction, oui, on peut dire que l'IA a passé le test."

Yohann : "Le test de Turing est très subjectif. Il y a un risque à attribuer des qualités humaines à l'IA, à l'anthropomorphiser. Rappelez-vous le cas de Blake Lemoine, ingénieur chez Google, qui a cru que le chatbot LaMDA avec lequel il parlait était devenu sensible... Le test de Turing est un exercice intéressant, rien de plus."

Hanan : "En ce qui concerne le ChatGPT, nous nous en rapprochons, mais nous n'y sommes pas encore".

L'arrivée du ChatGPT est-elle une révolution, une évolution ou un élément d'un continuum ?

Igor : "Bien que l'impact à long terme du ChatGPT sur les LLM ne puisse pas encore être pleinement compris, au fil du temps, de nouvelles utilisations de ces technologies émergeront et auront d'importantes implications sociétales. La discussion est intéressante, mais le facteur le plus important est la publication d'articles scientifiques qui décriront en détail les améliorations apportées aux modèles d'apprentissage tout au long de la vie. Les applications pratiques actuelles et potentielles de ces modèles ne doivent pas être négligées ou sous-estimées.

Quels sont les cas d'usage les plus prometteurs pour les entreprises ? Bots, génération d'images ?

Hanan : "Évidemment, les chatbots ont toujours été importants dans l'IA et continueront à être un cas d'utilisation important, car maintenant, avec ChatGPT, vous pouvez en mettre un en place en 48 heures en le connectant à une base de données, c'est incroyable. Un autre cas d'utilisation est la création d'agents autonomes qui peuvent effectuer des tâches spécifiques sans intervention humaine, comme un agent de voyage qui réserve tous vos billets d'hôtels et de restaurants pour une visite en Italie."

Yohann : "Je vois beaucoup d'opportunités pour les plugins alimentés par la CGT, comme Kayak ou Booking. Je pense que cela va restructurer l'environnement numérique, où l'OpenAI va agréger les agrégateurs."

Igor: "J'envisage la possibilité de personnaliser les LLM d'entreprise. Au-delà des lacs data , les entreprises commenceront à comprendre comment utiliser data non structuré et comment générer une valeur réelle à partir de data en interne avec des LLM privés. Dans le même temps, je pense que nous assisterons à des changements spectaculaires dans la manière dont les gens recherchent et utilisent l'internet grâce à ChatGPT."

Vincent : Je pense qu'il y aura une fusion de data et de LLM internes à l'entreprise en une sorte de "Master FAQ+" qui pourra être interrogée par des agents de recherche ou des agents augmentés. Le concept de requête évolue : demain, achètera-t-on un ou plusieurs mots-clés, ou achètera-t-on un concept ? Dans la publicité, l'objectif a toujours été d'être basé sur les personnes, sur l'audience ; maintenant, alors que nous protégeons les données personnelles data, nous nous dirigeons vers une approche contextuelle. Et cela peut conduire à une publicité plus intéressante".

Comment l'IA générative est-elle utilisée dans les organisations aujourd'hui ? A-t-elle une incidence sur l'emploi ?

Matthieu : "Nous avons de la chance, l'un de nos avantages concurrentiels est que nous avons l'IA dans notre ADN. Nous encourageons l'utilisation d'outils plus génératifs en interne. Notre équipe technique utilise Copilot pour le développement, et nos codeurs utilisent à la fois ChatGPT et Copilot. Nous sommes plus créatifs avec ces outils. En ce qui concerne l'emploi, nous sommes en pleine croissance et nous prévoyons donc d'embaucher de nouvelles personnes... mais en même temps, lorsque nous disposons d'un excellent logiciel, nous pouvons en faire plus avec des équipes plus petites."

Igor : "Nous avons toujours fonctionné avec une petite équipe - sept ou huit personnes - pour atteindre les mêmes niveaux de prouesses techniques que Google, par exemple, où les équipes sont dix fois plus grandes. Nos petites équipes ont un effet totalement disproportionné. Il est faux de croire qu'il faut une grande équipe pour réaliser de grandes choses".

Yohann : "Il y a dix ans, une étude américaine affirmait que 47 % des emplois seraient perdus à cause de l'IA d'ici 20 ans, mais nous constatons que ce n'est pas le cas. Une étude plus récente de l'OCDE indique que ce chiffre est plus proche de 14 %. Je pense que nous devrions penser en termes de tâches, et non d'emplois. Comme le mentionne une étude récente d'OpenAI, 80 à 90 % des emplois seront impactés par l'IA générative - mais cela signifie en réalité que 90 % des employés seront impactés sur 10 % de leurs tâches. Ce qui est intéressant, c'est que la notion de métiers que l'on pensait intouchables par l'IA est remise en cause, comme les métiers de la création, du droit, de la finance, etc. Le gouvernement français a créé Le LaborIA pour aider à explorer ces questions."

Quelles sont les limites de ces modèles en matière de souveraineté et de réglementation ?

Hanan : "La première limite concerne la propriété intellectuelle (PI). Aujourd'hui, nous avons trois types de modèles : les modèles publics, comme ChatGPT, où le site data que vous envoyez peut être utilisé à des fins commerciales ; les modèles privés sans propriétaire de PI, comme l'API de Google sur Lamba ; et les modèles open-source auto-installés. Data La souveraineté est un problème car GPT et PaLM ne sont pas européens mais américains."

Yohann : "Les réglementations sont un problème majeur en Europe. L'Italie a totalement interdit l'utilisation de ChatGPT dans l'attente d'une enquête visant à déterminer si l'application est conforme aux règles de confidentialité du GDPR. OpenAI doit être extrêmement claire sur son utilisation des données personnelles data en présentant, par exemple, une clause de non-responsabilité indiquant qu'elle utilise des données personnelles data et en permettant aux utilisateurs de refuser la collecte de data et d'effacer leurs données data. Un autre problème concernant les limites des LLM est celui des hallucinations : ils donnent souvent de mauvaises réponses, ce qui peut être grave si la demande concerne une personnalité publique et que le modèle génère une histoire "fake news" qui peut causer un réel préjudice à la personne en question".

Vincent : "Avez-vous étudié la question de la propriété intellectuelle et les problèmes soulevés par le procès intenté par Getty Images à Stability AI? Il y a beaucoup de questions sur la recherche d'images sur l'internet pour entraîner des modèles..."

Yohann : "Nous y réfléchissons. L'open source pourrait être un moyen de créer des bases de données et des ensembles de données propres, exempts de droits d'auteur et respectueux de la propriété intellectuelle."

Matthieu : "En ce qui concerne data et les produits personnels : ce qui permet à ChatGPT, Midjourney ou PhotoRoom de bien fonctionner, ce n'est pas data, mais le retour d'information de la part des clients.

Yohann : "Le retour d'information des utilisateurs est idéal, mais sa collecte est d'un coût prohibitif dans le cas des LLM".

Igor : "Où est l'argent ? Telle est ma question. Tous les problèmes que vous avez soulevés sont d'ordre technique et nous ne pourrons pas les résoudre tant que nous n'aurons pas les fonds nécessaires pour embaucher des ingénieurs et mettre en place un écosystème, et nous ne sommes tout simplement pas encore prêts."

Avec la construction d'un nombre croissant de LLM, pensez-vous qu'il y aura une "guerre" des GPU ?

Yohann : "C'est un risque réel. Pour l'instant, il y a un monopole de NVIDIA ici, ils contrôlent le marché et les prix. Il n'y a pas de véritables concurrents en Europe, malheureusement. C'est une ressource limitée par définition, une ressource rare, donc c'est une bataille sérieuse".

Matthieu : "Le manque de disponibilité des GPU limite fortement non seulement notre productivité, mais aussi la croissance des entreprises partout en Europe."

Igor : "Depuis que nous avons commencé à produire du matériel, nous avons déjà été confrontés à ce problème en 2016... Aujourd'hui, il y a des gens qui travaillent chez nos concurrents et dont le travail à plein temps consiste à trouver suffisamment de GPU pour entraîner les modèles... Le marché explose, mais la production de puces ne peut pas suivre - où que ce soit dans le monde."

Hanan : "Il y aura inévitablement un goulot d'étranglement au niveau du GPU, mais nous pouvons apprendre à être plus efficaces, nous devons le faire. Et nous devons voir comment nous pouvons intégrer l'open source dans nos entreprises, et pas seulement comment utiliser toutes les dernières technologies."

Où voyez-vous le plus de valeur pour l'avenir ? Les modèles open source ? Les LLM ?

Matthieu : "Chez PhotoRoom, nous utilisons l'open source, ce qui nous permet d'aller plus vite et de développer notre propre propriété intellectuelle. Nous avons une large communauté Hugging Face à Paris qui nous donne un retour d'information essentiel."

Igor : "Nous utilisons des LLM, mais nous ne sommes pas attachés à ce modèle commercial. Nous pourrions utiliser des logiciels libres. L'important est de pouvoir et de savoir réutiliser notre site propriétaire data pour former de futurs modèles. L'objectif est de créer une industrie qui personnalise ces modèles pour d'autres entreprises.

Yohann : "L'évolution de l'open source par rapport à la propriété intellectuelle a été le moteur de l'IA générative. La communauté de l'IA a travaillé ensemble pour que d'autres acteurs puissent bénéficier de cette recherche fondamentale pour construire leurs propres modèles. Je me demande si les performances de ces modèles open source ne seront pas inférieures à celles des modèles propriétaires, mais cela peut changer. En tout cas, on peut se demander si Google ne regrette pas d'avoir ouvert les portes de sa technologie ChatGPT !

La table ronde a été suivie d'une séance de questions-réponses avec le public, avec une discussion particulièrement animée sur le manque de femmes dans la technologie. Yohann a détaillé plusieurs des mesures prises par le gouvernement français en matière d'éducation qui visent spécifiquement les filles et les femmes, tandis que Vincent a parlé de ce qui est fait par l'écoleArtefact de Data, l'initiative Women@Artefact et d'autres entreprises technologiques pour tenter de corriger la situation.

D'autres questions ont été posées sur l'inclusion des personnes autistes et d'autres personnes handicapées dans l'utilisation des LLM, sur le problème des hallucinations de l'IA, sur les mesures que les entreprises prévoient de mettre en place pour protéger l'environnement et sur le rôle de l'Europe par rapport à celui de la France en ce qui concerne le grattage de l'internet pour data. Pour voir comment les participants ont répondu à ces questions, regardez la conférence replay.

BLOG

BLOG