Voici quelques lignes directrices pour élaborer des solutions d'apprentissage automatique dignes de confiance sans tomber dans des pièges éthiques.

Introduction

L'utilisation de l'apprentissage automatique comme moyen de prise de décision est désormais omniprésente. De nombreux services que nous utilisons tous les jours sont le résultat d'une décision prise par l'apprentissage automatique. En conséquence, nous assistons à une réduction progressive de l'intervention humaine dans des domaines qui touchent à tous les aspects de notre vie quotidienne et où toute défaillance dans le jugement du modèle algorithmique pourrait avoir des conséquences néfastes. Il est donc essentiel d'établir des lignes directrices appropriées pour construire des solutions d'apprentissage automatique dignes de confiance et responsables, en prenant en compte l'éthique comme pilier central.

Ces dernières années, l'éthique de l'apprentissage automatique a connu un essor important dans la recherche universitaire, avec des conférences majeures telles que FACCT et AIES, ainsi que dans les grandes entreprises technologiques qui mettent en place des équipes à croissance rapide pour relever les défis éthiques.

L'IA éthique est un vaste sujet qui couvre de nombreuses questions telles que la protection de la vie privée, la gouvernance du site data , le bien-être sociétal et environnemental, la responsabilité des algorithmes, etc. Dans cet article, nous nous concentrerons principalement sur les composantes suivantes de l'éthique dans l'apprentissage automatique : l'équité, l'explicabilité et la traçabilité. Dans cet article, nous nous concentrerons principalement sur les composantes suivantes de l'éthique dans l'apprentissage automatique : équité, explicabilité et traçabilité. Nous examinerons d'abord les enjeux et les raisons pour lesquelles il est obligatoire de prêter attention à l'éthique, puis nous étudierons comment encadrer et développer votre projet d'apprentissage automatique en gardant l'éthique à l'esprit et comment assurer le suivi de l'éthique une fois déployé en production.

Pourquoi nous devons prêter attention à l'éthique

Les algorithmes d'apprentissage automatique et l'ensemble des abstractions et des hypothèses qui les sous-tendent devenant de plus en plus complexes, il est devenu difficile de saisir et de comprendre pleinement toutes les conséquences possibles de l'ensemble du système.

Il y a eu plusieurs exemples très médiatisés d'algorithmes d'apprentissage automatique injustes qui ont produit des résultats sous-optimaux et discriminants. Parmi ceux-ci, l'exemple bien connu du COMPAS. Le COMPAS était un logiciel commercial largement utilisé pour mesurer le risque de récidive d'une personne. Il a été comparé à un jugement humain normal dans le cadre d'une étude et on a découvert par la suite qu'il était biaisé à l'encontre des Afro-Américains : Le COMPAS était plus susceptible d'attribuer un score de risque plus élevé aux délinquants afro-américains qu'aux délinquants caucasiens ayant le même profil.

Dans le domaine du NLP, des biais de genre ont été détectés dans les premières versions de Google Translate et ont été corrigés en 2018 et plus récemment.

Dans le domaine de l'attribution de crédit, Goldman Sachs a fait l'objet d'une enquête pour avoir utilisé un algorithme d'IA qui aurait discriminé les femmes en accordant des limites de crédit plus importantes aux hommes qu'aux femmes sur leurs cartes Apple.

Dans le domaine des soins de santé, un algorithme de prédiction des risques utilisé sur plus de 200 millions de personnes aux États-Unis a révélé des préjugés raciaux.

En l'absence d'un cadre clairement défini sur la manière d'analyser, d'identifier et d'atténuer les biais, les risques de tomber dans des pièges éthiques peuvent être assez élevés. Il est donc de plus en plus important d'établir des lignes directrices adéquates afin de construire des modèles qui produisent des résultats appropriés et justes, en particulier dans les domaines impliquant des personnes. La construction d'une IA digne de confiance permet aux utilisateurs finaux de se sentir en sécurité lorsqu'ils l'utilisent, et aux entreprises d'exercer un meilleur contrôle sur son utilisation afin d'accroître l'efficacité tout en évitant tout préjudice. Pour que votre IA soit digne de confiance, vous devez commencer à penser à l'éthique avant même de traiter data et de développer des algorithmes.

Comment penser à l'éthique avant même le début de votre projet

L'éthique doit être prise en compte dès le début d'un nouveau projet, en particulier lors de la phase de cadrage du problème. Vous devez avoir à l'esprit les utilisateurs finaux ciblés ainsi que l'objectif de la solution proposée afin d'établir le bon cadre d'analyse et de gestion des risques pour identifier les préjudices directs ou indirects qui peuvent être induits par la solution. Vous devez vous demander si, dans ces conditions, ma solution pourrait conduire à des décisions susceptibles d'être biaisées en faveur d'un sous-groupe particulier d'utilisateurs finaux.

Il est donc essentiel d'élaborer des indicateurs de performance clés pour suivre les méthodes qui assurent l'efficacité de votre stratégie de gestion des risques. Un cadre solide pourrait également intégrer, dans la mesure du possible, un mécanisme de réduction des risques éthiques.

Lorsque l'on traite d'un sujet sensible qui présente un potentiel de risque élevé, il est nécessaire de prolonger le temps alloué à la phase d'exploration et de construction afin d'injecter une analyse d'évaluation éthique approfondie et des stratégies d'atténuation des préjugés.

Vous devez également mettre en place des mécanismes qui facilitent l'audit et la reproductibilité du système d'IA. Une trace logique doit être disponible à des fins d'inspection afin que tout problème puisse être examiné ou faire l'objet d'une enquête plus approfondie. Pour ce faire, il convient d'assurer un bon niveau de traçabilité par le biais de la documentation, de l'enregistrement, du suivi et de l'attribution de versions.

Chaque source data et chaque transformation data doit également être documentée afin de rendre transparents et traçables les choix effectués pour traiter le data . Cela permet de repérer les étapes qui ont pu injecter ou renforcer un biais.

Comment inclure l'éthique dans l'élaboration de votre projet data

Pour intégrer l'éthique dans l'élaboration de votre projet data , il est important d'inclure au moins trois composantes : l'équité, l'explicabilité et la traçabilité.

L'équité

La première étape de la plupart des projets d'apprentissage automatique est généralement la collecte de data . Qu'il s'agisse du processus de collecte data ou de l'utilisation d'un ensemble de données existant, la connaissance de la manière dont la collecte a été effectuée est cruciale. En général, il n'est pas possible d'inclure l'ensemble de la population cible, de sorte que les caractéristiques et les étiquettes peuvent être échantillonnées à partir d'un sous-ensemble, filtrées sur la base de certains critères ou agrégées. Toutes ces étapes peuvent introduire un biais statistique susceptible d'avoir des conséquences éthiques.

Biais de représentation

découle de la manière dont nous définissons et échantillonnons une population. Par exemple, le manque de diversité géographique dans des ensembles de données tels qu'ImageNet a mis en évidence un biais en faveur des pays occidentaux. En raison de ce biais d'échantillonnage, les tendances estimées pour une population donnée peuvent ne pas être généralisées à data pour une nouvelle population.

Il est donc nécessaire de définir des protocoles de collecte data appropriés, d'analyser la diversité des data reçus et de signaler à l'équipe toute lacune ou tout risque détecté. Vous devez collecter data de la manière la plus objective possible. Par exemple, en vous assurant, par le biais d'une analyse statistique, que l'échantillon est représentatif de la population ou du groupe que vous étudiez et, dans la mesure du possible, en combinant des données provenant de sources multiples afin de garantir data la diversité.

Il est obligatoire de documenter les résultats et l'ensemble du processus de collecte data .

Il existe en fait de nombreuses sources possibles de biais qui peuvent exister sous de nombreuses formes, dont certaines peuvent conduire à une injustice dans différentes tâches d'apprentissage en aval.

Étant donné que le cœur des algorithmes d'apprentissage automatique supervisé est la formation data, les modèles peuvent apprendre leur comportement à partir de data qui peuvent souffrir de l'inclusion de biais historiques ou statistiques involontaires. Les biais historiques peuvent s'infiltrer dans le processus de génération de data même si l'échantillonnage et la sélection des caractéristiques sont parfaits. La persistance de ces biais peut conduire à une discrimination involontaire à l'encontre de certains groupes ou individus, ce qui peut exacerber les préjugés et la marginalisation.

Toutes les sources de biais ne sont pas enracinées dans data, le pipeline complet d'apprentissage automatique implique une série de choix et de pratiques en cours de route, depuis le prétraitement data jusqu'au déploiement du modèle.

Il n'est pas simple d'identifier dès le départ si et comment des problèmes peuvent survenir. Une analyse approfondie est nécessaire pour identifier les problèmes émergents. Selon le cas d'utilisation, le type de data et l'objectif de la tâche, différentes méthodes seront utilisées Postuler.

Dans cette section, nous allons explorer quelques techniques pour identifier et atténuer les biais éthiques à travers un cas d'utilisation illustratif. Nous commencerons par énoncer le problème, puis nous verrons comment mesurer les biais et enfin nous utiliserons certaines techniques pour atténuer les biais pendant le prétraitement, le traitement et le post-traitement.

Énoncé du problème

Supposons que vous construisiez un algorithme de notation dans le secteur bancaire pour automatiser le ciblage des clients qui bénéficieront ou non d'une offre premium. Vous disposez d'un ensemble de données historiques contenant de nombreuses caractéristiques sur vos data significatives concernant vos clients, ainsi que la cible binaire "éligible pour une offre premium". Les éléments PII (informations personnelles identifiables) ont été préalablement supprimés de l'ensemble de données, de sorte qu'il n'y a pas de problème de confidentialité en jeu (à cet égard, le service de prévention des pertes dedata Google cloud est un excellent outil pour effectuer la tâche de dépersonnalisation de vos data sensibles).

Ce cas d'utilisation peut sembler quelque peu fictif, mais le problème est proche d'un cas d'utilisation réel que nous avons traité par le passé dans un secteur différent.

Mesurer les biais

La première étape de l'analyse consiste à explorer le site data afin d'identifier les caractéristiques sensibles, la valeur privilégiée et le label favorable.

Les caractéristiques sensibles (ou parfois appelées attributs protégés) sont des caractéristiques qui divisent une population en groupes qui devraient bénéficier d'une parité en termes d'avantages. Ces caractéristiques peuvent avoir un potentiel discriminatoire à l'égard de certains sous-groupes. Par exemple : le sexe, le genre, l'âge, la situation familiale, la classification socio-économique, la situation matrimoniale, etc. et toute approximation data qui en découle (par exemple, la situation géographique ou le montant des factures peuvent servir d'approximation à la classification socio-économique, car il a été observé dans certaines situations qu'ils pouvaient être fortement corrélés) sont des caractéristiques sensibles.

Une valeur privilégiée d'une caractéristique sensible indique un groupe qui a eu, historiquement, un avantage systématique.

Au cours de la phase de préparation de data , des étapes telles que la division de data, le sous-échantillonnage ou le suréchantillonnage, le traitement des valeurs manquantes et des valeurs aberrantes peuvent introduire des biais si elles ne sont pas exécutées avec soin. Les proportions de valeurs manquantes ou de valeurs aberrantes dans les sous-groupes pour les caractéristiques sensibles peuvent constituer une première étape dans l'identification des biais. Certaines stratégies d'imputation peuvent introduire un biais statistique, par exemple l'imputation des valeurs manquantes de la caractéristique de l'âge du client par sa médiane.

Dans notre exemple de notation, nous avons dessiné le graphique de la répartition de la formation data entre les sexes en ce qui concerne la cible "éligible à une offre de prime" :

Nous pouvons constater que la distribution de la cible est déséquilibrée en faveur du sexe masculin. Faisons l'hypothèse que la valeur privilège est Male lorsque le genre est une caractéristique sensible et que le label favorable est "éligible à une offre premium". En outre, cela pourrait correspondre à un biais de représentation dans le site data. En effet, dans un cas où l'équité est respectée, on pourrait faire en sorte que les distributions dans le site data soient totalement équilibrées ou correspondent aux distributions dans le site démographique data.

À ce stade, vous pourriez être tenté d'éliminer simplement les caractéristiques sensibles de votre ensemble de données, mais il a été démontré que la suppression des attributs sensibles n'est pas nécessairement suffisante pour rendre votre modèle équitable. Le modèle pourrait utiliser d'autres caractéristiques en corrélation avec la caractéristique sensible supprimée, reproduisant ainsi des biais historiques. Par exemple, une caractéristique A pourrait être fortement corrélée à l'âge d'un client, de sorte que si le site data est biaisé en faveur d'une certaine tranche d'âge (un biais historique pourrait se traduire par une discrimination fondée sur l'âge en matière d'embauche, de promotion, etc. En conservant la caractéristique sensible dans votre site data, lorsque c'est nécessaire, vous pouvez mieux contrôler les mesures et l'atténuation des préjugés et de l'équité.

Mesures des biais

Il existe un grand nombre de définitions et de mesures de l'équité. Nous pouvons diviser l'équité en deux catégories : l'équité individuelle et l'équité de groupe. L'équité individuelle donne des prédictions similaires à des individus similaires, tandis que l'équité de groupe traite les différents groupes de la même manière.

Pour parvenir à l'équité au sein du groupe, nous voulons que la probabilité d'un résultat positif soit la même, que la personne appartienne ou non au groupe protégé (par exemple, les femmes).

Une mesure de groupe simple consiste à comparer le pourcentage de résultats favorables pour les groupes privilégiés et non privilégiés (dans notre exemple, le sexe masculin "éligible à une offre de prime" comparé au sexe féminin "éligible à une offre de prime"). Vous pouvez calculer cette comparaison comme une différence entre les deux pourcentages, ce qui conduit à la mesure de la différence de parité statistique (également appelée parité démographique) :

Pour qu'il n'y ait pas de différence dans les résultats favorables entre les groupes privilégiés et non privilégiés, la différence de parité statistique doit être égale à 0.

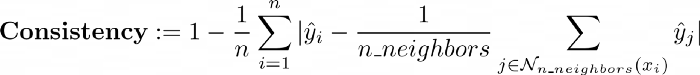

En ce qui concerne la mesure de l'équité individuelle, il existe la cohérence qui mesure le degré de similitude des étiquettes pour des individus similaires à l'aide d'un algorithme du plus proche voisin :

Nous ne nous attarderons pas sur ce sujet, mais le lecteur intéressé pourra consulter cet article.

Vous pouvez utiliser la bibliothèque pratique AIF360 qui vous permet de calculer de nombreuses mesures d'équité.

Tout ce que vous avez à faire est d'envelopper votre dataframe dans le StandardDataset. AIF360 utilise un StandardDataset qui enveloppe un Pandas DataFrame avec de nombreux attributs et méthodes spécifiques au traitement et à la mesure des biais éthiques. Vous pouvez ensuite l'utiliser comme entrée de la classe BinaryLabelDatasetMetric qui calculera un ensemble de mesures utiles.

| params_aif = { | |

| "label_name": "eligible_for_a_premium_deal", | |

| "favorable_classes":[1], | |

| "protected_attribute_names": ["gender"], | |

| "privileged_classes": [[0]] # dans notre cas, 0 correspond à Male et 1 à Female | |

| } | |

| # Créer des ensembles de données standard aif360 | |

| train_standard_dataset = StandardDataset(df=train_dataframe, | |

| **params_aif) | |

| privileged_groups = [{‘gender’: 0}] | |

| unprivileged_groups = [{‘gender’: 1}] | |

| train_bldm = BinaryLabelDatasetMetric(train_standard_dataset, | |

| unprivileged_groups=unprivileged_groups, | |

| groupes_privilégiés=groupes_privilégiés) |

Une fois mesurée sur la formation de notre exemple de notation data, nous observons une différence de parité statistique moyenne de -0,21, ce qui indique que le groupe privilégié Male a obtenu 21 % de résultats positifs en plus dans l'ensemble de formation data .

Atténuation des biais

Les méthodes qui ciblent les biais algorithmiques sont généralement divisées en trois catégories :

Nous avons utilisé une technique de prétraitement sur le site data afin d'optimiser la différence de parité statistique. Nous avons appliqué l'algorithme Reweighing (plus de détails dans cet article) qui est implémenté dans AIF360 afin de pondérer les exemples différemment dans chaque combinaison (groupe, étiquette) pour assurer l'équité avant la classification.

RW = Reweighing(unprivileged_groups=unprivileged_groups,

groupes_privilégiés=groupes_privilégiés)

reweighted_train = RW.fit_transform(train_standard_dataset)

|

L'attribut des poids des instances a été modifié afin de rééquilibrer la caractéristique sensible par rapport à la cible. Ce faisant, l'algorithme de repondération a atténué le biais de groupe sur le site d'apprentissage data: une nouvelle mesure de la différence de parité statistique est complètement rééquilibrée de -0,21 à 0.

Il existe d'autres algorithmes d'atténuation des biais de prétraitement mis en œuvre dans AIF360, tels que DisparateImpactRemover, une technique qui modifie les valeurs des caractéristiques afin d'accroître l'équité des groupes tout en préservant l'ordre de classement au sein des groupes (plus d'informations dans l'article suivant) ou LFR (Learning fair representation), une technique de prétraitement qui trouve une représentation latente qui encode le site data mais masque les informations sur les attributs protégés (plus d'informations dans l'article suivant).

Nous avons ensuite formé deux modèles de classification, l'un sur le site d'apprentissage original data et l'autre sur le site repondéré data. Nous observons que la repondération n'a qu'un faible impact sur les performances, perdant 1% du score F1.

Nous avons également essayé un algorithme de traitement sur notre exemple de cas d'utilisation : le débiaisage contradictoire qui a amélioré de manière significative les mesures de biais de groupe (la différence de parité statistique a été divisée par 2) avec une faible détérioration de la performance du modèle (environ 1 % sur le score F1).

Il peut donc y avoir un compromis entre les mesures de performance et de biais. Dans le cas présent, la détérioration est assez faible, mais dans certaines situations, le compromis pourrait être plus important. Cette information doit être portée à la connaissance de l'équipe et des parties prenantes appropriées qui peuvent prendre des décisions sur la manière de traiter ce problème.

Maintenant que nous disposons de modèles entraînés, nous pouvons explorer leurs prédictions et rechercher un déséquilibre vers le résultat favorable entre les sexes. Il existe de nombreux outils, tels que What-if tool ou Aequitas, qui vous permettent de sonder le comportement des modèles d'apprentissage automatique formés et d'étudier les performances du modèle et l'équité entre les sous-groupes.

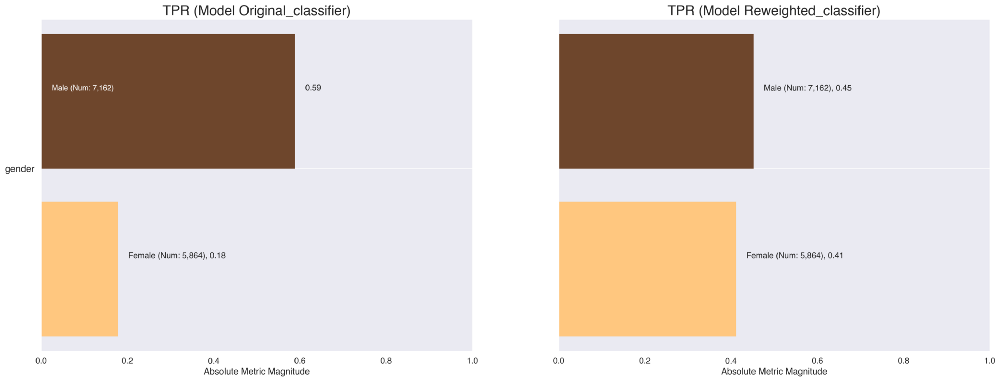

À titre d'illustration, vous pouvez utiliser Aequitas pour générer des tableaux croisés et des visualisations qui présentent diverses mesures de biais et de performance réparties entre les sous-groupes. Par exemple, nous pouvons rapidement comparer les taux de vrais positifs des classificateurs formés sur le site original data et sur le site repondéré data. Nous constatons que ce taux a été équilibré et qu'il permet donc une plus grande équité entre les sexes en ce qui concerne le résultat favorable du modèle, à savoir l'éligibilité à une offre premium.

En tant que technique de post-traitement, nous avons agi sur le seuil de classification. Un modèle de classification nous fournit généralement les probabilités associées à la réalisation de chaque classe en tant que prédiction. Cette probabilité peut être utilisée telle quelle ou convertie en valeur binaire.

Afin d'identifier la classe correspondant aux probabilités obtenues, un seuil de classification (également appelé seuil de décision) doit être défini. Toute valeur supérieure à ce seuil correspondra à la catégorie positive "est éligible à une offre de prime" et vice versa pour les valeurs inférieures à ce seuil.

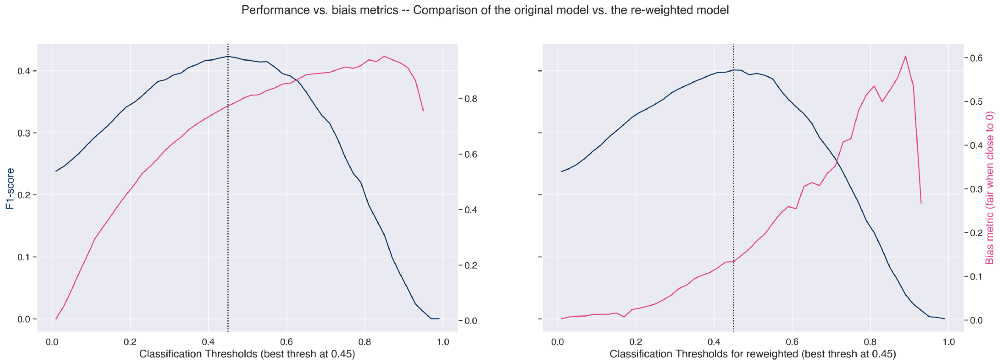

La représentation graphique de la mesure de la performance et de la mesure du biais (ici 1 - impact disparate) pour tous les seuils de classification permet de définir le seuil optimal. Cela nous aide à choisir le seuil approprié afin de maximiser les performances et de minimiser les biais.

Sur la figure de gauche, nous voyons que si nous poussons le seuil vers la gauche, réduisant ainsi légèrement les performances, nous pouvons améliorer la métrique de biais.

De même, comme prévu, nous observons une nette amélioration de la mesure du biais de groupe sur le modèle repondéré (figure de droite), qui pourrait être encore améliorée en choisissant un autre seuil de classification, mais au détriment de la performance.

Explicabilité

Un autre pilier essentiel pour construire des modèles d'apprentissage automatique dignes de confiance est l'explicabilité. L'explicabilité est la capacité à expliquer à la fois les processus techniques du système d'IA et le raisonnement qui sous-tend les décisions ou les prédictions du système d'IA, ce qui permet de quantifier l'influence de chaque caractéristique/attribut sur les prédictions. Une bonne pratique consiste à utiliser autant que possible des modèles facilement interprétables plutôt que des modèles de boîte noire.

Il existe de nombreuses méthodes pour obtenir l'explicabilité des modèles. Ces méthodes peuvent être regroupées en deux catégories :

Nous allons ici Postuler une méthode post-hoc célèbre, à savoir SHAP (SHapley Additive exPlanations). Pour plus d'informations, nous vous recommandons d'explorer cette ressource très complète sur le sujet. Shap est une bibliothèque qui met en œuvre une approche théorique des jeux pour expliquer les résultats de n'importe quel modèle d'apprentissage automatique.

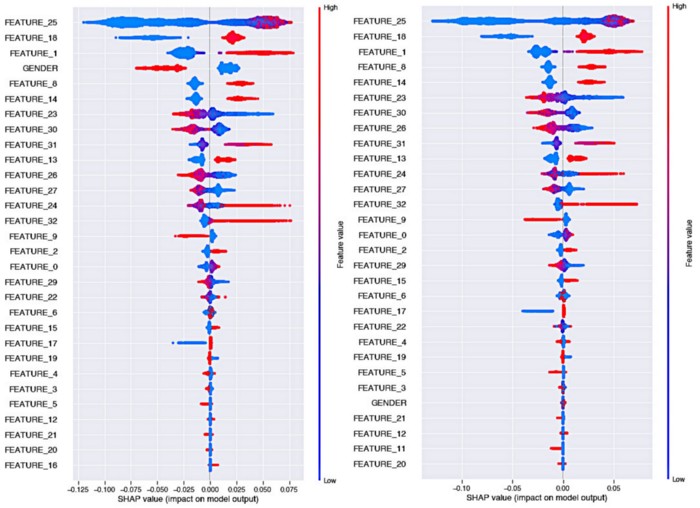

Observons l'impact de l'algorithme Reweighing sur l'explicabilité du modèle :

Petit rappel sur la façon de lire les tracés des guêpiers de Shap :

À gauche, nous avons l'explicabilité du modèle original où nous observons que dans ce cas, la variable du sexe a un très fort pouvoir prédictif et que le sexe féminin a un impact qui influence la décision vers la cible "non éligible à une offre de prime" avec un écart important par rapport au sexe masculin.

Nous pouvons voir sur le graphique de droite, dans ce cas où le modèle a été entraîné sur le site data repondéré, que l'importance de la caractéristique du sexe a fortement diminué. Elle fait maintenant partie des caractéristiques les moins importantes. De plus, l'influence de la classe féminine par rapport à la classe masculine sur la prédiction de la cible est beaucoup plus équilibrée (les couleurs sont proches de 0 dans la valeur de Shapley).

Traçabilité

Un autre aspect essentiel du processus de création d'algorithmes d'apprentissage automatique dignes de confiance est la traçabilité des résultats et la bonne reproductibilité des expériences. Il est ainsi facile d'identifier la version d'un modèle qui a été mise en production, de sorte qu'elle puisse être auditée si son comportement cause des dommages et n'est plus conforme aux valeurs éthiques de l'entreprise.

Pour ce faire, il faut être en mesure de suivre et d'enregistrer chaque version du modèle ainsi que la formation qui lui est associée data, les hyperparamètres et les résultats. Plusieurs outils permettent d'accomplir cette tâche : Mlflow est une excellente option qui vous permet de générer rapidement une interface web qui centralise toutes les exécutions, tout en sauvegardant vos artefacts dans le stockage de votre choix. Chaque version de l'expérience peut être suivie avec le hash du commit associé. Chacune de ces versions contiendra tous les éléments enregistrés par MLflow.

Voici un outil que nous avons ouvert à Artefact et qui vous permet de déployer un MLflow sécurisé sur un projet GCP à l'aide d'une seule commande.

C'est également une bonne pratique de créer une FactSheet pour chaque modèle, qui correspond à une carte d'identité du modèle qui résume divers éléments retraçant les étapes de prétraitement, les mesures de performance, les mesures de biais, etc.

Ces fiches d'identité sont remises par les scientifiques de data aux équipes chargées de l'exploitation des modèles, ce qui leur permet de déterminer si le modèle est adapté à leur situation. Pour plus de détails sur la méthodologie de création d'une fiche d'information, nous vous recommandons cet article. La FactSheet peut également être stockée, sous forme de tableau par exemple, dans MLFlow avec le modèle associé.

Comment assurer le suivi de l'éthique une fois qu'elle a été déployée ?

Une fois votre modèle déployé, vous devez vous assurer qu'il est utilisé dans le but pour lequel il a été pensé, conçu et construit. Il y a biais de déploiement lorsqu'il y a inadéquation entre le problème qu'un modèle est censé résoudre et la manière dont il est réellement utilisé. Cela se produit fréquemment lorsqu'un système est développé et évalué comme s'il était totalement autonome, alors qu'en réalité il fait partie d'un système socio-technique complexe régi par un grand nombre de décideurs.

La production data peut dériver au fil du temps, ce qui peut entraîner une dégradation des performances de l'algorithme susceptible d'injecter des biais. Le suivi de la qualité de la production data et de la dérive data en surveillant les distributions des nouveaux data par rapport aux data utilisés pour former les modèles, devrait être une étape dans le pipeline de production afin de déclencher les alertes appropriées en cas de besoin et de définir quand le recyclage est obligatoire.

Le pipeline de production doit être conçu de manière à ce qu'il soit possible de désactiver le modèle actuel ou de revenir à une version antérieure.

Conclusion

Dans cet article, nous avons présenté quelques bonnes pratiques et protocoles pour vous guider dans la construction de pipelines d'apprentissage automatique qui minimisent le risque de tomber dans des pièges éthiques.

Cet article a à peine effleuré la surface du vaste sujet qu'est l'IA éthique et n'a fait qu'effleurer les outils intéressants en cours de développement qui sont aujourd'hui disponibles.

Comme nous l'avons vu, la manière la plus logique d'aborder explicitement les problèmes d'équité est de déclarer une collection de caractéristiques sélectionnées comme potentiellement discriminatoires, puis d'étudier à travers ce prisme les préjugés éthiques. Cette technique simple présente toutefois un défaut : la discrimination peut être le résultat d'une combinaison de caractéristiques qui ne sont pas discriminatoires en elles-mêmes. En outre, dans de nombreux cas, vous n'aurez accès à aucune caractéristique sensible (plus d'informations à ce sujet ici).

L'évaluation de l'équité est une tâche complexe qui dépend de la nature du problème. L'approche d'un problème de notation basé sur le tableau data ne sera pas la même que l'atténuation des préjugés dans le traitement du langage naturel.

Nous espérons que le partage de notre perspective et de nos méthodologies vous inspirera dans vos propres projets ! Merci pour votre lecture, n'hésitez pas à suivre le blog Artefact tech si vous souhaitez être notifié de la sortie de notre prochain article !

BLOG

BLOG