Hier volgen enkele richtlijnen om betrouwbare oplossingen voor machine learning te bouwen zonder in ethische valkuilen te trappen.

Inleiding

Het gebruik van machine learning als middel om beslissingen te nemen is inmiddels alomtegenwoordig. Veel van de resultaten van diensten die we dagelijks gebruiken zijn het resultaat van een beslissing die door machine learning is genomen. Als gevolg hiervan zien we een geleidelijke afname van menselijke tussenkomst op gebieden die elk aspect van ons dagelijks leven beïnvloeden en waar elke fout in het oordeel van het algoritmische model nadelige gevolgen kan hebben. Het is daarom essentieel om goede richtlijnen op te stellen om betrouwbare en verantwoordelijke oplossingen voor machinaal leren te bouwen, waarbij ethiek een belangrijke pijler is.

In de afgelopen jaren heeft de ethiek van machinaal leren een grote vlucht genomen in het academisch onderzoek, met grote conferenties zoals FACCT en AIES, maar ook in grote techbedrijven die snelgroeiende teams samenstellen om de ethische uitdagingen aan te gaan.

Ethisch AI is een breed onderwerp dat veel onderwerpen omvat, zoals privacy, data governance, maatschappelijk en ecologisch welzijn, algoritmische verantwoording, enz. In dit artikel zullen we ons voornamelijk richten op de volgende componenten van ethiek in machine learning: eerlijkheid, uitlegbaarheid en traceerbaarheid. We zullen eerst bespreken wat er op het spel staat en waarom aandacht voor ethiek verplicht is. Daarna zullen we onderzoeken hoe je een machine-learningproject kunt opzetten en ontwikkelen met ethiek in gedachten en hoe je ethiek kunt opvolgen zodra het in productie is genomen.

Waarom we aandacht moeten besteden aan ethiek

Nu algoritmen voor machinaal leren en de reeks abstracties en hypotheses die eraan ten grondslag liggen steeds complexer worden, is het een uitdaging geworden om alle mogelijke gevolgen van het hele systeem volledig te begrijpen.

Er zijn verschillende geruchtmakende voorbeelden uit de echte wereld van oneerlijke algoritmen voor machinaal leren die leiden tot suboptimale en discriminerende resultaten. Waaronder het bekende voorbeeld van COMPAS. COMPAS was een veelgebruikte commerciële software die het risico meet dat iemand opnieuw een misdaad begaat, die in een onderzoek werd vergeleken met normale menselijke beoordelingen en waarvan later werd ontdekt dat ze bevooroordeeld waren ten opzichte van Afro-Amerikanen: COMPAS kende eerder een hogere risicoscore toe aan Afro-Amerikaanse daders dan aan blanken met hetzelfde profiel.

Op het gebied van NLP werd gender biais gedetecteerd in vroege versies van Google Translate die in 2018 en meer recent werden aangepakt.

Op het gebied van krediettoekenning werd Goldman Sachs onderzocht voor het gebruik van een AI algoritme dat naar verluidt vrouwen discrimineerde door grotere kredietlimieten toe te kennen aan mannen dan aan vrouwen op hun Apple kaarten.

In de gezondheidszorg toonde een algoritme voor risicovoorspelling dat werd gebruikt op meer dan 200 miljoen mensen in de VS raciale vooroordelen aan.

Zonder een duidelijk omlijnd kader voor het analyseren, identificeren en beperken van vooroordelen is het risico om in ethische valkuilen te trappen vrij groot. Het wordt dus steeds belangrijker om goede richtlijnen op te stellen om modellen te bouwen die resultaten produceren die gepast en eerlijk zijn, vooral in domeinen waar mensen bij betrokken zijn. Het bouwen van betrouwbare AI geeft eindgebruikers een veilig gevoel als ze het gebruiken en het stelt bedrijven in staat om meer controle uit te oefenen over het gebruik ervan om de efficiëntie te verhogen en tegelijkertijd schade te voorkomen. Om ervoor te zorgen dat je AI betrouwbaar is, moet je eigenlijk al beginnen na te denken over ethiek voordat je data verwerkt en algoritmen ontwikkelt.

Hoe je al ethisch kunt denken voordat je project begint

Ethiek moet vanaf het begin van een nieuw project in overweging worden genomen, vooral in de fase waarin het probleem wordt gedefinieerd. Je moet de beoogde eindgebruikers en het doel van de voorgestelde oplossing in gedachten houden om het juiste kader voor analyse en risicobeheer op te stellen om de directe of indirecte schade te identificeren die door de oplossing kan worden veroorzaakt. Je moet jezelf afvragen of mijn oplossing in deze omstandigheden kan leiden tot beslissingen die in het voordeel zijn van een bepaalde subgroep van eindgebruikers.

Het is dus van cruciaal belang om KPI's op te stellen om de methoden te volgen die de doeltreffendheid van je risicomanagementstrategie uitvoeren. Een robuust raamwerk kan waar mogelijk ook ethische risicobeperkingsmechanismen bevatten.

Als je te maken hebt met een gevoelig onderwerp met een hoog risicopotentieel, is het nodig om meer tijd te besteden aan de exploratie- en constructiefase om een grondige ethische beoordelingsanalyse en strategieën voor voorkeursbeperking in te voeren.

Je moet ook mechanismen instellen die de controleerbaarheid en reproduceerbaarheid van het AI systeem vergemakkelijken. Een logische trace moet beschikbaar zijn voor inspectie, zodat eventuele problemen kunnen worden herzien of verder onderzocht. Dit wordt gedaan door een goed niveau van traceerbaarheid af te dwingen via documentatie, logging, tracking en versiebeheer.

Elke data bron en data transformatie moet ook gedocumenteerd worden om de keuzes die gemaakt zijn om de data te verwerken transparant en traceerbaar te maken. Dit maakt het mogelijk om de stappen te lokaliseren die mogelijk een vooroordeel hebben geïnjecteerd of versterkt.

Hoe ethiek opnemen in de ontwikkeling van je data project

Om ethiek op te nemen in de ontwikkeling van je data project, is het belangrijk om ten minste drie componenten op te nemen: eerlijkheid, uitlegbaarheid en traceerbaarheid.

Eerlijkheid

De eerste stap in de meeste machine-leerprojecten is meestal data verzameling. Of het nu gaat om het verzamelen via data of het gebruiken van een bestaande dataset, kennis over hoe het verzamelen is uitgevoerd is cruciaal. Meestal is het niet haalbaar om de hele doelpopulatie te omvatten, dus kenmerken en labels kunnen worden bemonsterd uit een subset, gefilterd op bepaalde criteria of geaggregeerd. Al deze stappen kunnen statistische vertekeningen introduceren die ethische gevolgen kunnen hebben.

Vertekende vertegenwoordiging

ontstaat door de manier waarop we een populatie definiëren en bemonsteren. Het gebrek aan geografische diversiteit in datasets zoals ImageNet heeft bijvoorbeeld een vertekening naar Westerse landen aangetoond. Als gevolg van de vertekening door steekproeven, is het mogelijk dat trends die voor een bepaalde populatie zijn geschat, niet generaliseren naar data die is verzameld bij een nieuwe populatie.

Daarom is het nodig om de juiste data verzamelprotocollen te definiëren en de diversiteit van de ontvangen data te analyseren en aan het team te rapporteren over eventuele lacunes of risico's die worden ontdekt. Je moet data zo objectief mogelijk verzamelen. Bijvoorbeeld door er via statistische analyse voor te zorgen dat de steekproef representatief is voor de populatie of groep die je bestudeert en door zoveel mogelijk input uit meerdere bronnen te combineren om data diversiteit te garanderen.

Het documenteren van de bevindingen en het hele verzamelproces data is verplicht.

Er zijn in feite veel mogelijke bronnen van vooringenomenheid die kunnen bestaan in vele vormen, waarvan sommige kunnen leiden tot oneerlijkheid in verschillende downstream leertaken.

Aangezien de kern van gesuperviseerde algoritmen voor machinaal leren de training data is, kunnen modellen hun gedrag leren van data dat kan lijden onder de opname van onbedoelde historische of statistische vooroordelen. Historische vooroordelen kunnen binnensijpelen in het data generatieproces, zelfs bij een perfecte steekproeftrekking en selectie van kenmerken. Het voortbestaan van deze vooroordelen kan leiden tot onbedoelde discriminatie van bepaalde groepen of individuen, wat vooroordelen en marginalisatie kan verergeren.

Niet alle bronnen van vertekening zijn geworteld in data, de volledige pijplijn van machinaal leren omvat een reeks keuzes en praktijken onderweg, van data pre-processing tot het inzetten van modellen.

Het is niet eenvoudig om vanaf het begin vast te stellen of en hoe problemen kunnen ontstaan. Er is een grondige analyse nodig om opkomende problemen op te sporen. Afhankelijk van de use case, het type data en het doel van de taak, zullen verschillende methoden van toepassing zijn.

In dit hoofdstuk zullen we enkele technieken verkennen om ethische biais te identificeren en te beperken aan de hand van een illustratieve use case. Eerst beschrijven we het probleem, daarna bekijken we hoe we bias kunnen meten en tot slot gebruiken we een aantal technieken om bias te verminderen tijdens pre-processing, in-processing en post-processing.

Probleemstelling

Stel dat je in de banksector een scoringsalgoritme aan het bouwen bent om automatisch klanten targeting die al dan niet in aanmerking komen voor een premium deal. Je krijgt een historische dataset die veel kenmerken bevat van je betekenisvolle data over je klanten en het binaire doel "in aanmerking voor een premium deal". Elementen van PII (persoonlijk identificeerbare informatie) zijn eerder verwijderd uit de dataset, zodat er geen privacykwesties op het spel staan (wat dit betreft is de google cloud data loss prevention service een geweldig hulpmiddel om de-identificatie van je gevoelige data uit te voeren).

Deze use case lijkt misschien wat fictief, maar het probleem ligt dicht bij een echte use case die we in het verleden in een andere sector hebben behandeld.

Vertekening meten

De eerste stap van de analyse is het verkennen van de data om gevoelige kenmerken, bevoorrechte waarde en het gunstige label te identificeren.

Gevoelige kenmerken (of soms beschermde kenmerken genoemd) zijn kenmerken die een populatie verdelen in groepen die gelijk moeten zijn wat betreft de voordelen die ze ontvangen. Deze kenmerken kunnen discriminerend zijn voor bepaalde subgroepen. Bijvoorbeeld: geslacht, geslacht, leeftijd, gezinssituatie, sociaaleconomische classificatie, burgerlijke staat, enz. en elke proxy data die daarvan is afgeleid (bv. geografische locatie of factuurbedragen kunnen als proxies voor sociaaleconomische classificatie fungeren omdat in sommige situaties is waargenomen dat ze sterk gecorreleerd kunnen zijn) zijn gevoelige kenmerken.

Een bevoorrechte waarde van een gevoelig kenmerk duidt op een groep die historisch een systematisch voordeel heeft gehad.

Een gunstig label is een label waarvan de waarde een positief resultaat oplevert waar de ontvanger baat bij heeft. Tijdens de voorbereidingsfase van data kunnen stappen zoals het splitsen van de data, undersampling of oversampling, omgaan met ontbrekende waarden en uitschieters vertekening introduceren als ze niet zorgvuldig worden uitgevoerd. De proporties ontbrekende waarden of uitschieters bij subgroepen op gevoelige kenmerken kan een eerste stap zijn in het identificeren van vertekening. Sommige imputatiestrategieën kunnen statistische vertekening introduceren, bijvoorbeeld de imputatie van de ontbrekende waarden van het kenmerk leeftijd van de klant door de mediaan ervan.

In ons scorevoorbeeld hebben we de grafiek getekend van hoe de training data is verdeeld over de geslachten met betrekking tot het doel "in aanmerking komen voor een premium deal":

We kunnen zien dat de verdeling van het doel onevenwichtig is in het voordeel van het geslacht Man. Laten we veronderstellen dat de voorkeurswaarde Mannelijk is wanneer geslacht een gevoelig kenmerk is en het gunstige label "in aanmerking komt voor een premieaanbieding" is. Bovendien zou dit kunnen overeenkomen met een vertekening van de vertegenwoordiging in de data. In feite zou men, in een geval waarin gelijkheid wordt gerespecteerd, ervoor kunnen zorgen dat de verdelingen in de data volledig in evenwicht zijn of overeenkomen met de verdelingen in de demografische data.

Op dit punt zou je geneigd kunnen zijn om gewoon de gevoelige kenmerken uit je dataset te verwijderen, maar het is aangetoond dat het verwijderen van gevoelige kenmerken niet noodzakelijkerwijs voldoende is om je model eerlijk te maken. Het model kan andere kenmerken gebruiken die correleren met het verwijderde gevoelige kenmerk, waardoor historische vertekeningen worden gereproduceerd. Om een voorbeeld te geven: kenmerk A kan sterk gecorreleerd zijn aan de leeftijd van een klant, dus als de data bevooroordeeld is ten opzichte van een bepaalde leeftijdsgroep (historische vooringenomenheid kan leiden tot discriminatie op basis van leeftijd bij aanname, promotie etc.), dan wordt deze vooringenomenheid gecodeerd in kenmerk A en zal het verwijderen van de leeftijd van een klant het probleem niet verminderen. Door de gevoelige eigenschap in je data te houden, wanneer dat nodig is, heb je meer controle over het meten en beperken van vooroordelen en eerlijkheid.

Bias meetgegevens

Er zijn verschillende definities en maatstaven voor eerlijkheid. We kunnen eerlijkheid onderverdelen in individuele eerlijkheid en groeps eerlijkheid. Individuele eerlijkheid geeft gelijkaardige voorspellingen aan gelijkaardige individuen terwijl groepsrechtvaardigheid verschillende groepen gelijk behandelt.

Om groepsrechtvaardigheid te bereiken, willen we dat de waarschijnlijkheid van een positieve uitkomst hetzelfde is, ongeacht of de persoon tot de beschermde (bijv. vrouwelijke) groep behoort of niet.

Een eenvoudige groepsmeting is het vergelijken van het percentage gunstige uitkomsten voor de bevoorrechte en de niet-bevoorrechte groep (in ons voorbeeld het geslacht Man dat "in aanmerking komt voor een premieregeling" vergeleken met het geslacht Vrouw dat "in aanmerking komt voor een premieregeling"). Je kunt deze vergelijking berekenen als een verschil tussen de twee percentages, wat leidt tot de metriek voor statistische pariteitsverschillen (ook wel demografische pariteit genoemd):

Opdat er geen verschil zou zijn in gunstige resultaten tussen bevoorrechte en niet-bevoorrechte groepen, moet het statistische pariteitsverschil gelijk zijn aan 0.

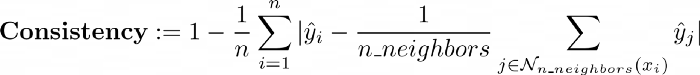

Op het gebied van individuele eerlijkheidsmetriek is er de consistentie die de mate van gelijkenis meet van labels voor gelijksoortige individuen met behulp van een nearest neighbor algoritme:

We zullen ons niet richten op dit onderwerp, maar de geïnteresseerde lezer zou dit artikel kunnen lezen.

Je kunt de handige library AIF360 gebruiken waarmee je veel eerlijkheidsmetrieken kunt berekenen.

Het enige wat je hoeft te doen is je dataframe in de StandardDataset te wikkelen. AIF360 gebruikt een StandardDataset die een Pandas DataFrame omhult met veel attributen en methoden die specifiek zijn voor het verwerken en meten van ethische vertekeningen. Je kunt dit dan gebruiken als invoer voor de klasse BinaryLabelDatasetMetric die een reeks nuttige statistieken berekent.

| params_aif = { | |

| "label_name": "eligible_for_a_premium_deal", | |

| "favorable_classes":[1], | |

| "protected_attribute_names": ["gender"], | |

| "privileged_classes": [[0]] # in ons geval is 0 Man en 1 Vrouw | |

| } | |

| # Creëer aif360 Standaarddatasets | |

| train_standard_dataset = StandardDataset(df=train_dataframe, | |

| **params_aif) | |

| privileged_groups = [{‘gender’: 0}] | |

| unprivileged_groups = [{‘gender’: 1}] | |

| train_bldm = BinaryLabelDatasetMetric(train_standard_dataset, | |

| unprivileged_groups=unprivileged_groups, | |

| privileged_groups=privileged_groups) |

Eenmaal gemeten op de training van ons scorende voorbeeld data, observeren we een gemiddeld statistisch pariteitsverschil van -0,21, wat aangeeft dat de bevoorrechte groep Man 21% meer positieve resultaten had in de training data set.

Beperking van vertekeningen

Methoden die gericht zijn op algoritmische vertekeningen worden meestal onderverdeeld in drie categorieën:

We gebruikten een voorbewerkingstechniek op de training data om het statistische pariteitsverschil te optimaliseren. We pasten het Reweighing-algoritme toe (meer details in dit artikel) dat in AIF360 is geïmplementeerd om de voorbeelden in elke combinatie (groep, label) anders te wegen om eerlijkheid vóór classificatie te garanderen.

RW = Opnieuw wegen(unprivileged_groups=unprivileged_groups,

geprivilegieerde_groepen=geprivilegieerde_groepen)

herwogen_train = RW.fit_transform(train_standard_dataset)

|

Het attribuut instance weight is gewijzigd om het gevoelige kenmerk opnieuw in evenwicht te brengen met betrekking tot het doel. Door dit te doen, heeft het herwegingsalgoritme de groepsvooringenomenheid op de training data verminderd: een nieuwe maat voor het statistische pariteitsverschil is volledig hergebalanceerd van -0,21 naar 0.

Er zijn andere voorbewerkingsalgoritmen voor biasmitigatie geïmplementeerd in AIF360, zoals de DisparateImpactRemover, een techniek die kenmerkwaarden bewerkt om de groepseerlijkheid te vergroten met behoud van de rangorde binnen groepen (meer info in het volgende artikel) of LFR (Learning fair representation), een voorbewerkingstechniek die een latente representatie vindt die de data codeert maar informatie over de beschermde kenmerken versluiert (meer info in het volgende artikel).

Vervolgens trainden we twee classificatiemodellen, een op de oorspronkelijke training data en de andere op de herwogen data. We zien dat herweging slechts een zwakke invloed had op de prestaties, met een verlies van 1% van de F1-score.

We hebben ook een in-processing algoritme uitgeprobeerd op onze voorbeeld use case: adversarial debiasing dat de groepsvertekeningsmetriek aanzienlijk verbeterde (het statistische pariteitsverschil werd gedeeld door 2) met weinig verslechtering van de modelprestaties (ongeveer 1% op de F1-score).

Er kan dus een compromis zijn tussen prestatie- en biasmetriek. Hier is de verslechtering vrij klein, maar in sommige situaties kan het compromis acuter zijn. Deze informatie moet aan het licht gebracht worden bij het team en de juiste belanghebbenden die beslissingen kunnen nemen over hoe om te gaan met deze kwestie.

Nu we getrainde modellen hebben, kunnen we hun voorspellingen onderzoeken en nagaan of er sprake is van onevenwichtigheid tussen de gunstige uitkomsten voor mannen en vrouwen. Er zijn veel tools zoals What-if of Aequitas waarmee je het gedrag van getrainde modellen voor machinaal leren kunt onderzoeken en de prestaties van het model en de eerlijkheid tussen subgroepen kunt onderzoeken.

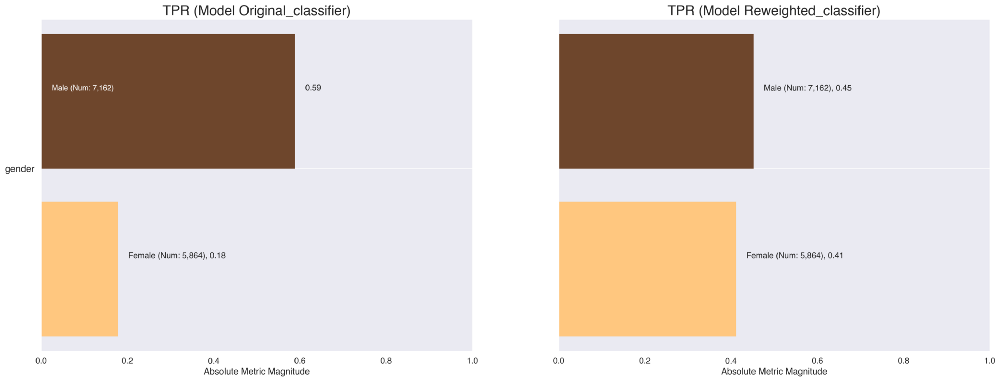

Ter illustratie kunt u Aequitas gebruiken om kruistabellen en visualisaties te genereren die verschillende bias- en prestatiecijfers presenteren, verdeeld over de subgroepen. We kunnen bijvoorbeeld snel de true positive percentages vergelijken van de classifiers die zijn getraind op de oorspronkelijke data en op de herwogen data. We zien dat dit percentage in evenwicht is gebracht en daardoor meer gendergelijkheid mogelijk maakt voor de gunstige uitkomst van het model om in aanmerking te komen voor een premium deal.

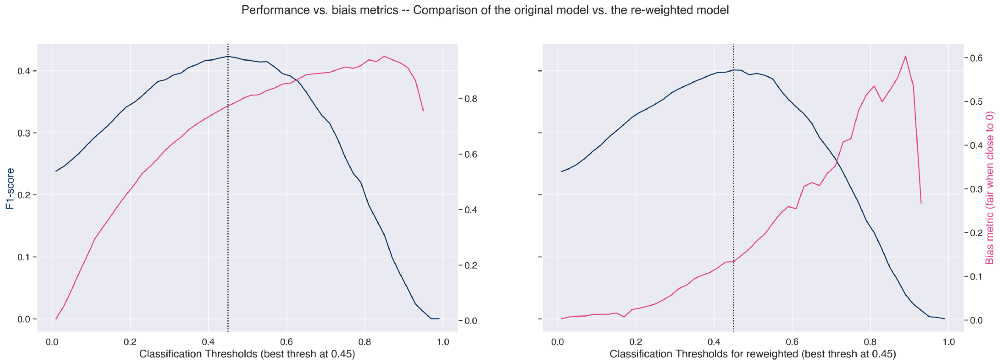

Als nabewerkingstechniek hebben we de classificatiedrempel gebruikt. Een classificatiemodel geeft ons gewoonlijk de waarschijnlijkheid die geassocieerd is met de realisatie van elke klasse als voorspelling. Deze waarschijnlijkheid kan als zodanig worden gebruikt of worden omgezet in een binaire waarde.

Om de klasse te identificeren die overeenkomt met de verkregen waarschijnlijkheden, moet een classificatiedrempel (ook beslissingsdrempel genoemd) worden gedefinieerd. Elke waarde boven deze drempel komt overeen met de positieve categorie "komt in aanmerking voor een premiedeal" en omgekeerd voor waarden onder deze drempel.

Door de prestatiedrempel en de vertekeningsdrempel (hier 1 - ongelijke impact) over alle classificatiedrempels uit te zetten, kunnen we de optimale drempel bepalen. Dit helpt ons de juiste drempel te kiezen om de prestatie te maximaliseren en de vertekening te minimaliseren.

Op de linkerfiguur zien we dat als we de drempel naar links verschuiven, waardoor de prestaties iets afnemen, we de bias meten kunnen verbeteren.

Ook zien we, zoals verwacht, een duidelijke verbetering van de groepsbias metriek op het herwogen model (rechter figuur) dat verder kan worden verbeterd door een andere classificatiedrempel te kiezen, maar ten koste van de prestaties.

Verklaarbaarheid

Een andere belangrijke pijler voor het bouwen van betrouwbare modellen voor machinaal leren is de verklaarbaarheid. Uitlegbaarheid is het vermogen om zowel de technische processen van het AI systeem als de redenering achter de beslissingen of voorspellingen die het AI systeem maakt, uit te leggen en dus de invloed van elk kenmerk/attribuut op de voorspellingen te kunnen kwantificeren. Het is een goede gewoonte om zoveel mogelijk gebruik te maken van gemakkelijk interpreteerbare modellen in plaats van black-box modellen.

Er zijn veel methoden om de verklaarbaarheid van modellen te verkrijgen. Deze methoden kunnen gegroepeerd worden in 2 categorieën:

Hier passen we een beroemde post-hocmethode toe, namelijk SHAP (SHapley Additive exPlanations). Voor meer informatie raden we aan deze zeer uitgebreide bron over dit onderwerp te verkennen. Shap is een bibliotheek die een speltheoretische benadering implementeert om de uitvoer van eender welk machine-learningmodel te verklaren.

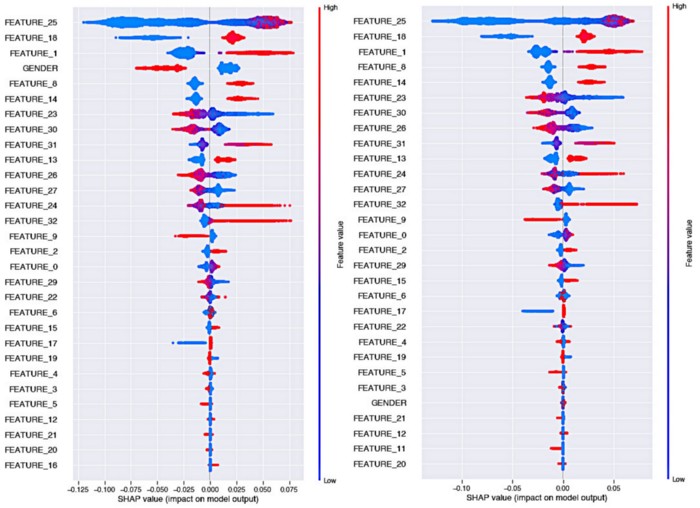

Laten we eens kijken naar de invloed van het Reweighing-algoritme op de verklaarbaarheid van het model:

Even een geheugensteuntje om de bijenwarme plots van Shap te lezen:

Links zien we de verklaarbaarheid van het oorspronkelijke model, waarbij we zien dat in dit geval de geslachtsvariabele een zeer sterke voorspellende kracht heeft en dat het geslacht Vrouw een impact heeft die de beslissing beïnvloedt in de richting van het doel "niet in aanmerking komen voor een premiedeal", met een grote kloof ten opzichte van het geslacht Man.

We zien in de rechter grafiek, in dit geval waar het model werd getraind op de herwogen data, dat het belang van het geslachtkenmerk sterk is afgenomen. Het behoort nu tot de minst belangrijke kenmerken. Bovendien is de invloed van de vrouwelijke versus mannelijke klasse op de voorspelling van het doel veel evenwichtiger (de kleuren liggen dicht bij 0 in Shapley-waarde).

Traceerbaarheid

Een ander essentieel aspect in het proces van het creëren van betrouwbare algoritmen voor machinaal leren is de traceerbaarheid van resultaten en goede reproduceerbaarheid van experimenten. Hierdoor kan eenvoudig worden vastgesteld welke versie van een model in productie is genomen, zodat het kan worden gecontroleerd als het gedrag ervan schade veroorzaakt en niet langer in overeenstemming is met de ethische waarden van organisatie.

Om dit te kunnen doen, moet men elke modelversie en de bijbehorende training data, hyperparameters en resultaten kunnen bijhouden en vastleggen. Verschillende tools kunnen deze taak uitvoeren: Mlflow is een geweldige optie waarmee je snel een webinterface kunt genereren die alle runs centraliseert, terwijl je artefacten worden opgeslagen in de opslag van je keuze. Elke versie van het experiment kan gevolgd worden met de hash van de bijbehorende commit. Elk van deze versies bevat alle elementen die door MLflow zijn vastgelegd.

Hier is een tool die we hebben geopend op Artefact waarmee je een beveiligde MLflow kunt implementeren op een GCP project met een enkel commando.

Het is ook een goede gewoonte om voor elk model een FactSheet te maken, wat overeenkomt met een modelidentiteitskaart die verschillende elementen samenvat, zoals de voorbewerkingsstappen, prestatiemetingen, biasmetingen, enz.

Deze identiteitskaarten worden door de wetenschappers van data geleverd aan de modeluitvoeringsteams, zodat zij kunnen bepalen of het model geschikt is voor hun situatie. Voor meer details over de methodologie voor het maken van een FactSheet raden we dit artikel aan. De FactSheet kan ook worden opgeslagen, bijvoorbeeld in tabelvorm, in MLFlow naast het bijbehorende model.

Hoe ethische kwesties op te volgen wanneer ze eenmaal zijn geïmplementeerd

Zodra je model wordt ingezet, moet je ervoor zorgen dat het wordt gebruikt voor het doel waarvoor het is bedacht, ontworpen en gebouwd. Deployment bias treedt op wanneer er een mismatch is tussen het probleem dat een model moet oplossen en de manier waarop het daadwerkelijk wordt gebruikt. Dit gebeurt vaak als een systeem wordt ontwikkeld en geëvalueerd alsof het volledig op zichzelf staat, terwijl het in werkelijkheid deel uitmaakt van een complex socio-technisch systeem dat wordt bestuurd door een groot aantal besluitvormers.

Productie data kan in de loop van de tijd afwijken, wat kan resulteren in een verslechtering van de algoritmeprestaties waardoor vertekeningen kunnen ontstaan. Het bijhouden van de kwaliteit van de productie data en data drift door het monitoren van de distributies van nieuwe data vergeleken met de data die gebruikt is om de modellen te trainen, moet een stap zijn in de productiepijplijn om de juiste waarschuwingen te geven wanneer dat nodig is en te bepalen wanneer hertraining verplicht is.

De productiepijplijn moet zo worden ontworpen dat er een manier is om het huidige model uit te schakelen of terug te gaan naar een vorige versie.

Conclusie

In dit artikel hebben we een aantal goede praktijken en protocollen gepresenteerd om je te begeleiden bij het bouwen van machine learning-pijplijnen die het risico om in ethische valkuilen te trappen minimaliseren.

In dit artikel hebben we nauwelijks de oppervlakte van het enorme onderwerp dat ethisch AI is, betreden en hebben we slechts een paar van de interessante hulpmiddelen aangeraakt die nu worden ontwikkeld en beschikbaar zijn.

Zoals we gezien hebben, is de meest logische manier om problemen met eerlijkheid expliciet aan te pakken om een verzameling geselecteerde kenmerken als potentieel discriminerend te bestempelen en vervolgens door dit prisma ethische vooringenomenheid te onderzoeken. Deze eenvoudige techniek heeft echter een fout: discriminatie kan het resultaat zijn van een combinatie van kenmerken die op zichzelf niet discriminerend zijn. Bovendien heb je in veel gevallen geen toegang tot gevoelige kenmerken (meer hierover hier).

Het beoordelen van eerlijkheid is een complexe taak die afhankelijk is van de aard van het probleem. Het benaderen van een scoringsprobleem op basis van data in tabelvorm is niet hetzelfde als het beperken van vooroordelen in natuurlijke taalverwerking.

We hopen dat het delen van onze visie en methodologieën u zal inspireren in uw eigen projecten! Bedankt voor het lezen. Aarzel niet om de Artefact tech blog te volgen als u op de hoogte wilt blijven wanneer ons volgende artikel verschijnt!

BLOG

BLOG