He aquí algunas pautas para crear soluciones de aprendizaje automático fiables sin caer en trampas éticas.

Introducción

El uso del aprendizaje automático como medio para la toma de decisiones se ha convertido en omnipresente. Muchos de los productos de los servicios que utilizamos a diario son el resultado de una decisión tomada por el aprendizaje automático. Como consecuencia, estamos asistiendo a una reducción gradual de la intervención humana en áreas que afectan a todos los aspectos de nuestra vida cotidiana y en las que cualquier fallo en el juicio del modelo algorítmico podría tener implicaciones adversas. Por lo tanto, es esencial establecer directrices adecuadas para construir soluciones de aprendizaje automático fiables y responsables, teniendo en cuenta la ética como pilar fundamental.

En los últimos años, la ética en el aprendizaje automático ha experimentado un importante auge en la investigación académica, con grandes conferencias como FACCT y AIES, así como en grandes empresas tecnológicas que están creando equipos de rápido crecimiento para abordar los retos éticos.

La ética AI es un tema amplio que abarca muchos aspectos, como la privacidad, la gobernanza data , el bienestar social y medioambiental, la responsabilidad algorítmica, etc. En este artículo nos centraremos principalmente en los siguientes componentes de la ética en el aprendizaje automático: imparcialidad, explicabilidad y trazabilidad. En primer lugar, analizaremos lo que está en juego y por qué es obligatorio prestar atención a la ética; a continuación, exploraremos cómo enmarcar y desarrollar su proyecto de aprendizaje automático teniendo en cuenta la ética y cómo realizar un seguimiento de la ética una vez desplegado en la producción.

Por qué debemos prestar atención a la ética

Los algoritmos de aprendizaje automático y el conjunto de abstracciones e hipótesis en que se basan son cada vez más complejos, por lo que resulta difícil comprender todas las posibles consecuencias del sistema en su conjunto.

Ha habido varios ejemplos reales muy sonados de algoritmos de aprendizaje automático injustos que han dado lugar a resultados subóptimos y discriminatorios. Entre ellos, el conocido ejemplo de COMPAS. COMPAS era un programa informático comercial muy utilizado que mide el riesgo de que una persona vuelva a delinquir, que se comparó con el juicio humano normal en un estudio y más tarde se descubrió que estaba sesgado en contra de los afroamericanos: El COMPAS era más propenso a asignar una puntuación de riesgo más alta a los delincuentes afroamericanos que a los caucásicos con el mismo perfil.

En el campo de la PNL, se detectó biais de género en las primeras versiones de Google Translate que se abordó en 2018 y más recientemente.

En el ámbito de la atribución de créditos, Goldman Sachs estaba siendo investigado por utilizar un algoritmo AI que supuestamente discriminaba a las mujeres al conceder límites de crédito más elevados a los hombres que a las mujeres en sus tarjetas Apple.

En el ámbito de la sanidad, un algoritmo de predicción de riesgos utilizado en más de 200 millones de personas en Estados Unidos demostró un sesgo racial.

Sin un marco claramente definido sobre cómo analizar, identificar y mitigar los sesgos, los riesgos de caer en trampas éticas pueden ser bastante elevados. Por ello, es cada vez más importante establecer directrices adecuadas para construir modelos que produzcan resultados que sean apropiados y justos, sobre todo en los ámbitos en los que intervienen personas. Construir un AI de confianza hace que los usuarios finales se sientan seguros cuando lo utilizan, y permite a las empresas ejercer un mayor control sobre su uso con el fin de aumentar la eficiencia evitando al mismo tiempo cualquier perjuicio. Para que su AI sea digno de confianza, en realidad necesita empezar a pensar en la ética incluso antes de procesar data y desarrollar algoritmos.

Cómo pensar en la ética incluso antes de empezar el proyecto

La ética debe tenerse en cuenta desde el principio de un nuevo proyecto, sobre todo en la fase de planteamiento del problema. Debe tener en mente los usuarios finales a los que va dirigida, así como el objetivo de la solución propuesta, para establecer el marco de análisis y gestión de riesgos adecuado para identificar los daños directos o indirectos que puede inducir la solución. Hay que preguntarse si, en estas condiciones, mi solución podría dar lugar a decisiones sesgadas a favor de un determinado subgrupo de usuarios finales.

Por lo tanto, es fundamental crear indicadores clave de rendimiento para realizar un seguimiento de los métodos que llevan a cabo la eficacia de su estrategia de gestión de riesgos. Un marco sólido también podría incorporar, cuando sea posible, un mecanismo de reducción del riesgo ético.

Cuando se trata de un tema delicado que tiene un alto potencial de riesgo, es necesario ampliar el tiempo asignado a la fase de exploración y construcción con el fin de inyectar un análisis exhaustivo de evaluación ética y estrategias de mitigación de sesgos.

También debe establecer mecanismos que faciliten la auditabilidad y reproducibilidad del sistema AI . La traza lógica debe estar disponible para su inspección, de modo que cualquier problema pueda ser revisado o investigado más a fondo. Para ello, hay que garantizar un buen nivel de trazabilidad mediante la documentación, el registro, el seguimiento y el control de versiones.

Cada fuente de data y cada transformación de data también deben documentarse para que las decisiones tomadas para procesar data sean transparentes y rastreables. De este modo, es posible determinar con precisión las etapas que pueden haber inyectado o reforzado un sesgo.

Cómo incluir la ética en el desarrollo de su proyecto data

Para incluir la ética en el desarrollo de su proyecto data , es importante incluir al menos tres componentes: imparcialidad, explicabilidad y trazabilidad.

Equidad

El primer paso en la mayoría de los proyectos de aprendizaje automático suele ser la recopilación de data . Tanto si se sigue el proceso de recopilación de data como si se utiliza un conjunto de datos existente, es fundamental conocer cómo se ha realizado la recopilación. Por lo general, no es factible incluir a toda la población objetivo, por lo que las características y las etiquetas podrían muestrearse a partir de un subconjunto, filtrarse en función de algunos criterios o agregarse. Todos estos pasos pueden introducir sesgos estadísticos que pueden tener consecuencias éticas.

Sesgo de representación

surge de la forma en que definimos y muestreamos una población. Por ejemplo, la falta de diversidad geográfica en conjuntos de datos como ImageNet ha demostrado un sesgo hacia los países occidentales. Como resultado del sesgo de muestreo, las tendencias estimadas para una población pueden no generalizarse a data recogidas de una nueva población.

De ahí la necesidad de definir protocolos adecuados de recogida de data y de analizar la diversidad de los data recibidos e informar al equipo de las lagunas o riesgos detectados. Es necesario recoger data de la forma más objetiva posible. Por ejemplo, asegurándose, mediante algún análisis estadístico, de que la muestra es representativa de la población o grupo que se está estudiando y, en la medida de lo posible, combinando aportaciones de múltiples fuentes para garantizar la diversidad de data .

Es obligatorio documentar las conclusiones y todo el proceso de recogida de data .

De hecho, hay muchas fuentes posibles de sesgo que pueden existir de muchas formas, algunas de las cuales pueden dar lugar a injusticias en diferentes tareas de aprendizaje descendente.

Dado que el núcleo de los algoritmos de aprendizaje automático supervisado es el entrenamiento data, los modelos pueden aprender su comportamiento a partir de data , que puede sufrir la inclusión de sesgos históricos o estadísticos no intencionados. Los sesgos históricos pueden filtrarse en el proceso de generación de data incluso con un muestreo y una selección de características perfectos. La persistencia de estos sesgos podría dar lugar a una discriminación involuntaria contra determinados grupos o individuos, lo que puede exacerbar los prejuicios y la marginación.

No todas las fuentes de sesgo tienen su origen en data, el proceso completo de aprendizaje automático implica una serie de elecciones y prácticas a lo largo del camino, desde el preprocesamiento de data hasta la implantación del modelo.

No es fácil identificar desde el principio si pueden surgir problemas y cómo. Se necesita un análisis exhaustivo para identificar los problemas que puedan surgir. Dependiendo del caso de uso, del tipo de data y del objetivo de la tarea, se aplicarán distintos métodos.

En esta sección, exploraremos algunas técnicas para identificar y mitigar los biais éticos a través de un caso de uso ilustrativo. Primero plantearemos el problema, luego veremos cómo medir el sesgo y, por último, utilizaremos algunas técnicas para mitigar el sesgo durante el preprocesamiento, el procesamiento y el postprocesamiento.

Planteamiento del problema

Supongamos que está creando un algoritmo de scoring en el sector bancario para automatizar la targeting de clientes que se beneficiarán o no de un acuerdo premium. Se le da un conjunto de datos históricos que contiene muchas características sobre sus data significativos acerca de sus clientes, así como el objetivo binario "elegible para un acuerdo premium". Los elementos de PII (información personal identificable) se han eliminado previamente del conjunto de datos, por lo que no habrá ningún problema de privacidad en juego (a este respecto, el servicio de prevención de pérdida dedata cloud de google es una gran herramienta para realizar la tarea de desidentificación de sus data sensibles).

Este caso de uso puede parecer algo ficticio, pero el problema se acerca a un caso de uso real que tratamos en el pasado en un sector diferente.

Medición del sesgo

El primer paso del análisis consiste en explorar la página data para identificar las características sensibles, el valor privilegiado y la etiqueta favorable.

Las características sensibles (o a veces denominadas atributos protegidos) son características que dividen a una población en grupos que deberían tener paridad en cuanto a los beneficios recibidos. Estas características pueden tener un potencial discriminatorio hacia determinados subgrupos. Por ejemplo: el sexo, el género, la edad, la situación familiar, la clasificación socioeconómica, el estado civil, etc. y cualquier aproximación data derivada de ellos (por ejemplo, la ubicación geográfica o el importe de la factura pueden actuar como aproximaciones a la clasificación socioeconómica, ya que se ha observado en algunas situaciones que pueden estar fuertemente correlacionados) son características sensibles.

Un valor privilegiado de un rasgo sensible denota un grupo que ha tenido, históricamente, una ventaja sistemática.

Una etiqueta favorable es una etiqueta cuyo valor proporciona un resultado positivo que beneficia al destinatario.Durante la fase de preparación de data , pasos como la división de data, el submuestreo o el sobremuestreo, el tratamiento de los valores perdidos y los valores atípicos podrían introducir sesgos si no se llevan a cabo con cuidado. Las proporciones de valores perdidos o valores atípicos en los subgrupos de características sensibles pueden ser un primer paso para identificar el sesgo. Algunas estrategias de imputación pueden introducir sesgos estadísticos, por ejemplo, imputar los valores perdidos de la característica edad del cliente por su mediana.

En nuestro ejemplo de puntuación, dibujamos el gráfico de cómo se distribuye la formación data entre géneros con respecto al objetivo "elegible para un acuerdo premium" :

Podemos ver que la distribución del objetivo está desequilibrada a favor del género Masculino. Formulemos la hipótesis de que el valor de privilegio es Masculino cuando el género es una característica sensible y la etiqueta favorable es "elegible para un trato preferente". Además, esto podría corresponder a un sesgo de representación en el data. De hecho, en un caso en el que se respete la equidad, se podría asegurar que las distribuciones en el data están totalmente equilibradas o corresponden a las distribuciones en el data demográfico.

Llegados a este punto, puede que tenga la tentación de descartar simplemente las características sensibles de su conjunto de datos, pero se ha demostrado que la eliminación de atributos sensibles no es necesariamente suficiente para que su modelo sea justo. El modelo podría utilizar otras características correlacionadas con la característica sensible eliminada, reproduciendo sesgos históricos. Por poner un ejemplo, una característica A podría estar fuertemente correlacionada con la edad de un cliente, de modo que si data tiene un sesgo hacia una determinada franja de edad (el sesgo histórico podría dar lugar a discriminación por motivos de edad en la contratación, promoción, etc.) este sesgo se codificará en la característica A y la eliminación de la edad de un cliente no aliviará el problema. Si mantiene la característica sensible en su data, cuando sea necesario, podrá tener un mayor control sobre las mediciones y la mitigación del sesgo y la imparcialidad.

Métricas de sesgo

Existen varias definiciones y medidas de la equidad. Podemos dividir la equidad en equidad individual y equidad de grupo. La equidad individual ofrece predicciones similares a individuos similares, mientras que la equidad de grupo trata por igual a grupos diferentes.

Para lograr la equidad de grupo, queremos que la probabilidad de un resultado positivo sea la misma independientemente de si la persona pertenece al grupo protegido (por ejemplo, femenino) o no.

Una métrica de grupo sencilla consiste en comparar el porcentaje de resultados favorables para los grupos privilegiados y no privilegiados (en nuestro ejemplo, el género Masculino que es "elegible para un acuerdo premium" comparado con el género Femenino que es "elegible para un acuerdo premium"). Puede calcular esta comparación como una diferencia entre los dos porcentajes, lo que da lugar a la métrica de diferencia de paridad estadística (también denominada paridad demográfica):

Para que no haya diferencias en los resultados favorables entre grupos privilegiados y no privilegiados, la diferencia de paridad estadística debe ser igual a 0.

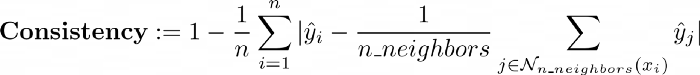

En cuanto a la métrica de equidad individual, existe la consistencia, que mide el grado de similitud de las etiquetas de individuos similares mediante un algoritmo de vecino más próximo:

No nos centraremos en este tema, pero el lector interesado puede consultar este artículo.

Puede utilizar la práctica biblioteca AIF360 que le permite calcular muchas métricas de equidad.

Todo lo que tienes que hacer es envolver tu dataframe en el StandardDataset. AIF360 utiliza un StandardDataset que envuelve un Pandas DataFrame con muchos atributos y métodos específicos para procesar y medir los sesgos éticos. A continuación, puede utilizar esto como una entrada a la clase BinaryLabelDatasetMetric que calculará un conjunto de métricas útiles.

| params_aif = { | |

| "label_name": "eligible_for_a_premium_deal", | |

| "clases_favorables":[1], | |

| "protected_attribute_names": ["género"], | |

| "privileged_classes": [[0]] # en nuestro caso, 0 es Masculino y 1 es Femenino | |

| } | |

| # Crear aif360 StandardDatasets | |

| train_standard_dataset = StandardDataset(df=marco_datos_entrenamiento, | |

| **Parámetros_aif) | |

| privileged_groups = [{‘gender’: 0}] | |

| unprivileged_groups = [{‘gender’: 1}] | |

| train_bldm = BinaryLabelDatasetMetric(train_standard_dataset, | |

| unprivileged_groups=grupos_no_privilegiados, | |

| privileged_groups=grupos_privilegiados) |

Una vez medido en el entrenamiento de nuestro ejemplo de puntuación data, observamos una diferencia de paridad estadística media de -0,21, lo que indica que el grupo privilegiado Male obtuvo un 21% más de resultados positivos en el conjunto de entrenamiento data .

Mitigación de sesgos

Los métodos que abordan los sesgos algorítmicos suelen dividirse en tres categorías:

Utilizamos una técnica de preprocesamiento en el entrenamiento data para optimizar la diferencia de paridad estadística. Aplicamos el algoritmo Reweighing (más detalles en este artículo) que se implementa en AIF360 con el fin de ponderar los ejemplos de manera diferente en cada combinación (grupo, etiqueta) para garantizar la equidad antes de la clasificación.

RW = Reweighing(unprivileged_groups=grupos_no_privilegiados,

privileged_groups=grupos_privilegiados)

reweighted_train = RW.fit_transform(train_standard_dataset)

|

El atributo de pesos de instancia se ha modificado para reequilibrar la característica sensible con respecto al objetivo. Al hacerlo, el algoritmo Reweighing mitigó el sesgo de grupo en la formación data: una nueva medida de la diferencia de paridad estadística se reequilibra completamente de -0,21 a 0.

Existen otros algoritmos de mitigación de sesgos de preprocesamiento implementados en AIF360, como el DisparateImpactRemover que es una técnica que edita los valores de las características para aumentar la imparcialidad de los grupos mientras preserva el orden de rango dentro de los grupos (más información en el siguiente artículo) o LFR (Learning fair representation) que es una técnica de preprocesamiento que encuentra una representación latente que codifica el data pero oscurece la información sobre los atributos protegidos (más información en el siguiente artículo).

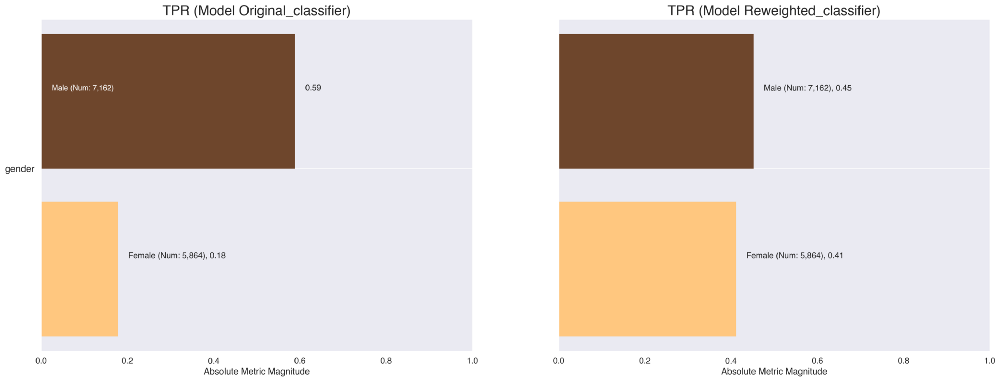

A continuación, entrenamos dos modelos clasificadores, uno en el data de entrenamiento original y otro en el data reponderado. Observamos que la reponderación sólo tuvo un impacto débil en el rendimiento, con una pérdida del 1% de la puntuación F1.

También probamos un algoritmo de procesamiento interno en nuestro caso de uso de ejemplo: debiasing adversarial que mejoró significativamente las métricas de sesgo de grupo (la diferencia de paridad estadística se dividió por 2) con poco deterioro en el rendimiento del modelo (alrededor del 1% en la puntuación F1).

Por tanto, puede haber un compromiso entre las métricas de rendimiento y sesgo. Aquí el deterioro es bastante pequeño, pero en algunas situaciones el compromiso podría ser más agudo. Esta información debe ponerse en conocimiento del equipo y de las partes interesadas adecuadas, que podrán tomar decisiones sobre cómo abordar esta cuestión.

Ahora que tenemos modelos entrenados, podemos explorar sus predicciones e investigar el desequilibrio hacia el resultado favorable entre géneros. Existen muchas herramientas, como What-if tool o Aequitas, que permiten sondear el comportamiento de los modelos de aprendizaje automático entrenados e investigar el rendimiento del modelo y la equidad entre subgrupos.

A título ilustrativo, puede utilizar Aequitas para generar tablas cruzadas y visualizaciones que presenten diversas métricas de sesgo y rendimiento distribuidas entre los subgrupos. Por ejemplo, podemos comparar rápidamente las tasas de verdaderos positivos de los clasificadores que se entrenaron en el data original y en el data reponderado. Vemos que esta tasa se ha equilibrado y, por tanto, permite una mayor equidad de género hacia el resultado favorable del modelo de poder optar a un acuerdo premium.

Como técnica de posprocesamiento, interactuamos con el umbral de clasificación. Un modelo de clasificación suele proporcionarnos las probabilidades asociadas a la realización de cada clase como predicción. Esta probabilidad puede utilizarse tal cual o convertirse en un valor binario.

Para identificar la clase correspondiente a las probabilidades obtenidas, hay que definir un umbral de clasificación (también llamado umbral de decisión). Cualquier valor por encima de este umbral corresponderá a la categoría positiva "tiene derecho a un trato preferente" y viceversa para los valores por debajo de este umbral.

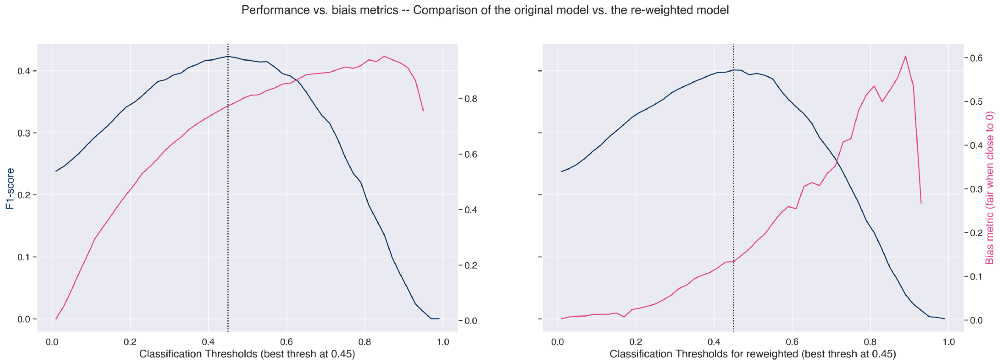

Trazando la métrica de rendimiento y la métrica de sesgo (aquí 1 - impacto dispar) a través de todos los umbrales de clasificación, podemos definir el umbral óptimo. Esto nos ayuda a elegir el umbral adecuado para maximizar el rendimiento y minimizar el sesgo.

En la figura de la izquierda vemos que si empujamos el umbral hacia la izquierda, bajando así un poco el rendimiento, podemos mejorar en la métrica de sesgo.

También, como era de esperar, observamos una clara mejora de la métrica de sesgo de grupo en el modelo reponderado (figura derecha), que podría mejorarse aún más eligiendo otro umbral de clasificación, pero a expensas del rendimiento.

Explicabilidad

Otro pilar fundamental para crear modelos de aprendizaje automático fiables es la explicabilidad. La explicabilidad es la capacidad de explicar tanto los procesos técnicos del sistema AI como el razonamiento que subyace a las decisiones o predicciones que realiza el sistema AI , pudiendo así cuantificar la influencia de cada característica/atributo en las predicciones. Utilizar en la medida de lo posible modelos fácilmente interpretables en lugar de modelos de caja negra es una buena práctica.

Existen muchos métodos para obtener la explicabilidad de los modelos. Estos métodos pueden agruparse en 2 categorías:

Aquí aplicaremos un famoso método post-hoc, concretamente SHAP (SHapley Additive exPlanations), para más información recomendamos explorar este recurso muy completo sobre el tema. Shap es una librería que implementa un enfoque teórico de juegos para explicar la salida de cualquier modelo de aprendizaje automático.

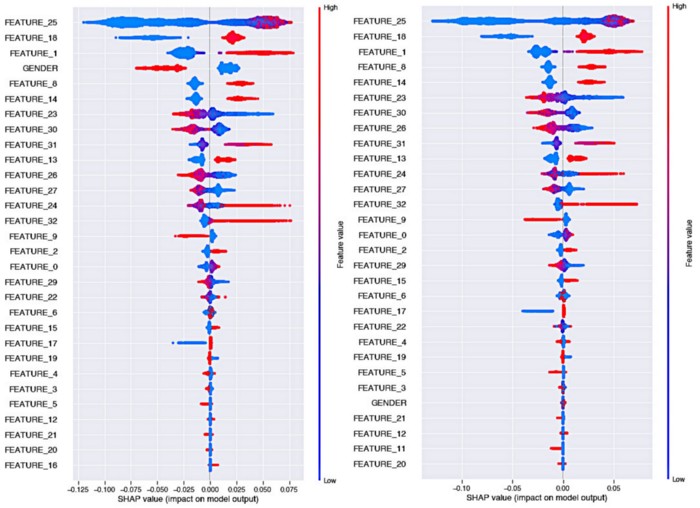

Observemos el impacto del algoritmo Reweighing en la explicabilidad del modelo:

Recordatorio rápido sobre cómo leer las tramas de abejas de Shap:

A la izquierda, tenemos la explicabilidad del modelo original donde observamos que en este caso la variable de género tiene un poder predictivo muy fuerte y que el género Femenino tiene un impacto que influye en la decisión hacia el objetivo "no elegible para un acuerdo premium" con una gran diferencia con respecto al género Masculino.

Podemos ver en el gráfico de la derecha, en este caso en el que el modelo se entrenó con la nueva ponderación de data, que la importancia de la característica de género ha disminuido considerablemente. Ahora forma parte de las características menos importantes. Además, la influencia de la clase femenina frente a la masculina en la predicción del objetivo está mucho más equilibrada (los colores se acercan a 0 en el valor de Shapley).

Trazabilidad

Otro aspecto esencial en el proceso de creación de algoritmos de aprendizaje automático fiables es la trazabilidad de los resultados y la buena reproducibilidad de los experimentos. Esto facilita la identificación de la versión de un modelo que se ha puesto en producción, de modo que pueda auditarse si su comportamiento causa daños y deja de ajustarse a los valores éticos de Compañia.

Para ello, hay que ser capaz de rastrear y registrar cada versión del modelo y su entrenamiento asociado data, hiperparámetros y resultados. Varias herramientas pueden llevar a cabo esta tarea: Mlflow es una gran opción que permite generar rápidamente una interfaz web que centraliza todas las ejecuciones, al tiempo que guarda los artefactos en el almacenamiento de su elección. Cada versión del experimento puede rastrearse con el hash del commit asociado. Cada una de estas versiones contendrá todos los elementos registrados por MLflow.

Aquí tienes una herramienta de código abierto en Artefact que te permite desplegar un MLflow seguro en un proyecto GCP con un solo comando.

También es una buena práctica crear una FactSheet para cada modelo, que corresponde a una tarjeta de identidad del modelo que resume varios elementos que trazan los pasos de preprocesamiento, las métricas de rendimiento, las métricas de sesgo, etc.

Estas fichas son entregadas por los científicos de data a los equipos operativos de los modelos, lo que les permite determinar si el modelo es adecuado para su situación. Para más detalles sobre la metodología de creación de una FactSheet recomendamos este artículo. La FactSheet también puede almacenarse, en forma tabular por ejemplo, en MLFlow junto con el modelo asociado.

Cómo hacer un seguimiento de la ética una vez desplegada

Una vez desplegado el modelo, hay que asegurarse de que se utiliza para el fin para el que fue pensado, diseñado y construido. El sesgo de despliegue se produce cuando hay un desajuste entre el problema que se pretende resolver con un modelo y la forma en que se utiliza realmente. Suele ocurrir cuando un sistema se desarrolla y evalúa como si fuera totalmente autónomo, cuando en realidad forma parte de un complejo sistema sociotécnico regido por un gran número de responsables.

La producción de data puede desviarse con el tiempo, lo que puede dar lugar a una degradación del rendimiento del algoritmo que podría inyectar sesgo. El seguimiento de la calidad de la producción de data y la desviación de data mediante la supervisión de las distribuciones de los nuevos data en comparación con los data utilizados para entrenar los modelos, debería ser un paso en la cadena de producción para emitir las alertas adecuadas cuando sea necesario y definir cuándo es obligatorio el reentrenamiento.

La cadena de producción debe diseñarse de modo que exista una forma de desactivar el modelo actual o volver a una versión anterior.

Conclusión

En este artículo hemos presentado algunas buenas prácticas y protocolos para guiarle en la construcción de pipelines de aprendizaje automático que minimicen el riesgo de caer en trampas éticas.

Este artículo apenas ha arañado la superficie del vasto tema que es la ética AI y sólo se ha limitado a tocar algunas de las interesantes herramientas que se están desarrollando y que ya están disponibles.

Como hemos visto, la forma más lógica de abordar explícitamente los problemas de equidad es declarar una colección de características seleccionadas como potencialmente discriminatorias y luego investigar a través de este prisma el sesgo ético. Esta técnica directa, sin embargo, tiene un fallo y es que la discriminación puede ser el resultado de una combinación de características que no son discriminatorias por sí solas. Además, en muchos casos no se tendrá acceso a ningún rasgo sensible (más sobre este tema aquí).

La evaluación de la equidad es una tarea compleja que depende de la naturaleza del problema. Abordar un problema de puntuación basado en la tabulación data no será lo mismo que mitigar el sesgo en el procesamiento del lenguaje natural.

Esperamos que compartir nuestra perspectiva y metodologías le sirva de inspiración en sus propios proyectos. Gracias por leernos, ¡no dude en seguir el blog Artefact tech si desea que le avisemos cuando publiquemos nuestro próximo artículo!

BLOG

BLOG