Im Folgenden finden Sie einige Leitlinien für den Aufbau vertrauenswürdiger Lösungen für maschinelles Lernen, ohne in ethische Fallen zu tappen.

Einführung

Der Einsatz des maschinellen Lernens als Mittel zur Entscheidungsfindung ist inzwischen allgegenwärtig. Viele der Ergebnisse von Diensten, die wir täglich nutzen, sind das Ergebnis einer durch maschinelles Lernen getroffenen Entscheidung. Infolgedessen werden menschliche Eingriffe in Bereichen, die jeden Aspekt unseres täglichen Lebens betreffen und in denen jeder Fehler im Urteil des algorithmischen Modells nachteilige Auswirkungen haben könnte, allmählich reduziert. Es ist daher von entscheidender Bedeutung, angemessene Leitlinien für die Entwicklung vertrauenswürdiger und verantwortungsbewusster Lösungen für das maschinelle Lernen festzulegen und dabei die Ethik als einen der wichtigsten Pfeiler zu berücksichtigen.

In den letzten Jahren hat die Ethik im Bereich des maschinellen Lernens in der akademischen Forschung mit großen Konferenzen wie FACCT und AIES sowie in großen Technologieunternehmen, die schnell wachsende Teams zur Bewältigung der ethischen Herausforderungen zusammenstellen, einen erheblichen Aufschwung erlebt.

Ethik AI ist ein weites Feld, das viele Themen wie Datenschutz, data governance, gesellschaftliches und ökologisches Wohlergehen, algorithmische Verantwortlichkeit usw. umfasst. In diesem Artikel werden wir uns hauptsächlich auf die folgenden Komponenten der Ethik beim maschinellen Lernen konzentrieren: Fairness, Erklärbarkeit und Nachvollziehbarkeit. Wir werden zunächst erörtern, was auf dem Spiel steht und warum die Beachtung der Ethik zwingend erforderlich ist. Anschließend werden wir untersuchen, wie Sie Ihr maschinelles Lernprojekt unter Berücksichtigung der Ethik konzipieren und entwickeln und wie Sie die Ethik nach dem Einsatz in der Produktion weiterverfolgen können.

Warum wir der Ethik Aufmerksamkeit schenken sollten

Da die Algorithmen des maschinellen Lernens und die ihnen zugrunde liegenden Abstraktionen und Hypothesen immer komplexer werden, ist es schwierig geworden, alle möglichen Konsequenzen des gesamten Systems vollständig zu erfassen und zu verstehen.

Es gibt mehrere bekannte Beispiele aus der Praxis, in denen unfaire Algorithmen für maschinelles Lernen zu suboptimalen und diskriminierenden Ergebnissen führen. Dazu gehört das bekannte Beispiel von COMPAS. COMPAS war eine weit verbreitete kommerzielle Software zur Messung des Risikos einer Person, erneut straffällig zu werden, die in einer Studie mit dem normalen menschlichen Urteilsvermögen verglichen wurde und bei der später festgestellt wurde, dass sie Afroamerikaner benachteiligt: COMPAS wies afroamerikanischen Straftätern mit größerer Wahrscheinlichkeit eine höhere Risikobewertung zu als weißen Straftätern mit demselben Profil.

Im Bereich des NLP wurde in frühen Versionen von Google Translate ein Gender Biais entdeckt, das 2018 und in jüngster Zeit behoben wurde.

Im Bereich der Kreditvergabe wurde gegen Goldman Sachs wegen der Verwendung eines AI Algorithmus ermittelt, der angeblich Frauen diskriminierte, indem er Männern auf ihren Apple-Karten größere Kreditlimits gewährte als Frauen.

Im Bereich der Gesundheitsfürsorge hat ein Algorithmus zur Risikovorhersage, der bei mehr als 200 Millionen Menschen in den USA eingesetzt wurde, rassistische Verzerrungen gezeigt.

Ohne einen klar definierten Rahmen für die Analyse, Ermittlung und Abschwächung von Verzerrungen ist das Risiko, in ethische Fallen zu tappen, ziemlich hoch. Es wird daher immer wichtiger, geeignete Leitlinien festzulegen, um Modelle zu erstellen, die angemessene und faire Ergebnisse liefern, insbesondere in Bereichen, in denen Menschen involviert sind. Die Erstellung von vertrauenswürdigen AI gibt den Endnutzern ein sicheres Gefühl, wenn sie sie verwenden, und ermöglicht es Unternehmen, mehr Kontrolle über ihre Verwendung auszuüben, um die Effizienz zu steigern und gleichzeitig Schaden zu vermeiden. Damit Ihr AI vertrauenswürdig ist, müssen Sie bereits vor der Verarbeitung von data und der Entwicklung von Algorithmen über ethische Aspekte nachdenken.

Wie Sie schon vor Beginn Ihres Projekts über Ethik nachdenken können

Die Ethik muss von Beginn eines neuen Projekts an berücksichtigt werden, insbesondere in der Phase der Problemstellung. Sie sollten sowohl die anvisierten Endnutzer als auch das Ziel der vorgeschlagenen Lösung im Auge haben, um den richtigen Rahmen für die Analyse und das Risikomanagement zu schaffen, um die direkten oder indirekten Schäden zu ermitteln, die durch die Lösung verursacht werden könnten. Sie sollten sich fragen, ob meine Lösung unter diesen Bedingungen zu Entscheidungen führen könnte, die für eine bestimmte Untergruppe von Endnutzern ungünstig sind.

Es ist daher von entscheidender Bedeutung, KPIs zu entwickeln, um die Methoden zu verfolgen, mit denen die Wirksamkeit Ihrer Risikomanagementstrategie umgesetzt wird. Ein robuster Rahmen könnte auch, wenn möglich, Mechanismen zur ethischen Risikominderung enthalten.

Wenn es sich um ein sensibles Thema mit hohem Risikopotenzial handelt, ist es notwendig, die Zeit für die Erkundungs- und Erstellungsphase zu verlängern, um eine gründliche Analyse der ethischen Bewertung und Strategien zur Eindämmung von Vorurteilen zu ermöglichen.

Außerdem müssen Sie Mechanismen einrichten, die die Überprüfbarkeit und Reproduzierbarkeit des Systems AI erleichtern. Eine Logikspur muss für die Inspektion zur Verfügung stehen, damit alle Probleme überprüft oder weiter untersucht werden können. Dies geschieht durch ein hohes Maß an Rückverfolgbarkeit durch Dokumentation, Protokollierung, Verfolgung und Versionierung.

Jede data Quelle und data Umwandlung muss ebenfalls dokumentiert werden, um die Entscheidungen, die zur Verarbeitung der data getroffen wurden, transparent und nachvollziehbar zu machen. Auf diese Weise lassen sich die Schritte ermitteln, die möglicherweise eine Verzerrung verursacht oder verstärkt haben.

Wie Sie bei der Entwicklung Ihres data Projekts ethische Aspekte berücksichtigen können

Um Ethik in die Entwicklung Ihres data Projekts einzubeziehen, ist es wichtig, mindestens drei Komponenten zu berücksichtigen: Fairness, Erklärbarkeit und Nachvollziehbarkeit.

Fairness

Der erste Schritt bei den meisten Projekten zum maschinellen Lernen ist in der Regel die Sammlung von data . Unabhängig davon, ob man den data Erhebungsprozess durchläuft oder einen vorhandenen Datensatz verwendet, ist das Wissen darüber, wie die Erhebung durchgeführt wurde, entscheidend. In der Regel ist es nicht möglich, die gesamte Zielpopulation zu erfassen, so dass Merkmale und Bezeichnungen aus einer Teilmenge entnommen, nach bestimmten Kriterien gefiltert oder aggregiert werden können. All diese Schritte können zu statistischen Verzerrungen führen, die ethische Konsequenzen haben können.

Verzerrung der Repräsentation

ergibt sich aus der Art und Weise, wie wir eine Population definieren und beproben. So hat beispielsweise die mangelnde geografische Vielfalt in Datensätzen wie ImageNet eine Verzerrung in Richtung westlicher Länder gezeigt. Infolge der Stichprobenverzerrung lassen sich die für eine Population geschätzten Trends möglicherweise nicht auf data übertragen, das aus einer neuen Population stammt.

Daher ist es notwendig, geeignete data Erhebungsprotokolle festzulegen und die Vielfalt der erhaltenen data zu analysieren und dem Team alle festgestellten Lücken oder Risiken zu melden. Sie müssen data so objektiv wie möglich erheben. Zum Beispiel, indem Sie durch eine statistische Analyse sicherstellen, dass die Stichprobe repräsentativ für die zu untersuchende Population oder Gruppe ist, und indem Sie so viel wie möglich Input aus verschiedenen Quellen kombinieren, um data Vielfalt zu gewährleisten.

Die Dokumentation der Ergebnisse und des gesamten data Erhebungsprozesses ist obligatorisch.

Es gibt in der Tat viele mögliche Quellen für Verzerrungen, die in vielen Formen auftreten können, von denen einige zu Unfairness bei verschiedenen nachgelagerten Lernaufgaben führen können.

Da das Herzstück überwachter Algorithmen für maschinelles Lernen das Training data ist, können Modelle ihr Verhalten von data lernen, das unter der Einbeziehung unbeabsichtigter historischer oder statistischer Verzerrungen leiden kann. Historische Verzerrungen können in den data Generierungsprozess eindringen, selbst wenn die Stichprobenziehung und die Auswahl der Merkmale perfekt sind. Das Fortbestehen dieser Verzerrungen könnte zu einer unbeabsichtigten Diskriminierung bestimmter Gruppen oder Einzelpersonen führen, was Vorurteile und Ausgrenzung noch verschärfen kann.

Nicht alle Ursachen für Verzerrungen sind auf data zurückzuführen. Die gesamte Pipeline des maschinellen Lernens umfasst eine Reihe von Entscheidungen und Praktiken, von der data Vorverarbeitung bis zum Einsatz der Modelle.

Es ist nicht einfach, von Anfang an zu erkennen, ob und wie Probleme auftreten könnten. Eine gründliche Analyse ist erforderlich, um aufkommende Probleme zu erkennen. Je nach Anwendungsfall, der Art von data und dem Ziel der Aufgabe kommen unterschiedliche Methoden zur Anwendung.

In diesem Abschnitt werden wir einige Techniken zur Identifizierung und Entschärfung ethischer Probleme anhand eines anschaulichen Anwendungsfalls untersuchen. Zunächst wird das Problem dargelegt, dann wird gezeigt, wie Verzerrungen gemessen werden können, und schließlich werden wir einige Techniken anwenden, um Verzerrungen während der Vorverarbeitung, während der Verarbeitung und nach der Verarbeitung abzuschwächen.

Problemstellung

Nehmen wir an, Sie entwickeln einen Scoring-Algorithmus im Bankensektor, um die targeting von Kunden zu automatisieren, die von einem Premium-Geschäft profitieren oder nicht. Ihnen liegt ein historischer Datensatz vor, der viele aussagekräftige data über Ihre Kunden sowie das binäre Ziel "für ein Premium-Geschäft geeignet" enthält. PII-Elemente (personenbezogene Daten) wurden zuvor aus dem Datensatz entfernt, so dass der Datenschutz nicht gefährdet ist (in diesem Zusammenhang ist der Google cloud data Loss Prevention Service ein hervorragendes Tool zur De-Identifizierung Ihrer sensiblen data).

Dieser Anwendungsfall mag etwas fiktiv erscheinen, aber das Problem kommt einem realen Anwendungsfall nahe, mit dem wir uns in der Vergangenheit in einem anderen Sektor beschäftigt haben.

Verzerrungen messen

Der erste Schritt der Analyse besteht darin, die Website data zu durchsuchen, um empfindliche Merkmale, privilegierte Werte und günstige Kennzeichnungen zu ermitteln.

Sensible Merkmale (oder manchmal auch geschützte Merkmale genannt) sind Merkmale, die eine Bevölkerung in Gruppen aufteilen, die in Bezug auf die erhaltenen Leistungen gleichberechtigt sein sollten. Diese Merkmale können ein diskriminierendes Potenzial gegenüber bestimmten Untergruppen haben. Zum Beispiel: Geschlecht, Geschlecht, Alter, Familienstand, sozioökonomische Einstufung, Familienstand usw. und alle daraus abgeleiteten Proxy-Merkmale data (z. B. können der geografische Standort oder die Rechnungsbeträge als Proxy-Merkmale für die sozioökonomische Einstufung dienen, da in einigen Situationen beobachtet wurde, dass sie stark korreliert sein können) sind sensible Merkmale.

Ein privilegierter Wert eines sensiblen Merkmals kennzeichnet eine Gruppe, die in der Vergangenheit einen systematischen Vorteil hatte.

Ein günstiges Label ist ein Label, dessen Wert ein positives Ergebnis liefert, das dem Empfänger zugute kommt. Während der Vorbereitungsphase von data können Schritte wie die Aufteilung der data, Unter- oder Überstichproben, der Umgang mit fehlenden Werten und Ausreißern zu Verzerrungen führen, wenn sie nicht sorgfältig durchgeführt werden. Der Anteil der fehlenden Werte oder Ausreißer in den Untergruppen bei sensiblen Merkmalen kann ein erster Schritt zur Identifizierung von Verzerrungen sein. Einige Imputationsstrategien können zu statistischen Verzerrungen führen, z. B. die Imputation der fehlenden Werte des Altersmerkmals des Kunden durch seinen Median.

In unserem Scoring-Beispiel haben wir eine Grafik erstellt, die zeigt, wie sich die Ausbildung data in Bezug auf das Ziel "Prämienberechtigung" auf die Geschlechter verteilt:

Wir können sehen, dass die Verteilung des Ziels zugunsten des Geschlechts "männlich" unausgewogen ist. Wir stellen die Hypothese auf, dass der Privilegierungswert " männlich" ist, wenn das Geschlecht ein sensibles Merkmal ist und die bevorzugte Bezeichnung "für ein Premium-Geschäft geeignet" lautet. Darüber hinaus könnte dies einer Verzerrung der Repräsentation auf data entsprechen. In der Tat könnte man in einem Fall, in dem die Gleichheit respektiert wird, sicherstellen, dass die Verteilungen auf data völlig ausgeglichen sind oder den Verteilungen auf der demografischen Website data entsprechen.

An diesem Punkt könnten Sie versucht sein, die sensiblen Merkmale einfach aus Ihrem Datensatz zu entfernen, aber es hat sich gezeigt, dass das Entfernen sensibler Attribute nicht unbedingt ausreicht, um Ihr Modell fair zu machen. Das Modell könnte andere Merkmale verwenden, die mit dem entfernten sensiblen Merkmal korrelieren, wodurch historische Verzerrungen reproduziert werden. Um ein Beispiel zu nennen: Ein Merkmal A könnte stark mit dem Alter eines Kunden korreliert sein, so dass, wenn data gegenüber einer bestimmten Altersgruppe voreingenommen ist (historische Voreingenommenheit könnte zu einer Diskriminierung aufgrund des Alters bei der Einstellung, Beförderung usw. führen), diese Voreingenommenheit in Merkmal A kodiert wird und das Entfernen des Alters eines Kunden das Problem nicht beheben wird. Indem Sie das sensible Merkmal in Ihrem data beibehalten, wenn es notwendig ist, haben Sie eine bessere Kontrolle über die Messung und Abschwächung von Vorurteilen und Fairness.

Verzerrungsmetriken

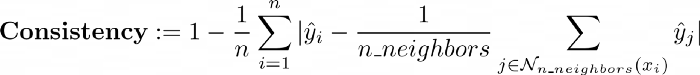

Es gibt eine Vielzahl von Fairness-Definitionen und Fairness-Metriken. Wir können Fairness in individuelle Fairness und Gruppenfairness unterteilen. Individuelle Fairness gibt ähnlichen Individuen ähnliche Prognosen, während Gruppenfairness verschiedene Gruppen gleich behandelt.

Um Gruppengerechtigkeit zu erreichen, soll die Wahrscheinlichkeit eines positiven Ergebnisses gleich hoch sein, unabhängig davon, ob die Person zur geschützten Gruppe (z. B. Frau) gehört oder nicht.

Eine einfache Gruppenkennzahl ist der Vergleich des Prozentsatzes der positiven Ergebnisse für die privilegierte und die nicht privilegierte Gruppe (in unserem Beispiel das männliche Geschlecht, das für ein "Premium-Angebot" in Frage kommt, mit dem weiblichen Geschlecht, das für ein "Premium-Angebot" in Frage kommt). Sie können diesen Vergleich als Differenz zwischen den beiden Prozentsätzen berechnen, was zu der Metrik der statistischen Paritätsdifferenz führt (auch demografische Parität genannt):

Damit es keinen Unterschied in den positiven Ergebnissen zwischen privilegierten und nicht privilegierten Gruppen gibt, sollte die statistische Paritätsdifferenz gleich 0 sein.

Zum Thema individuelle Fairness-Metrik gibt es die Konsistenz, die den Grad der Ähnlichkeit von Kennzeichnungen für ähnliche Individuen unter Verwendung eines Algorithmus der nächsten Nachbarn misst:

Wir werden uns nicht auf dieses Thema konzentrieren, aber der interessierte Leser kann diesen Artikel lesen.

Sie können die praktische Bibliothek AIF360 verwenden, mit der Sie viele Fairness-Metriken berechnen können.

Alles, was Sie tun müssen, ist, Ihren Datenrahmen in das StandardDataset zu wickeln. AIF360 verwendet ein StandardDataset, das einen Pandas DataFrame mit vielen Attributen und Methoden umhüllt, die speziell für die Verarbeitung und Messung ethischer Verzerrungen geeignet sind. Sie können dies dann als Eingabe für die BinaryLabelDatasetMetric-Klasse verwenden, die eine Reihe nützlicher Metriken berechnet.

| params_aif = { | |

| "label_name": "förderfähig_für_eine_prämie_deal", | |

| "favorable_classes":[1], | |

| "protected_attribute_names": ["Geschlecht"], | |

| "privileged_classes": [[0]] # in unserem Fall ist 0 männlich und 1 weiblich | |

| } | |

| # aif360 StandardDatensätze erstellen | |

| train_standard_dataset = StandardDataset(df=train_dataframe, | |

| **params_aif) | |

| privileged_groups = [{‘gender’: 0}] | |

| unprivileged_groups = [{‘gender’: 1}] | |

| train_bldm = BinaryLabelDatasetMetric(train_standard_dataset, | |

| unprivileged_groups=unprivileged_groups, | |

| privileged_groups=privileged_groups) |

Gemessen an den Trainingsergebnissen unseres Bewertungsbeispiels data ergibt sich eine mittlere statistische Paritätsdifferenz von -0,21, was bedeutet, dass die privilegierte Gruppe Male 21% mehr positive Ergebnisse in der Trainingsgruppe data hatte.

Abmilderung von Vorurteilen

Methoden, die gegen algorithmische Verzerrungen vorgehen, werden in der Regel in drei Kategorien unterteilt:

Wir haben eine Vorverarbeitungstechnik für das Training data verwendet, um die statistische Paritätsdifferenz zu optimieren. Wir wendeten den in AIF360 implementierten Reweighing-Algorithmus an (weitere Einzelheiten in diesem Artikel), um die Beispiele in jeder Kombination (Gruppe, Label) unterschiedlich zu gewichten, um vor der Klassifizierung Fairness zu gewährleisten.

RW = Neugewichtung(unprivilegierte_Gruppen=unprivilegierte_Gruppen,

privilegierte_Gruppen=privilegierte_Gruppen)

reweighted_train = RW.fit_transform(train_standard_dataset)

|

Das Attribut "Instanzgewichte" wurde geändert, um das empfindliche Merkmal in Bezug auf das Ziel neu zu gewichten. Auf diese Weise hat der Reweighing-Algorithmus die Gruppenverzerrung im Training data abgeschwächt: ein neues Maß für die statistische Paritätsdifferenz wurde vollständig von -0,21 auf 0 umgewichtet.

In AIF360 sind weitere Algorithmen zur Abschwächung von Verzerrungen vor der Verarbeitung implementiert, z. B. DisparateImpactRemover, eine Technik, die Merkmalswerte bearbeitet, um die Gruppenfairness zu erhöhen und gleichzeitig die Rangfolge innerhalb der Gruppen beizubehalten (weitere Informationen im folgenden Artikel), oder LFR (Learning fair representation), eine Vorverarbeitungstechnik, die eine latente Darstellung findet, die data kodiert, aber Informationen über die geschützten Attribute verschleiert (weitere Informationen im folgenden Artikel).

Wir haben dann zwei Klassifizierungsmodelle trainiert, eines mit dem ursprünglichen data und das andere mit dem neu gewichteten data. Wir stellen fest, dass die Neugewichtung nur eine schwache Auswirkung auf die Leistung hatte, nämlich einen Verlust von 1 % des F1-Scores.

Wir haben auch einen In-Processing-Algorithmus für unser Anwendungsbeispiel ausprobiert: adversarial debiasing der die Metrik der Gruppenverzerrung deutlich verbesserte (die statistische Paritätsdifferenz wurde durch 2 geteilt), wobei sich die Modellleistung nur geringfügig verschlechterte (etwa 1 % beim F1-Score).

Daher kann es zu einem Kompromiss zwischen Leistung und Verzerrungsmetriken kommen. Hier ist die Verschlechterung recht gering, aber in manchen Situationen könnte der Kompromiss akuter sein. Diese Informationen müssen dem Team und den entsprechenden Interessengruppen mitgeteilt werden, die dann entscheiden können, wie mit diesem Problem umzugehen ist.

Jetzt, da wir die Modelle trainiert haben, können wir ihre Vorhersagen untersuchen und feststellen, ob es ein Ungleichgewicht zwischen den Geschlechtern in Richtung eines günstigen Ergebnisses gibt. Es gibt viele Tools, wie z. B. das WENN-Tool oder Aequitas, mit denen Sie das Verhalten der trainierten Modelle für maschinelles Lernen untersuchen und die Modellleistung und Fairness in den Untergruppen prüfen können.

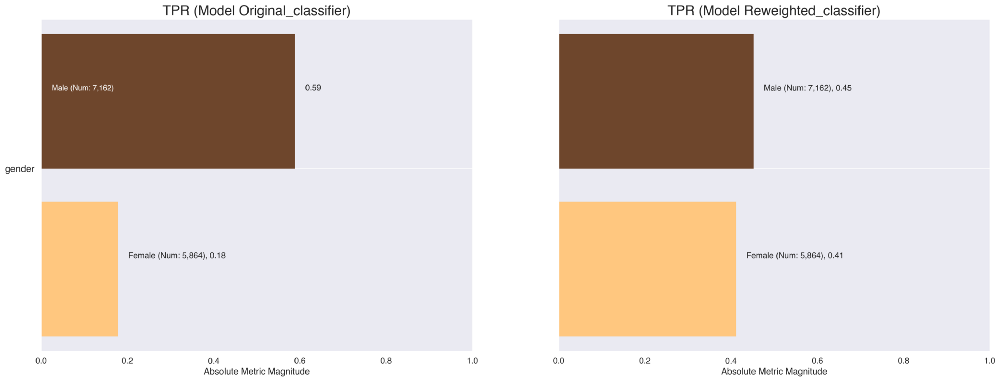

Zur Veranschaulichung können Sie mit Aequitas Kreuztabellen und Visualisierungen erstellen, die verschiedene Verzerrungs- und Leistungsmetriken über die Untergruppen verteilt darstellen. Zum Beispiel können wir schnell die True-Positive-Raten der Klassifikatoren vergleichen, die auf der ursprünglichen data und auf der neu gewichteten data trainiert wurden. Wir sehen, dass diese Rate ausgeglichen ist und daher eine größere Geschlechtergerechtigkeit in Bezug auf das günstige Ergebnis des Modells, für einen Premiumvertrag in Frage zu kommen, ermöglicht.

Als Nachbearbeitungstechnik haben wir mit der Klassifizierungsschwelle interagiert. Ein Klassifizierungsmodell liefert uns normalerweise die Wahrscheinlichkeiten, die mit der Realisierung jeder Klasse als Vorhersage verbunden sind. Diese Wahrscheinlichkeiten können unverändert verwendet oder in einen binären Wert umgewandelt werden.

Um die Klasse zu identifizieren, die den erhaltenen Wahrscheinlichkeiten entspricht, muss eine Klassifizierungsschwelle (auch Entscheidungsschwelle genannt) definiert werden. Jeder Wert, der über diesem Schwellenwert liegt, entspricht der positiven Kategorie "kommt für ein Premium-Geschäft in Frage" und umgekehrt für Werte unter diesem Schwellenwert.

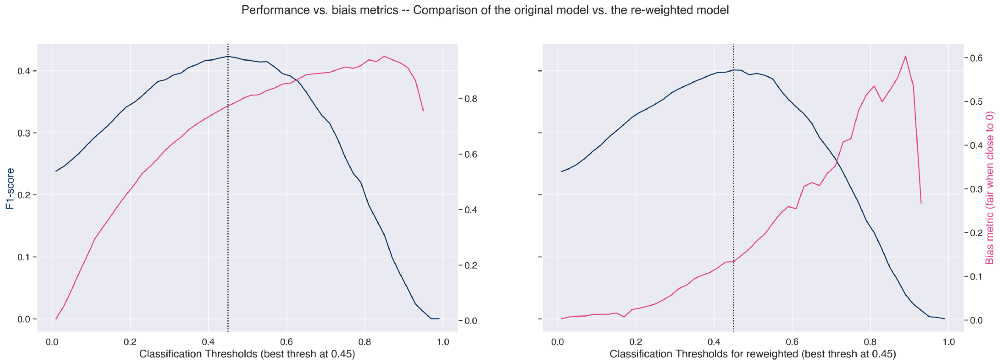

Durch Auftragen der Leistungsmetrik und der Verzerrungsmetrik (hier 1 - ungleiche Auswirkung) für alle Klassifizierungsschwellenwerte können wir den optimalen Schwellenwert definieren. Dies hilft uns bei der Auswahl eines geeigneten Schwellenwerts, um die Leistung zu maximieren und die Verzerrung zu minimieren.

In der linken Abbildung sehen wir, dass wir die Bias-Metrik verbessern können, wenn wir den Schwellenwert nach links verschieben und damit die Leistung etwas senken.

Außerdem beobachten wir wie erwartet eine deutliche Verbesserung der Gruppenverzerrungsmetrik bei dem neu gewichteten Modell (rechte Abbildung), die durch die Wahl eines anderen Klassifizierungsschwellenwerts weiter verbessert werden könnte, allerdings auf Kosten der Leistung.

Erklärbarkeit

Ein weiterer Grundpfeiler für den Aufbau vertrauenswürdiger maschineller Lernmodelle ist die Erklärbarkeit. Erklärbarkeit ist die Fähigkeit, sowohl die technischen Prozesse des AI Systems als auch die Gründe für die Entscheidungen oder Vorhersagen, die das AI System trifft, zu erläutern und somit den Einfluss der einzelnen Merkmale/Attribute auf die Vorhersagen zu quantifizieren. Die Verwendung leicht interpretierbarer Modelle anstelle von Black-Box-Modellen ist eine gute Praxis.

Es gibt viele Methoden, um die Erklärbarkeit von Modellen zu erhalten. Diese Methoden können in 2 Kategorien eingeteilt werden:

Hier werden wir eine berühmte Post-hoc-Methode anwenden, nämlich SHAP (SHapley Additive exPlanations). Für weitere Informationen empfehlen wir, diese sehr umfassende Ressource zu diesem Thema zu lesen. Shap ist eine Bibliothek, die einen spieltheoretischen Ansatz zur Erklärung des Outputs eines beliebigen maschinellen Lernmodells implementiert.

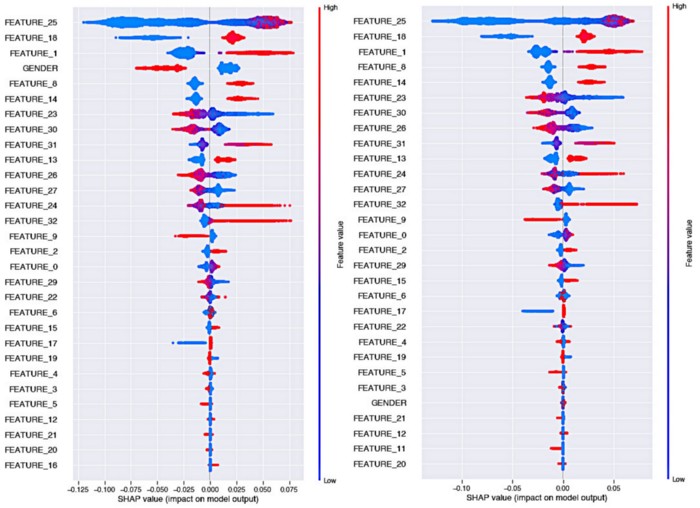

Betrachten wir nun die Auswirkungen des Reweighing-Algorithmus auf die Erklärbarkeit des Modells:

Kurze Erinnerung daran, wie man Shaps Bienenwarm-Plots liest:

Auf der linken Seite sehen wir die Erklärbarkeit des ursprünglichen Modells, wobei wir feststellen, dass in diesem Fall die Geschlechtsvariable eine sehr starke Vorhersagekraft hat und dass das Geschlecht "weiblich" eine Auswirkung hat, die die Entscheidung für das Ziel "kein Anspruch auf ein Prämiengeschäft" mit einem großen Abstand zum Geschlecht "männlich" beeinflusst.

In der rechten Grafik ist zu sehen, dass in diesem Fall, in dem das Modell auf der neu gewichteten data trainiert wurde, die Bedeutung des Geschlechtsmerkmals stark abgenommen hat. Es gehört jetzt zu den am wenigsten wichtigen Merkmalen. Außerdem ist der Einfluss der weiblichen gegenüber der männlichen Klasse auf die Vorhersage des Ziels viel ausgewogener (die Farben liegen beim Shapley-Wert nahe bei 0).

Rückverfolgbarkeit

Ein weiterer wesentlicher Aspekt bei der Entwicklung vertrauenswürdiger Algorithmen für maschinelles Lernen ist die Rückverfolgbarkeit der Ergebnisse und eine gute Reproduzierbarkeit der Experimente. So lässt sich leicht feststellen, welche Version eines Modells in Produktion gegangen ist, so dass es überprüft werden kann, wenn sein Verhalten Schaden anrichtet und nicht mehr mit den ethischen Werten des Unternehmens übereinstimmt.

Dazu muss man in der Lage sein, jede Modellversion und die damit verbundenen Trainings data, Hyperparameter und Ergebnisse zu verfolgen und aufzuzeichnen. Mehrere Tools können diese Aufgabe erfüllen: Mlflow ist eine großartige Option, mit der Sie schnell eine Weboberfläche erstellen können, die alle Läufe zentralisiert, während Sie Ihre Artefakte in einem Speicher Ihrer Wahl speichern. Jede Version des Experiments kann mit dem Hash des zugehörigen Commits nachverfolgt werden. Jede dieser Versionen enthält alle Elemente, die von MLflow aufgezeichnet wurden.

Hier ist ein Tool, das wir auf Artefact zur Verfügung gestellt haben und mit dem Sie einen sicheren MLflow mit einem einzigen Befehl in einem GCP-Projekt bereitstellen können.

Es empfiehlt sich auch, für jedes Modell ein FactSheet zu erstellen, das einer Modellidentitätskarte entspricht, in der verschiedene Elemente wie die Vorverarbeitungsschritte, Leistungskennzahlen, Verzerrungskennzahlen usw. zusammengefasst sind.

Diese Ausweise werden von den Wissenschaftlern von data an die Modellbetreiberteams übermittelt, damit diese feststellen können, ob das Modell für ihre Situation geeignet ist. Für weitere Details über die Methodik zur Erstellung eines FactSheets empfehlen wir diesen Artikel. Das FactSheet kann auch, z. B. in tabellarischer Form, in MLFlow zusammen mit dem zugehörigen Modell gespeichert werden.

Wie kann man die ethischen Aspekte nach dem Einsatz weiterverfolgen?

Sobald Ihr Modell zum Einsatz kommt, müssen Sie sicherstellen, dass es für den Zweck verwendet wird, für den es gedacht, entworfen und erstellt wurde. Eine Verzerrung des Einsatzes liegt vor, wenn es eine Diskrepanz zwischen dem Problem, das ein Modell lösen soll, und der Art und Weise, wie es tatsächlich verwendet wird, gibt. Dies geschieht häufig, wenn ein System so entwickelt und bewertet wird, als sei es völlig eigenständig, während es in Wirklichkeit Teil eines komplexen soziotechnischen Systems ist, das von einer großen Zahl von Entscheidungsträgern gesteuert wird.

Die Produktion data kann im Laufe der Zeit abdriften, was zu einer Leistungsverschlechterung des Algorithmus führen kann, die zu Verzerrungen führen könnte. Die Verfolgung der Qualität der Produktion data und der data Drift durch die Überwachung der Verteilungen der neuen data im Vergleich zu den data , die zum Trainieren der Modelle verwendet wurden, sollte ein Schritt in der Produktionspipeline sein, um bei Bedarf die richtigen Warnungen auszulösen und festzulegen, wann ein erneutes Training erforderlich ist.

Die Produktionspipeline sollte so gestaltet sein, dass es eine Möglichkeit gibt, das aktuelle Modell abzuschalten oder zu einer früheren Version zurückzukehren.

Schlussfolgerung

In diesem Artikel stellen wir Ihnen einige bewährte Verfahren und Protokolle vor, die Sie beim Aufbau von Pipelines für maschinelles Lernen unterstützen und das Risiko, in ethische Fallen zu tappen, minimieren.

Dieser Artikel hat kaum an der Oberfläche des riesigen Themas Ethik AI gekratzt und nur einen Teil der interessanten Werkzeuge, die derzeit entwickelt werden und verfügbar sind, gestreift.

Wie wir gesehen haben, besteht der logischste Weg, Fairnessprobleme explizit anzugehen, darin, eine Sammlung ausgewählter Merkmale als potenziell diskriminierend zu deklarieren und dann durch dieses Prisma die ethische Voreingenommenheit zu untersuchen. Diese einfache Methode hat jedoch den Nachteil, dass Diskriminierung das Ergebnis einer Kombination von Merkmalen sein kann, die für sich genommen nicht diskriminierend sind. Außerdem werden Sie in vielen Fällen keinen Zugang zu einem sensiblen Merkmal haben (mehr zu diesem Thema hier).

Die Beurteilung der Fairness ist eine komplexe Aufgabe, die von der Art des Problems abhängt. Die Herangehensweise an ein Bewertungsproblem auf der Grundlage von Tabellen data ist nicht dieselbe wie die Milderung von Verzerrungen bei der Verarbeitung natürlicher Sprache.

Wir hoffen, dass der Austausch über unsere Sichtweise und Methoden Sie bei Ihren eigenen Projekten inspirieren wird! Vielen Dank für die Lektüre, zögern Sie nicht, dem Artefact tech blog zu folgen, wenn Sie benachrichtigt werden möchten, wenn unser nächster Artikel erscheint!

BLOG

BLOG