Défi : étendre le marketing de précision avancé à plus de 30 marchés.

Sanofi est l'un des leaders mondiaux de l'industrie pharmaceutique. Au cours des trois dernières années, Artefact a aidé l'unité commerciale Sanofi CHC (Consumer Health Care) à commercialiser ses médicaments en vente libre en utilisant des tactiques et des outils numériques pour atteindre les bons consommateurs au bon moment avec le bon message, sur plus de 30 marchés.

Pour sa catégorie de produits saisonniers, Sanofi CHC a développé une approche basée sur les prévisions pour ajuster les dépenses en médias numériques en fonction des pics de demande prévus. Grâce à de multiples campagnes pilotes, l'équipe Global Digital Transformation a pu prouver la valeur ajoutée de cette approche avec un ROAS multiplié par 2 à 4 selon les géographies.

Cependant, la mise en place d'une nouvelle campagne prenait beaucoup de temps: les scientifiques de data devaient effectuer une série de tâches manuelles, répétitives et sujettes aux erreurs, ce qui les empêchait de se concentrer sur d'autres projets innovants. Afin de mettre à l'échelle ses pipelines ML innovants, l'équipe scientifique de Sanofi data a défini ses besoins pour industrialiser le cas d'utilisation et a fait appel au soutien de Artefact pour concevoir et mettre en œuvre conjointement une solution robuste.

Solution : un processus d'industrialisation co-conçu basé sur 6 solutions clés

"La clé de la réussite du projet a été l'étroite collaboration entre les experts commerciaux de Sanofi et les scientifiques de Sanofi data avec l'équipe Artefact ."

- Albert Pla Planas, Data Chef d'équipe scientifique, Sanofi

Grâce à une étroite collaboration entre Artefact et les équipes data et commerciales de Sanofi, un processus d'industrialisation complet s'appuyant sur la plate-forme Databricks unifiée a été conçu. Nos objectifs communs étaient les suivants

Simplifier la mise en place de bout en bout d'une nouvelle campagne saisonnière

Automatiser les tâches d'ingestion et de traitement de data

Rendre la solution plus robuste pour éviter les erreurs et la maintenance manuelle

Améliorer la maintenabilité et l'évolutivité du projet

Après un audit rapide d'une semaine visant à recenser les processus actuels et les problèmes techniques, l'équipe a décidé de mettre en place une infrastructure à l'épreuve du temps, basée sur six solutions clés :

Séparation des préoccupations:

Le fait d'avoir un pipeline ETL distinct du processus du modèle de prévision facilite la maintenance et la mise à l'échelle. Cela nous a permis de mettre en place des contrôles automatisés ainsi qu'un système de surveillance qui envoie des rapports détaillés aux équipes concernées sur l'état de l'ingestion.

Utilisation du lac Delta comme source d'or data :

Dans les équipes de DS où l'infrastructure peut être pénible à obtenir/maintenir, Delta Lake combine les principales caractéristiques des solutions data warehouse et data lakes, éliminant ainsi la complexité de l'administration de la base de données SQL. Il possède également des capacités de gestion des versions - importantes pour la reproductibilité de la ML - et servira de source unique de vérité pour data.

Emballer autant de code que possible dans une bibliothèque Python pour simplifier les processus:

Une partie du code initial était dispersée entre plusieurs notebooks au sein de Databricks, complexifiant la gestion des dépendances et la réutilisabilité du code. Le développement basé sur les notebooks est pertinent pour le prototypage mais peut créer des défis pour l'industrialisation des projets ML. Le fait d'avoir des bibliothèques Python clairement définies et implémentées sur le notebook et de ne garder que Databricks comme point d'entrée pour Compute a facilité la généralisation des notebooks et l'organisation des campagnes entrantes.

Tirer parti de Spark et de Databricks:

La formation du modèle à l'aide de méthodes de recherche d'hyperparamètres peut être longue et exigeante. C'est là que l'infrastructure d'autoscaling de Databricks et le runtime ML géré avec Spark et HyperOpt s'avèrent utiles. L'utilisation de calculs en mémoire de manière distribuée sur un ensemble de travailleurs accélère les performances et améliore considérablement le temps de formation.

Utilisation du suivi du flux ML:

Avec le suivi du ML Flow en place, Sanofi dispose maintenant d'une interface utilisateur où Data Scientists peut comparer les exécutions du modèle et garder une trace de tous les paramètres utilisés (versionData et paramètres du modèle) et des résultats obtenus.

Simplification des tests et de la mise en œuvre de nouveaux modèles ML:

Un cadre générique de fabrique de modèles a été mis en place, facilitant la mise en œuvre de nouveaux modèles d'apprentissage automatique et leur essai au cours d'une campagne de marketing de précision avec très peu d'efforts.

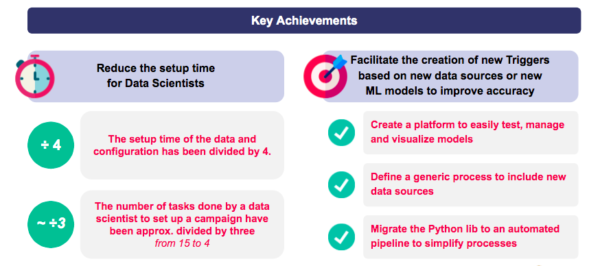

Résultats et enseignements : un temps d'installation divisé par quatre pour l'ingestion et la configuration de data .

Grâce à ce projet, Sanofi CHC a pu simplifier considérablement son pipeline data et accélérer la mise à l'échelle de son cas d'utilisation Precision Marketing basé sur les prévisions.

Réduction du temps de préparation des nouvelles campagnes:

- Le temps d'installation pour l'ingestion et la configuration de data est réduit d'un quart.

- Le nombre de tâches effectuées par les scientifiques de data pour mettre en place une nouvelle campagne a été réduit d'un tiers.

Simplification de la création de nouveaux modèles de prévision:

- Plateforme accessible pour tester, gérer et visualiser facilement les modèles.

- Processus générique pour inclure de nouvelles sources data .

- Pipeline automatisé data .

Le projet a également permis aux équipes de générer 4 apprentissages importants pour de futurs projets axés sur le ML :

Intégrer l'ingénierie data dans les projets de ML :

Impliquer les ingénieurs de Data dès le début d'un projet pour accélérer l'industrialisation du pipeline, et découpler clairement les différentes étapes du pipeline (toutes les manipulations, transformations et curations de data doivent être effectuées avant de passer aux étapes de ML).

Exploitez les outils préemballés:

L'utilisation de Databricks avec Delta Lake et ML Flow a été cruciale pour le succès de l'industrialisation, en garantissant une infrastructure facile à utiliser en libre-service sans avoir besoin de DevOps.

Collaboration étroite entre les équipes Business et Data :

Le facteur de réussite le plus important a sans doute été l'étroite collaboration entre les experts commerciaux de Sanofi et les scientifiques de data , qui ont eu l'idée et conduit le projet, et l'équipe de Artefact , qui a apporté une expérience et un savoir-faire supplémentaires en matière d'industrialisation.

Utiliser les méthodologies agiles pour s'industrialiser:

La méthodologie agile (sprints, itérations rapides suivies de semaines de feedback et d'alignement) s'est avérée très efficace pour identifier et traiter tous les points douloureux de Sanofi et garantir la fourniture de valeur aux équipes de Sanofi.

Artefact tient à remercier Ayaka Yanagisawa, Albert Pla Planas, Antoine Tran-Quan-Nam, Laurent Gautier et Sergio Villordo de Sanofi pour leur confiance et leur collaboration à ce projet, ainsi que l'équipe de Databricks pour leur soutien réactif. Cet article a été coproduit par les équipes de Sanofi CHC et Databricks aux côtés de Tristan Silhol, Maui Bar, Louise Morin et Eva Le Saux des bureaux américains et français de Artefact .

CAS CLIENTS

CAS CLIENTS