Herausforderung: Skalierung von fortschrittlichem Präzisionsmarketing in über 30 Märkten

Sanofi ist eines der weltweit führenden Unternehmen in der Pharmaindustrie. In den letzten drei Jahren hatArtefact den Sanofi-Geschäftsbereich CHC (Consumer Health Care) dabei unterstützt, seine rezeptfreien Medikamente mit Hilfe von Digital-First-Taktiken und Enablern zu vermarkten , um die richtigen Verbraucher zur richtigen Zeit mit der richtigen Botschaft zu erreichen - und das in mehr als 30 Märkten.

Für seine Kategorie der saisonalen Produkte hat Sanofi CHC einen auf Prognosen basierenden Ansatz entwickelt, um die Ausgaben für digitale Medien entsprechend den vorhergesagten Nachfragespitzen anzupassen. Durch mehrere Pilotkampagnen konnte das Global Digital Transformation Team den Mehrwert dieses Ansatzes mit einem ROAS nachweisen, der sich je nach Region um das 2- bis 4-fache erhöhte.

Die Einrichtung einer neuen Kampagne war jedoch zeitaufwändig: Die Wissenschaftler von data mussten eine Reihe von manuellen, sich wiederholenden und fehleranfälligen Aufgaben erledigen, was sie daran hinderte, sich auf andere innovative Projekte zu konzentrieren. Um seine innovativen ML-Pipelines zu skalieren, definierte das Wissenschaftsteam von Sanofi data seine Bedürfnisse, um den Anwendungsfall zu industrialisieren, und bat um die Unterstützung von Artefact , um gemeinsam eine robuste Lösung zu entwickeln und zu implementieren.

Lösung: ein mitgestalteter Industrialisierungsprozess auf der Grundlage von 6 Schlüssellösungen

"Der Schlüssel zum Erfolg des Projekts war die enge Zusammenarbeit zwischen den Geschäftsexperten von Sanofi und den Wissenschaftlern von Sanofi data mit dem Team von Artefact ."

- Albert Pla Planas, Data Wissenschaftlicher Teamleiter, Sanofi

In enger Zusammenarbeit zwischen Artefact und den Teams von Sanofi ( data ) und anderen Unternehmen wurde ein umfassender Industrialisierungsprozess entwickelt, der die einheitliche Databricks-Plattform nutzt. Unsere gemeinsamen Ziele waren:

Vereinfachen Sie die durchgängige Einrichtung einer neuen saisonalen Kampagne

Automatisieren Sie data Aufnahme- und Verarbeitungsaufgaben

die Lösung robuster machen, um Fehler und manuelle Wartung zu vermeiden

Verbesserung der Wartungsfreundlichkeit und Skalierbarkeit des Projekts

Nach einem schnellen einwöchigen Audit, in dem die aktuellen Prozesse und technischen Probleme aufgezeigt wurden, konzentrierte sich das Team auf die Implementierung einer zukunftssicheren Infrastruktur auf der Grundlage von sechs Schlüssellösungen:

Trennung der Anliegen:

Eine vom Prognosemodellprozess getrennte ETL-Pipeline ist einfacher zu pflegen und zu skalieren. Auf diese Weise konnten wir neben einem Überwachungssystem, das detaillierte Informationen über den Status der Datenaufnahme an die zuständigen Teams sendet ( reports ), automatisierte Prüfungen durchführen.

Nutzung des Deltasees als data goldene Quelle:

In DS-Teams, in denen die Beschaffung/Wartung der Infrastruktur mühsam sein kann, kombiniert Delta Lake die wichtigsten Funktionen der Lösungen data warehouse und data lakes und beseitigt damit die Komplexität der SQL-Datenbankverwaltung. Außerdem verfügt es über Versionierungsfunktionen - wichtig für die Reproduzierbarkeit von ML - und dient als einzige Quelle der Wahrheit für data.

So viel Code wie möglich in eine Python-Bibliothek packen, um Prozesse zu vereinfachen:

Ein Teil des ursprünglichen Codes war über mehrere Notebooks in Databricks verstreut, was die Verwaltung von Abhängigkeiten und die Wiederverwendbarkeit von Code erschwerte. Die Notebook-basierte Entwicklung ist für das Prototyping von Bedeutung, kann aber bei der Industrialisierung von ML-Projekten zu Problemen führen. Klar definierte Python-Bibliotheken, die auf dem Notebook implementiert wurden, und Databricks als einziger Einstiegspunkt für Compute machten es einfacher, Notebooks zu verallgemeinern und eingehende Kampagnen zu organisieren.

Nutzung von Spark und Databricks:

Das Training des Modells mit Hyperparametersuchmethoden kann zeitaufwändig und anspruchsvoll sein. Hier kommen die autoskalierende Infrastruktur von Databricks und die verwaltete ML-Laufzeit mit Spark und HyperOpt ins Spiel. Die verteilte Nutzung von Speicherberechnungen über eine Reihe von Arbeitern beschleunigt die Leistung und verbessert die Trainingszeit erheblich.

Verwendung von ML Flow Tracking:

Mit dem ML Flow Tracking verfügt Sanofi nun über eine Benutzeroberfläche, über die Data Wissenschaftler Modellläufe vergleichen und alle verwendeten Parameter (Data Version und Modellparameter) sowie die erzielten Ergebnisse verfolgen können.

Vereinfachte Prüfung und Implementierung neuer ML-Modelle:

Es wurde eine generische Modellfabrik eingerichtet, die es erleichtert, neue Modelle des maschinellen Lernens zu implementieren und sie während einer Precision-Marketing-Kampagne mit sehr geringem Aufwand zu testen.

Ergebnisse und Erkenntnisse: eine durch vier geteilte Einrichtungszeit für die Aufnahme und Konfiguration von data

Dank dieses Projekts war Sanofi CHC in der Lage, seine data Pipeline erheblich zu vereinfachen und die Skalierung seines auf Prognosen basierenden Precision Marketing Use Case zu beschleunigen.

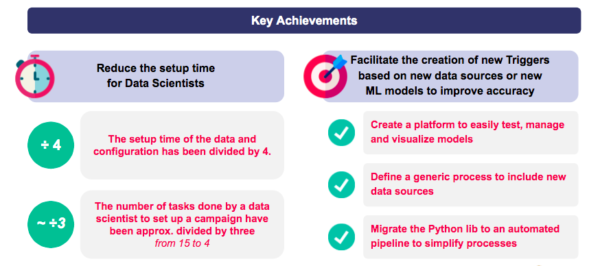

Verkürzung der Einrichtungszeit für neue Kampagnen:

- Die Einrichtungszeit für die Aufnahme und Konfiguration von data wurde um bis zu einem Viertel reduziert.

- Die Anzahl der von den Wissenschaftlern von data durchgeführten Aufgaben zur Einrichtung einer neuen Kampagne wurde um bis zu einem Drittel reduziert.

Vereinfachung der Erstellung von neuen Prognosemodellen:

- Zugängliche Plattform zum einfachen Testen, Verwalten und Visualisieren von Modellen.

- Generisches Verfahren zur Einbeziehung neuer data Quellen.

- Automatisierte data Pipeline.

Das Projekt ermöglichte es den Teams auch, 4 wichtige Erkenntnisse für zukünftige ML-gesteuerte Projekte zu gewinnen:

Integrieren Sie data engineering in ML-Projekte:

Einbeziehung von Data Ingenieuren von Beginn eines Projekts an, um die Industrialisierung der Pipeline zu beschleunigen, und klare Entkopplung der verschiedenen Phasen der Pipeline (alle data Verarbeitungs-, Umwandlungs- und Kuratierungsschritte müssen vor dem Sprung in die ML-Phasen erfolgen).

Nutzen Sie vorgefertigte Tools:

Der Einsatz von Databricks mit Delta Lake und ML Flow war entscheidend für den Erfolg der Industrialisierung, da sie eine einfache Self-Service-Infrastruktur ohne DevOps gewährleisten.

Intensive Zusammenarbeit zwischen den Teams von Business und Data :

Der wohl wichtigste Erfolgsfaktor war die enge Zusammenarbeit zwischen den Geschäftsexperten von Sanofi und den Wissenschaftlern von data , die das Projekt konzipiert und vorangetrieben haben, und dem Team von Artefact , das zusätzliche Erfahrung und Know-how bei der Industrialisierung einbrachte.

Nutzung agiler Methoden für die Industrialisierung:

Die agile Methodik (Sprints und schnelle Iterationen, gefolgt von Feedback- und Anpassungswochen) war sehr effizient, um alle Schmerzpunkte von Sanofi zu identifizieren und anzugehen und die Wertschöpfung für die Sanofi-Teams sicherzustellen.

Artefact dankt Ayaka Yanagisawa, Albert Pla Planas, Antoine Tran-Quan-Nam, Laurent Gautier und Sergio Villordo von Sanofi für ihr Vertrauen und ihre Mitarbeit an diesem Projekt sowie dem Databricks-Team für seine reaktive Unterstützung. Dieser Artikel wurde von den Teams von Sanofi CHC und Databricks gemeinsam mit Tristan Silhol, Maui Bar, Louise Morin und Eva Le Saux von Artefact in den USA und Frankreich verfasst.

KUNDEN CASES

KUNDEN CASES