Artefact Research Center

De kloof overbruggen tussen academische en industriële toepassingen.

Onderzoek naar transparantere en ethischere modellen om de adoptie van AI bedrijven te stimuleren.

Voorbeelden van AI vooroordelen

- AppleCard verstrekt hypotheken op basis van racistische criteria

- Lensa AI maakt selfies van vrouwen seksueel getint

- Racistische Facebook Afbeelding Classificatie Met afro-amerikanen als apen

- Twitter-chatbot van Microsoft wordt nazistisch, seksistisch en agressief

- ChatGPT die een code schrijft waarin staat dat goede wetenschappers blanke mannen zijn

Huidige uitdaging

AI modellen zijn nauwkeurig en gemakkelijk in te zetten in veel gebruikssituaties, maar blijven oncontroleerbaar vanwege zwarte dozen en ethische kwesties.

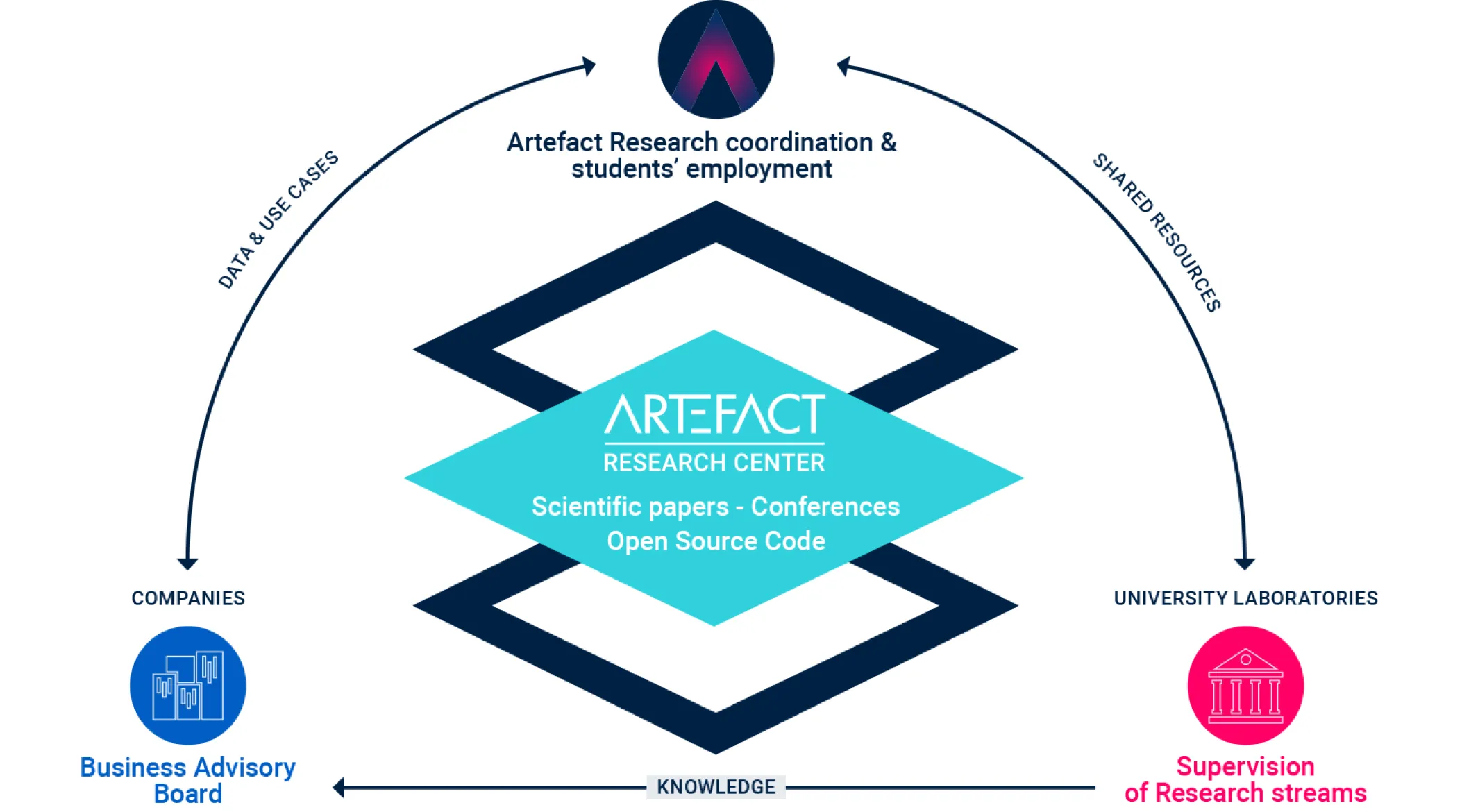

De missie van Artefact Research Center .

Een compleet ecosysteem dat de kloof overbrugt tussen

fundamenteel onderzoek en tastbare industriële toepassingen.

Emmanuel MALHERBE

Hoofd onderzoek

Onderzoeksgebied: Diep leren, machinaal leren

Beginnend met een PhD over NLP-modellen aangepast aan e-recruitment, heeft Emmanuel altijd gezocht naar een efficiënte balans tussen puur onderzoek en impactvolle toepassingen. Zijn onderzoekservaring omvat het voorspellen van 5G-tijdreeksen voor Huawei Technologies en computervisiemodellen voor kappers- en make-upklanten bij l'Oréal. Voordat hij bij Artefact kwam, werkte hij in Shanghai als hoofd van AI onderzoek voor L'Oréal Azië. Vandaag de dag is zijn positie op Artefact een perfecte gelegenheid en een ideale omgeving om de kloof tussen de academische wereld en de industrie te overbruggen, en om zijn onderzoek in de echte wereld te stimuleren terwijl het een impact heeft op industriële toepassingen.

Een volledig ecosysteem dat de kloof overbrugt tussen fundamenteel onderzoek en tastbare industriële toepassingen.

Transversale onderzoeksgebieden

Met onze unieke positionering richten we ons op algemene uitdagingen van AI, of het nu gaat om statistische modellering of managementonderzoek.

Deze vragen zijn transversaal voor al onze onderwerpen en voeden ons onderzoek.

Onderwerpen

We werken aan verschillende PhD-onderwerpen op het snijvlak van industriële use cases en state-of-the-art beperkingen.

Voor elk onderwerp werken we samen met universiteitsprofessoren en hebben we toegang tot industrieel data waarmee we de belangrijkste onderzoeksgebieden in een gegeven scenario in de echte wereld kunnen aanpakken.

1 - Prognose en prijsstelling

Tijdreeksen als geheel modelleren met een controleerbaar, multivariaat voorspellingsmodel. Met een dergelijk model kunnen we de prijs- en promotieplanning aanpakken door de optimale parameters te vinden die de verkoopprognose verhogen. Met zo'n holistische benadering willen we kannibalisatie en complementariteit tussen producten vastleggen. Hierdoor kunnen we de voorspelling controleren met de garantie dat de voorspellingen consistent blijven.

2 - Verklaarbare en controleerbare scores

Een veelgebruikte familie van machine-learning modellen is gebaseerd op beslisbomen: random forests, boosting. Hoewel hun nauwkeurigheid vaak state of the art is, lijden dergelijke modellen aan een black-box gevoel, waardoor de gebruiker beperkte controle heeft. We willen de verklaarbaarheid en transparantie ervan vergroten, met name door de schatting van SHAP-waarden te verbeteren in het geval van ongebalanceerde datasets. We streven er ook naar om bepaalde garanties te bieden voor dergelijke modellen, bijvoorbeeld voor monsters die niet getraind zijn of door betere monotone beperkingen mogelijk te maken.

3 - Assortimentoptimalisatie

Assortiment is een belangrijk bedrijfsprobleem voor retailers dat zich voordoet bij het selecteren van de set producten die in winkels verkocht worden. Met behulp van grote industriële datasets en neurale netwerken willen we robuustere en beter interpreteerbare modellen bouwen die de keuze van de klant beter weergeven wanneer deze geconfronteerd wordt met een assortiment producten. Omgaan met kannibalisatie en complementariteit tussen producten, evenals een beter begrip van klantenclusters, zijn de sleutel tot het vinden van een meer optimale set producten in een winkel.

4 - AI Adoptie in bedrijven

De uitdaging van een betere toepassing van AI in bedrijven bestaat enerzijds uit het verbeteren van de AI modellen en anderzijds uit het begrijpen van de menselijke en organisatorische aspecten. Op het kruispunt van kwalitatief managementonderzoek en sociaal onderzoek probeert deze as te onderzoeken waar bedrijven moeilijkheden ondervinden bij de adoptie van AI tools. De bestaande kaders voor de adoptie van innovaties zijn niet helemaal geschikt voor innovaties op basis van machinaal leren, omdat er typische verschillen zijn met regelgeving, opleiding van mensen of vooroordelen als het gaat om AI, en meer nog met generatieve AI.

5 - Data duurzaamheid

Het project maakt gebruik van kwalitatieve en kwantitatieve onderzoeksmethoden en richt zich op twee belangrijke vragen: Hoe kunnen bedrijven effectief sociale en ecologische duurzaamheidsprestaties meten? Waarom leiden duurzaamheidsmaatregelen vaak niet tot significante veranderingen in organisatiepraktijken?

Enerzijds is het project gericht op het verkennen van data meetmethoden en het identificeren van indicatoren om organisatorische procedures af te stemmen op sociale en ecologische duurzaamheidsdoelstellingen. Anderzijds zal het project zich richten op het omzetten van deze duurzaamheidsmaatregelen in concrete acties binnen bedrijven.

6 - Vertekening in computervisie

Wanneer een model een voorspelling doet op basis van een afbeelding, bijvoorbeeld van een gezicht, heeft het toegang tot gevoelige informatie, zoals de etniciteit, het geslacht of de leeftijd, die zijn redenering kan beïnvloeden. We willen een raamwerk ontwikkelen om deze vertekening wiskundig te meten en methodes voorstellen om deze vertekening tijdens de modeltraining te verminderen. Bovendien zou onze aanpak zones met een sterke vertekening statistisch detecteren om te verklaren en te begrijpen en te controleren waar dergelijke modellen de vertekening die aanwezig is in de data versterken.

7 - LLM voor het opzoeken van informatie

Een belangrijke toepassing van LLM's is wanneer ze gekoppeld worden aan een corpus van documenten die bepaalde industriële kennis of informatie vertegenwoordigen. In zo'n geval is er een stap van het ophalen van informatie, waarvoor LLM's enkele beperkingen hebben, zoals de grootte van de invoertekst, die te klein is om documenten te indexeren. Op dezelfde manier kan het hallucinatie-effect ook optreden in het uiteindelijke antwoord, dat we proberen te detecteren met behulp van het opgehaalde document en de modelonzekerheid op het moment van inferentie.

Artefactparttime onderzoekers

Naast ons team dat zich bezighoudt met onderzoek, hebben we verschillende medewerkers die enige tijd besteden aan wetenschappelijk onderzoek en het publiceren van artikelen. Door ook als consultant te werken, inspireren we hen met problemen die onze klanten in de praktijk tegenkomen.

Publicaties

Medium blogartikelen van onze technische experts.

Assortimentoptimalisatie met discrete keuzemodellen in Python

Assortimentoptimalisatie is een cruciaal proces in de detailhandel waarbij de ideale mix van producten wordt samengesteld om aan de vraag van de consument te voldoen, rekening houdend met de vele logistieke...

Is Preference Alignment altijd de beste optie om LLM-gebaseerd vertalen te verbeteren? Een empirische analyse

Neurale meetmethoden voor de evaluatie van machinevertaling (MT) worden steeds prominenter vanwege hun superieure correlatie met menselijke beoordelingen in vergelijking met traditionele lexicale meetmethoden.

Keuze-leren: Grootschalige keuzemodellering voor operationele contexten door de lens van machinaal leren

Discrete keuzemodellen zijn gericht op het voorspellen van keuzebeslissingen die individuen maken uit een menu van alternatieven, een zogenaamd assortiment. Bekende toepassingen zijn het voorspellen van een...

Het tijdperk van generatieve AI: Wat verandert er?

De overvloed en diversiteit van reacties op ChatGPT en andere generatieve AI's, of ze nu sceptisch of enthousiast zijn, tonen de veranderingen die ze teweegbrengen en de impact...

Hoe Artefact erin slaagde een eerlijk maar eenvoudig carrièresysteem voor software-ingenieurs te ontwikkelen

In de dynamische en steeds veranderende technologiesector van vandaag kan een carrièrepad vaak aanvoelen als een kronkelend pad door een dicht woud van mogelijkheden. Met snelle...

Waarom je LLMOps nodig hebt

Dit artikel introduceert LLMOps, een gespecialiseerde tak die DevOps en MLOps samenvoegt om de uitdagingen van Large Language Models (LLM's) aan te gaan...

De kracht van LangChain Expression Language (LCEL) ontketenen: van proof of concept naar productie

LangChain is in minder dan een jaar uitgegroeid tot een van de meest gebruikte Python-bibliotheken voor interactie met LLM's, maar LangChain was vooral een bibliotheek...

Hoe we de reconciliatie van profiel-ID's afhandelden met behulp van Treasure Data Unification en SQL

In dit artikel leggen we de uitdagingen van ID-reconciliatie uit en demonstreren we onze aanpak om een eenduidig profiel-ID te maken in het Customer Data Platform,...

Snowflake's Snowday '23: Snowballing into Data Wetenschappelijk succes

Terwijl we nadenken over de inzichten die zijn gedeeld tijdens het 'Snowday'-evenement op 1 en 2 november, is er een stroom van spannende onthullingen over de toekomst van...

Hoe we software engineers interviewen en aannemen bij Artefact

We bespreken de vaardigheden waarnaar we op zoek zijn, de verschillende stappen van het proces en de beloften die we aan alle kandidaten doen.

Het coderen van categorische kenmerken in voorspellingen: doen we het allemaal verkeerd?

We stellen een nieuwe methode voor om categorische kenmerken te coderen die specifiek is afgestemd op voorspellingstoepassingen.

Hoe we een eenvoudig bewakingssysteem voor wilde dieren implementeerden op Google Cloud

We hebben samengewerkt met Smart Parks, een Nederlandse organisatie die geavanceerde sensoroplossingen biedt voor het behoud van bedreigde wilde dieren...