Artefact Research Center

Colmar la brecha entre el mundo académico y las aplicaciones industriales.

Investigación sobre modelos más transparentes y éticos para fomentar la adopción de AI business.

Ejemplos de sesgos AI

- AppleCard concede hipotecas según criterios racistas

- Lensa AI sexualiza los selfies de mujeres

- Clasificación de imágenes racistas en Facebook con afroamericanos como monos

- El chatbot de Twitter de Microsoft se vuelve nazi, sexista y agresivo

- ChatGPT que escribe un código que afirma que los buenos científicos son hombres blancos

Desafío actual

AI son precisos y fáciles de implantar en muchos casos de uso, pero siguen siendo incontrolables debido a las cajas negras y las cuestiones éticas.

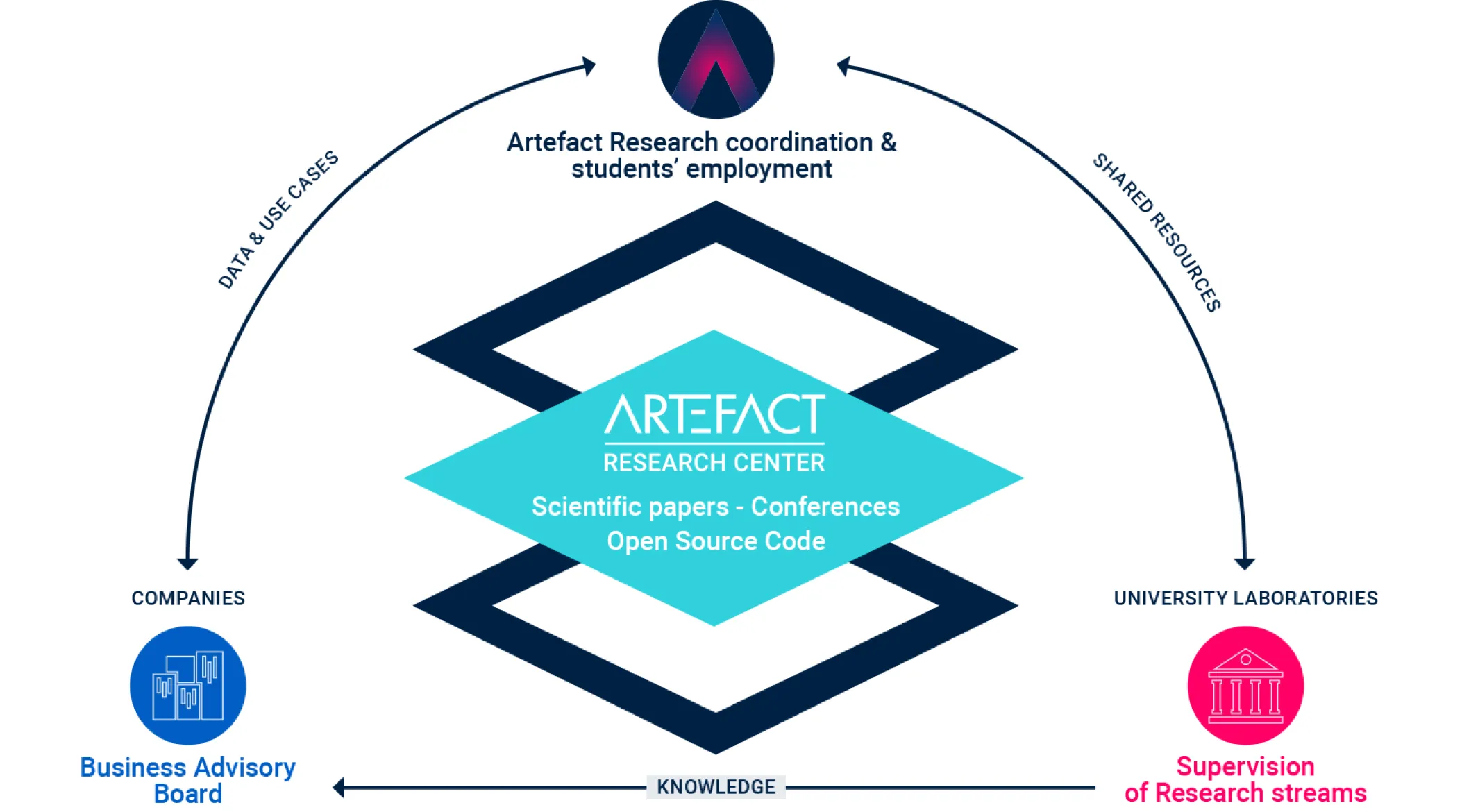

La misión de Artefact Research Center

Un ecosistema completo que tiende un puente entre

la investigación fundamental y las aplicaciones industriales tangibles.

Emmanuel MALHERBE

Jefe de Investigación

Campo de investigación: Aprendizaje profundo, aprendizaje automático

Emmanuel, que comenzó con un doctorado sobre modelos de PNL adaptados a la contratación electrónica, siempre ha buscado un equilibrio eficaz entre la investigación pura y las aplicaciones de impacto. Su experiencia investigadora incluye la previsión de series temporales de 5G para Huawei Technologies y modelos de visión por ordenador para clientes de peluquería y maquillaje en l'Oréal. Antes de incorporarse a Artefact, trabajó en Shanghái como responsable de investigación de AI para L'Oréal Asia. En la actualidad, su puesto en Artefact es una oportunidad perfecta y un entorno ideal para tender puentes entre el mundo académico y la industria, y fomentar su investigación en el mundo real al tiempo que repercute en las aplicaciones industriales.

Un ecosistema completo que tiende puentes entre la investigación fundamental y las aplicaciones tangibles de la industria.

Campos de investigación transversales

Con nuestro posicionamiento único, nuestro objetivo es abordar los retos generales de AI, ya sea en modelización estadística o en investigación de gestión.

Estas cuestiones son transversales a todos nuestros temas y nutren nuestra investigación.

Temas

Trabajamos en varios temas de doctorado en la intersección de los casos de uso industrial y las limitaciones del estado de la técnica.

Para cada tema, trabajamos en colaboración con profesores universitarios y tenemos acceso a data industrial que nos permite abordar las principales áreas de investigación en un escenario real determinado.

1 - Previsión y fijación de precios

Modelizar las series temporales en su conjunto con un modelo de previsión multivariable y controlable. Esta modelización nos permitirá abordar la planificación de precios y promociones encontrando los parámetros óptimos que aumenten la previsión de ventas. Con este enfoque holístico, pretendemos captar la canibalización y la complementariedad entre productos. Nos permitirá controlar la previsión con garantías de que las predicciones se mantienen coherentes.

2 - Puntuación explicable y controlable

Una familia muy utilizada de modelos de aprendizaje automático se basa en árboles de decisión: bosques aleatorios, boosting. Aunque su precisión suele ser la más avanzada, estos modelos tienen una sensación de "caja negra", lo que limita el control del usuario. Nuestro objetivo es aumentar su explicabilidad y transparencia, por ejemplo mejorando la estimación de los valores SHAP en el caso de conjuntos de datos desequilibrados. También pretendemos ofrecer algunas garantías para estos modelos, por ejemplo, para muestras fuera de entrenamiento o permitiendo mejores restricciones monotónicas.

3 - Optimización del surtido

El surtido es un importante problema empresarial para los minoristas que se plantea a la hora de seleccionar el conjunto de productos que se venderán en las tiendas. Utilizando grandes conjuntos de datos industriales y redes neuronales, pretendemos construir modelos más sólidos e interpretables que capten mejor la elección del cliente cuando se enfrenta a un surtido de productos. El tratamiento de la canibalización y la complementariedad entre productos, así como una mejor comprensión de las agrupaciones de clientes, son claves para encontrar un conjunto más óptimo de productos en una tienda.

4 - AI Adopción en las empresas

El reto de una mejor adopción de AI en las empresas consiste, por un lado, en mejorar los modelos AI y, por otro, en comprender los aspectos humanos y organizativos. En la encrucijada de la investigación cualitativa sobre gestión y la investigación social, este eje pretende explorar dónde encuentran dificultades las empresas a la hora de adoptar las herramientas de AI . Los marcos existentes sobre la adopción de innovaciones no son del todo adecuados para las innovaciones del aprendizaje automático, ya que existen diferencias típicas con la normativa, la formación de las personas o los prejuicios cuando se trata de AI, y más aún con AI generativo.

5 - Sostenibilidad Data

El proyecto movilizará métodos de investigación cualitativos y cuantitativos y abordará dos cuestiones clave: ¿Cómo pueden medir eficazmente las empresas sus resultados en materia de sostenibilidad social y medioambiental? ¿Por qué las medidas de sostenibilidad no suelen producir cambios significativos en las prácticas organizativas?

Por un lado, el proyecto pretende explorar métricas data e identificar indicadores para alinear los procedimientos organizativos con los objetivos de sostenibilidad social y medioambiental. Por otro, el proyecto se centrará en transformar estas medidas de sostenibilidad en acciones concretas dentro de las empresas.

6 - Sesgo en la visión por ordenador

Cuando un modelo realiza una predicción basándose en una imagen, por ejemplo de un rostro, tiene acceso a información sensible, como la etnia, el sexo o la edad, que puede sesgar su razonamiento. Nuestro objetivo es desarrollar un marco para medir matemáticamente ese sesgo y proponer metodologías para reducirlo durante el entrenamiento del modelo. Además, nuestro enfoque detectaría estadísticamente las zonas de fuerte sesgo para explicar y comprender y controlar dónde tales modelos refuerzan el sesgo presente en la data.

7 - LLM para la recuperación de información

Una de las principales aplicaciones de los LLM es cuando se combinan con un corpus de documentos que representan algún tipo de conocimiento o información industrial. En tal caso, hay un paso de recuperación de información, para el que los LLM muestran algunas limitaciones, como el tamaño del texto de entrada, que es demasiado pequeño para indexar documentos. Del mismo modo, el efecto de alucinación también puede producirse en la respuesta final, que pretendemos detectar utilizando el documento recuperado y la incertidumbre del modelo en el momento de la inferencia.

Artefactinvestigadores a tiempo parcial

Además de nuestro equipo dedicado a la investigación, contamos con varios colaboradores que dedican parte de su tiempo a la investigación científica y a la publicación de artículos. Al trabajar también como consultores, se inspiran en los problemas del mundo real con los que se encuentran nuestros clientes.

Publicaciones

Artículos del blog Medium escritos por nuestros expertos en tecnología.

Optimización del surtido con modelos de elección discreta en Python

La optimización del surtido es un proceso crítico en el comercio minorista que consiste en seleccionar la combinación ideal de productos para satisfacer la demanda de los consumidores teniendo en cuenta...

¿Es siempre la alineación de preferencias la mejor opción para mejorar la traducción basada en LLM? Un análisis empírico

Las métricas neuronales para la evaluación de la traducción automática (TA) son cada vez más importantes debido a su mayor correlación con los juicios humanos en comparación con las métricas léxicas tradicionales.

Choice-Learn: Modelización de elecciones a gran escala para contextos operativos a través de la lente del aprendizaje automático.

Los modelos de elección discreta tienen como objetivo predecir las decisiones de elección tomadas por los individuos a partir de un menú de alternativas, denominado surtido. Los casos de uso más conocidos incluyen la predicción de una...

La era generativa AI: ¿Qué está cambiando?

La abundancia y diversidad de respuestas a ChatGPT y otras IA generativas, ya sean escépticas o entusiastas, demuestran los cambios que están provocando y el impacto...

Cómo Artefact consiguió desarrollar un sistema de carrera justo y sencillo para los ingenieros de software.

En el dinámico sector tecnológico actual, en constante evolución, una carrera profesional puede parecer a menudo un camino sinuoso a través de un denso bosque de oportunidades. Con...

Por qué necesita LLMOps

Este artículo presenta LLMOps, una rama especializada que fusiona DevOps y MLOps para gestionar los retos que plantean los grandes modelos lingüísticos (LLM)...

Liberar la potencia del lenguaje de expresión LangChain (LCEL): de la prueba de concepto a la producción

LangChain se ha convertido en menos de un año en una de las bibliotecas de Python más utilizadas para interactuar con LLM, pero LangChain era sobre todo una biblioteca...

Cómo gestionamos la conciliación de ID de perfil utilizando Treasure Data Unification y SQL

En este artículo explicamos los retos de la conciliación de ID y demostramos nuestro enfoque para crear un ID de perfil unificado en la plataforma de clientes Data , en concreto...

Snowflake's Snowday '23: Snowballing into Data Science Success

Al reflexionar sobre las ideas compartidas durante el "Snowday" del 1 y 2 de noviembre, una cascada de interesantes revelaciones sobre el futuro de...

Cómo entrevistamos y contratamos ingenieros de software en Artefact

Repasamos las competencias que buscamos, las distintas fases del proceso y los compromisos que asumimos con todos los candidatos.

Codificación de características categóricas en la previsión: ¿lo hacemos todos mal?

Proponemos un método novedoso para codificar características categóricas específicamente adaptadas a las aplicaciones de previsión.

Cómo desplegamos un sencillo sistema de vigilancia de la fauna salvaje en Google Cloud

Colaboramos con Smart Parks, una empresa holandesa que ofrece soluciones avanzadas de sensores para conservar la fauna salvaje en peligro...